Socket网络编程--网络爬虫(3)

上一小节我们实现了从博客园的首页获取一些用户的用户名,并保存起来。接下来的这一小节我将对每个用户名构建一个用户的博客主页,然后从这个主页获取所有能获取到的网页,网页的格式现在是http://www.cnblogs.com/yourname/p/xxxxxxxx.html以前是http://www.cnblogs.com/youurname/archive/xxxxxxx.html

我的做法是把所有用户名处理后得到的一个个url放到一个队列里去,然后每次在这个队列中拿一个url进行解析查找看有没有新的用户。如果有那么把新的用户加入到map中,结束后就从队列中再拿一个url进行判断,查找心得用户。

下面这个程序是对前两节进行整理

#include <stdio.h>

#include <stdlib.h>

#include <string.h>

#include <sys/types.h>

#include <sys/socket.h>

#include <unistd.h>

#include <netdb.h>

#include <netinet/in.h>

#include <arpa/inet.h>

#include <regex.h>//正则表达式

#include <map>

#include <string>

#include <iostream> using namespace std;

#define BUF_SIZE 512 struct URL

{

char host[];

char url[];//除去域名后的url

};

int reptile_regex(char * buf,char *pattern,map<string,int> & user);

int createSocket(char *hostname,int port);

int closeSocket(int sockfd);

int sendHttpRequest(int sockfd,struct URL url);

int recvHttpRespond(int sockfd,char *ch); int main(int argc,char *argv[])

{

int sockfd;

char ch[];//100k

char pattern[]={};

struct URL url;

string str;

map<string,int> user;//第一个是用户名,第二个保存被加入的次数 strcpy(url.host,"www.cnblogs.com");

strcpy(url.url,"/");

sockfd=createSocket(url.host,);

sendHttpRequest(sockfd,url);

recvHttpRespond(sockfd,ch);

strcpy(pattern,"http://www.cnblogs.com/[[:alnum:]\\-\\_]*");

reptile_regex(ch,pattern,user);

map<string,int>::iterator it;

for(it=user.begin();it!=user.end();++it)

{

cout<<it->first<<endl;

} closeSocket(sockfd);

return ;

} //第一个参数是要匹配的字符串,第二个参数是匹配的规则

int reptile_regex(char * buf,char *pattern,map<string,int> & user)

{

size_t nmatch=;

regmatch_t pm[];

regex_t reg;//正则表达式指针

char * str;

char ch[];

int i,j;

str=buf;

regcomp(®,pattern,);//编译匹配模式

while(regexec(®,str,nmatch,pm,)!=REG_NOMATCH)

{

i=pm[].rm_so+;

for(j=i;j<pm[].rm_eo;++j)

{

ch[j-i]=str[j];

}

ch[j-i]=;

string st(ch);

user[st]++;

//printf("%d=%s\n",i,substr(buf,pm[i].rm_so,pm[i].rm_eo));

str=str+pm[].rm_eo;

}

regfree(®);

return ;

} int closeSocket(int sockfd)

{

close(sockfd);

return ;

} int createSocket(char *hostname,int port)

{

struct sockaddr_in servAddr;

struct hostent * host;

int sockfd;

host=gethostbyname(hostname);

if(host==NULL)

{

perror("dns 解析失败");

}

servAddr.sin_family=AF_INET;

servAddr.sin_addr=*((struct in_addr *)host->h_addr);

servAddr.sin_port=htons(port);

bzero(&(servAddr.sin_zero),); sockfd=socket(AF_INET,SOCK_STREAM,);

if(sockfd==-)

{

perror("socket 创建失败");

} if(connect(sockfd,(struct sockaddr *)&servAddr,sizeof(struct sockaddr_in))==-)

{

perror("connect 失败");

}

return sockfd;

} int sendHttpRequest(int sockfd,struct URL url)

{

char sendBuf[BUF_SIZE];

int sendSize;

//构建一个http请求

sprintf(sendBuf,"GET %s HTTP/1.1 \r\nHost: %s \r\nConnection: Close \r\n\r\n",url.url,url.host);

if((sendSize=send(sockfd,sendBuf,BUF_SIZE,))==-)

{

perror("send 失败");

}

return ;

} int recvHttpRespond(int sockfd,char *ch)

{

char recvBuf[BUF_SIZE];

int recvSize;

//获取http应答信息

memset(recvBuf,,sizeof(recvBuf));

memset(ch,,sizeof(ch));

while(recvSize=recv(sockfd,recvBuf,BUF_SIZE,)>)

{

strcat(ch,recvBuf);

memset(recvBuf,,sizeof(recvBuf));

}

return ;

}

接下来要做的是创建两个队列,一个保存新进来的用户,一个保存新url用来处理的。然后让两个队列一直循环下去。理论上就可以爬到大多数的用户名。如果用上面的程序进行匹配的话,有时候会出现匹配错误的时候,例如有一个用户名是wunaozai,但是在匹配的过程中有时候会有wunao这样的用户名出现,一开始以为是重名,但是后来看了源码发现没有这个用户了,然后多次获取,每次都或多或少会有错误的用户名出现。到底是为什么呢?我把用recv获取到的网页ch这个都打印出来,然后用grep过滤一下,会发现根本没有错,但是就是会匹配错误的用户名。我就接着把网页重定向到一个文件中,然后用vim打开,然后查找一下,然后真相大白了,原来这个文本中有时候会在用户名处有这个符号(^A),UNIX中ctrl-v ctrl-a可以打印出来,ascii码的值是0x01.哎弄了那么久,导致这篇博客那么晚才发布。在正则中可以用[:cntrl:]进行匹配。这一部分的代码修改比较简单。

还有一个问题就是没进行一次连接,都要创建一次socket连接。因为我的HTTP请求中的Connection是Close而不是keep-alive。

修改BUG后的网络爬虫程序

...

29 int reptile_regex_url(char * buf,char *pattern,map<string,int> & user,queue<string> & qstr); int main(int argc,char *argv[])

{

int sockfd;

char ch[];//100k

char pattern_user[]={};

char pattern_url[]={};

struct URL url;

string str;

map<string,int> user;//第一个是用户名,第二个保存被加入的次数

queue<struct URL> qurl;

queue<string> qstr; strcpy(url.host,"www.cnblogs.com");

strcpy(url.url,"/");

//

sockfd=createSocket(url.host,);

//初始化用户名

sendHttpRequest(sockfd,url);

recvHttpRespond(sockfd,ch);

//printf("%s\n",ch);

strcpy(pattern_user,"http://www.cnblogs.com/[[:alnum:][:cntrl:]\\-\\_]*");

reptile_regex_url(ch,pattern_user,user,qstr);

map<string,int>::iterator it;

for(it=user.begin();it!=user.end();++it)

{

qstr.push(it->first);

strcpy(url.host,"www.cnblogs.com");

strcpy(url.url,"/");

strcat(url.url,it->first.c_str());

strcat(url.url,"/");

qurl.push(url);

}

//一开始以为是只要创建一次socket然后每次都可以进行send&recv的。但是后来测试好像不行,每次都要进行一次socket的创建

closeSocket(sockfd); while()

{

while(!qurl.empty())

{

url=qurl.front();

qurl.pop();

cout<<"现在正在判断:";

cout<<url.host<<url.url<<endl;

//将获取到的地址进行再次获取用户名

strcpy(url.host,"www.cnblogs.com");

strcpy(url.url,"/");

sockfd=createSocket(url.host,);

sendHttpRequest(sockfd,url);

recvHttpRespond(sockfd,ch);

//printf("\n\n\n%s\n",ch);

strcpy(pattern_user,"http://www.cnblogs.com/[[:alnum:][:cntrl:]\\-\\_]*");

reptile_regex_url(ch,pattern_user,user,qstr);

closeSocket(sockfd);

}

while(!qstr.empty())

{

qstr.pop();

}

}

sendHttpRequest(sockfd,url);

recvHttpRespond(sockfd,ch);

strcpy(pattern_url,"http://www.cnblogs.com/[[:alnum:]\\-\\_]*/[[:alnum:]\\-\\_/]*\\.html");

//reptile_regex(ch,pattern_url,qurl); return ;

} //第一个参数是要匹配的字符串,第二个参数是匹配的规则

int reptile_regex_url(char * buf,char *pattern,map<string,int> & user,queue<string> & qstr)

{

size_t nmatch=;

regmatch_t pm[];

regex_t reg;//正则表达式指针

char * str;

char ch[];

int i,j,k;

str=buf;

regcomp(®,pattern,REG_EXTENDED);//编译匹配模式

while(regexec(®,str,nmatch,pm,)!=REG_NOMATCH)

{

i=pm[].rm_so+;

k=;

memset(ch,,sizeof(ch));

for(j=i;j<pm[].rm_eo;++j)//这里修改****

{

if(str[j]!=0x01) //ctrl-v ctrl-a

{

ch[k++]=str[j];

}

}

string st(ch);

if(user[st]==)

{

cout<<"新加入的用户名:"<<st<<endl;

qstr.push(st);

}

user[st]++;

str=str+pm[].rm_eo;

}

regfree(®);

return ;

} int closeSocket(int sockfd)

{

close(sockfd);

return ;

} int createSocket(char *hostname,int port)

{

...

return sockfd;

} int sendHttpRequest(int sockfd,struct URL url)

{

...

return ;

} int recvHttpRespond(int sockfd,char *ch)

{

...

return ;

}

我们从博客园的首页中可以看到最新博客有200页之多。每一页的格式为http://www.cnblogs.com/sitehome/p/1 到 http://www.cnblogs.com/sitehome/p/200 所以我们可以根据这个格式进行获取用户名,一般也是这种方式获取的比较多。

int main(int argc,char *argv[])

{

int sockfd;

char ch[];//100k

char pattern_user[]={};

char pattern_url[]={};

struct URL url;

string str;

map<string,int> user;//第一个是用户名,第二个保存被加入的次数

queue<struct URL> qurl;

queue<string> qstr; //http://www.cnblogs.com/sitehome/p/1 - 200 //最新博客的200篇

//初始化用户名

for(int i=;i<=;++i)

{

strcpy(url.host,"www.cnblogs.com");

strcpy(url.url,"/sitehome/p/");

char pch[];

sprintf(pch,"%d",i);

strcat(url.url,pch);

strcat(url.url,"/");

cout<<"当前正在判断:"<<url.host<<url.url<<endl;

sockfd=createSocket(url.host,);

sendHttpRequest(sockfd,url);

recvHttpRespond(sockfd,ch);

strcpy(pattern_user,"http://www.cnblogs.com/[[:alnum:][:cntrl:]\\-\\_]*");

reptile_regex_url(ch,pattern_user,user,qstr); closeSocket(sockfd);

}

map<string,int>::iterator it;

for(it=user.begin();it!=user.end();++it)

{

qstr.push(it->first);

strcpy(url.host,"www.cnblogs.com");

strcpy(url.url,"/");

strcat(url.url,it->first.c_str());

strcat(url.url,"/");

qurl.push(url);

}

//一开始以为是只要创建一次socket然后每次都可以进行send&recv的。但是后来测试好像不行,每次都要进行一次socket的创建 ... ...

return ;

}

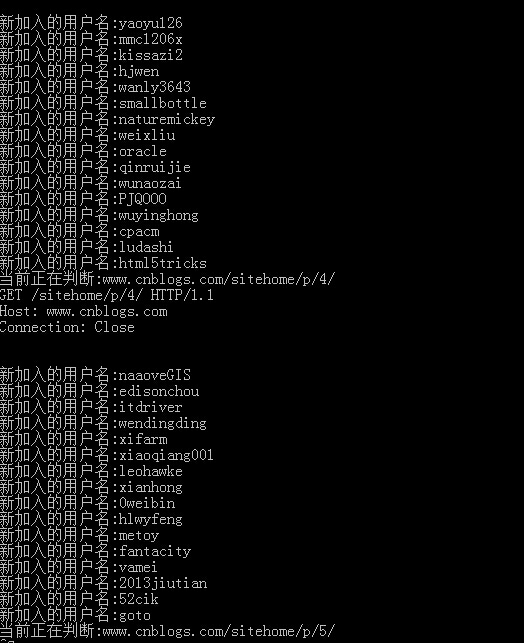

获取到的用户名如下

这一小节到这里就结束了,可以获取用户名了,不过虽然有200页,不过获取来还是很快的。下一节我将对这些用户的关注和粉丝进行用户名的再次提取。然后得到新的用户名,然后再次提取,就这样一直下去。理论上有在博客园活跃过的人都可以爬取的到,想想都激动。(这个是理论,我没敢试,怕管理员找我谈人生和理想。)

本文地址: http://www.cnblogs.com/wunaozai/p/3900454.html

Socket网络编程--网络爬虫(3)的更多相关文章

- [转] - Linux网络编程 -- 网络知识介绍

(一)Linux网络编程--网络知识介绍 Linux网络编程--网络知识介绍客户端和服务端 网络程序和普通的程序有一个最大的区别是网络程序是由两个部分组成的--客户端和服务器端. 客户 ...

- JAVA基础知识之网络编程——-网络基础(Java的http get和post请求,多线程下载)

本文主要介绍java.net下为网络编程提供的一些基础包,InetAddress代表一个IP协议对象,可以用来获取IP地址,Host name之类的信息.URL和URLConnect可以用来访问web ...

- UNIX网络编程——网络IPC:套接字

UNIX网络编程——网络IPC:套接字 Contents 套接字接口 套接字描述符 寻址 字节序 地址格式 地址查询 绑定地址 建立连接 数据传输 套接字选项 带外数据 UNIX域套接字 使用套接字的 ...

- Socket网络编程--网络爬虫(1)

我们这个系列准备讲一下--网络爬虫.网络爬虫是搜索引擎系统中十分重要的组成部分,它负责从互联网中搜集网页,采集信息,这些网页信息用于建立索引从而为搜索引擎提供支持,它决定着整个引擎系统的内容是否丰富, ...

- 网络编程—网络基础概览、socket,TCP/UDP协议

网络基础概览 socket概览 socket模块—TCP/UDP的实现 TCP/UDP总结 网络基础概览 osi七层协议各层主要的协议 # 物理层传输电信号1010101010 # 数据链路层,以太网 ...

- linux网络编程--网络编程的基本函数介绍与使用【转】

本文转载自:http://blog.csdn.net/yusiguyuan/article/details/17538499 我们深谙信息交流的价值,那网络中进程之间如何通信,如我们每天打开浏览器浏览 ...

- python网络编程——网络IO模型

1 网络IO模型介绍 服务器端编程经常需要构造高性能的IO模型,常见的IO模型有四种: (1)同步阻塞IO(Blocking IO):即传统的IO模型. (2)同步非阻塞IO(Non-bl ...

- JAVA基础知识之网络编程——-网络通信模型(IO模型)

<Unix网络编程:卷1>中介绍了5中I/O模型,JAVA作为运行在宿主机上的程序,底层也遵循这5中I/O模型规则.这5中I/O模型分别是: 阻塞式IO 非阻塞式IO I/O复用 信号驱动 ...

- UNIX网络编程——网络I/O模型

在学习UNIX网络编程的时候.一開始分不清 同步 和 异步,所以还是总结一下,理清下他们的差别比較好. IO分类 IO依据对IO的调度方式可分为堵塞IO.非堵塞IO.IO复用.信号驱动IO.异步IO. ...

- Socket网络编程--网络爬虫(2)

上一小节,我们实现了下载一个网页.接下来的一步就是使用提取有用的信息.如何提取呢?一个比较好用和常见的方法就是使用正则表达式来提取的.想一想我们要做个什么样的网络爬虫好呢?我记得以前好像博客园里面有人 ...

随机推荐

- vs2017下发现解决python运行出现‘No module named "XXX""的解决办法

对于使用vs2017开发python程序无疑发现,在解决方案资源管理器中设置把两个xxx.py,yyy.py文件都设置为启动文件,然后分别在vs2017这个IDE下运行这个两个文件在项目工程中运行,发 ...

- HDU1532 网络流最大流【EK算法】(模板题)

<题目链接> 题目大意: 一个农夫他家的农田每次下雨都会被淹,所以这个农夫就修建了排水系统,还聪明的给每个排水管道设置了最大流量:首先输入两个数n,m ;n为排水管道的数量,m为节点的数量 ...

- 洛谷 P1433 吃奶酪【DFS】+剪枝

题目链接:https://www.luogu.org/problemnew/show/P1433 题目描述 房间里放着n块奶酪.一只小老鼠要把它们都吃掉,问至少要跑多少距离?老鼠一开始在(0,0)点处 ...

- 爬虫之urllib.request基础使用(一)

urllib模块 urllib模块简介: urllib提供了一系列用于操作URL的功能.包含urllib.request,urllib.error,urllib.parse,urllib.robotp ...

- Windows10下 tensorflow-gpu 配置

引言 越来越多的的人入坑机器学习,深度学习,tensorflow 作为目前十分流行又强大的一个框架,自然会有越来越多的新人(我也刚入门)准备使用,一般装的都是 CPU 版的 tensorflow,然而 ...

- Codeforces-541div2

https://www.cnblogs.com/31415926535x/p/10427505.html codeforces-1131A~G 这场很多题都很简单,,应该是要能至少做出4道的,,但是我 ...

- C++泛型线性查找算法——find

C++泛型线性查找算法--find <泛型编程和STL>笔记及思考. 线性查找可能是最为简单的一类查找算法了.他所作用的数据结构为一维线性的空间.这篇文章主要介绍使用 C++ 实现泛型算法 ...

- java中thread的start()和run()的区别

1.start()方法来启动线程,真正实现了多线程运行,这时无需等待run方法体代码执行完毕而直接继续执行下面的代码: 通过调用Thread类的start()方法来启动一个线程, 这时此线程是处于就绪 ...

- SQL EXCEPT INTERSECT

EXCEPT是指在第一个集合中存在,但是不存在于第二个集合中的数据. INTERSECT是指在两个集合中都存在的数据. )) go )) go insert into t1 ,'t1' union a ...

- 潭州课堂25班:Ph201805201 第十课 类的定义,属性和方法 (课堂笔记)

类的定义 共同属性,特征,方法者,可分为一类,并以名命之 class Abc: # class 定义类, 后面接类名 ( 规则 首字母大写 ) cls_name = '这个类的名字是Abc' # 在类 ...