tensorflow2.0 学习(二)

线性回归问题

# encoding: utf-8 import numpy as np

import matplotlib.pyplot as plt data = []

for i in range(100):

x = np.random.uniform(-10., 10.) #均匀分布产生x

eps = np.random.normal(0., 0.01) #高斯分布产生一个误差值

y = 1.477*x + 0.089 +eps #计算得到y值

data.append([x, y]) #保存到data中 data = np.array(data) #转成数组的方式方便处理

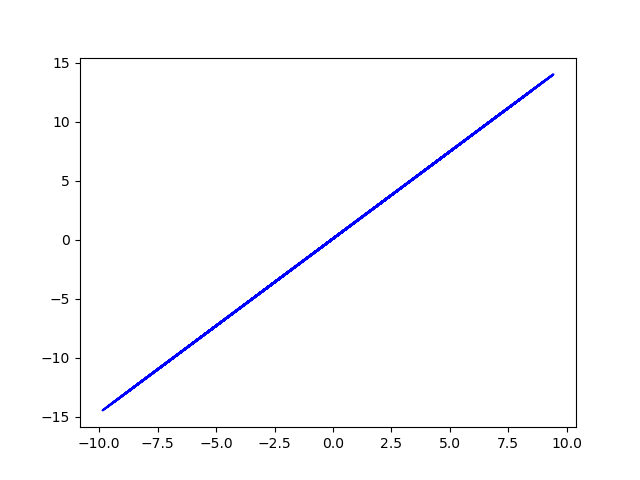

plt.plot(data[:,0], data[:,1], 'b') #自己引入用于观察原始数据

#plt.show()

plt.savefig('original data.png') def mse(b, w, points): #计算所有点的预测值和真实值之间的均方误差

totalError = 0

for i in range(0, len(points)):

x = points[i, 0]

y = points[i, 1]

totalError += (y -(w*x + b))**2 #真实值减预测值的平方

return totalError/float(len(points)) #返回平均误差值 def step_gradient(b_current, w_current, points, lr): #预测模型中梯度下降方式优化b和w

b_gradient = 0

w_gradient = 0

M = float(len(points))

for i in range(0, len(points)):

x = points[i, 0]

y = points[i, 1]

b_gradient += (2/M) * ((w_current*x + b_current) - y) #求偏导数的公式可知

w_gradient += (2/M)*x*((w_current*x + b_current) - y) #求偏导数的公式可知

new_b = b_current - (lr*b_gradient) #更新参数,使用了梯度下降法

new_w = w_current - (lr*w_gradient) #更新参数,使用了梯度下降法

return [new_b, new_w] def gradient_descent(points, starting_b, starting_w, lr, num_iterations): #循环更新w,b多次

b = starting_b

w = starting_w

loss_data = []

for step in range(num_iterations): #计算并更新一次

b, w = step_gradient(b, w, np.array(points), lr) #更新了这一次的b,w

loss = mse(b, w, points)

loss_data.append([step+1, loss])

if step % 50 == 0: #每50次输出一回

print(f"iteration:{step}, loss{loss}, w:{w}, b:{b}")

return [b, w, loss_data] def main():

lr = 0.01 #学习率,梯度下降算法中的参数

initial_b = 0 #初值

initial_w = 0

num_iterations = 1000 #学习100轮

[b, w, loss_data] = gradient_descent(data, initial_b, initial_w, lr, num_iterations)

loss = mse(b, w, data)

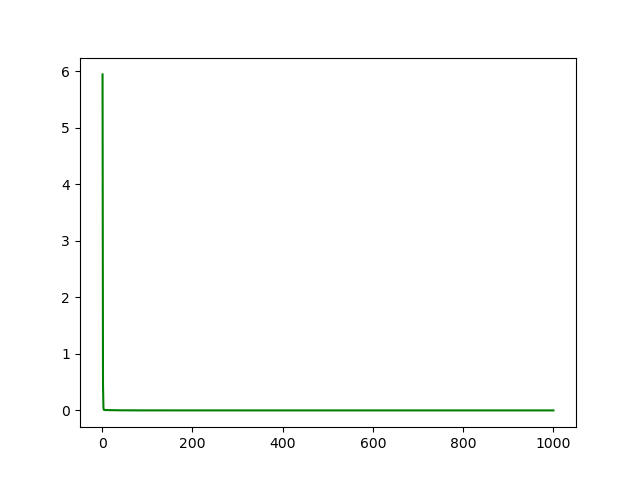

print(f'Final loss:{loss}, w:{w}, b:{b}') plt.figure() #观察loss每一步情况

loss_data = np.array(loss_data)

plt.plot(loss_data[:,0], loss_data[:,1], 'g')

plt.savefig('loss.png')

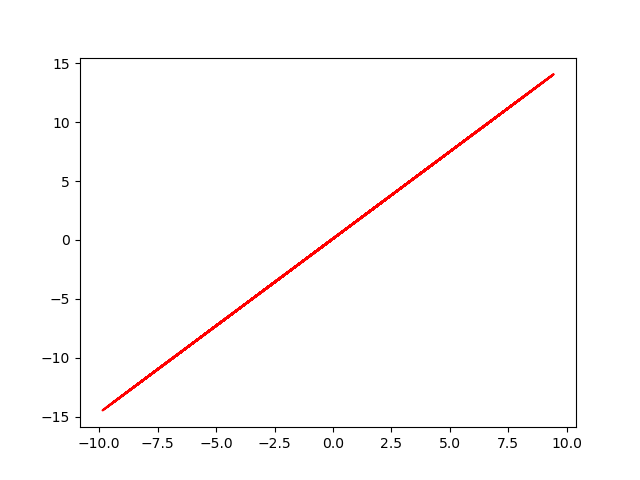

#plt.show() plt.figure() #观察最终的拟合效果

y_fin = w*data[:,0] + b + eps

plt.plot(data[:,0], y_fin, 'r')

#plt.show()

plt.savefig('final data.png') if __name__ == '__main__':

main()

original data (y = w*x + b +eps)

loss rate

final data (y' = w' *x + b' + eps )

最终loss趋近9.17*10^-5, w趋近1.4768, b趋近0.0900

真实的w值1.477, b为0.089

对于线性回归问题,适用性挺好!

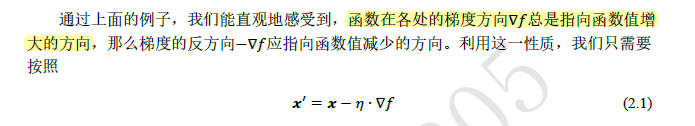

主要的数学代码能理解,唯有取梯度的反方向更新参数,不是很能理解!

这里还没有用到tensorflow,下一次更新基础知识!

tensorflow2.0 学习(二)的更多相关文章

- tensorflow2.0 学习(三)

用tensorflow2.0 版回顾了一下mnist的学习 代码如下,感觉这个版本下的mnist学习更简洁,更方便 关于tensorflow的基础知识,这里就不更新了,用到什么就到网上取搜索相关的知识 ...

- tensorflow2.0 学习(一)

虽说是按<TensorFlow深度学习>这本书来学习的,但是总会碰到新的问题!记录下这些问题,有利于巩固知新. 之前学过一些tensorflow1.0的知识,到RNN这章节,后面没有再继续 ...

- Tensorflow2.0学习(一)

站长资讯平台:今天学习一下Tensorflow2.0 的基础 核心库,@tf.function ,可以方便的将动态图的语言,变成静态图,在某种程度上进行计算加速 TensorFlow Lite Ten ...

- tensorflow2.0学习笔记

今天我们开始学习tensorflow2.0,用一种简单和循循渐进的方式,带领大家亲身体验深度学习.学习的目录如下图所示: 1.简单的神经网络学习过程 1.1张量生成 1.2常用函数 1.3鸢尾花数据读 ...

- TensorFlow2.0(二):数学运算

1 基本运算:加(+).减(-).点乘(*).除(/).地板除法(//).取余(%) 基本运算中所有实例都以下面的张量a.b为例进行: >>> a = tf.random.unifo ...

- tensorflow2.0学习笔记第一章第二节

1.2常用函数 本节目标:掌握在建立和操作神经网络过程中常用的函数 # 常用函数 import tensorflow as tf import numpy as np # 强制Tensor的数据类型转 ...

- tensorflow2.0学习笔记第二章第四节

2.4损失函数损失函数(loss):预测值(y)与已知答案(y_)的差距 nn优化目标:loss最小->-mse -自定义 -ce(cross entropy)均方误差mse:MSE(y_,y) ...

- tensorflow2.0学习笔记第二章第一节

2.1预备知识 # 条件判断tf.where(条件语句,真返回A,假返回B) import tensorflow as tf a = tf.constant([1,2,3,1,1]) b = tf.c ...

- tensorflow2.0学习笔记第一章第一节

一.简单的神经网络实现过程 1.1张量的生成 # 创建一个张量 #tf.constant(张量内容,dtpye=数据类型(可选)) import tensorflow as tf import num ...

随机推荐

- Scratch学习中需要注意的地方,学习Scratch时需要注意的地方

在所有的编程工具中,Scratch是比较简单的,适合孩子学习锻炼,也是信息学奥赛的常见项目.通常Scratch学习流程是,先掌握程序相关模块,并且了解各个模块的功能使用,然后通过项目的编写和练习,不断 ...

- Delphi TButton.OnClick 匿名函数用法

type TNotifyEventRef = reference to procedure(Sender: TObject); function AnonymousEvent(const Proc: ...

- FMX 隐藏任务栏 xe10

找了好多信息,测试好些,xe10 隐藏只要以下命令 隐藏 ShowWindow(ApplicationHWND, SW_HIDE); 显示 ShowWindow(ApplicationHWND, S ...

- HTTP响应状态

状态码分类 状态码详解 状态码 英文提示 说明 100 Continue 继续 101 Switching Protocols 切换协议.服务器根据客户端的请求切换协议.只能切换到更高级的协议,例如, ...

- SpringBoot整合freemarker 引用基础

原 ElasticSearch学习笔记Ⅲ - SpringBoot整合ES 新建一个SpringBoot项目.添加es的maven坐标如下: <dependency> <groupI ...

- C#/.NET 中启动进程时所使用的 UseShellExecute 设置为 true 和 false 分别代表什么意思?

原文:C#/.NET 中启动进程时所使用的 UseShellExecute 设置为 true 和 false 分别代表什么意思? 在 .NET 中创建进程时,可以传入 ProcessStartInfo ...

- C# 练习题 有一对兔子,从出生后第3个月起每个月都生一对兔子,小兔子长到第三个月后每个月又生一对兔子,假如兔子都不死,问每个月的兔子总数为多少?

题目:古典问题:有一对兔子,从出生后第3个月起每个月都生一对兔子,小兔子长到第三个月后每个月又生一对兔子,假如兔子都不死,问每个月的兔子总数为多少?程序分析: 兔子的规律为数列1,1,2,3,5,8, ...

- 在windows服务中使用定时器

在windows服务中,利用winform中直接拖动timer控件的方式使用定时器是不可以的,启动服务后会发现定时器并没有执行.那么在windows服务中如何使用定时器呢? 不使用直接拖动控件的方式 ...

- CSS揭秘(引言)

1.标准的制定过程 a 人员结构:W3C会员公司的成员.特邀专家.W3C工作人员 b 尽管“CSS3”非常流行,但它实际上并没有在任何规范中定义过.它实际上是指一个非正式的集合,包括CSS规范第三版再 ...

- MySQL数据库之互联网常用分库分表方案

一.数据库瓶颈 不管是IO瓶颈,还是CPU瓶颈,最终都会导致数据库的活跃连接数增加,进而逼近甚至达到数据库可承载活跃连接数的阈值.在业务Service来看就是,可用数据库连接少甚至无连接可用.接下来就 ...