Hadoop 2.7.3 完全分布式维护-动态增加datanode篇

原有环境

http://www.cnblogs.com/ilifeilong/p/7406944.html

| IP | host | JDK | linux | hadop | role |

| 172.16.101.55 | sht-sgmhadoopnn-01 | 1.8.0_111 | CentOS release 6.5 | hadoop-2.7.3 | NameNode,SecondaryNameNode,ResourceManager |

| 172.16.101.58 | sht-sgmhadoopdn-01 | 1.8.0_111 | CentOS release 6.5 | hadoop-2.7.3 | DataNode,NodeManager |

| 172.16.101.59 | sht-sgmhadoopdn-02 | 1.8.0_111 | CentOS release 6.5 | hadoop-2.7.3 | DataNode,NodeManager |

| 172.16.101.60 | sht-sgmhadoopdn-03 | 1.8.0_111 | CentOS release 6.5 | hadoop-2.7.3 | DataNode,NodeManager |

| 172.16.101.66 | sht-sgmhadoopdn-04 | 1.8.0_111 | CentOS release 6.5 | hadoop-2.7.3 | DataNode,NodeManager |

现计划向集群新增一台datanode,如表格所示

1. 配置系统环境

主机名,ssh互信,环境变量等

2. 修改namenode节点的slave文件,增加新节点信息

$ cat slaves

sht-sgmhadoopdn-

sht-sgmhadoopdn-

sht-sgmhadoopdn-

sht-sgmhadoopdn-

3. 在namenode节点上,将hadoop-2.7.3复制到新节点上,并在新节点上删除data和logs目录中的文件

$ hostname

sht-sgmhadoopnn-

$ rsync -az --progress /usr/local/hadoop-2.7./* hduser@sht-sgmhadoopdn-04:/usr/local/hadoop-2.7.3/ $ hostname

sht-sgmhadoopdn-04

$ rm -rf /usr/local/hadoop-2.7.3/logs/*

$ rm -rf /usr/local/hadoop-2.7.3/data/*

4. 启动新datanode的datanode进程

$ hadoop-daemon.sh start datanode

starting datanode, logging to /usr/local/hadoop-2.7./logs/hadoop-hduser-datanode-sht-sgmhadoopdn-.out

$ jps

Jps

DataNode

5. 在namenode查看当前集群情况,确认信节点已经正常加入

5.1 以命令行方式

$ hdfs dfsadmin -report

Configured Capacity: (282.49 GB)

Present Capacity: (77.98 GB)

DFS Remaining: (77.38 GB)

DFS Used: (618.02 MB)

DFS Used%: 0.77%

Under replicated blocks:

Blocks with corrupt replicas:

Missing blocks:

Missing blocks (with replication factor ): -------------------------------------------------

Live datanodes (): Name: 172.16.101.66: (sht-sgmhadoopdn-)

Hostname: sht-sgmhadoopdn-

Decommission Status : Normal

Configured Capacity: (70.62 GB)

DFS Used: ( KB)

Non DFS Used: (33.13 GB)

DFS Remaining: (37.49 GB)

DFS Used%: 0.00%

DFS Remaining%: 53.09%

Configured Cache Capacity: ( B)

Cache Used: ( B)

Cache Remaining: ( B)

Cache Used%: 100.00%

Cache Remaining%: 0.00%

Xceivers:

Last contact: Fri Sep :: CST Name: 172.16.101.60: (sht-sgmhadoopdn-)

Hostname: sht-sgmhadoopdn-

Decommission Status : Normal

Configured Capacity: (70.62 GB)

DFS Used: ( MB)

Non DFS Used: (57.48 GB)

DFS Remaining: (12.95 GB)

DFS Used%: 0.28%

DFS Remaining%: 18.33%

Configured Cache Capacity: ( B)

Cache Used: ( B)

Cache Remaining: ( B)

Cache Used%: 100.00%

Cache Remaining%: 0.00%

Xceivers:

Last contact: Fri Sep :: CST Name: 172.16.101.59: (sht-sgmhadoopdn-)

Hostname: sht-sgmhadoopdn-

Decommission Status : Normal

Configured Capacity: (70.62 GB)

DFS Used: ( MB)

Non DFS Used: (57.80 GB)

DFS Remaining: (12.63 GB)

DFS Used%: 0.28%

DFS Remaining%: 17.88%

Configured Cache Capacity: ( B)

Cache Used: ( B)

Cache Remaining: ( B)

Cache Used%: 100.00%

Cache Remaining%: 0.00%

Xceivers:

Last contact: Fri Sep :: CST Name: 172.16.101.58: (sht-sgmhadoopdn-)

Hostname: sht-sgmhadoopdn-

Decommission Status : Normal

Configured Capacity: (70.62 GB)

DFS Used: ( MB)

Non DFS Used: (56.11 GB)

DFS Remaining: (14.31 GB)

DFS Used%: 0.28%

DFS Remaining%: 20.26%

Configured Cache Capacity: ( B)

Cache Used: ( B)

Cache Remaining: ( B)

Cache Used%: 100.00%

Cache Remaining%: 0.00%

Xceivers:

Last contact: Fri Sep :: CST

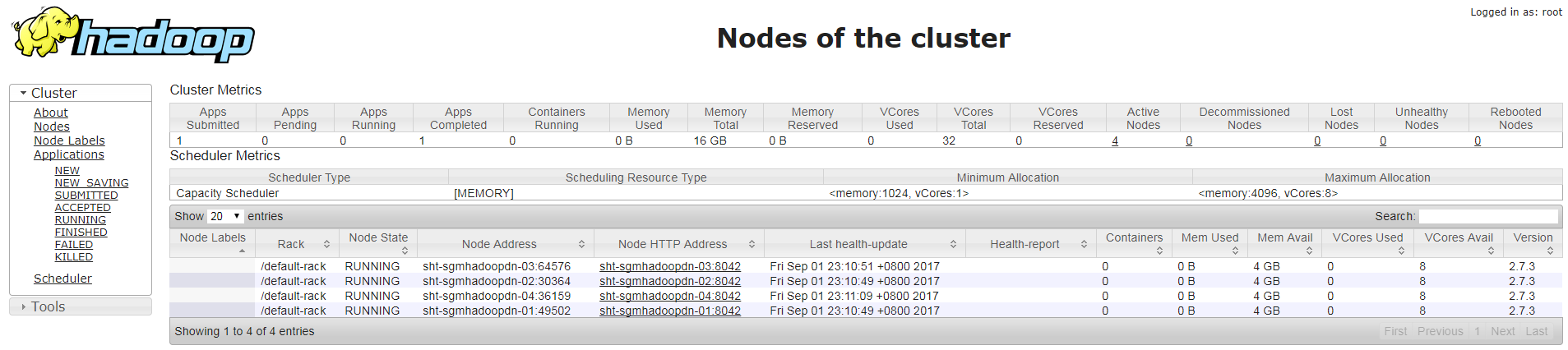

5.2 以web方式

6. 在namenoe上设置 hdfs 的负载均衡

$ hdfs dfsadmin -setBalancerBandwidth

Balancer bandwidth is set to

$ start-balancer.sh -threshold

starting balancer, logging to /usr/local/hadoop-2.7./logs/hadoop-hduser-balancer-sht-sgmhadoopnn-.out

7. 查看hdfs负载信息(有时候节点数据量较小,看出来数据量变化,可以上传大文件测试)

8. 启动新节点的nodemanager进程

$ yarn-daemon.sh start nodemanager

starting nodemanager, logging to /usr/local/hadoop-2.7./logs/yarn-hduser-nodemanager-sht-sgmhadoopdn-.out

$ jps

NodeManager

Jps

DataNode

Hadoop 2.7.3 完全分布式维护-动态增加datanode篇的更多相关文章

- Hadoop 2.7.3 完全分布式维护-简单测试篇

1. 测试MapReduce Job 1.1 上传文件到hdfs文件系统 $ jps Jps SecondaryNameNode JobHistoryServer NameNode ResourceM ...

- Hadoop 2.7.3 完全分布式维护-部署篇

测试环境如下 IP host JDK linux hadop role 172.16.101.55 sht-sgmhadoopnn-01 1.8.0_111 CentOS release ...

- Hadoop 2.6.3动态增加/删除DataNode节点

假设集群操作系统均为:CentOS 6.7 x64 Hadoop版本为:2.6.3 一.动态增加DataNode 1.准备新的DataNode节点机器,配置SSH互信,可以直接复制已有DataNode ...

- 安装部署Apache Hadoop (本地模式和伪分布式)

本节内容: Hadoop版本 安装部署Hadoop 一.Hadoop版本 1. Hadoop版本种类 目前Hadoop发行版非常多,有华为发行版.Intel发行版.Cloudera发行版(CDH)等, ...

- Hadoop、Zookeeper、Hbase分布式安装教程

参考: Hadoop安装教程_伪分布式配置_CentOS6.4/Hadoop2.6.0 Hadoop集群安装配置教程_Hadoop2.6.0_Ubuntu/CentOS ZooKeeper-3.3 ...

- Hadoop 在windows 上伪分布式的安装过程

第一部分:Hadoop 在windows 上伪分布式的安装过程 安装JDK 1.下载JDK http://www.oracle.com/technetwork/java/javaee/d ...

- centos中-hadoop单机安装及伪分布式运行实例

创建用户并加入授权 1,创建hadoop用户 sudo useradd -m hadoop -s /bin/bash 2,修改sudo的配置文件,位于/etc/sudoers,需要root权限才可以读 ...

- Apache Hadoop 2.9.2 完全分布式部署

Apache Hadoop 2.9.2 完全分布式部署(HDFS) 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 一.环境准备 1>.操作平台 [root@node101.y ...

- centos6.8系统安装 Hadoop 2.7.3伪分布式集群

安装 Hadoop 2.7.3 配置ssh免密码登陆 cd ~/.ssh # 若没有该目录,请先执行一次ssh localhost ssh-keygen - ...

随机推荐

- Python打印矩形、直角三角形、等腰三角形、菱形

思路如下: (1)先打印一个星号并换行 print("*") (2)打印一行6个星号 for i in range(6): print("*", end=&qu ...

- RequestMethod用法小结和注意事项

本文为博主原创,未经允许不得转载: RequestMethod为在@RequestMapping注解中使用的一个属性,用来标识请求的方法类型,可参考@RequestMapping源码: @Target ...

- 当图片加载失败时更换图片, Firefox onerror 报错

当图片加载失败时更换图片. <!DOCTYPE html> <meta charset="UTF-8"> <img src="http:// ...

- Java中泛型Class<T>、T与Class<?>、 Object类和Class类、 object.getClass()和Object.class

一.区别 单独的T 代表一个类型(表现形式是一个类名而已) ,而 Class<T>代表这个类型所对应的类(又可以称做类实例.类类型.字节码文件), Class<?>表示类型不确 ...

- springmvc通过ajax异步请求返回json格式数据

jsp 首先创建index.jsp页面 <script type="text/javascript"> $(function () { $("#usernam ...

- python 删除文件夹

只能删除空文件夹,删除非空文件夹会报错 >>> import os >>> os.rmdir("/tmp/ssh-GyoPWOFZ47") Tr ...

- Pycharm设置去除显示的波浪线

1.选择文件选择file—Settings,如下图打开setting对话框 2.选择Editur—Color Scheme—General选项,然后选择右边对话框中的Errors and Warnin ...

- python使用sessions模拟登录淘宝

之前想爬取一些淘宝的数据,后来发现需要登录,找了很多的资料,有个使用request的sessions加上cookie来登录的,cookie的获取在登录后使用开发者工具可以找到.不过这个登录后获得的网页 ...

- vuex学习与实践——mapState、getter、mapGetters

1.mapState辅助函数 当一个组件需要获取多个状态时候,将这些状态都声明为计算属性会有些重复和冗余.为了解决这个问题,我们可以使用 mapState 辅助函数帮助我们生成计算属性,让你少按几次键 ...

- QT新建工程编译出现"Moc'ing xxx.h..." 找不到文件或者error MSB6006: "cmd.exe" exited with code 3.

产生这个问题的原因是QT的头文件路径包含出错: (1)如果没有添加如图所示的路径,则添加后重新编译: (2)如果已经添加了,则删除后,重新添加,在重新编译: (3)或者在QT Project Sett ...