高可用之KeepAlived(2):keepalived+lvs

KeepAlived系列文章:http://www.cnblogs.com/f-ck-need-u/p/7576137.html

本文只给出几个keepalived+lvs(VS/DR模式)的配置示例,关于keepalived的配置文件说明见:高可用之KeepAlived(一):基本概念和配置文件分析。

在实验开始前,需要说明几点:

- 使用keepalived配置lvs的VS/DR模式时,vip建议绑定在别名接口上。如果VIP使用单独的网卡,在lvs的高可用问题上就会出现问题:使用独立网卡配置VIP的vrrp实例将总是master角色,除非它完全死机。

- 既然VIP要绑定在某个接口别名上,那么VIP必须和这个接口在同一网段,否则无法正确配置VIP相关的路由(router到VIP部分)。因此对于keepalived+lvs来说,VIP和rip应该设置在同一网段。除非已经考虑清楚不使用vrrp的高可用功能,这样VIP不用绑定在网卡别名上,也就可以和rip在不同网段。

- 既然VIP和RIP在同一网段,那么内网路由器上就无需设置rp_filter。

1.keepalived+lvs:健康状况检查示例

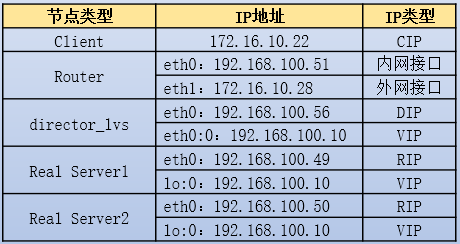

实验环境如下:

RS上操作:

yum -y install httpd

echo "rs1:192.168.100.49" > /var/www/html/index.html # RS1上操作

echo "rs1:192.168.100.50" > /var/www/html/index.html # RS2上操作

service httpd start

echo 1 >/proc/sys/net/ipv4/conf/all/arp_ignore

echo 2 >/proc/sys/net/ipv4/conf/all/arp_announce

ifconfig lo:0 192.168.100.10/32 up

route add -host 192.168.100.10 dev lo

route add default gw 192.168.100.51

Router上操作:

echo 1 >/proc/sys/net/ipv4/ip_forward

Director上操作:

[root@xuexi ~]# route del default

[root@xuexi ~]# route add default gw 192.168.100.51

[root@xuexi ~]# cp /etc/keepalived/keepalived.conf /etc/keepalived/keepalived.conf.bak

[root@xuexi ~]# vim /etc/keepalived/keepalived.conf

! Configuration File for keepalived

global_defs {

router_id LVS_1

}

vrrp_instance VI_1 {

state MASTER

interface eth0

virtual_router_id 51

priority 100

advert_int 1

authentication {

auth_type PASS

auth_pass 12345678

}

virtual_ipaddress {

192.168.100.10/32 dev eth0 label eth0:0

}

}

virtual_server 192.168.100.10 80 {

delay_loop 6

lb_algo wrr

lb_kind DR

protocol TCP

real_server 192.168.100.49 80 {

weight 2

TCP_CHECK {

connect_port 80

connect_timeout 1

nb_get_retry 2

delay_before_retry 1

}

}

real_server 192.168.100.50 80 {

weight 1

TCP_CHECK {

connect_port 80

connect_timeout 1

nb_get_retry 2

delay_before_retry 1

}

}

}

测试是否能实现连接的负载均衡。

2.keepalived+lvs:高可用+健康检查示例

KeepAlived通过vrrp的冗余路由切换协议实现高可用功能,主要用于lvs Director的高可用。

在配置KeepAlived高可用功能时,需要注意以下几点:

- 两台(或多台)Director上的vrrp实例名称要一致,vrid(virtual_router_id)要一致,认证机制以及认证密码要一致,global定义的服务器标识router_id不能一致。

- 不同机器上的优先级priority的值不能一致。priority直接决定谁是master,谁是backup,而无论vrrp实例的state值是MASTER还是BACKUP。

- VIP不能使用独立的网卡,而应该绑定在别名接口上。如果使用独立的网卡地址作为VIP,则这个vrrp实例将总是master角色,直至它死机或者该网卡down掉。

- keepalived的vrrp组件不依赖于lvs,它可以独立提供高可用服务。

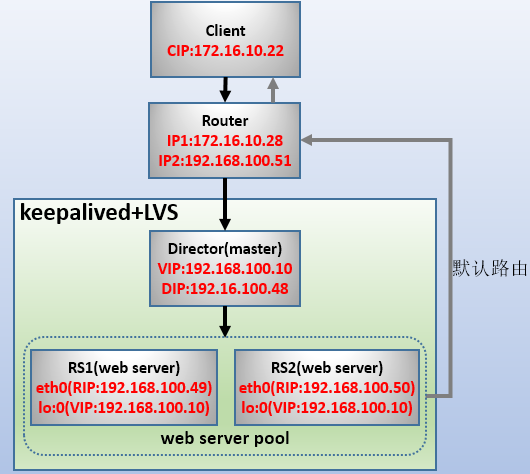

实验环境如下:

RS1、RS2、Router、director_lvs(master)和前文实验的配置一致,不需修改。因此,只需提供director_lvs(backup)的配置文件即可。

以下是master上的操作。

[root@xuexi ~]# route del default

[root@xuexi ~]# route add default gw 192.168.100.51

[root@xuexi ~]# cp /etc/keepalived/keepalived.conf /etc/keepalived/keepalived.conf.bak

[root@xuexi ~]# vim /etc/keepalived/keepalived.conf

! Configuration File for keepalived

global_defs {

router_id LVS_2 # 和master不同

}

vrrp_instance VI_1 { # 和master相同

state BACKUP # 和master不同

interface eth0

virtual_router_id 51 # 和master相同

priority 50 # 和maste不同

advert_int 1

authentication {

auth_type PASS # 和master相同

auth_pass 12345678 # 和master相同

}

virtual_ipaddress {

192.168.100.10/32 dev eth0 label eth0:0

}

}

virtual_server 192.168.100.10 80 {

delay_loop 6

lb_algo wrr

lb_kind DR

protocol TCP

real_server 192.168.100.49 80 {

weight 2

TCP_CHECK {

connect_port 80

connect_timeout 1

nb_get_retry 2

delay_before_retry 1

}

}

real_server 192.168.100.50 80 {

weight 1

TCP_CHECK {

connect_port 80

connect_timeout 1

nb_get_retry 2

delay_before_retry 1

}

}

}

启动两Director,查看是否只有master上设置了VIP。注意:ipvs规则在master和backup上都设置了,但由于backup没有VIP,因此backup设置的ipvs规则暂时是没有意义的。当backup切换为master状态时,只会设置VIP。

然后查看master是否已经生效。生效后,将master断开。观察原来的backup切换为master的日志:

Mar 1 20:52:19 xuexi Keepalived_vrrp[4709]: VRRP_Instance(VI_1) Transition to MASTER STATE

Mar 1 20:52:20 xuexi Keepalived_vrrp[4709]: VRRP_Instance(VI_1) Entering MASTER STATE

Mar 1 20:52:20 xuexi Keepalived_vrrp[4709]: VRRP_Instance(VI_1) setting protocol VIPs.

Mar 1 20:52:20 xuexi Keepalived_vrrp[4709]: Sending gratuitous ARP on eth0 for 192.168.100.10

Mar 1 20:52:20 xuexi Keepalived_vrrp[4709]: VRRP_Instance(VI_1) Sending/queueing gratuitous ARPs on eth0 for 192.168.100.10

Mar 1 20:52:20 xuexi Keepalived_vrrp[4709]: Sending gratuitous ARP on eth0 for 192.168.100.10

Mar 1 20:52:20 xuexi Keepalived_vrrp[4709]: Sending gratuitous ARP on eth0 for 192.168.100.10

Mar 1 20:52:20 xuexi Keepalived_vrrp[4709]: Sending gratuitous ARP on eth0 for 192.168.100.10

Mar 1 20:52:20 xuexi Keepalived_vrrp[4709]: Sending gratuitous ARP on eth0 for 192.168.100.10

Mar 1 20:52:25 xuexi Keepalived_vrrp[4709]: Sending gratuitous ARP on eth0 for 192.168.100.10

Mar 1 20:52:25 xuexi Keepalived_vrrp[4709]: VRRP_Instance(VI_1) Sending/queueing gratuitous ARPs on eth0 for 192.168.100.10

Mar 1 20:52:25 xuexi Keepalived_vrrp[4709]: Sending gratuitous ARP on eth0 for 192.168.100.10

Mar 1 20:52:25 xuexi Keepalived_vrrp[4709]: Sending gratuitous ARP on eth0 for 192.168.100.10

Mar 1 20:52:25 xuexi Keepalived_vrrp[4709]: Sending gratuitous ARP on eth0 for 192.168.100.10

Mar 1 20:52:25 xuexi Keepalived_vrrp[4709]: Sending gratuitous ARP on eth0 for 192.168.100.10

可以看到,切换速度极快(1秒以内)。

再测试将原来的master(高优先级)启动,发现它再次成为master,切换速度也是极快。

将RS1上的httpd停止。再查看主、备director上的ipvs规则。

[root@xuexi ~]# ipvsadm -ln

IP Virtual Server version 1.2.1 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 192.168.100.10:80 wrr

-> 192.168.100.50:80 Route 1 0 0

发现master和backup两边都把不健康的RealServer1节点给踢出去了。由此可以知道,健康检查是master和backup都会循环进行的,并不是只有master进行检查。

再将RS1上的httpd启动。然后查看ipvs规则。发现没过几秒钟就把规则添加回来了。

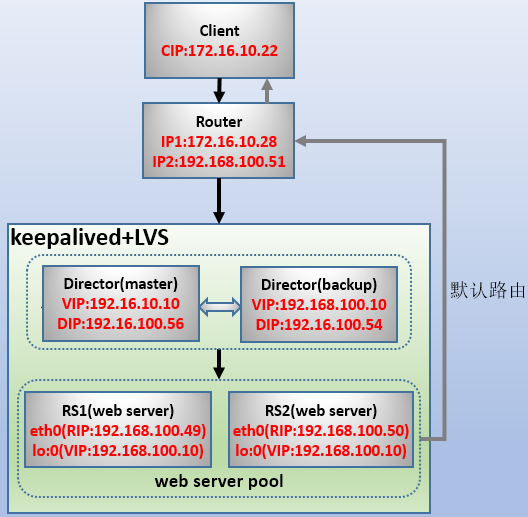

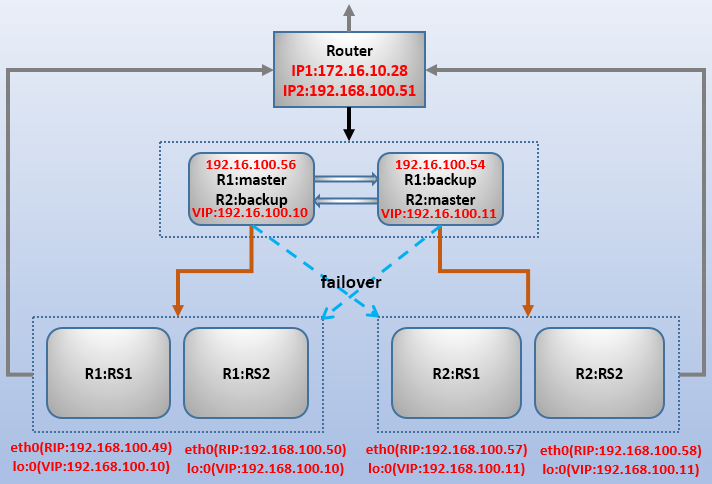

3.keepalived+lvs:多实例+高可用(双主)

keepalive的vrrp多实例可以管理多个director和vip,进而可以实现"双主模型"的高可用。

实验环境如下图:

其中Director1的vrrp实例1上是R1的master,vrrp实例2是R2的backup,Director2的vrrp实例1是R1的backup,vrrp实例2是R2的master。

这里略过4个RS的配置步骤(如有问题,参照前文配置RS1、RS2的过程)。

以下是Director1和Director2的keepalived.conf不同部分和相同部分的内容:

# 以下是两台Director上相同部分的内容

! Configuration File for keepalived |! Configuration File for keepalived

|

global_defs { |global_defs {

router_id LVS_1 | router_id LVS_2

} |}

|

vrrp_instance VI_1 { |vrrp_instance VI_1 {

state MASTER | state BACKUP

interface eth0 | interface eth0

virtual_router_id 51 | virtual_router_id 51

priority 100 | priority 50

advert_int 1 | advert_int 1

authentication { | authentication {

auth_type PASS | auth_type PASS

auth_pass 12345678 | auth_pass 12345678

} | }

virtual_ipaddress { | virtual_ipaddress {

192.168.100.10/32 dev eth0 label eth0:0 | 192.168.100.10/32 dev eth0 label eth0:0

} | }

} |}

# 不同vrrp实例绑定在同一接口上,vrid必须不能相同 |# 不同vrrp实例绑定在同一接口上,vrid必须不能相同

vrrp_instance VI_2 { |vrrp_instance VI_2 {

state BACKUP | state MASTER

interface eth0 | interface eth0

virtual_router_id 55 | virtual_router_id 55

priority 50 | priority 100

advert_int 1 | advert_int 1

authentication { | authentication {

auth_type PASS | auth_type PASS

auth_pass 12345678 | auth_pass 12345678

} | }

virtual_ipaddress { | virtual_ipaddress {

192.168.100.11/32 dev eth0 label eth0:1 | 192.168.100.11/32 dev eth0 label eth0:1

} | }

} |}

#########################################################################################

# 以下是两台Director上相同部分的内容

virtual_server 192.168.100.10 80 {

delay_loop 6

lb_algo wrr

lb_kind DR

protocol TCP

real_server 192.168.100.49 80 {

weight 2

TCP_CHECK {

connect_port 80

connect_timeout 1

nb_get_retry 2

delay_before_retry 1

}

}

real_server 192.168.100.50 80 {

weight 1

TCP_CHECK {

connect_port 80

connect_timeout 1

nb_get_retry 2

delay_before_retry 1

}

}

}

virtual_server 192.168.100.11 80 {

delay_loop 6

lb_algo wrr

lb_kind DR

protocol TCP

real_server 192.168.100.57 80 {

weight 2

TCP_CHECK {

connect_port 80

connect_timeout 1

nb_get_retry 2

delay_before_retry 1

}

}

real_server 192.168.100.58 80 {

weight 1

TCP_CHECK {

connect_port 80

connect_timeout 1

nb_get_retry 2

delay_before_retry 1

}

}

}

分别测试访问两个VIP:http://192.168.100.10和http://192.168.100.11。其中前者目前只能调度R1:RS1和R1:RS2,后者只能调度R2:RS1和R2:RS2。将任一Director断开,测试4个RS是否仍能继续提供服务。

4.提供sorry server和local RS

如果所有RS都宕了,对于外界来说就真的无法再访问网站了,这显然不适合。这时可以通过keepalived来配置一个服务页面。例如告诉外界客户端网站正在维护状态,或者只提供一个网站的一个主页面。

一般来说,因为是在所有RS都宕机的情况下sorry server提供的临时服务才生效,因此通常将sorry server配置在virtual_server中而非real_server中。

配置时,只需在keepalived配置文件的virtual_server段落中添加sorry_server指令即可。并且,如果启用了vrrp的高可用,应该在master和backup节点上都加上sorry server。

virtual_server 192.168.100.10 80 {

delay_loop 6

lb_algo wrr

lb_kind DR

protocol TCP

sorry_server 127.0.0.1 80

重启keepalived后,再在每个vrrp机器上配置好httpd。

yum -y install httpd

echo "web Maintenancing" >/var/www/html/index.html

service httpd start

然后将所有的RS节点的httpd服务停掉。再看keepalived上的ipvs规则,发现已经将VIP作为规则添加进来了,于是下次访问VIP时将调度这台sorry server。当某一台RS恢复的时候,ipvs规则又会变更为RS的节点。

对于集群系统不大的情况下,LVS Director一般会比较空闲,这样就比较浪费资源。这时通常会将LVS Director自身也作为一个RS,一边提供web服务,一边提供调度功能,不过应该将它的调度权重设置低一点,以免影响负载均衡的性能。这称为local RS,local RS的RIP可以写Director上的任意地址(127.0.0.1都可以)。例如:

real_server 127.0.0.1 80 {

weight 1

TCP_CHECK {

connect_port 80

connect_timeout 1

nb_get_retry 2

delay_before_retry 1

}

}

local RS和sorry server不应该同时设置,因为如果local RS坏了,sorry server肯定无法被调度到。

高可用之KeepAlived(2):keepalived+lvs的更多相关文章

- 高可用群集HA介绍与LVS+keepalived高可用群集

一.Keepalived介绍 通常使用keepalived技术配合LVS对director和存储进行双机热备,防止单点故障,keepalived专为LVS和HA设计的一款健康检查工具,但演变为后来不仅 ...

- 高可用Mysql架构_Haproxy+keepalived+mycat集群的配置

接上一篇文章http://www.cnblogs.com/wt645631686/p/8310891.html,虽然已经在原有两台mycat基础上增加了Haproxy作为mycat的中间服务器,不足的 ...

- 高可用集群之keepalived+lvs实战-技术流ken

keepalived简介 lvs在我之前的博客<高负载集群实战之lvs负载均衡-技术流ken>中已经进行了详细的介绍和应用,在这里就不再赘述.这篇博文将把lvs与keepalived相结合 ...

- 高可用集群之keepalived+lvs实战2

keepalived简介 lvs在我之前的博客<高负载集群实战之lvs负载均衡-技术流ken>中已经进行了详细的介绍和应用,在这里就不再赘述.这篇博文将把lvs与keepalived相结合 ...

- 高可用集群之keepalived+lvs实战

keepalived简介 lvs在我之前的博客<高负载集群实战之lvs负载均衡-技术流ken>中已经进行了详细的介绍和应用,在这里就不再赘述.这篇博文将把lvs与keepalived相结合 ...

- LVS负载均衡+动静分离+高可用(nginx+tomcat+keepalived)

文章目录 [隐藏] 一.环境介绍 二.环境安装 1.安装JDK 2.两台服务器安装tomcat 3.nginx安装 4.keepalive安装 三.负载均衡 四.动静分离 五.keepalive高可用 ...

- 你需要了解的高可用方案之使用keepalived搭建双机热备一览

在之前一篇使用nginx搭建高可用的解决方案的时候,很多同学会问,如果nginx挂掉怎么办,比如下面这张图: 你可以清楚的看到,如果192.168.2.100这台机器挂掉了,那么整个集群就下线了,这个 ...

- MySQL高可用架构:mysql+keepalived实现

系统环境及架构 #主机名 系统版本 mysql版本 ip地址 mysqlMaster <a href="https://www.linuxprobe.com/" title= ...

- Mysql - 高可用方案之MM+Keepalived

一.概述 本文将介绍mysql的MM+Keepalived方案.该方案由两个mysql服务器组成,这两个mysql互为主备.其中一台主作为写服务器,另一台主作为读服务器.通过keepalived软件管 ...

- 打造kubernetes 高可用集群(nginx+keepalived)

一.添加master 部署高可用k8s架构 1.拷贝/opt/kubernetes目录到新的master上(注意如果新机上部署了etcd要排除掉) scp -r /opt/kubernetes/ ro ...

随机推荐

- System.Web.Mvc 3.0.0.1 和 3.0.0.0 有什么区别?被 Microsoft ASP.NET MVC 的一次安全更新害惨了!!!

今天更新站点时,发现网站竟然报错 ... uses 'System.Web.Mvc, Version=3.0.0.1, Culture=neutral, PublicKeyToken=31bf3856 ...

- 前端工程构建工具FIS3

FIS3 是面向前端的工程构建工具.解决前端工程中性能优化.资源加载(异步.同步.按需.预加载.依赖管理.合并.内嵌).模块化开发.自动化工具.开发规范.代码部署等问题. 一.安装 全局安装fis3 ...

- Linux系统中调用短信猫发送短信(笔记)

1, 拷贝底层串口依赖的librxtxSerial.so到JDK安装路径cp librxtxSerial.so /usr/java/{0}/jre/lib/{1} # {0}: JDK的基础目录,例如 ...

- redis键操作

设置键 [root@host ~]# /usr/local/redis/bin/redis-cli 127.0.0.1:6379> set name linux OK 127.0.0.1:637 ...

- iOS-cocoapods安装与使用以及常见错误

前言 CocoaPods是一个负责管理iOS项目中第三方开源代码的工具. 二.安装由于网上的教程基本都大同小异,但细节之处还不是很完善,所以借机会在这里补充下:注:要使用CocoaPods,那就要下载 ...

- Mysql高可用架构(主从同步)

做高可用的优势 1.成本低 2.解决单点故障 3.不容易遇到性能瓶颈 一 .Mysql主从同步架构搭建案例 优点如下:·在业务繁忙阶段,在从服务器上可以执行查询工作(即我们常说的读写分离),降低主服务 ...

- oracle的分组查询和连接查询

分组函数: 六个常用的分组函数: AVG,SUM,MIN,MAX,COUNT,WM_CONCAT: 行转列 PS:分组函数默认会自动过滤控制,可以使用NVL函数使分组函数无法忽略空值: 未使用NVL函 ...

- java 多维数组遍历

java 多维数组遍历的顺序的性能问题 ps:下图为java多维数组内存分布原理.出自:http://math.hws.edu/javanotes/c7/two-dimensional-array.p ...

- Django REST framework反向生成url

Django REST framework是一个基于Django的框架,REST framework又是怎么反向生成url的呢?? 在前面的例子中,知道在REST framework中有6种版本控制的 ...

- rsync源目录写法的一点小细节

原始状态: [root@localhost tmp]# tree . ├── a │ ├── a1 │ └── a2 └── b directories, files [root@localhost ...