Solr(六)Solr索引数据存放到HDFS下

Solr索引数据存放到HDFS下

一 新建solr core hdfs

方法:http://www.cnblogs.com/Matchman/p/7287385.html

二 修改solrconfig.xml文件

文件地址:/usr/local/tomcat/apache-tomcat-8.5.13/solr_home/hdfs/conf/solrconfig.xml

vi /usr/local/tomcat/apache-tomcat-8.5.13/solr_home/hdfs/conf/solrconfig.xml

1 将原文件中<directoryFactory>...</directoryFactory>配置修改成如下:

<directoryFactory name="DirectoryFactory" class="solr.HdfsDirectoryFactory">

<str name="solr.hdfs.home">hdfs://192.168.3.111:9000/news</str>

<bool name="solr.hdfs.blockcache.enabled">true</bool>

<int name="solr.hdfs.blockcache.slab.count">1</int>

<bool name="solr.hdfs.blockcache.direct.memory.allocation">true</bool>

<int name="solr.hdfs.blockcache.blocksperbank">16384</int>

<bool name="solr.hdfs.blockcache.read.enabled">true</bool>

<bool name="solr.hdfs.blockcache.write.enabled">true</bool>

<bool name="solr.hdfs.nrtcachingdirectory.enable">true</bool>

<int name="solr.hdfs.nrtcachingdirectory.maxmergesizemb">16</int>

<int name="solr.hdfs.nrtcachingdirectory.maxcachedmb">192</int>

</directoryFactory>

(注):solr.hdfs.home中配置的为Hadoop的HDFS的访问路劲

2 将原文件中<<lockType>>...</<lockType>>配置修改成如下:

<lockType>${solr.lock.type:hdfs}</lockType>

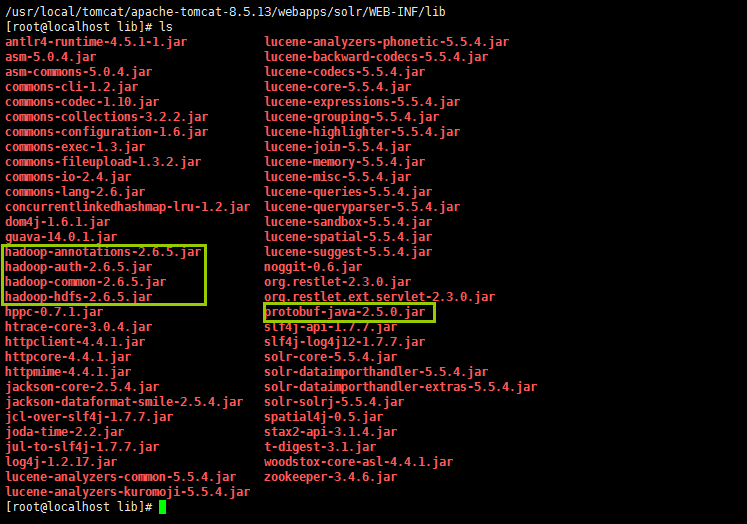

三 替换Jar包

1 从Hadoop中获取以下四个jar包

hadoop-2.6.5/share/hadoop/common/hadoop-common-2.6.5.jar

hadoop-2.6.5/share/hadoop/hdfs/hadoop-hdfs-2.6.5.jar

hadoop-2.6.5/share/hadoop/common/lib/hadoop-auth-2.6.5.jar

hadoop-2.6.5/share/hadoop/common/lib/hadoop-annotations-2.6.5.jar

2 下载protobuf-java-2.5.0.jar包

下载地址:http://download.csdn.net/download/u013292160/9936638

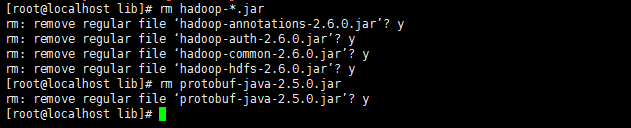

3 删除Jar包

目录:/usr/local/tomcat/apache-tomcat-8.5.13/webapps/solr/WEB-INF/lib

rm hadoop-*.jar

rm protobuf-java-2.5.0.jar

4上传Jar包

将Hadoop中获取的四个Jar包和下载的Jar包上传

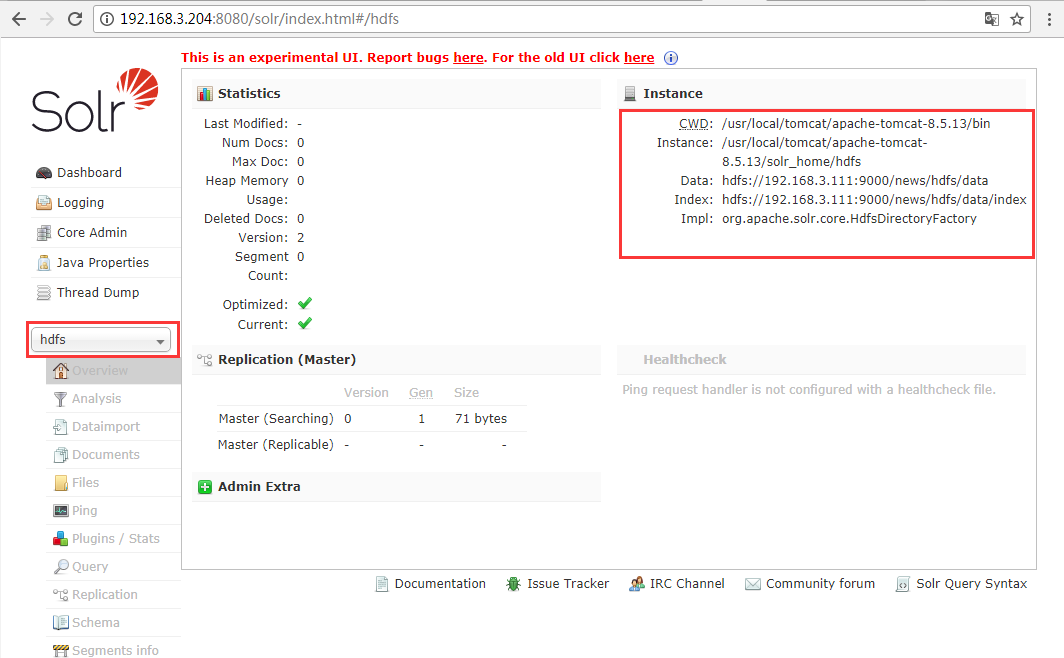

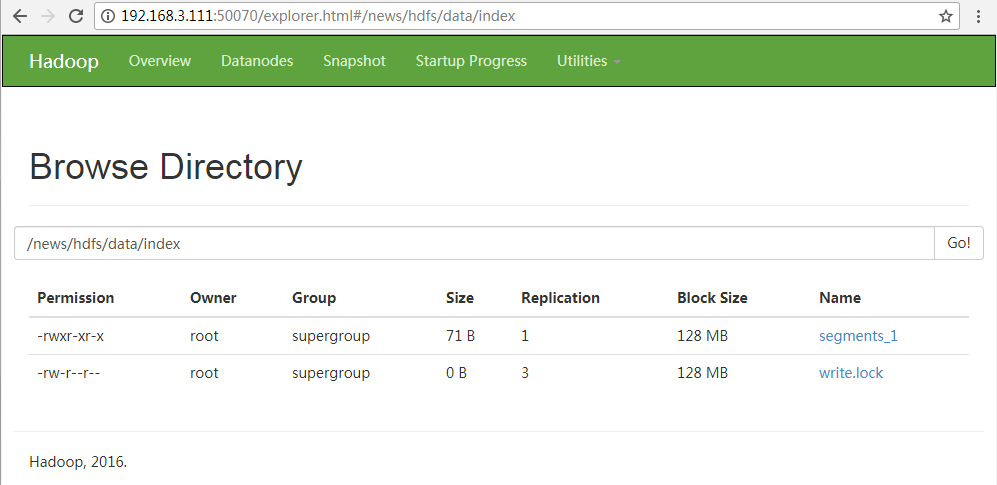

四 重启tomcat访问Solr客户端

cd /usr/local/tomcat/apache-tomcat-8.5.13/bin/ ./startup.sh

Solr(六)Solr索引数据存放到HDFS下的更多相关文章

- 【solr】SolrCloud中索引数据存储于HDFS

SolrCloud中索引数据存储于HDFS 本人最近使用SolrCloud存储索引日志条件,便于快速索引,因为我的索引条件较多,每天日志记录较大,索引想到将日志存入到HDFS中,下面就说说怎么讲sol ...

- solr删除全部索引数据

SOLR 删除全部索引数据: <delete><query>*:*</query></delete><commit/>

- 乐视云监控数据存放到influxdb中

3.9 监控.告警系统 监控报警我们分PaaS平台和业务应用两大类. PaaS平台主要聚焦在基础设施和LeEngine的各个服务组件的监控报警(比如主机CPU,内存,IO,磁盘空间,LeEng ...

- 【PHP】如何将SESSION数据存放到Redis中

在php中,SESSION的数据默认是存放到文件中,这样性能不仅不高,而且不利于扩展.在搭建集群后,默认存放到文件中就不适用了.所以,我们一般将SESSION自定义,让SESSION中的数据存放到 数 ...

- solr开发,提交索引数据的几种方式

今天抽空学习了一下solr,有新东西学习就是哈皮! 期待能有机会与实战.实例仅为个人理解学习实例.提交到Solr服务器上的数据必须是 SolrInputDocument 类型. 方案一:利用反射,自定 ...

- [solr 管理界面] - 索引数据删除

删除solr索引数据,使用XML有两种写法: 1) <delete><id>1</id></delete> <commit/> 2) < ...

- Ajax返回的数据存放到js数组

js定义数组比较简单: var array = [ ] ; 即可 今天记录一下 js 数组的常用规则: 1. b = [1,'da',"sdaf"]; //定义数组给数组添加默认 ...

- Solr的学习使用之(五)添加索引数据

1.创建SolrServer类 SolrServer类:提供与Solr实例的连接与通信. 往Solr里添加索引数据,据说有好几种办法,这边利用SolrJ操作solr API完成index操作,具体So ...

- solr与.net系列课程(六)solr定时增量索引与安全

solr与.net系列课程(六)solr定时增量索引与安全 solr增量索引的方式,就是一个Http请求,但是这样的请求显然不能满足要求,我们需要的是一个自动的增量索引,solr官方提供了一个定时器 ...

随机推荐

- Libgdx 1.6.1发布,跨平台游戏开发框架

Libgdx 1.6.1发布 [1.6.1] 英文原文:http://www.badlogicgames.com/wordpress/?p=3694 译文翻译:宋志辉 - Net.newServerS ...

- STL:STL各种容器的使用时机详解

C++标准程序库提供了各具特长的不同容器.现在的问题是:该如何选择最佳的容器类别?下表给出了概述. 但是其中有些描述可能不一定实际.例如:如果你需呀处理的元素数量很少,可以虎落复杂度,因为线性算法通常 ...

- 小强的HTML5移动开发之路(11)——链接,图片,表格,框架

来自:http://blog.csdn.net/dawanganban/article/details/18098193 一.HTML是什么? HTML(hypertext mark-uplangua ...

- 如何在Git中撤销一切 | 干货

翻译:李伟 审校:张帆 译自:Github JF杰微刊:如何在Git中撤销一切 任何一个版本控制系统中,最有用的特性之一莫过于 "撤销(undo)"操作.在Git中,"撤 ...

- Linux Shell 命令--awk

说明: awk被设计用于数据流,能够对列和行进行操作.而sed更多的是匹配,进行替换和删除.awk有很多内建的功能,比如数组,函数等.灵活性是awk的最大优势. awk的结构}{i++}END{pr ...

- Get/POST方法提交的长度限制

1. Get方法长度限制 Http Get方法提交的数据大小长度并没有限制,HTTP协议规范没有对URL长度进行限制.这个限制是特定的浏览器及服务器对它的限制. 如:IE对URL长度的限制 ...

- HashMap与HashTable面试宝典

u012233832的专栏 初生牛犊 目录视图 摘要视图 订阅 写博客,送money.送书.送C币啦 7-8月博乐推荐文章 砸BUG 得大奖 100%中奖率 微信开发学习路线高级篇上线 ...

- Android 5.0 SEAndroid下如何获得对一个内核节点的访问权限

-9]* u:object_r:tty_device:s0 # We add here /dev/wf_bt u:object_r:wf_bt_device:s0 wf_bt ...

- STL - 各个容器的使用时机

deque的使用场景:比如排队购票系统,对排队者的存储可以采用deque,支持头端的快速移除,尾端的快速添加.如果采用vector,则头端移除时,会移动大量的数据,速度慢. vector与deque的 ...

- Mahout Bayes分类

Mahout Bayes分类器是按照<Tackling the Poor Assumptions of Naive Bayes Text Classiers>论文写出来了,具体查看论文 实 ...