python爬虫入门---第二篇:获取2019年中国大学排名

我们需要爬取的网站:最好大学网

我们需要爬取的内容即为该网页中的表格部分:

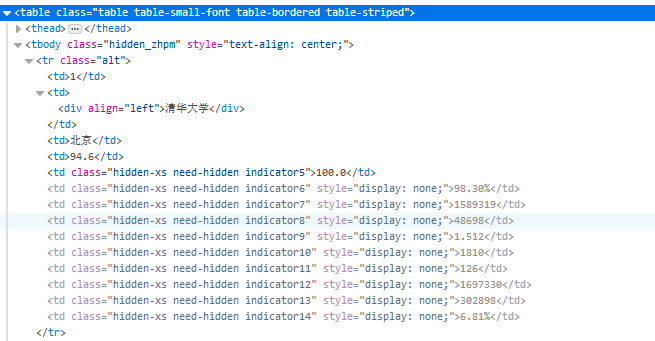

该部分的html关键代码为:

其中整个表的标签为<tbody>标签,每行的标签为<tr>标签,每行中的每个单元格的标签为<td>标签,而我们所需的内容即为每个单元格中的内容。

因此编写程序的大概思路就是先找到整个表格的<tbody>标签,再遍历<tbody>标签下的所有<tr>标签,最后遍历<tr>标签下的所有<td>标签,

我们用二维列表来存储所有的数据,其中二维列表中的每个列表用于存储一行中的每个单元格数据,即<tr>标签下的所有<td>标签中的所有字符串。

代码如下;

import requests

from bs4 import BeautifulSoup

import bs4 def get_html_text(url):

'''返回网页的HTML代码'''

try:

res = requests.get(url, timeout = 6)

res.raise_for_status()

res.encoding = res.apparent_encoding

return res.text

except:

return '' def fill_ulist(ulist, html):

'''将我们所需的数据写入一个列表ulist''' #解析HTML代码,并获得解析后的对象soup

soup = BeautifulSoup(html, 'html.parser')

#遍历得到第一个<tbody>标签

tbody = soup.tbody

#遍历<tbody>标签的孩子,即<tbody>下的所有<tr>标签及字符串

for tr in tbody.children:

#排除字符串

if isinstance(tr, bs4.element.Tag):

#使用find_all()函数找到tr标签中的所有<td>标签

u = tr.find_all('td')

#将<td>标签中的字符串内容写入列表ulist

ulist.append([u[0].string, u[1].string, u[2].string, u[3].string]) def display_urank(ulist):

'''格式化输出大学排名'''

tplt = "{:^5}\t{:{ocp}^12}\t{:{ocp}^5}\t{:^5}"

#方便中文对其显示,使用中文字宽作为站字符,chr(12288)为中文空格符

print(tplt.format("排名", "大学名称", "省市", "总分", ocp = chr(12288)))

for u in ulist:

print(tplt.format(u[0], u[1], u[2], u[3], ocp = chr(12288))) def write_in_file(ulist, file_path):

'''将大学排名写入文件'''

tplt = "{:^5}\t{:{ocp}^12}\t{:{ocp}^5}\t{:^5}\n"

with open(file_path, 'w') as file_object:

file_object.write('软科中国最好大学排名2019版:\n\n')

file_object.write(tplt.format("排名", "大学名称", "省市", "总分", ocp = chr(12288)))

for u in ulist:

file_object.write(tplt.format(u[0], u[1], u[2], u[3], ocp = chr(12288))) def main():

'''主函数'''

ulist = []

url = 'http://www.zuihaodaxue.cn/zuihaodaxuepaiming2019.html'

file_path = 'university rankings.txt'

html = get_html_text(url)

fill_ulist(ulist, html)

display_urank(ulist)

write_in_file(ulist, file_path) main()

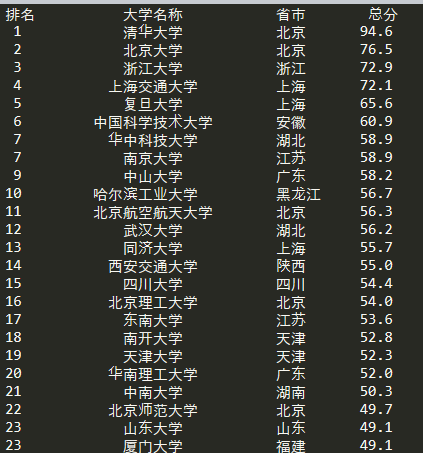

打印显示:

python爬虫入门---第二篇:获取2019年中国大学排名的更多相关文章

- Python爬虫入门案例:获取百词斩已学单词列表

百词斩是一款很不错的单词记忆APP,在学习过程中,它会记录你所学的每个单词及你答错的次数,通过此列表可以很方便地找到自己在记忆哪些单词时总是反复出错记不住.我们来用Python来爬取这些信息,同时学习 ...

- python爬虫入门---第一篇:获取某一网页所有超链接

这是一个通过使用requests和BeautifulSoup库,简单爬取网站的所有超链接的小爬虫.有任何问题欢迎留言讨论. import requests from bs4 import Beauti ...

- 2.Python爬虫入门二之爬虫基础了解

1.什么是爬虫 爬虫,即网络爬虫,大家可以理解为在网络上爬行的一直蜘蛛,互联网就比作一张大网,而爬虫便是在这张网上爬来爬去的蜘蛛咯,如果它遇到资源,那么它就会抓取下来.想抓取什么?这个由你来控制它咯. ...

- Python爬虫入门二之爬虫基础了解

1.什么是爬虫 爬虫,即网络爬虫,大家可以理解为在网络上爬行的一直蜘蛛,互联网就比作一张大网,而爬虫便是在这张网上爬来爬去的蜘蛛咯,如果它遇到资源,那么它就会抓取下来.想抓取什么?这个由你来控制它咯. ...

- 转 Python爬虫入门二之爬虫基础了解

静觅 » Python爬虫入门二之爬虫基础了解 2.浏览网页的过程 在用户浏览网页的过程中,我们可能会看到许多好看的图片,比如 http://image.baidu.com/ ,我们会看到几张的图片以 ...

- Python爬虫入门有哪些基础知识点

1.什么是爬虫 爬虫,即网络爬虫,大家可以理解为在网络上爬行的一直蜘蛛,互联网就比作一张大网,而爬虫便是在这张网上爬来爬去的蜘蛛咯,如果它遇到资源,那么它就会抓取下来.想抓取什么?这个由你来控制它咯. ...

- Python爬虫入门(二)之Requests库

Python爬虫入门(二)之Requests库 我是照着小白教程做的,所以该篇是更小白教程hhhhhhhh 一.Requests库的简介 Requests 唯一的一个非转基因的 Python HTTP ...

- Python开发【第二篇】:初识Python

Python开发[第二篇]:初识Python Python简介 Python前世今生 python的创始人为吉多·范罗苏姆(Guido van Rossum).1989年的圣诞节期间,吉多·范罗苏 ...

- Python爬虫入门教程 43-100 百思不得姐APP数据-手机APP爬虫部分

1. Python爬虫入门教程 爬取背景 2019年1月10日深夜,打开了百思不得姐APP,想了一下是否可以爬呢?不自觉的安装到了夜神模拟器里面.这个APP还是比较有名和有意思的. 下面是百思不得姐的 ...

随机推荐

- Android开发 - 掌握ConstraintLayout(五)偏差(Bias)

比如实现这样一个场景: "在屏幕宽度的1/4的地方放置一个View" 使用传统布局时,实现按照屏幕的宽度(高度),或者相对两个View之间距离的一个比例来进行布局,就显得非常麻烦, ...

- 从零搭建java后台管理系统(二)mysql和redis安装

接上篇开始安装mysql和redis 注意了,如果用阿里云服务器,外网访问的端口必须在安全组开启,否则外网访问不通 三.服务器安装redis和mysql 本次环境搭建将所有第三方服务会安装在阿里云服务 ...

- 机器学习技法笔记:14 Radial Basis Function Network

Roadmap RBF Network Hypothesis RBF Network Learning k-Means Algorithm k-Means and RBF Network in Act ...

- LeetCode:21_Merge Two Sorted Lists | 合并两个排序列表 | Easy

题目:Merge Two Sorted Lists Merge two sorted linked lists and return it as a new list. The new list sh ...

- LDA-线性判别分析(三)推广到 Multi-classes 情形

本来是要调研 Latent Dirichlet Allocation 的那个 LDA 的, 没想到查到很多关于 Linear Discriminant Analysis 这个 LDA 的资料.初步看了 ...

- matlab中数组的拼接

matlab中,行拼接用逗号“:”,列拼接用分号“,”.示例如下: >> a=[1,2,3,4] 结果: a = 1 2 3 4 >> b=[1;2;3;4] 结果: b = ...

- BF算法(模式匹配)

BF算法 (Brute-Force算法) 一种简单的模式匹配算法,目的是寻找模式串p是否在目标串s中有出现. 思想:先从第一个字符开始匹配,如果p[j]==s[i],那么继续向下比较,一旦不相等,即回 ...

- CentOS 6.5的安装详解(图文详解)

不多说,直接上干货! 主流: 目前的Linux操作系统主要应用于生产环境, 主流企业级Linux系统仍旧是RedHat或者CentOS. 免费: RedHat 和CentOS差别不大,CentOS是一 ...

- 使用crypt配置Basic Auth登录认证

简介 Basic Auth用于服务端简单的登录认证,通常使用服务器Nginx.Apache本身即可完成.比如我们要限定某个域名或者页面必须输入用户名.密码才能登录,但又不想使用后端开发语言,此时Bas ...

- Linux 常用命令 | mkdir/rmdir/touch 的使用

一.创建空目录 命令:mkdir 原意:make directories 所在路径: /bin/mkdir 1.创建空目录 2.递归创建空目录 选项:-p 如果直接使用mkdir 创建空目录: W ...