hadoop 修改datanode balance带宽使用限制

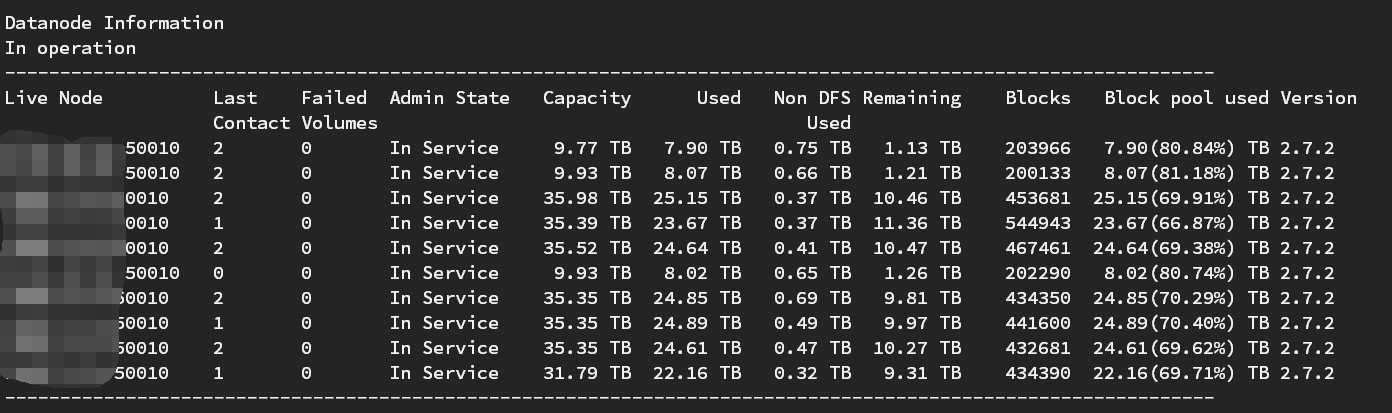

前段时间,一个客户现场的Hadoop看起来很不正常,有的机器的存储占用达到95%,有的机器只有40%左右,刚好前任的负责人走了,这边还没有明确接班人的时候。

我负责的大数据计算部分,又要依赖Hadoop的基础平台,要是Hadoop死了,我的报表也跑不出来(专业背锅)。

做下balance,让各个节点的存储均衡一下。

1、首先需要配上这个参数:

<property>

<name>dfs.datanode.balance.bandwidthPerSec</name>

<value></value>

<description>hdfs做balance的占用的网络带宽,建议配置网卡带宽的一半(//*=480MBps)</description>

</property>

2、重启datanode

# 停止datanode

[hadoop@venn06 sbin]$ ./hadoop-daemon.sh stop datanode

stopping datanode # 启动datanode

[hadoop@venn06 sbin]$ ./hadoop-daemon.sh start datanode

starting datanode, logging to /opt/hadoop/hadoop3/logs/hadoop-hadoop-datanode-venn06.out

服务器网卡的带宽有限,不设置这个参数,做balance的时候,会把网卡的带宽跑满。需要移动的block很多,执行时间就会很长,会导致集群网络资源不足,任务跑得很慢。

3、执行balance

[hadoop@venn05 bin]$ pwd

/opt/hadoop/hadoop3/bin

[hadoop@venn05 bin]$ nohup ./hdfs balancer -threshold 1 &

由于执行时间会很长,所以把命令放到后台执行。

HDFS做balance的方式大概如下:

1、计算集群中需要移动的block数量,计算需要移动的文件大小。

2、并发的从资源占用高的机器,往资源占用低的机器移数据。一批一批的移,一批的大小,会根据需要移动的文件大小计算。

3、重复第1步,直到资源均衡(1%左右的差距)

HDFS做balance的时候,会先移动block,成功后才会删除数据,只要集群网络资源充足,可以不警慎的执行balance操作,随时停也不影响,不会丢数据。

由于datanode 空间大小不同,所以有的机器磁盘占用会高一点。

hadoop 修改datanode balance带宽使用限制的更多相关文章

- Hadoop的datanode无法启动

Hadoop的datanode无法启动 hdfs-site中配置的dfs.data.dir为/usr/local/hadoop/hdfs/data 用bin/hadoop start-all.sh启动 ...

- 设置Hadoop的 dataNode的单个Map的内存配置

1.进入hadoop的配置目录 ,找到 环境变量的 $HADOOP_HOME cd $HADOOP_HOME 2.修改dataNode 节点的 单个map的能使用的内存配置 找到配置的文件: /opt ...

- hadoop修改MR的提交的代码程序的副本数

hadoop修改MR的提交的代码程序的副本数 Under-Replicated Blocks的数量很多,有7万多个.hadoop fsck -blocks 检查发现有很多replica missing ...

- linux及hadoop修改权限

linux下修改文件权限: 在shell环境里输入:ls -l 或者 ls -lh drwxr-xr-x 2 nsf users 1024 12-10 17:37 下载文件备份对应:文件属性 连接数 ...

- hadoop启动 datanode的live node为0

hadoop启动 datanode的live node为0 浏览器访问主节点50070端口,发现 Data Node 的 Live Node 为 0 查看子节点的日志 看到 可能是无法访问到主节点的9 ...

- 解决hadoop no dataNode to stop问题

错误原因: datanode的clusterID 和 namenode的 clusterID 不匹配. 解决办法: 1. 打开 hadoop/tmp/dfs/namenode/name/dir 配置对 ...

- hadoop修改

https://github.com/medcl/elasticsearch-analysis-ik/releases hadoop-/etc/hadoop/core-site.xml <con ...

- hadoop 运行 datanode , mac 系统

问题描述 今天使用 hadoop 时,发现无法通过下面命令上传文件到 hadoop 文件系统,会报错. bin/hadoop fs -put input . 运行 jps 后,输出如下: Resour ...

- hadoop中datanode无法启动

一.问题描述 当我多次格式化文件系统时,如 [hadoop@xsh hadoop]$ ./bin/hdfs namenode -format 会出现datanode无法启动,查看日志(/usr/loc ...

随机推荐

- [Codeforces_713A]Sonya and Queries

题目链接 http://codeforces.com/problemset/problem/713/A 题意 三种操作: + ai 集合里加一个整数ai,相同数记为多个. - ai 集合里减一个 ...

- elasticsearch的索引操作和文档操作总结

参考文档:https://es.xiaoleilu.com/010_Intro/00_README.html 一.索引操作 1.查看当前节点的所有的index 查看当前节点的所有的index [roo ...

- css浮动知识点(转)

转自:http://www.cnblogs.com/iyangyuan/archive/2013/03/27/2983813.html 很早以前就接触过CSS,但对于浮动始终非常迷惑,可能是自身理解能 ...

- swift4.2 打印所有系统字体

func showAllFonts(){ let familyNames = UIFont.familyNames var index:Int = 0 for familyName in family ...

- web中CookieUtils的工具类

该类中包含Web开发中对Cookie的常用操作,如需要Copy带走 package com.project.utils; import java.io.UnsupportedEncodingExcep ...

- day 11 生成器

生成器生成器本质就是迭代器,生成器是自己用python代码写的迭代器 将函数变成生成器yield用next 取值一个next,对应一个yield def func(): yield 111 yield ...

- SprinMVC中文件上传只在内存保留一份拷贝

背景:web项目里经常有上传文件的模块,某些特殊场景下,上传文件的人不希望在服务器留存一份原始文件,这个时候就需要把文件放到内存里了. 笔者调试了一下springmvc里面的CommonsMultip ...

- javascript 生存周期

生存周期: 局部 JavaScript 变量 在 JavaScript 函数内部声明的变量(使用 var)是局部变量,所以只能在函数内部访问它.(该变量的作用域是局部的). 您可以在不同的函数中使用名 ...

- python 3.6.5 map() max() lambda匿名函数

python 3.6.5 sample: map() 会根据提供的函数对指定序列做映射. 第一个参数 function 以参数序列中的每一个元素调用 function 函数,返回包含每次 functi ...

- 4. 深入 Python 流程控制

除了前面介绍的 while 语句,Python 还从其它语言借鉴了一些流程控制功能,并有所改变. 4.1. if 语句 也许最有名的是 if 语句.例如: >>> x = int(i ...