k8s如何管理Pod(rc、rs、deployment)

使用Replication Controller 来部署、升级Pod

Replica Set – 下一代Replication Controller

Deployment – 更加方便的管理Pod和Replica Set

先举个例子,假设我们有一个Pod在提供线上服务,现在有如下几个场景,大家想想如何应对:

节日活动,网站访问量突增

遭到攻击,网站访问量突增

运行Pod的节点发生故障

第1种情况,活动前预先多启动几个Pod,活动结束后再结束掉多余的,虽然要启动和结束的Pod有点多,但也能有条不紊按计划进行

第2种情况,正在睡觉突然手机响了说网站反应特慢卡得要死,赶紧爬起来边扩容边查找攻击模式、封IP等等……

第3种情况,正在休假突然手机又响了说网站上不去,赶紧打开电脑查看原因,启动新的Pod

Pod需要手动管理,好累……能否在Pod发生问题时自动恢复呢,我们先来看下Replication Controller(以下简称RC)

先说RC是什么。RC保证在同一时间能够运行指定数量的Pod副本,保证Pod总是可用。如果实际Pod数量比指定的多就结束掉多余的,如果实际数量比指定的少就启动缺少的。当Pod失败、被删除或被终结时RC会自动创建新的Pod来保证副本数量。所以即使只有一个Pod也应该使用RC来进行管理。

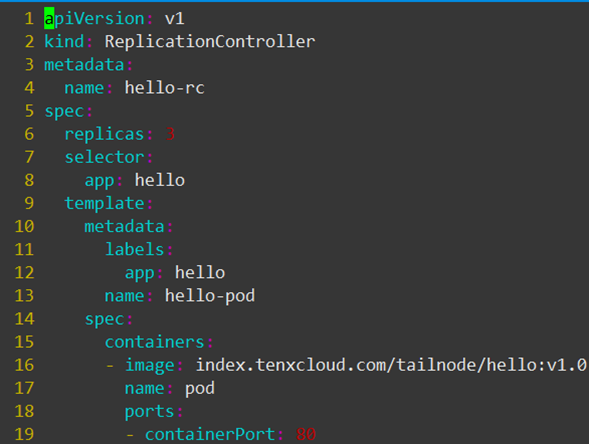

接下来我们看下如何创建RC,看这个定义文件rc.yaml

这个文件定义了RC的属性,我们先关注如下字段:

spec.replicas:副本数量3

spec.selector:RC通过spec.selector来筛选要控制的Pod

spec.template:这里写Pod的定义(但不需要apiVersion和kind)

spec.template.metadata.labels:Pod的label,可以看到这个label与spec.selector相同

这个文件的意思是定义了一个RC对象,它的名字是hello-rc(metadata.name:hello-rc),保证有3个Pod运行(spec.replicas:3),Pod的镜像是index.tenxcloud.com/tailnode/hello:v1.0(spec.template.spec.containers.image: index.tenxcloud.com/tailnode/hello:v1.0)关键在于spec.selector与spec.template.metadata.labels,这两个字段必须相同,否则下一步创建RC会失败。(也可以不写spec.selector,这样默认与spec.template.metadata.labels相同)

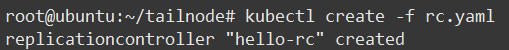

现在通过kubectl来创建RC:

查看结果可以看到当前RC的状态:指定了需要3个Pod、当前实际有3个Pod、3个Pod都在运行中(图片较大只截取部分):

如果使用的镜像较大查看状态可能是Waiting,这是因为正在下载镜像,等待一段时间就好。

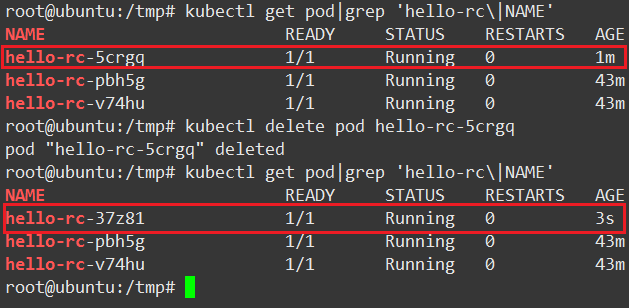

上面说过RC会自动管理Pod保证指定数量副本运行,我们来实验一下,看下图:

2.删除hello-rc-5crgq

3.再次查看Pod,发现新的Pod启动了(注意NAME和AGE列)

到这里我们对RC有了基本的认识,并进行了简单的使用。

现在回到最开始的问题,如何通过RC修改Pod副本数量。其实非常简单,只需要修改yaml文件spec.replicas字段成想要的值,然后执行kubectl replace命令(或者使用kubect edit replicationcontroller hello-rc直接修改)

执行结果看下图:

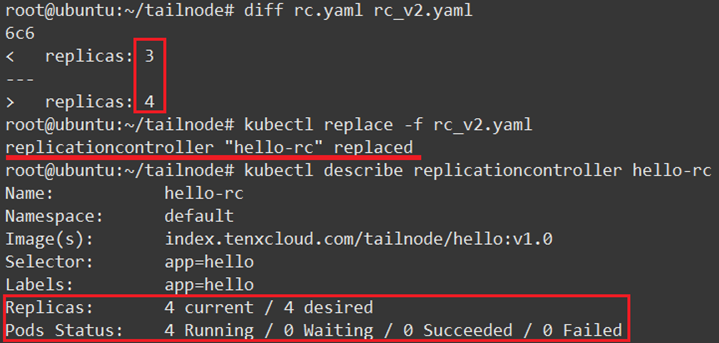

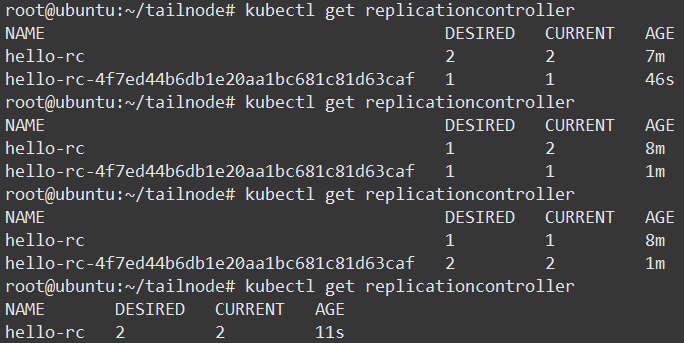

当我们有新功能发布或修复BUG时使用滚动升级是不错的选择,可以使用工具kubectl rolling-update完成这个任务。对照下图我们来看下是如何进行的

使用命令kubectl rolling-update hello-rc –image=index.tenxcloud.com/tailnode/hello:v2.0

对照两张截图,我们能够看出升级步骤如下:

创建一个使用新版本Pod的RC,hello-rc-4f7ed44b6db1e20aa1bc681c81d63caf

依次增加新RC的副本数量、减少旧RC的副本数量

当升级成功后,删除旧RC

重命名新RC为hello-rc

当Pod中只有一个容器时通过--image参数指定新的Tag,如果有多个容器或其他字段的修改时,需要使用kubectl rolling-update NAME -f FILE指定文件

如果在升级过程中出现问题(比如长时间无响应),可以CTRL+C结束再使用kubectl rolling-update hello-rc –-rollback进行回滚,但如果升级完成后出现问题(比如新版本程序出core),此命令无能为力,需要使用同样方法“升级”为旧版本

在时速云平台我们能够非常方便的使用弹性伸缩功能来调整Pod副本数量,还是举例说明:

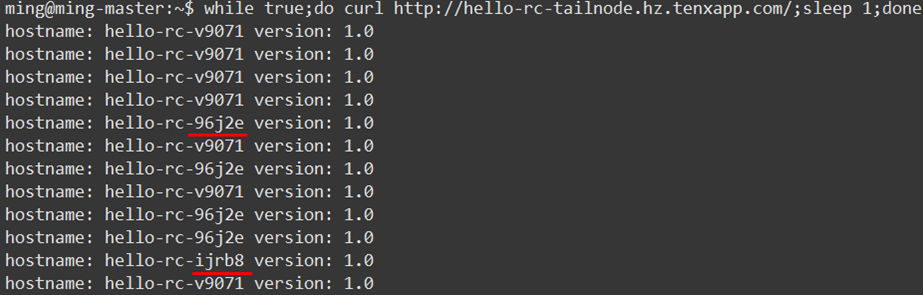

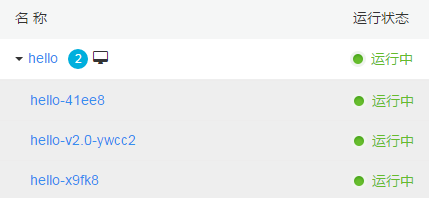

启动一个能够输出Pod主机名和版本号的服务,看下图当前只有一个Pod副本运行

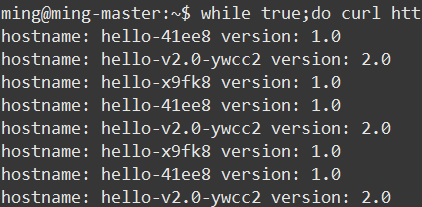

下面再来测试下灰度升级功能,修改目标版本为v2.0(之前是v1.0,为了便于查看效果新建有2个Pod的服务),然后查看Pod变化

第一个新Pod hello-v2.0-ywcc2已经启动

k8s是一个高速发展的项目,在新的版本中官方推荐使用Replica Set和Deployment来代替RC。那么它们优势在哪里,我们来看一看:

RC只支持基于等式的selector(env=dev或environment!=qa)但Replica Set还支持新的基于集合的selector(version in (v1.0, v2.0)或env notin (dev, qa)),这对复杂的运维管理带来很大方便

使用Deployment升级Pod只需要定义Pod的最终状态,k8s会为你执行必要的操作,虽然能够使用命令kubectl rolling-update完成升级,但它是在客户端与服务端多次交互控制RC完成的,所以REST API中并没有rolling-update的接口,这为定制自己的管理系统带来了一些麻烦。

Deployment拥有更加灵活强大的升级、回滚功能

Replica Set目前与RC的区别只是支持的selector不同,后续肯定会加入更多功能。Deployment使用了Replica Set,是更高一层的概念。除非需要自定义升级功能或根本不需要升级Pod,所以推荐使用Deployment而不直接使用Replica Set。

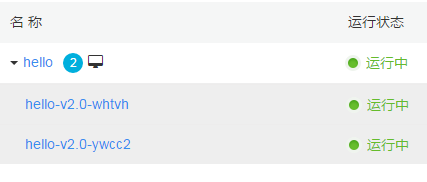

下面我们继续来看Deployment的定义文件,与RC的定义文件基本相同(注意apiVersion还是beta版),所以不再详细解释各字段意思

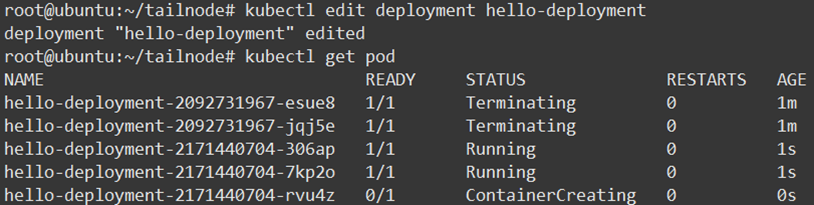

使用kubectl edit deployment hello-deployment修改spec.replicas/spec.template.spec.container.image字段来完成扩容缩容与滚动升级(比kubectl rolling-update速度快很多)

修改image字段为新版本镜像后查看Pod,在STATUS列看到正在执行升级的Pod:

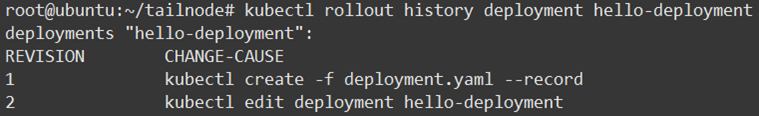

使用kubectl rollout history命令查看Deployment的历史信息

上面提到过kubectl rolling-update升级成功后不能直接回滚,不是很方便,那使用Deployment可以吗,答案是肯定的。

首先在上面的命令加上–revision参数,查看改动详细信息如下:

命令kubectl describe deployment hello-deployment查看详细信息,在Message一列看到回滚如下,详细的信息记录对于问题发生后的原因查找有很大帮助:

通过对比RC、Replica Set与Deployment,可以看出新的Replica Set与Deployment比RC要强大易用很多,但因为现在还是beta版本所以不建议在生产环境使用,不过相信不久的将来我们就能使用上。

k8s如何管理Pod(rc、rs、deployment)的更多相关文章

- 管理Pod(rc,rs,deployment)

1.概述 可以把容器想像成豆荚里的豆子,把一个或多个关系紧密的豆子包在一起就是豆荚(一个Pod).在k8s中我们不会直接操作容器,而是把容器包装成Pod再进行管理. 2.管理Pod a. 使用Repl ...

- k8s几种pod的控制器

replicationcontroller 选择器 模版 副本数 如果更改选择器,则会创建新的pod 如果更改pod的标签,那么也会创建新的pod进行替换,但是老的pod不会被删除 如果更改模版, ...

- 3.k8s资源控制器rs Deployment Job

k8s资源控制器 #控制器类型 ReplicaSet #rs,确保pod副本数,rs已替代rc Deployment #管理rs,升级.回滚.扩容pod DaemonSet #在每个节点运行一个Pod ...

- kubernetes云平台管理实战:deployment通过标签管理pod(十)

一.kubectl run命令拓展 1.RC创建 [root@k8s-master ~]# kubectl run web --generator=run/v1 --image=10.0.128.0: ...

- [转帖] Kubernetes如何使用ReplicationController、Replica Set、Deployment管理Pod ----文章很好 但是还没具体操作实践 也还没记住.

Kubernetes如何使用ReplicationController.Replica Set.Deployment管理Pod https://blog.csdn.net/yjk13703623757 ...

- 【K8S】K8S-网络模型、POD/RC/SVC YAML 语法官方文档

K8S-网络模型.POD/RC/SVC YAML 语法官方文档 Kubernetes - Production-Grade Container Orchestration kubernetes/kub ...

- k8s管理pod资源对象(上)

一.容器于pod资源对象 现代的容器技术被设计用来运行单个进程时,该进程在容器中pid名称空间中的进程号为1,可直接接收并处理信号,于是,在此进程终止时,容器即终止退出.若要在一个容器中运行多个进程, ...

- k8s 中的 Pod 细节了解

k8s中Pod的理解 基本概念 k8s 为什么使用 Pod 作为最小的管理单元 如何使用 Pod 1.自主式 Pod 2.控制器管理的 Pod 静态 Pod Pod的生命周期 Pod 如何直接暴露服务 ...

- Spring Cloud Config整合Spring Cloud Kubernetes,在k8s上管理配置

1 前言 欢迎访问南瓜慢说 www.pkslow.com获取更多精彩文章! Kubernetes有专门的ConfigMap和Secret来管理配置,但它也有一些局限性,所以还是希望通过Spring C ...

随机推荐

- HTML基础之CSS

CSS选择器 1.id选择器 2.class选择器 3.标签选择器 4.层级选择器(空格) 5.组合选择器(逗号) 6.属性选择器(中括号) <!DOCTYPE html> <htm ...

- mybatis 异常 too many connections 解决方案 mysql

参考: https://blog.csdn.net/u011628250/article/details/54017481 https://www.cnblogs.com/baby123/p/5710 ...

- 详解C#7.0新特性

1. out 变量(out variables) 以前我们使用out变量必须在使用前进行声明,C# 7.0 给我们提供了一种更简洁的语法 “使用时进行内联声明” .如下所示: 1 var input ...

- flask_admin 笔记五 内置模板设置

内建模板 Flask-Admin是使用jinja2模板引擎 1)扩展内建的模板 不要完全覆盖内置的模板,最好是扩展它们. 这将使您更容易升级到新的Flask-Admin版本. 在内部,Flask-Ad ...

- Hyperledger Fabric v1.1.0安装记录(国内源版)

1. 安装虚拟机 虚拟机软件采用:VirtualBox 操作系统选择:Ubuntu 14.04 内存:4G CPU:2核 硬盘:20G 2.(可选)更改 ...

- 微软职位内部推荐-Senior Program Manager

微软近期Open的职位: Title: Senior Program Manager – Bing Multimedia Relevance Group: Search Technology Cent ...

- 1082. Read Number in Chinese (25)-字符串处理

题意就是给出9位以内的数字,按照汉子的读法读出来. 读法请看下方的几个例子: 5 0505 0505 伍亿零伍佰零伍万零伍佰零伍 5 5050 5050 伍亿伍仟零伍拾万伍仟零伍拾 (原本我以为这个 ...

- Android中应用contentprovider来创建数据库的一些步骤

http://blog.csdn.net/xiaodongvtion/article/details/7865669 1:首先创建一个xxprovider的class,它是extendscontent ...

- 《Linux内核分析》课程第五周学习总结

姓名:何伟钦 学号:20135223 ( *原创作品转载请注明出处*) ( 学习课程:<Linux内核分析>MOOC课程http://mooc.study.163.com/course/U ...

- 20135234mqy-——信息安全系统设计基础第十四周学习总结

第九章 虚拟存储器 主要作用: 将主存看作是一个存储在磁盘上的地址空间的高速缓存,在主存中只保护活动的区域,并根据需要在磁盘和主存之间来回传送数据: 为每个进程提供了一致的地址空间,从而简化了存储器管 ...