Java爬虫学习(3)之用对象保存新浪微博博文

package com.mieba; import us.codecraft.webmagic.Page;

import us.codecraft.webmagic.Site;

import us.codecraft.webmagic.processor.PageProcessor; public class SinaPageProcessor implements PageProcessor

{

public static final String URL_LIST = "http://blog\\.sina\\.com\\.cn/s/articlelist_1487828712_0_\\d+\\.html"; public static final String URL_POST = "http://blog\\.sina\\.com\\.cn/s/blog_\\w+\\.html"; private Site site = Site.me().setTimeOut(10000).setRetryTimes(3).setSleepTime(1000).setCharset("UTF-8").setUserAgent( "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_7_2) AppleWebKit/537.31 (KHTML, like Gecko) Chrome/26.0.1410.65 Safari/537.31");; @Override

public Site getSite()

{

// TODO Auto-generated method stub

return site;

} @Override

public void process(Page page)

{

// TODO Auto-generated method stub

// 列表页 if (page.getUrl().regex(URL_LIST).match())

{

// 从页面发现后续的url地址来抓取

page.addTargetRequests(page.getHtml().xpath("//div[@class=\"articleList\"]").links().regex(URL_POST).all()); page.addTargetRequests(page.getHtml().links().regex(URL_LIST).all()); // 文章页 } else

{

String title = new String();

String content = new String();

Article ar = new Article(title, content);

// 定义如何抽取页面信息,并保存下来

ar.setTitle(page.getHtml().xpath("//div[@class='articalTitle']/h2/text()").toString()); ar.setContent(

page.getHtml().xpath("//div[@id='articlebody']//div[@class='articalContent']/text()").toString());

System.out.println("title:"+ar.getTitle());

System.out.println(ar.getContent());

page.putField("repo", ar);

// page.putField("date", page.getHtml().xpath("//div[@id='articlebody']//span[@class='time SG_txtc']/text()").regex("\\((.*)\\)")); }

} }

package com.mieba; import java.io.FileNotFoundException;

import java.io.FileWriter;

import java.io.IOException;

import java.io.PrintWriter;

import java.util.Vector; import us.codecraft.webmagic.ResultItems;

import us.codecraft.webmagic.Task;

import us.codecraft.webmagic.pipeline.Pipeline; public class SinaPipeline implements Pipeline

{ @Override

public void process(ResultItems resultItems, Task arg1)

{

// TODO Auto-generated method stub

Article vo = resultItems.get("repo");

PrintWriter pw = null;

try

{

pw = new PrintWriter(new FileWriter("sina.txt", true)); pw.println(vo);

pw.flush(); }catch(FileNotFoundException e) {

e.printStackTrace();

}catch (IOException e)

{

e.printStackTrace();

} finally

{

pw.close();

}

} }

package com.mieba; public class Article

{

private String title;

private String content;

public String getTitle()

{

return title;

}

public void setTitle(String title)

{

this.title = title;

}

public String getContent()

{

return content;

}

public void setContent(String content)

{

this.content = content;

}

public Article(String title, String content)

{

super();

this.title = title;

this.content = content;

}

@Override

public String toString()

{

return "Article [title=" + title + ", content=" + content + "]";

} }

package com.mieba; import us.codecraft.webmagic.Spider; public class Demo

{ public static void main(String[] args)

{ // 爬取开始

Spider

// 爬取过程

.create(new SinaPageProcessor())

// 爬取结果保存

.addPipeline(new SinaPipeline())

// 爬取的第一个页面

.addUrl("http://blog.sina.com.cn/s/articlelist_1487828712_0_1.html")

// 启用的线程数

.thread(5).run();

}

}

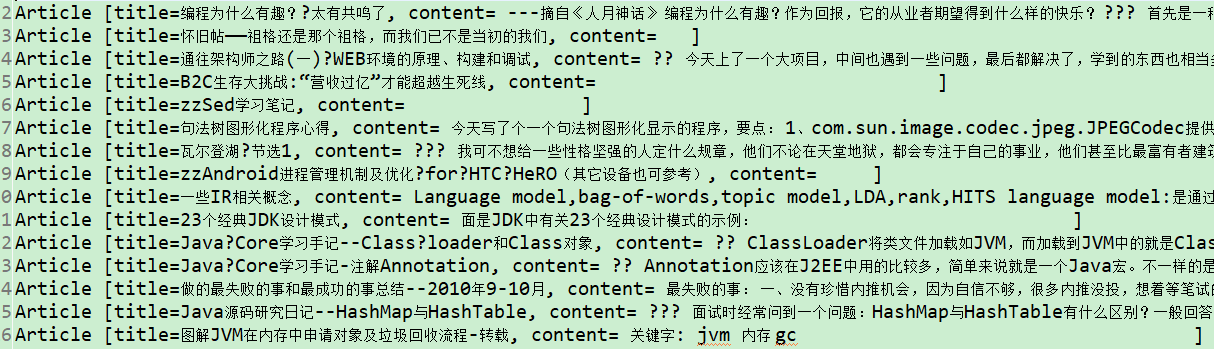

运行结果

爬取到的数据

总结:

关于简单的页面基本可以实现爬取,并且用对象进行存储数据,并最终保存为txt文档。

目前存在的问题,在于一些前端渲染的页面,还找不到url链接去完成相应的爬取,还需要进一步学习模拟登录页面,以获得隐藏的url等数据。

Java爬虫学习(3)之用对象保存新浪微博博文的更多相关文章

- Java爬虫一键爬取结果并保存为Excel

Java爬虫一键爬取结果并保存为Excel 将爬取结果保存为一个Excel表格 官方没有给出导出Excel 的教程 这里我就发一个导出为Excel的教程 导包 因为个人爱好 我喜欢用Gradle所以这 ...

- Java 爬虫学习

Java爬虫领域最强大的框架是JSoup:可直接解析具体的URL地址(即解析对应的HTML),提供了一套强大的API,包括可以通过DOM.CSS选择器,即类似jQuery方式来取出和操作数据.主要功能 ...

- 半途而废的Java爬虫学习经历

最近在面试,发现Java爬虫对于小数据量数据的爬取的应用还是比较广,抽空周末学习一手,留下学习笔记 Java网络爬虫 简单介绍 爬虫我相信大家都应该知道什么,有什么用,主要的用途就是通过程序自动的去获 ...

- 《java JDK7 学习笔记》之对象封装

1.构造函数实现对象初始化流程的封装.方法封装了操作对象的流程.java中还可以使用private封装对象私有数据成员.封装的目的主要就是隐藏对象细节,将对象当做黑箱子进行操作. 2.在java命名规 ...

- Java反射学习-5 - 反射复制对象

通过反射方式复制对象: package cn.tx.reflect; import java.lang.reflect.Constructor; import java.lang.reflect.Fi ...

- Java爬虫学习(2)之用对象保存文件demo(1)

package com.mieba.spider; import java.util.ArrayList; import java.util.List; import java.util.Vector ...

- java web学习总结(十) -------------------HttpServletRequest对象

一.HttpServletRequest介绍 HttpServletRequest对象代表客户端的请求,当客户端通过HTTP协议访问服务器时,HTTP请求头中的所有信息都封装在这个对象中,通过这个对象 ...

- java web学习总结(七) -------------------HttpServletResponse对象(一)

Web服务器收到客户端的http请求,会针对每一次请求,分别创建一个用于代表请求的request对象.和代表响应的response对象.request和response对象即然代表请求和响应,那我们要 ...

- java web 学习十(HttpServletRequest对象1)

一.HttpServletRequest介绍 HttpServletRequest对象代表客户端的请求,当客户端通过HTTP协议访问服务器时,HTTP请求头中的所有信息都封装在这个对象中,通过这个对象 ...

随机推荐

- Error: cannot fetch last explain plan from PLAN_TABLE

最近遇到了错误"Error: cannot fetch last explain plan from PLAN_TABLE",于是稍微研究了一下哪些场景下碰到这种错误,具体参考下面 ...

- openlayers编辑区域

<!DOCTYPE html> <html> <head> <meta charset="utf-8" /> <title&g ...

- lasso-ridge

线性回归 线性回归很简单,用线性函数拟合数据,用 mean square error (mse) 计算损失(cost),然后用梯度下降法找到一组使 mse 最小的权重. lasso 回归和岭回归(ri ...

- Verilog-case、casez和casex的区别

参考博客:https://www.cnblogs.com/guolongnv/articles/6906929.html 1.基本概念 1)?表示z,而不是“dont care” 2)区分: case ...

- jQuery---内容复习

内容复习 1. 操作样式 (5) 1.1 css操作 设置单个样式 设置多个样式 获取样式 css(name, value) :设置单个样式 css(obj):设置多个样式 css(name):获取样 ...

- double加减乘除

//四舍五入 public static double toDecimal(Double num){ if(Double.isNaN(num) || num == null){ return 0; } ...

- psp 周计划2

日期\时间 开始时间 结束时间 中断时间 净时间 活动 备注 12/3 9:00 11:30 10:30 120分钟 自习,练习 教室 14:00 16:30 15:30 80分钟 练习 中午休息 1 ...

- luogu P2158 [SDOI2008]仪仗队 (欧拉函数)

欧拉函数裸题 可惜我太久没做题忘了欧拉函数是什么了... 注意判断一下n = 1的情况就好了 #include <cstdio> using namespace std; ; typede ...

- caffe+win10+git使用sh文件

在windows下是否可以执行sh文件呢,搜了一下,可以安装了git就可以执行,当然这不是唯一答案. 然后联想到caffe下有一些.sh文件可以尝试,就用create_mnist.sh尝试把. cre ...

- dubbox生产者与消费者案例

一.首先要将dubbox添加到本地maven仓库 参考: https://blog.csdn.net/try_and_do/article/details/83383861 二.目录结 ...