Spark之UDF

package big.data.analyse.udfudaf

import org.apache.spark.sql.types.{IntegerType, StringType, StructField, StructType}

import org.apache.spark.sql.{Row, SparkSession}

/**

* Created by zhen on 2018/11/25.

*/

object SparkUdfUdaf {

def isAdult(age : Int) ={

if(age > 18){

true

}else{

false

}

}

def main(args: Array[String]) {

val spark = SparkSession

.builder()

.appName("UdfUdaf")

.master("local[2]")

.getOrCreate()

val userData = Array(

"2015,11,www.baidu.com",

"2016,14,www.google.com",

"2017,13,www.apache.com",

"2015,21,www.spark.com",

"2016,32,www.hadoop.com",

"2017,18,www.solr.com",

"2017,14,www.hive.com"

)

val sc = spark.sparkContext

val sqlContext = spark.sqlContext

val userDataRDD = sc.parallelize(userData) // 转化为RDD

val userDataType = userDataRDD.map(line => {

val Array(age, id, url) = line.split(",")

Row(

age, id.toInt, url

)

})

val structTypes = StructType(Array(

StructField("age", StringType, true),

StructField("id", IntegerType, true),

StructField("url", StringType, true)

))

// RDD转化为DataFrame

val userDataFrame = sqlContext.createDataFrame(userDataType,structTypes)

// 注冊临时表

userDataFrame.createOrReplaceTempView("udf")

// 注册udf(方式一)

spark.udf.register("getLength", (str : String) => str.length)

// 注册udf(方式二)

spark.udf.register("isAdult", isAdult _)

//执行sql

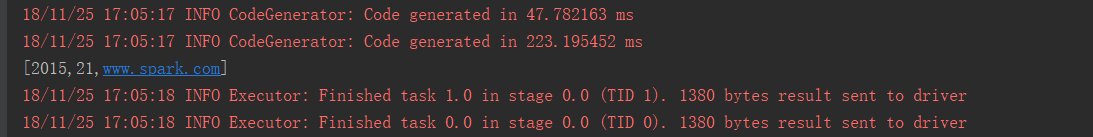

val sql = "select * from udf where getLength(udf.url)=13 and isAdult(udf.id)"

val result = sqlContext.sql(sql)

result.foreach(println(_))

}

}

结果:

Spark之UDF的更多相关文章

- Kafka:ZK+Kafka+Spark Streaming集群环境搭建(十五)Spark编写UDF、UDAF、Agg函数

Spark Sql提供了丰富的内置函数让开发者来使用,但实际开发业务场景可能很复杂,内置函数不能够满足业务需求,因此spark sql提供了可扩展的内置函数. UDF:是普通函数,输入一个或多个参数, ...

- 转】 Spark SQL UDF使用

原博文出自于: http://blog.csdn.net/oopsoom/article/details/39401391 感谢! Spark1.1推出了Uer Define Function功能,用 ...

- spark编写UDF和UDAF

UDF: 一.编写udf类,在其中定义udf函数 package spark._sql.UDF import org.apache.spark.sql.functions._ /** * AUTHOR ...

- Spark SQL UDF示例

UDF即用户自定函数,注册之后,在sql语句中使用. 基于scala-sdk-2.10.7,Spark2.0.0. package UDF_UDAF import java.util import o ...

- spark使用udf给dataFrame新增列

在 spark 中给 dataframe 增加一列的方法一般使用 withColumn // 新建一个dataFrame val sparkconf = new SparkConf() .setMas ...

- Spark注册UDF函数,用于DataFrame DSL or SQL

import org.apache.spark.sql.SparkSession import org.apache.spark.sql.functions._ object Test2 { def ...

- Pyspark 使用 Spark Udf 的一些经验

起初开始写一些 udf 的时候感觉有一些奇怪,在 spark 的计算中,一般通过转换(Transformation) 在不触发计算(Action) 的情况下就行一些预处理.udf 就是这样一个好用的东 ...

- Spark笔记之使用UDF(User Define Function)

一.UDF介绍 UDF(User Define Function),即用户自定义函数,Spark的官方文档中没有对UDF做过多介绍,猜想可能是认为比较简单吧. 几乎所有sql数据库的实现都为用户提供了 ...

- 王家林 大数据Spark超经典视频链接全集[转]

压缩过的大数据Spark蘑菇云行动前置课程视频百度云分享链接 链接:http://pan.baidu.com/s/1cFqjQu SCALA专辑 Scala深入浅出经典视频 链接:http://pan ...

随机推荐

- java发送http get请求的两种方式

长话短说,废话不说 一.第一种方式,通过HttpClient方式,代码如下: public static String httpGet(String url, String charset) thro ...

- Appcan开发笔记:导出Excel文件

Appcan IDE为4.0+; appcan提供了导出文件的方法 appcan.file.write 文件会自动创建,要解决的事情是Excel用字符串输出,可以考虑 csv(逗号间隔).HTML.X ...

- 用主题模型可视化分析911新闻(Python版)

本文由 伯乐在线 - 东狗 翻译,toolate 校稿.未经许可,禁止转载!英文出处:blog.dominodatalab.com.欢迎加入翻译小组. 本文介绍一个将911袭击及后续影响相关新闻文章的 ...

- Hibernate学习(六)———— cascade(级联)和inverse关系详解

序言 写这篇文章之前,自己也查了很多的资料来搞清楚这两者的关系和各自所做的事情,但是百度一搜,大多数博文感觉说的云里雾里,可能博主自己清楚是怎么一回事,但是给一个不懂的人或者一知半解的人看的话,别人也 ...

- SpringBoot快速引入第三方jar包

工作中,我们常会用到第三方jar包,而这些jar包往往在maven仓库是搜不到的,下面推荐一种简单.快速的引入第三方依赖的方法: 比如第三方jar包在lib文件夹下,对pom.xml的配置如下: &l ...

- Perl的IO操作(1):文件句柄

文件句柄 文件句柄用来对应要操作的文件系统中的文件,这么说不太严谨,但比较容易理解.首先为要打开的文件绑定文件句柄(称为打开文件句柄),然后在后续的操作中都通过文件句柄来操作对应的文件,最后关闭文件句 ...

- Go基础系列:defer、panic和recover

defer关键字 defer关键字可以让函数或语句延迟到函数语句块的最结尾时,即即将退出函数时执行,即便函数中途报错结束.即便已经panic().即便函数已经return了,也都会执行defer所推迟 ...

- C# 7.1中default关键字的新用法

default 关键字有两类用法 switch语句中指定默认标签 默认值表达式 switch 语句 int caseSwitch = 1; switch (caseSwitch) { case 1: ...

- [转]ERROR: http://rancherserver/v1 is not accessible

本文转自:http://securityer.lofter.com/post/1d0f3ee7_10c465cc 安装rancher agent时出现以下报错 [root@localhost ~]# ...

- [转]Angular4 数据请求 POST、GET

本文转自:https://blog.csdn.net/dailuwen/article/details/79375980 版权声明:本文为博主原创文章,未经博主允许不得转载. https://blog ...