fastdfs java客户端操作

https://github.com/happyfish100/fastdfs-client-java

到此处下载下来demo

这里采用maven的方式

mvn clean install

上传到本地仓库

mvn install:install-file -DgroupId=org.csource -DartifactId=fastdfs-client-java -Dversion=1.29-SNAPSHOT -Dpackaging=jar -Dfile=fastdfs-client-java-1.29-SNAPSHOT.jar

引入文件上传依赖

<dependency>

<groupId>commons-io</groupId>

<artifactId>commons-io</artifactId>

<version>2.4</version>

</dependency>

<dependency>

<groupId>org.csource</groupId>

<artifactId>fastdfs-client-java</artifactId>

<version>1.29-SNAPSHOT</version>

</dependency>

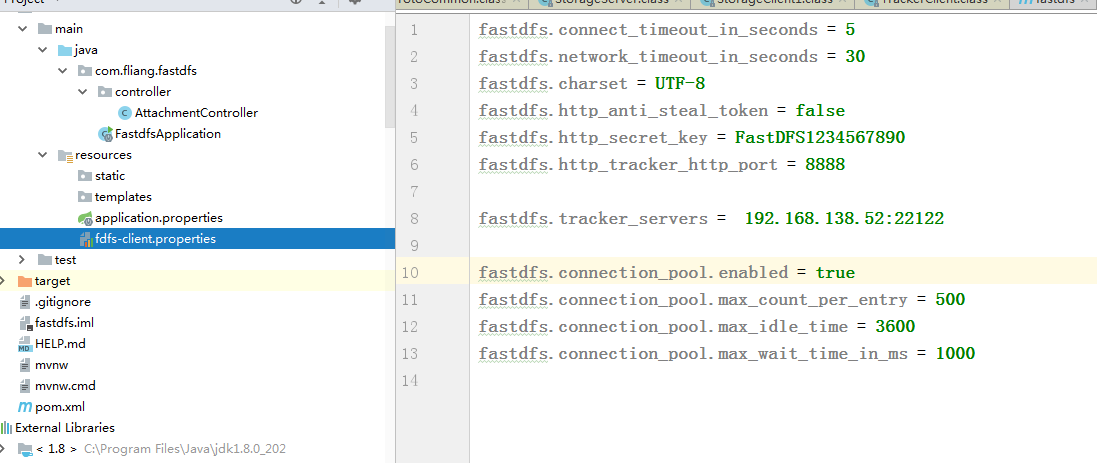

项目结构

代码如下:

@RestController

public class AttachmentController {

@RequestMapping("/upload")

public String fdfsUpload(@RequestParam MultipartFile file){

try {

ClientGlobal.initByProperties("fdfs-client.properties");

System.out.println("初始化信息:"+ClientGlobal.configInfo());

// 链接FastDFS服务器,创建tracker和Stroage

TrackerClient trackerClient = new TrackerClient();

TrackerServer trackerServer = trackerClient.getTrackerServer();

StorageServer storageServer = trackerClient.getStoreStorage(trackerServer);

StorageClient storageClient = new StorageClient(trackerServer,storageServer);

String tempFileName = file.getOriginalFilename();

String fileExtName = tempFileName.substring(tempFileName.lastIndexOf(".")+1);

//上传文件,只需要文件字节数组,第二个参数是文件扩展名,第三个参数是元数据

String[] strings = storageClient.upload_file(file.getBytes(), fileExtName, null);

String result="";

for (int i=0;i<strings.length;i++){

if(i==strings.length-1){

result+=strings[i];

}else{

result+=strings[i]+"/";

}

}

System.out.println(result);

} catch (Exception e) {

e.printStackTrace();

}

return null;

}

/**

* FastDFS实现文件下载

*

* @param filePath

*/

@RequestMapping(value = "/download", method = RequestMethod.GET)

@ResponseBody

public void fdfsDownload(String filePath) {

try {

ClientGlobal.initByProperties("fdfs-client.properties");

// 链接FastDFS服务器,创建tracker和Stroage

TrackerClient trackerClient = new TrackerClient();

TrackerServer trackerServer = trackerClient.getTrackerServer();

StorageServer storageServer = trackerClient.getStoreStorage(trackerServer);

StorageClient storageClient = new StorageClient(trackerServer,storageServer);

byte[] b = storageClient.download_file("group1", filePath);

if (b == null) {

throw new IOException("文件" + filePath + "不存在");

}

String fileName = filePath.substring(filePath.lastIndexOf("/") + 1);

FileOutputStream fileOutputStream = new FileOutputStream("E://" + fileName);

IOUtils.write(b, fileOutputStream);

fileOutputStream.close();

System.out.println("文件下载成功");

} catch (Exception e) {

e.printStackTrace();

}

}

/**

* FastDFS实现文件删除

*

* @param filePath

*/

@RequestMapping(value = "/delete", method = RequestMethod.GET)

@ResponseBody

public void fdfsDelete(String filePath) {

try {

ClientGlobal.initByProperties("fdfs-client.properties");

TrackerClient trackerClient = new TrackerClient();

TrackerServer trackerServer = trackerClient.getTrackerServer();

StorageServer storageServer = trackerClient.getStoreStorage(trackerServer);

StorageClient storageClient = new StorageClient(trackerServer,storageServer);

int deleteResult = storageClient.delete_file("group1", filePath);

if (deleteResult== 0) {

System.out.println("文件删除成功");

}else {

System.out.println("文件删除失败");

}

} catch (Exception e) {

e.printStackTrace();

}

}

}

亲测可用

fastdfs java客户端操作的更多相关文章

- Java 客户端操作 FastDFS 实现文件上传下载替换删除

FastDFS 的作者余庆先生已经为我们开发好了 Java 对应的 SDK.这里需要解释一下:作者余庆并没有及时更新最新的 Java SDK 至 Maven 中央仓库,目前中央仓库最新版仍旧是 1.2 ...

- HDFS的Java客户端操作代码(HDFS的查看、创建)

1.HDFS的put上传文件操作的java代码: package Hdfs; import java.io.FileInputStream; import java.io.FileNotFoundEx ...

- 使用Java客户端操作elasticsearch(二)

承接上文,使用Java客户端操作elasticsearch,本文主要介绍 常见的配置 和Sniffer(集群探测) 的使用. 常见的配置 前面已介绍过,RestClientBuilder支持同时提供一 ...

- Hive学习(三)Hive的Java客户端操作

Hive的Java客户端操作分为JDBC和Thrifit Client,首先启动Hive远程服务: hive --service hiveserver 一.JDBC 在MyEclipse中首先创建连接 ...

- 使用Java客户端操作elasticsearch

Java REST客户端有两种风格: Java低级别REST客户端(Java Low Level REST Client,以后都简称低级客户端算了,难得码字):Elasticsearch的官方low- ...

- Hadoop学习(2)-java客户端操作hdfs及secondarynode作用

首先要在windows下解压一个windows版本的hadoop 然后在配置他的环境变量,同时要把hadoop的share目录下的hadoop下的相关jar包拷贝到esclipe 然后Build Pa ...

- 关于FastDFS Java客户端源码中的一个不太明白的地方

下面代码是package org.csource.fastdfs下TrackerGroup.java文件中靠近结束的一段代码,我下载的这个源码的版本是1.24. /** * return connec ...

- FastDfs java客户端上传、删除文件

#配置文件 connect_timeout = 2 network_timeout = 30 charset = UTF-8 http.tracker_http_port = 9090 http.an ...

- HDFS的java客户端操作代码(Windows上面打jar包,提交至linux运行)

1.通过java.net.URL实现屏幕显示demo1文件的内容 package Hdfs; import java.io.InputStream; import java.net.URL; impo ...

- HDFS的Java客户端操作代码(HDFS删除文件或目录)

1.HDFS删除文件或目录 package Hdfs; import java.io.IOException; import java.net.URI; import org.apache.hadoo ...

随机推荐

- Nodejs后端自动化测试

偶然看到收藏一下 const puppeteer = require('puppeteer'); const fs = require('fs'); (async () => { const b ...

- statefulset详解及为何结合headless service部署有状态应用

1.1 有状态应用管理statefulset StatefulSet(有状态集,缩写为sts)常用于部署有状态的且需要有序启动的应用程序,比如在进行SpringCloud项目容器化时,Eureka的部 ...

- JavaScript 疑难记录(未解决)

异步迭代器与生成器的联系和区别

- composer 安装 laravel指定版本

composer 安装 laravel指定版本 $ composer create-project --prefer-dist laravel/laravel notelog '7.*'

- vscode安装教程(含插件配置)

1.下载 下载地址:Download Visual Studio Code VS code,全称Visual Studio Code,是Microsoft(微软)在2015年4月30日发布的,编写现代 ...

- 从 Newtonsoft.Json 迁移到 System.Text.Json

一.写在前面 System.Text.Json 是 .NET Core 3 及以上版本内置的 Json 序列化组件,刚推出的时候经常看到踩各种坑的吐槽,现在经过几个版本的迭代优化,提升了易用性,修复了 ...

- JuiceFS 在火山引擎边缘计算的应用实践

火山引擎边缘云是以云计算基础技术和边缘异构算力结合网络为基础,构建在边缘大规模基础设施之上的云计算服务,形成以边缘位置的计算.网络.存储.安全.智能为核心能力的新一代分布式云计算解决方案. 01- 边 ...

- 合肥光源储存环束流三维参数测量系统相关PV

合肥光源纵向震荡数据源相关PV 合肥光源纵向震荡数据源相关PV的增补 在上两文中公布了一些PV,依然有效. 本来发过了,那篇里的PV有些命名的不太好,比如PositionX.PositionY等,感觉 ...

- Windows QT程序配置删除网卡IP

1.Windows下可在CMD控制终端使用Dos命令对指定网卡进行IP配置,需要使用管理员权限打开CMD终端 往网卡添加IP主要有以下两种方法: 方法1: netsh interface ip add ...

- 【KAWAKO】从mac上定时将腾讯云的数据备份到本地

目录 前言 需求 宝塔面板 备份网站 备份数据库 mac端 创建工程文件夹 rua.py rua stdout plist Reference 前言 不信任一切云端平台,把数据牢牢握在自己手中才是最安 ...