.NET for Apache Spark 入门演练

.NET for Apache Spark 入门演练

微软官方文档: .NET for Apache Spark 入门 | Microsoft Learn

注意:由于本次在windows平台下进行演练,以下在未标注操作系统平台处,默认为windows。

1. 环境准备

推荐安装工具: visual studio 2019, 7-zip 或 bandzip 解压工具

1.1 安装.Net

推荐安装 visual studio 2019 作为编码IDE,同时它会自动安装 .net 开发环境。

在windows开发环境下,安装了visual studio 2019或者其它版本时已经安装了.net开发环境。故不做详细说明。

在命令行输入以下命令验证是否有.net环境:

dotnet --version

打印出版本信息,则进行下一步。

1.2 安装 Java

安装 java 8 , 安装完成后可使用如下命令进行测试

java , javac , java -version

打印出版本信息,则进行下一步。

1.3 安装 Apache Spark

本文使用 spark-3.0.1-bin-hadoop2.7.tgz。

官网下载地址:Downloads | Apache Spark

下载完成后,使用7-zip提取嵌套的 .tar文件,然后解压 .tar文件

取消7-zip界面的 "提取到" 勾选框

设置环境变量

# 这里的 C:\bin 替换为自己的安装目录

setx /M HADOOP_HOME C:\bin\spark-3.0.1-bin-hadoop2.7\

setx /M SPARK_HOME C:\bin\spark-3.0.1-bin-hadoop2.7\

setx /M PATH "%PATH%;%HADOOP_HOME%;%SPARK_HOME%bin"

环境变量设置成功后,**打开新的命令行 **运行以下命令

spark-submit --version

如果打印出版本信息,则安装成功,进行下一步。

1.4 安装.NET for Apache Spark

- 从 GitHub Releases · dotnet/spark (github.com) 下载。 这里下载 Microsoft.Spark.Worker.net461.win-x64-2.1.1.zip 版本,因为本文是基于 .NetFramework 演练。

- 使用7-zip提取嵌套的 .tar文件,然后解压 .tar文件

- 取消7-zip界面的 "提取到" 勾选框

1.5 安装 WinUtils(仅限 Windows)

.NET for Apache Spark 要求与 Apache Spark 一起安装 WinUtils。 下载 winutils.exe 。然后,将 WinUtils 复制到 C:\bin\spark-3.0.1-bin-hadoop2.7\bin。

设置环境变量

# 这里的 C:\bin 替换为自己的安装目录

setx /M DOTNET_WORKER_DIR C:bin\Microsoft.Spark.Worker-2.1.1

2 编写演练实例

在本地新建一个文本,输入如下内容

Hello World

This .NET app uses .NET for Apache Spark

This .NET app counts words with Apache Spark

打开 visual studio 2019,选择 .NetFramework,创建控制台程序。

引入 NuGet 包:Microsoft.Spark,默认最新版本2.1.1

在 Progarm.cs 文件中输入以下代码

var inputTxt = @"C:\Users\Administrator\Desktop\新建文本文档.txt";

SparkSession spark = SparkSession

.Builder()

.AppName("word_count_sample")

.GetOrCreate();

// Create initial DataFrame

DataFrame dataFrame = spark.Read().Text(inputTxt);

// Count words

DataFrame words = dataFrame

.Select(Functions.Split(Functions.Col("value"), " ").Alias("words"))

.Select(Functions.Explode(Functions.Col("words"))

.Alias("word"))

.GroupBy("word")

.Count()

.OrderBy(Functions.Col("count").Desc());

// Show results

words.Show();

// Stop Spark session

spark.Stop();

编译输出。

执行。输入如下命令运行

spark-submit --class org.apache.spark.deploy.dotnet.DotnetRunner --master local microsoft-spark-3-0_2.12-2.1.1.jar ConsoleApp1.exe

- spark-submit 提交给spark执行

- --calss 执行程序

- --master 本地还是远程仓库,选local, 然后 指定 microsoft-spark 版本,然后 指定用户程序

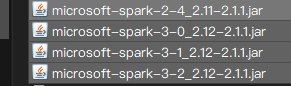

这里有个注意的地方,NuGet下载下来的包,在编译输出目录下会有4个jar包

- microsoft-spark-2-4_2.11-2.1.1.jar

- microsoft-spark-3-0_2.12-2.1.1.jar

- microsoft-spark-3-1_2.12-2.1.1.jar

- microsoft-spark-3-2_2.12-2.1.1.jar

这里选择第二个 microsoft-spark-3-0_2.12-2.1.1.jar,只有这个能运行成功 。其它3个应该是 .netcore平台下的,

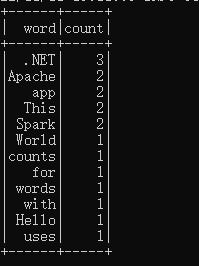

执行结果如下:

说明第一次演练成功!

.NET for Apache Spark 入门演练的更多相关文章

- [翻译]Apache Spark入门简介

原文地址:http://blog.jobbole.com/?p=89446 我是在2013年底第一次听说Spark,当时我对Scala很感兴趣,而Spark就是使用Scala编写的.一段时间之后,我做 ...

- Apache Spark大数据分析入门(一)

摘要:Apache Spark的出现让普通人也具备了大数据及实时数据分析能力.鉴于此,本文通过动手实战操作演示带领大家快速地入门学习Spark.本文是Apache Spark入门系列教程(共四部分)的 ...

- 新手福利:Apache Spark入门攻略

[编者按]时至今日,Spark已成为大数据领域最火的一个开源项目,具备高性能.易于使用等特性.然而作为一个年轻的开源项目,其使用上存在的挑战亦不可为不大,这里为大家分享SciSpike软件架构师Ash ...

- Apache Spark 2.2.0 中文文档 - 快速入门 | ApacheCN

快速入门 使用 Spark Shell 进行交互式分析 基础 Dataset 上的更多操作 缓存 独立的应用 快速跳转 本教程提供了如何使用 Spark 的快速入门介绍.首先通过运行 Spark 交互 ...

- Spark 入门

Spark 入门 目录 一. 1. 2. 3. 二. 三. 1. 2. 3. (1) (2) (3) 4. 5. 四. 1. 2. 3. 4. 5. 五. Spark Shell使用 ...

- Spark入门实战系列--10.分布式内存文件系统Tachyon介绍及安装部署

[注]该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取 .Tachyon介绍 1.1 Tachyon简介 随着实时计算的需求日益增多,分布式内存计算 ...

- 使用scala开发spark入门总结

使用scala开发spark入门总结 一.spark简单介绍 关于spark的介绍网上有很多,可以自行百度和google,这里只做简单介绍.推荐简单介绍连接:http://blog.jobbole.c ...

- Spark入门实战系列--1.Spark及其生态圈简介

[注]该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取 .简介 1.1 Spark简介 年6月进入Apache成为孵化项目,8个月后成为Apache ...

- Spark入门实战系列--2.Spark编译与部署(中)--Hadoop编译安装

[注]该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取 .编译Hadooop 1.1 搭建环境 1.1.1 安装并设置maven 1. 下载mave ...

- Spark入门实战系列--2.Spark编译与部署(下)--Spark编译安装

[注]该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取 .编译Spark .时间不一样,SBT是白天编译,Maven是深夜进行的,获取依赖包速度不同 ...

随机推荐

- Linux命令行与shell脚本编程(1)--读书笔记

这里记录下个人读书笔记,持续更新中(作者小白,大佬轻喷... chap7 理解Linux文件权限 7.1 Linux安全性 Linux系统的每个用户账户都有唯一的用户ID,即UID,用户权限根据UID ...

- 【必知必会的MySQL知识】⑤DQL语言

目录 一.前言 二.基础查询 2.1 语法 2.2 实践操作 三.条件查询 3.1 语法 3.2 where 语句操作符 3.3 实践操作 四.排序查询 4.1 语法格式 4.2 实践操作 五.分组查 ...

- 2022-10-20:以下go语言代码输出什么?A:7;B:7.0;C:0;D:编译错误。 package main import ( “fmt“ ) func main() { const

2022-10-20:以下go语言代码输出什么?A:7:B:7.0:C:0:D:编译错误. package main import ( "fmt" ) func main() { ...

- 2021-05-03:给定一个非负整数num, 如何不用循环语句, 返回>=num,并且离num最近的,2的某次方 。

2021-05-03:给定一个非负整数num, 如何不用循环语句, 返回>=num,并且离num最近的,2的某次方 . 福大大 答案2021-05-03: 32位整数,N=32. 1.非负整数用 ...

- 2021-07-12:缺失的第一个正数。给你一个未排序的整数数组 nums ,请你找出其中没有出现的最小的正整数。请你实现时间复杂度为 O(n) 并且只使用常数级别额外空间的解决方案。比如[3,4,5

2021-07-12:缺失的第一个正数.给你一个未排序的整数数组 nums ,请你找出其中没有出现的最小的正整数.请你实现时间复杂度为 O(n) 并且只使用常数级别额外空间的解决方案.比如[3,4,5 ...

- 2021-09-08:每一个项目都有三个数,[a,b,c]表示这个项目a和b乐队参演,花费为c。每一个乐队可能在多个项目里都出现了,但是只能被挑一次。nums是可以挑选的项目数量,所以一定会有nums

2021-09-08:每一个项目都有三个数,[a,b,c]表示这个项目a和b乐队参演,花费为c.每一个乐队可能在多个项目里都出现了,但是只能被挑一次.nums是可以挑选的项目数量,所以一定会有nums ...

- pycharm-professional-2023 下载安装

PyCharm Professional 是一款针对 Python 编程的集成开发环境 (IDE),由 JetBrains 公司开发和维护.它是 PyCharm 社区版的升级版,提供了更多的功能和工具 ...

- 1451, 'Cannot delete or update a parent row: a foreign key constraint fails

问题描述:1451, 'Cannot delete or update a parent row: a foreign key constraint fails (`sysProDB4`.`IM003 ...

- Row size too large. The maximum row size for the used table type, not counting BLOBs, is 65535.

问题描述 新建表或者修改表varchar字段长度的时候,出现这个错误 Row size too large. The maximum row size for the used table type, ...

- 2019年蓝桥杯C/C++大学B组省赛真题(迷宫)

题目描述: 下图给出了一个迷宫的平面图,其中标记为1 的为障碍,标记为0 的为可 以通行的地方. 010000 000100 001001 110000 迷宫的入口为左上角,出口为右下角,在迷宫中,只 ...