Spark入门(六)--Spark的combineByKey、sortBykey

spark的combineByKey

combineByKey的特点

combineByKey的强大之处,在于提供了三个函数操作来操作一个函数。第一个函数,是对元数据处理,从而获得一个键值对。第二个函数,是对键值键值对进行一对一的操作,即一个键值对对应一个输出,且这里是根据key进行整合。第三个函数是对key相同的键值对进行操作,有点像reduceByKey,但真正实现又有着很大的不同。

在Spark入门(五)--Spark的reduce和reduceByKey中,我们用reduce进行求平均值。用combineByKey我们则可以求比平均值更为丰富的事情。现在有一个数据集,每一行数据包括一个a-z字母和一个整数,其中字母和整数之间以空格分隔。现在要求得每个字母的平均数。这个场景有点像多个学生,每个学生多门成绩,求得学生的平均分。但这里将问题简化,其中数据集放在grades中。数据集以及下面的代码都可以在github上下载。

combineByKey求多个平均值

scala实现

import org.apache.spark.{SparkConf, SparkContext}

import org.apache.spark.{SparkConf, SparkContext}

object SparkCombineByKey {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setMaster("local").setAppName("SparkCombineByKey")

val sc = new SparkContext(conf)

sc.textFile("./grades").map(line=>{

val splits = line.split(" ")

(splits(0),splits(1).toInt)

}).combineByKey(

value => (value,1),

(x:(Int,Int),y)=>(x._1+y,x._2+1),

(x:(Int,Int),y:(Int,Int))=>(x._1+y._1,x._2+y._2)

).map(x=>(x._1,x._2._1/x._2._2)).foreach(println)

}

}

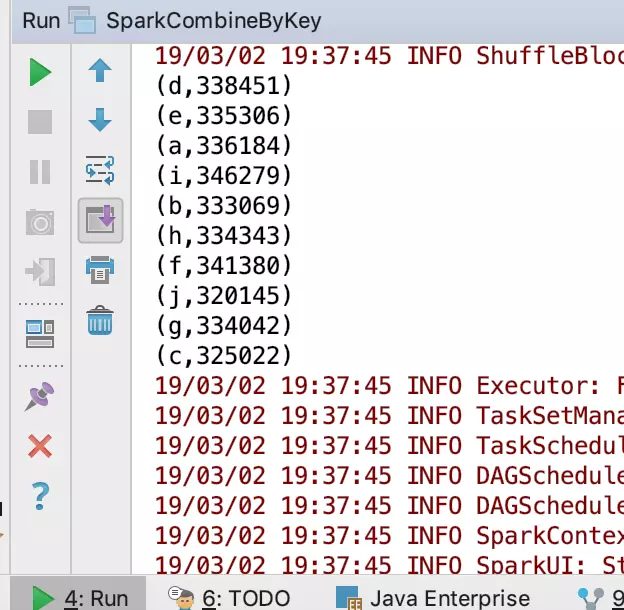

scala运行结果

(d,338451)

(e,335306)

(a,336184)

(i,346279)

(b,333069)

(h,334343)

(f,341380)

(j,320145)

(g,334042)

(c,325022)

java实现:

import org.apache.spark.SparkConf;

import org.apache.spark.api.java.JavaPairRDD;

import org.apache.spark.api.java.JavaSparkContext;

import org.apache.spark.api.java.function.Function;

import org.apache.spark.api.java.function.Function2;

import org.apache.spark.api.java.function.PairFunction;

import org.apache.spark.api.java.function.VoidFunction;

import org.apache.spark.sql.sources.In;

import scala.Tuple2;

public class SparkCombineByKeyJava {

public static void main(String[] args){

SparkConf conf = new SparkConf().setMaster("local").setAppName("SparkCombineByKeyJava");

JavaSparkContext sc = new JavaSparkContext(conf);

combineByKeyJava(sc);

combineByKeyJava8(sc);

}

public static void combineByKeyJava(JavaSparkContext sc){

JavaPairRDD<String,Integer> splitData = sc.textFile("./grades").mapToPair(new PairFunction<String, String, Integer>() {

@Override

public Tuple2<String, Integer> call(String s) throws Exception {

String[] splits = s.split(" ");

return new Tuple2<>(splits[0],Integer.parseInt(splits[1]));

}

});

splitData.combineByKey(new Function<Integer, Tuple2<Integer, Integer>>() {

@Override

public Tuple2<Integer, Integer> call(Integer integer) throws Exception {

return new Tuple2<>(integer, 1);

}

}, new Function2<Tuple2<Integer, Integer>, Integer, Tuple2<Integer, Integer>>() {

@Override

public Tuple2<Integer, Integer> call(Tuple2<Integer, Integer> integerIntegerTuple2, Integer integer) throws Exception {

return new Tuple2<>(integerIntegerTuple2._1 + integer, integerIntegerTuple2._2 + 1);

}

}, new Function2<Tuple2<Integer, Integer>, Tuple2<Integer, Integer>, Tuple2<Integer, Integer>>() {

@Override

public Tuple2<Integer, Integer> call(Tuple2<Integer, Integer> integerIntegerTuple2, Tuple2<Integer, Integer> integerIntegerTuple22) throws Exception {

return new Tuple2<>(integerIntegerTuple2._1+integerIntegerTuple22._1,integerIntegerTuple2._2+integerIntegerTuple22._2);

}

}).map(new Function<Tuple2<String,Tuple2<Integer,Integer>>, Tuple2<String,Double>>() {

@Override

public Tuple2<String,Double> call(Tuple2<String, Tuple2<Integer, Integer>> stringTuple2Tuple2) throws Exception {

return new Tuple2<>(stringTuple2Tuple2._1,stringTuple2Tuple2._2._1*1.0/stringTuple2Tuple2._2._2);

}

}).foreach(new VoidFunction<Tuple2<String, Double>>() {

@Override

public void call(Tuple2<String, Double> stringDoubleTuple2) throws Exception {

System.out.println(stringDoubleTuple2._1+" "+stringDoubleTuple2._2);

}

});

}

public static void combineByKeyJava8(JavaSparkContext sc){

JavaPairRDD<String,Integer> splitData = sc.textFile("./grades").mapToPair(line -> {

String[] splits = line.split(" ");

return new Tuple2<>(splits[0],Integer.parseInt(splits[1]));

});

splitData.combineByKey(

x->new Tuple2<>(x,1),

(x,y)->new Tuple2<>(x._1+y,x._2+1),

(x,y)->new Tuple2<>(x._1+y._1,x._2+y._2)

).map(x->new Tuple2(x._1,x._2._1*1.0/x._2._2)).foreach(x->System.out.println(x._1+" "+x._2));

}

}

java运行结果

d 338451.6

e 335306.7480769231

a 336184.95321637427

i 346279.497029703

b 333069.8589473684

h 334343.75

f 341380.94444444444

j 320145.7618069815

g 334042.37605042016

c 325022.4183673469

分析

在开始python之前,我们先观察java和scala两个程序。我们发现java7的代码非常冗余,而java8和scala则相比起来非常干净利落。当然,我们难说好坏,但是这也表现出当代语言开始从繁就简的一个转变。到了python这一特点就体现的更加淋漓尽致。

但我们不光说语言,我们分析这个求平均的实现方式,由于java中对数值做了一个处理,因此有保留小数,而scala则没有,但至少可以判断两者的结果是一致的。当然,这不是重点,重点是,这个combinByKey非常复杂,有三个函数。我们很难观察到每个过程做了什么。因此我们在这里,对scala程序进行进一步的输出,从而观察combineByKey到底做了什么。

scala修改

import org.apache.spark.{SparkConf, SparkContext}

object SparkCombineByKey {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setMaster("local").setAppName("SparkCombineByKey")

val sc = new SparkContext(conf)

sc.textFile("./grades").map(line=>{

val splits = line.split(" ")

(splits(0),splits(1).toInt)

}).combineByKey(

value => {

println("这是第一个函数")

println("将所有的值遍历,并放在元组中,标记1")

println(value)

(value,1)

},

(x:(Int,Int),y)=>{

println("这是第二个函数")

println("将x中的第一个值进行累加求和,第二个值加一,求得元素总个数")

println("x:"+x.toString())

println("y:"+y)

(x._1+y,x._2+1)

},

(x:(Int,Int),y:(Int,Int))=>{

(x._1+y._1,x._2+y._2)

}

).map(x=>(x._1,x._2._1/x._2._2)).foreach(println)

}

}

得到结果

这是第一个函数

将所有的值遍历,并放在元组中,标记1

222783

这是第一个函数

将所有的值遍历,并放在元组中,标记1

48364

这是第一个函数

将所有的值遍历,并放在元组中,标记1

204950

这是第一个函数

将所有的值遍历,并放在元组中,标记1

261777

...

...

...

这是第二个函数

将x中的第一个值进行累加求和,第二个值加一,求得元素总个数

x:(554875,2)

y:357748

这是第二个函数

将x中的第一个值进行累加求和,第二个值加一,求得元素总个数

x:(912623,3)

y:202407

这是第一个函数

将所有的值遍历,并放在元组中,标记1

48608

这是第二个函数

将x中的第一个值进行累加求和,第二个值加一,求得元素总个数

x:(1115030,4)

y:69003

这是第一个函数

将所有的值遍历,并放在元组中,标记1

476893

...

...

...

(d,338451)

(e,335306)

(a,336184)

(i,346279)

(b,333069)

(h,334343)

(f,341380)

(j,320145)

(g,334042)

(c,325022)

这里我们发现了,函数的顺序并不先全部执行完第一个函数,再执行第二个函数。而是分区并行,即第一个分区执行完第一个函数,并不等待其他分区执行完第一个函数,而是紧接着执行第二个函数,最后在第三个函数进行处理。在本地单机下,该并行特点并不能充分发挥,但在集群环境中,各个分区在不同节点计算,然后处理完结果汇总处理。这样,当数据量十分庞大时,集群节点数越多,该优势就表现地越明显。

此外还有一个非常值得关注的特点,当我们把foreach(println)这句话去掉时

foreach(println)

我们运行程序,发现程序没有任何输出。这是由于spark的懒加载特点,spark只用在对数据执行具体操作时,如输出、保存等才会执行计算。这看起来有点不合理,但实际上这样做在很多场景下能大幅度提升效率,但如果没有处理好,可能会导致spark每次执行操作都会从头开始计算该过程。因此当一个操作结果需要被频繁或者多次调用的时候,我们应该将结果存下来。

python实现

from pyspark import SparkConf,SparkContext

conf = SparkConf().setMaster("local").setAppName("SparkCombineByKey")

sc = SparkContext(conf=conf)

sc.textFile("./grades")\

.map(lambda line : (line.split(" ")[0],int(line.split(" ")[1])))\

.combineByKey(

lambda num:(num,1),lambda x,y:(x[0]+y,x[1]+1),lambda x,y:(x[0]+y[0],x[1]+y[1])

).map(lambda x:(x[0],x[1][0]/x[1][1])).foreach(print)

得到结果

('b', 333069.8589473684)

('f', 341380.94444444444)

('j', 320145.7618069815)

('h', 334343.75)

('a', 336184.95321637427)

('g', 334042.37605042016)

('d', 338451.6)

('e', 335306.7480769231)

('c', 325022.4183673469)

spark的sortByKey

sortByKey进行排序

sortByKey非常简单,也非常常用。这里依然采用上述文本,将处理后的结果,进行排序,得到平均值最大的字母。在实际运用中我们这里可以看成求得按照成绩排序,或者按照姓名排序。

scala实现

import org.apache.spark.{SparkConf, SparkContext}

object SparkSortByKey {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setMaster("local").setAppName("SparkCombineByKey")

val sc = new SparkContext(conf)

val result = sc.textFile("./grades").map(line=>{

val splits = line.split(" ")

(splits(0),splits(1).toInt)

}).combineByKey(value =>(value,1),(x:(Int,Int),y)=>(x._1+y,x._2+1),(x:(Int,Int),y:(Int,Int))=>(x._1+y._1,x._2+y._2)

).map(x=>(x._1,x._2._1/x._2._2))

//按照名字排序,顺序

result.sortByKey(true).foreach(println)

//按照名字排序,倒序

result.sortByKey(false).foreach(println)

val result1 = sc.textFile("./grades").map(line=>{

val splits = line.split(" ")

(splits(0),splits(1).toInt)

}).combineByKey(value =>(value,1),(x:(Int,Int),y)=>(x._1+y,x._2+1),(x:(Int,Int),y:(Int,Int))=>(x._1+y._1,x._2+y._2)

).map(x=>(x._2._1/x._2._2,x._1))

//按照成绩排序,顺序

result1.sortByKey(true).foreach(println)

//按照成绩排序,倒序

result1.sortByKey(false).foreach(println)

}

}

python实现

from pyspark import SparkConf,SparkContext

conf = SparkConf().setMaster("local").setAppName("SparkCombineByKey")

sc = SparkContext(conf=conf)

result = sc.textFile("./grades")\

.map(lambda line : (line.split(" ")[0],int(line.split(" ")[1])))\

.combineByKey(

lambda num:(num,1),lambda x,y:(x[0]+y,x[1]+1),lambda x,y:(x[0]+y[0],x[1]+y[1])

).map(lambda x:(x[0],x[1][0]/x[1][1]))

result.sortByKey(True).foreach(print)

result.sortByKey(False).foreach(print)

result1 = sc.textFile("./grades")\

.map(lambda line : (line.split(" ")[0],int(line.split(" ")[1])))\

.combineByKey(

lambda num:(num,1),lambda x,y:(x[0]+y,x[1]+1),lambda x,y:(x[0]+y[0],x[1]+y[1])

).map(lambda x:(x[1][0]/x[1][1],x[0]))

result1.sortByKey(True).foreach(print)

result1.sortByKey(False).foreach(print)

得到结果

(a,336184)

(b,333069)

(c,325022)

(d,338451)

(e,335306)

(f,341380)

(g,334042)

(h,334343)

(i,346279)

(j,320145)

(j,320145)

(i,346279)

(h,334343)

(g,334042)

(f,341380)

(e,335306)

(d,338451)

(c,325022)

(b,333069)

(a,336184)

(320145,j)

(325022,c)

(333069,b)

(334042,g)

(334343,h)

(335306,e)

(336184,a)

(338451,d)

(341380,f)

(346279,i)

(346279,i)

(341380,f)

(338451,d)

(336184,a)

(335306,e)

(334343,h)

(334042,g)

(333069,b)

(325022,c)

(320145,j)

数据集以及代码都可以在github上下载。

转自:https://juejin.im/post/5c7a58426fb9a049a42fc190

Spark入门(六)--Spark的combineByKey、sortBykey的更多相关文章

- 一、spark入门之spark shell:wordcount

1.安装完spark,进入spark中bin目录: bin/spark-shell scala> val textFile = sc.textFile("/Users/admin/ ...

- 二、spark入门之spark shell:文本中发现5个最常用的word

scala> val textFile = sc.textFile("/Users/admin/spark-1.5.1-bin-hadoop2.4/README.md") s ...

- Spark入门:Spark运行架构(Python版)

此文为个人学习笔记如需系统学习请访问http://dblab.xmu.edu.cn/blog/1709-2/ 基本概念 * RDD:是弹性分布式数据集(Resilient Distributed ...

- spark 入门学习 核心api

spark入门教程(3)--Spark 核心API开发 原创 2016年04月13日 20:52:28 标签: spark / 分布式 / 大数据 / 教程 / 应用 4999 本教程源于2016年3 ...

- Spark入门(七)--Spark的intersection、subtract、union和distinc

Spark的intersection intersection顾名思义,他是指交叉的.当两个RDD进行intersection后,将保留两者共有的.因此对于RDD1.intersection(RDD2 ...

- Spark 入门

Spark 入门 目录 一. 1. 2. 3. 二. 三. 1. 2. 3. (1) (2) (3) 4. 5. 四. 1. 2. 3. 4. 5. 五. Spark Shell使用 ...

- 【核心API开发】Spark入门教程[3]

本教程源于2016年3月出版书籍<Spark原理.机制及应用> ,在此以知识共享为初衷公开部分内容,如有兴趣,请支持正版书籍. Spark综合了前人分布式数据处理架构和语言的优缺点,使用简 ...

- 使用scala开发spark入门总结

使用scala开发spark入门总结 一.spark简单介绍 关于spark的介绍网上有很多,可以自行百度和google,这里只做简单介绍.推荐简单介绍连接:http://blog.jobbole.c ...

- Spark入门实战系列--2.Spark编译与部署(上)--基础环境搭建

[注] 1.该系列文章以及使用到安装包/测试数据 可以在<倾情大奉送--Spark入门实战系列>获取: 2.Spark编译与部署将以CentOS 64位操作系统为基础,主要是考虑到实际应用 ...

随机推荐

- Python: Socket网络编程,多线程处理小Demo

一个简单的例子,深入研究一下socket的多线程处理任务 Server端: #!/usr/bin/env python #encoding:utf8 # # 注意:定义encoding时必须在第二行 ...

- Nginx笔记总结十五:nginx+keepalive+proxy_cache配置高可用nginx集群和高速缓存

nginx编译 wget http://labs.frickle.com/files/ngx_cache_purge-2.3.tar.gz ./configure --prefix=/usr/loca ...

- POJ 2728 二分+最小生成树

题意:给n个点,可以将每个点的x,y的欧几里得距离(就是坐标系里两点距离公式)看作距离,z的差值即为费用差,求的是所有最小生成树中的min(边费用和/边距离和). 思路:其实挑战P143有类似的列题, ...

- docker 使用:镜像和容器

docker 镜像 docker image是一个极度精简版的Linux程序运行环境,官网的java镜像包括的东西更少,除非是镜像叠加方式的如centos+java7,需要定制化build的一个安装包 ...

- mac 下openOffice服务的安装

1.安装准备 安装 Homebrew 及 Homebrew-Cask Homebrew 是一个Mac上的包管理工具.使用Homebrew可以很轻松的安装缺少的依赖. Homebrew-Cask是建立在 ...

- 多线程的lock功能

import threading def job1(): global A, lock lock.acquire() for i in range(10): A += 1 print('job1', ...

- 递归、尾递归和使用Stream延迟计算优化尾递归

我们在学数据结构的时候必然会接触栈(Stack),而栈有一个重要的应用是在程序设计语言中实现递归.递归用途十分广泛,比如我们常见的阶乘,如下代码: 1234 public static int (in ...

- Snap们崛起告诉我们:这个世界太需要悄悄话

北京时间3月3日凌晨,"阅后即焚"应用Snapchat母公司Snap在纽约证券交易所上市.开盘价24美元,比其初定的17美元IPO价格高出近41.2%,按照24美元的股价计算, ...

- JSON parse error: Cannot deserialize value of type `java.util.Date` from String

DateTimePicker + @DateTimeFormat("yyyy-MM-dd HH:mm:ss")日期格式转换异常 最近在做的一个项目使用的日期格式是yyyy-MM-d ...

- bp(net core)+easyui+efcore实现仓储管理系统——入库管理之二(三十八)

abp(net core)+easyui+efcore实现仓储管理系统目录 abp(net core)+easyui+efcore实现仓储管理系统——ABP总体介绍(一) abp(net core)+ ...