Tensor:Pytorch神经网络界的Numpy

摘要:Tensor,它可以是0维、一维以及多维的数组,你可以将它看作为神经网络界的Numpy,它与Numpy相似,二者可以共享内存,且之间的转换非常方便。

本文分享自华为云社区《Tensor:Pytorch神经网络界的Numpy》,作者: 择城终老 。

Tensor

Tensor,它可以是0维、一维以及多维的数组,你可以将它看作为神经网络界的Numpy,它与Numpy相似,二者可以共享内存,且之间的转换非常方便。

但它们也不相同,最大的区别就是Numpy会把ndarray放在CPU中进行加速运算,而由Torch产生的Tensor会放在GPU中进行加速运算。

对于Tensor,从接口划分,我们大致可分为2类:

- torch.function:如torch.sum、torch.add等。

- tensor.function:如tensor.view、tensor.add等。

而从是否修改自身来划分,会分为如下2类:

- 不修改自身数据,如x.add(y),x的数据不变,返回一个新的Tensor。

- 修改自身数据,如x.add_(y),运算结果存在x中,x被修改。

简单的理解就是方法名带不带下划线的问题。

现在,我们来实现2个数组对应位置相加,看看其效果就近如何:

import torch x = torch.tensor([1, 2])

y = torch.tensor([3, 4])

print(x + y)

print(x.add(y))

print(x)

print(x.add_(y))

print(x)

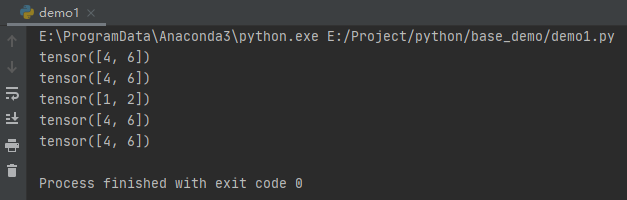

运行之后,效果如下:

下面,我们来正式讲解Tensor的使用方式。

创建Tensor

与Numpy一样,创建Tensor也有很多的方法,可以自身的函数进行生成,也可以通过列表或者ndarray进行转换,同样也可以指定维度等。具体方法如下表(数组即张量):

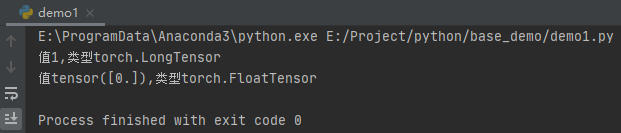

这里需要注意Tensor有大写的方法也有小写的方法,具体效果我们先来看看代码:

import torch t1 = torch.tensor(1)

t2 = torch.Tensor(1)

print("值{0},类型{1}".format(t1, t1.type()))

print("值{0},类型{1}".format(t2, t2.type()))

运行之后,效果如下:

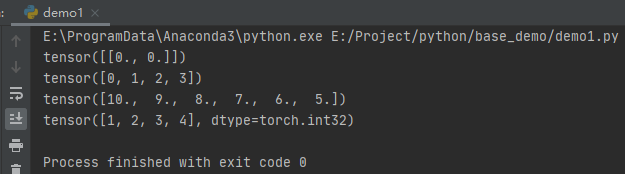

其他示例如下:

import torch

import numpy as np t1 = torch.zeros(1, 2)

print(t1)

t2 = torch.arange(4)

print(t2)

t3 = torch.linspace(10, 5, 6)

print(t3)

nd = np.array([1, 2, 3, 4])

t4 = torch.from_numpy(nd)

print(t4)

其他例子基本与上面基本差不多,这里不在赘述。

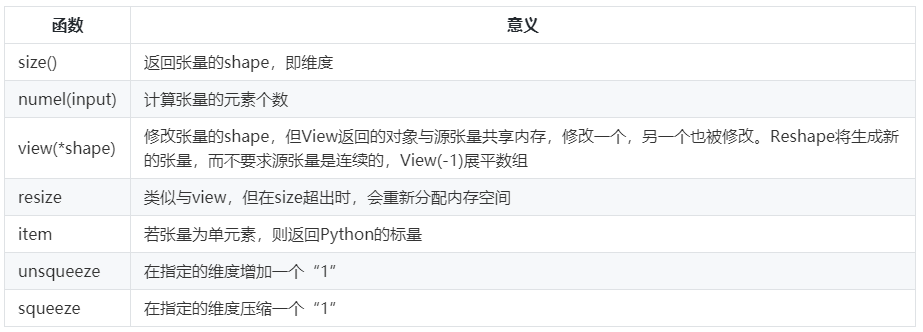

修改Tensor维度

同样的与Numpy一样,Tensor一样有维度的修改函数,具体的方法如下表所示:

示例代码如下所示:

import torch t1 = torch.Tensor([[1, 2]])

print(t1)

print(t1.size())

print(t1.dim())

print(t1.view(2, 1))

print(t1.view(-1))

print(torch.unsqueeze(t1, 0))

print(t1.numel())

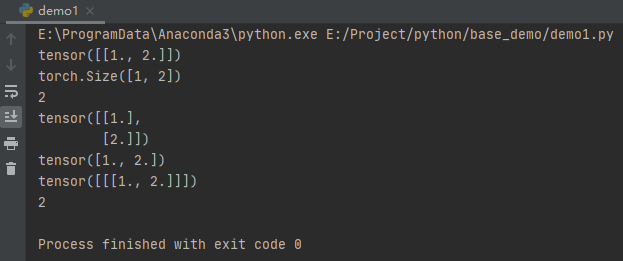

运行之后,效果如下:

截取元素

当然,我们创建Tensor张量,是为了使用里面的数据,那么就不可避免的需要获取数据进行处理,具体截取元素的方式如表:

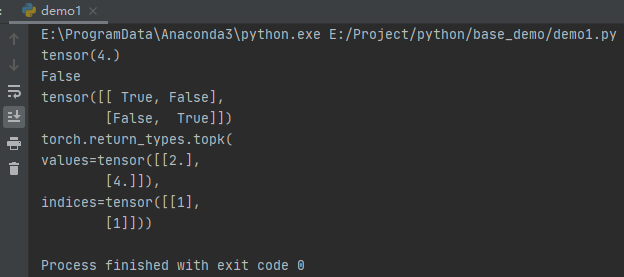

示例代码如下所示:

import torch # 设置随机数种子,保证每次运行结果一致

torch.manual_seed(100)

t1 = torch.randn(2, 3)

# 打印t1

print(t1)

# 输出第0行数据

print(t1[0, :])

# 输出t1大于0的数据

print(torch.masked_select(t1, t1 > 0))

# 输出t1大于0的数据索引

print(torch.nonzero(t1))

# 获取第一列第一个值,第二列第二个值,第三列第二个值为第1行的值

# 获取第二列的第二个值,第二列第二个值,第三列第二个值为第2行的值

index = torch.LongTensor([[0, 1, 1], [1, 1, 1]])

# 取0表示以行为索引

a = torch.gather(t1, 0, index)

print(a)

# 反操作填0

z = torch.zeros(2, 3)

print(z.scatter_(1, index, a))

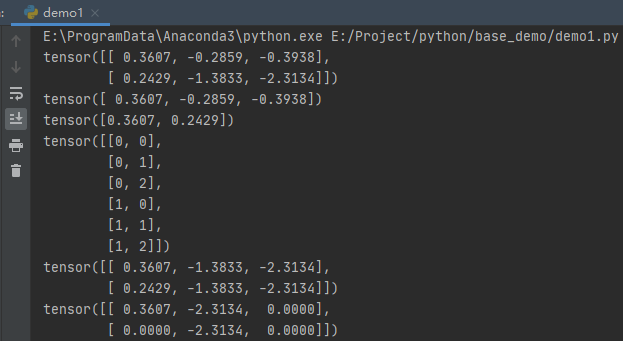

运行之后,效果如下:

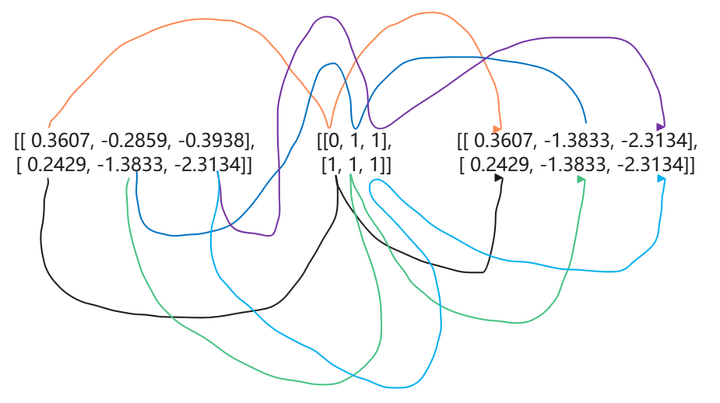

我们a = torch.gather(t1, 0, index)对其做了一个图解,方便大家理解。如下图所示:

当然,我们直接有公司计算,因为这么多数据标线实在不好看,这里博主列出转换公司供大家参考:

当dim=0时,out[i,j]=input[index[i,j]][j]

当dim=1时,out[i,j]=input[i][index[i][j]]

简单的数学运算

与Numpy一样,Tensor也支持数学运算。这里,博主列出了常用的数学运算函数,方便大家参考:

需要注意的是,上面表格所有的函数操作均会创建新的Tensor,如果不需要创建新的,使用这些函数的下划线"_"版本。

示例如下:

t = torch.Tensor([[1, 2]])

t1 = torch.Tensor([[3], [4]])

t2 = torch.Tensor([5, 6])

# t+0.1*(t1/t2)

print(torch.addcdiv(t, 0.1, t1, t2))

# t+0.1*(t1*t2)

print(torch.addcmul(t, 0.1, t1, t2))

print(torch.pow(t,3))

print(torch.neg(t))

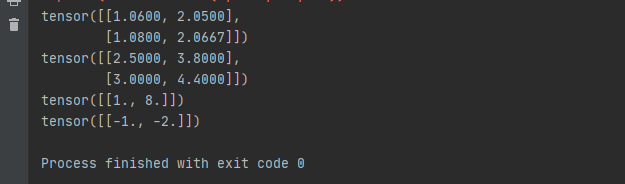

运行之后,效果如下:

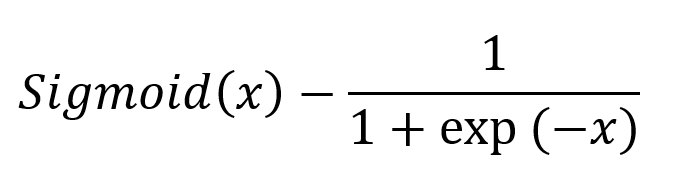

上面的这些函数都很好理解,只有一个函数相信没接触机器学习的时候,不大容易理解。也就是sigmoid()激活函数,它的公式如下:

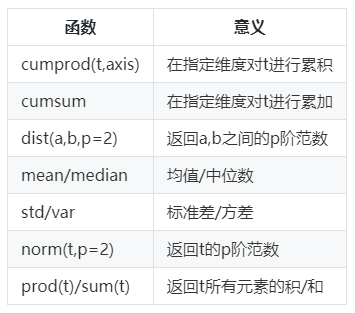

归并操作

简单的理解,就是对张量进行归并或者说合计等操作,这类操作的输入输出维度一般并不相同,而且往往是输入大于输出维度。而Tensor的归并函数如下表所示:

示例代码如下所示:

t = torch.Tensor([[1, 2]])

t1 = torch.Tensor([[3], [4]])

t2 = torch.Tensor([5, 6])

# t+0.1*(t1/t2)

print(torch.addcdiv(t, 0.1, t1, t2))

# t+0.1*(t1*t2)

print(torch.addcmul(t, 0.1, t1, t2))

print(torch.pow(t,3))

print(torch.neg(t))

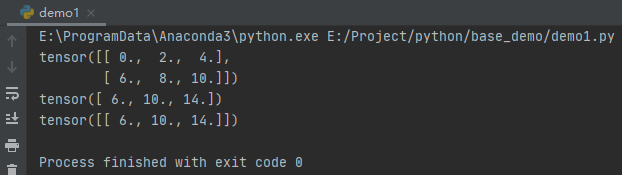

运行之后,效果如下:

需要注意的是,sum函数求和之后,dim的元素个数为1,所以要被去掉,如果要保留这个维度,则应当keepdim=True,默认为False。

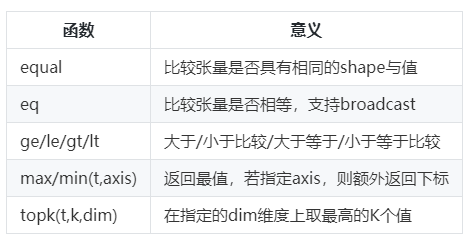

比较操作

在量化交易中,我们一般会对股价进行比较。而Tensor张量同样也支持比较的操作,一般是进行逐元素比较。具体函数如下表:

示例代码如下所示:

t = torch.Tensor([[1, 2]])

t1 = torch.Tensor([[3], [4]])

t2 = torch.Tensor([5, 6])

# t+0.1*(t1/t2)

print(torch.addcdiv(t, 0.1, t1, t2))

# t+0.1*(t1*t2)

print(torch.addcmul(t, 0.1, t1, t2))

print(torch.pow(t,3))

print(torch.neg(t))

运行之后,输出如下:

矩阵运算

机器学习与深度学习中,存在大量的矩阵运算。与Numpy一样常用的矩阵运算一样,一种是逐元素相乘,一种是点积乘法。函数如下表所示:

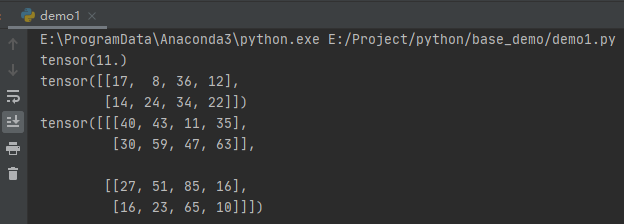

这里有3个主要的点积计算需要区分,dot()函数只能计算1维张量,mm()函数只能计算二维的张量,bmm只能计算三维的矩阵张量。示例如下:

# 计算1维点积

a = torch.Tensor([1, 2])

b = torch.Tensor([3, 4])

print(torch.dot(a, b))

# 计算2维点积

a = torch.randint(10, (2, 3))

b = torch.randint(6, (3, 4))

print(torch.mm(a, b))

# 计算3维点积

a = torch.randint(10, (2, 2, 3))

b = torch.randint(6, (2, 3, 4))

print(torch.bmm(a, b))

运行之后,输出如下:

Tensor:Pytorch神经网络界的Numpy的更多相关文章

- pytorch神经网络解决回归问题(非常易懂)

对于pytorch的深度学习框架,在建立人工神经网络时整体的步骤主要有以下四步: 1.载入原始数据 2.构建具体神经网络 3.进行数据的训练 4.数据测试和验证 pytorch神经网络的数据载入,以M ...

- PyTorch 神经网络

PyTorch 神经网络 神经网络 神经网络可以通过 torch.nn 包来构建. 现在对于自动梯度(autograd)有一些了解,神经网络是基于自动梯度 (autograd)来定义一些模型.一个 n ...

- PyTorch神经网络集成技术

PyTorch神经网络集成技术 create_python_neuropod 将任意python代码打包为一个neurood包. create_python_neuropod( neuropod_pa ...

- 使用Google-Colab训练PyTorch神经网络

Colaboratory 是免费的 Jupyter 笔记本环境,不需要进行任何设置就可以使用,并且完全在云端运行.关键是还有免费的GPU可以使用!用Colab训练PyTorch神经网络步骤如下: 1: ...

- 『PyTorch』第四弹_通过LeNet初识pytorch神经网络_下

『PyTorch』第四弹_通过LeNet初识pytorch神经网络_上 # Author : Hellcat # Time : 2018/2/11 import torch as t import t ...

- 2.Tensor Shape《Pytorch神经网络高效入门教程》Deeplizard

,之后,我们张量和基础数据的形状酱油卷积运算来改变. 卷积改变了高度和宽度维度以及颜色通道的数量.

- pytorch神经网络实现的基本步骤

转载自:https://blog.csdn.net/dss_dssssd/article/details/83892824 版权声明:本文为博主原创文章,遵循 CC 4.0 by-sa 版权协议,转载 ...

- pytorch之 compare with numpy

import torch import numpy as np # details about math operation in torch can be found in: http://pyto ...

- PyTorch学习笔记6--案例2:PyTorch神经网络(MNIST CNN)

上一节中,我们使用autograd的包来定义模型并求导.本节中,我们将使用torch.nn包来构建神经网络. 一个nn.Module包含各个层和一个forward(input)方法,该方法返回outp ...

随机推荐

- NAT网络地址转换技术

NAT网络地址转换技术 目录 一.NAT概述 1.1.概述 1.2.NAT 的应用场景 二.NAT的类型及配置命令 2.1.静态NAT 2.2.动态NAT 2.3.Easy IP 2.4.NATP 2 ...

- Terraform状态State管理,让变更有记录

我最新最全的文章都在南瓜慢说 www.pkslow.com,欢迎大家来喝茶! 简介 最近工作中用到了Terraform,权当学习记录一下,希望能帮助到其它人. Terraform系列文章如下: Ter ...

- 【春节歌曲回味 | STM32小音乐盒 】PWM+定时器驱动无源蜂鸣器(STM32 HAL库)

l STM32通过PWM与定时器方式控制无源蜂鸣器鸣响 l STM32小音乐盒,歌曲进度条图形显示与百分比显示,歌曲切换 l 编程使用STM32 HAL库 l IIC OLED界面编程,动画实 ...

- springboot集成swagger添加消息头(header请求头信息)

springboot集成swagger上篇文章介绍: https://blog.csdn.net/qiaorui_/article/details/80435488 添加头信息: package co ...

- linux学习之路第三天

开机,重启和用户登陆注销 关机&重启命令 shutdown shutdown -h now :表示立即关机 shutdown -h 1 :表示一分钟后关机 shutdown -r now :表 ...

- leetcode147对链表进行插入排序

题目: 对链表进行插入排序. 插入排序算法: 插入排序是迭代的,每次只移动一个元素,直到所有元素可以形成一个有序的输出列表. 每次迭代中,插入排序只从输入数据中移除一个待排序的元素,找到它在序列中适当 ...

- 第六章 time库的使用

time库概述 time库是python中处理时间的标准库 1.用于计算机时间的表达 2.提供获取系统时间并格式化输出功能 3.提供系统级精确计时功能,用于程序性能分析 1 import time 2 ...

- Djiango 连接数据库mysql 的基本数据操作

1.单表操作 (1) .增加操作 1 # 增加操作 2 def add_person(request): 3 # 1.使用save() 方法 4 # person_obj = models.Perso ...

- 使用 Java 和 Maven (JBake) 生成静态网站

使用 JBake("mvn generate-resources")构建您的静态网站或博客.使用布局.宏和数据文件. 我们迁移了整个www.optaplanner.org网站(13 ...

- C语言:按行读TXT文件

//搂行读取TXT #include <stdio.h> #include <stdlib.h> #include <string.h> #define MAX_L ...