如何用Python 制作词云-对1000首古诗做词云分析

公号:码农充电站pro

主页:https://codeshellme.github.io

今天来介绍一下如何使用 Python 制作词云。

词云又叫文字云,它可以统计文本中频率较高的词,并将这些词可视化,让我们可以直观的了解文本中的重点词汇。

词的频率越高,词显示的大小也就越大。

1,wordcloud 模块

wordcloud 是一个词云生成器,它不仅是一个 Python 库,还是一个命令行工具。我们可以通过 wordcloud 官方文档,和示例库来学习如何使用它。

在使用 wordcloud 之前,需要先安装它:

pip install wordcloud

2,WordCloud 类

WordCloud 类用于创建词云对象,先来看下它的原型:

WordCloud(font_path=None,

width=400, height=200,

margin=2, ranks_only=None,

prefer_horizontal=0.9,

mask=None, scale=1,

color_func=None, max_words=200,

min_font_size=4, stopwords=None,

random_state=None,

background_color='black',

max_font_size=None,

font_step=1, mode='RGB',

relative_scaling='auto',

regexp=None, collocations=True,

colormap=None, normalize_plurals=True,

contour_width=0, contour_color='black',

repeat=False, include_numbers=False,

min_word_length=0,

collocation_threshold=30)

可以看到,WordCloud 类有很多参数可以设置,这里介绍一些常用的参数:

- font_path:设置字体文件路径,字体文件以

.ttf为后缀。- 如果分析的文本是中文,则需要设置中文字体,否则会乱码。

- background_color:设置图片背景颜色,默认为 black,也可以设置为 white 等。

- mask:设置背景图片。

- max_words:设置最大的词数,默认为200。

- stopwords:设置停用词。

- max_font_size:设置字体最大值。

- width:设置画布的宽度,默认为400。

- height:设置画布的高度,默认为200。

- random_state:设置多少种随机状态,即多少种颜色。

在创建好词云对象后,可以使用 generate 方法生成词云,并使用 to_file 方法将词云图像保存在文件中。

generate 方法的原型如下:

generate(text)

参数text 是一个用空格隔开的文本字符串。如果分析的是中文,需要先用 jieba 进行分词,可以参考这里。

除了将词云图像保存在文件中,还可以使用 Matplotlib 模块显示词云图像,示例代码如下:

import matplotlib.pyplot as plt

plt.imshow(wordcloud) # wordcloud 是词云对象

plt.axis("off") # 用于关闭坐标轴

plt.show()

3,一个简单的示例

下面演示一个最简单的示例,来看如何使用 wordcloud。

首先创建词云对象:

from wordcloud import WordCloud

wc = WordCloud()

生成词云:

text = "Python is a programming language, it is easy to use."

wc.generate(text)

词云对象的 words_ 属性中存储了每个单词的(归一化后的)权重,权重的范围是 (0, 1]。

words_ 属性是一个字典类型,它存储的键的最大个数为 max_words,即 WordCloud 类的参数。

如下:

>>> wc.words_

{'Python': 1.0, 'programming': 1.0, 'language': 1.0, 'easy': 1.0, 'use': 1.0}

# 示例中的这些单词出现的频率都相等(均为 1),

# 所以它们的权重都是 1。

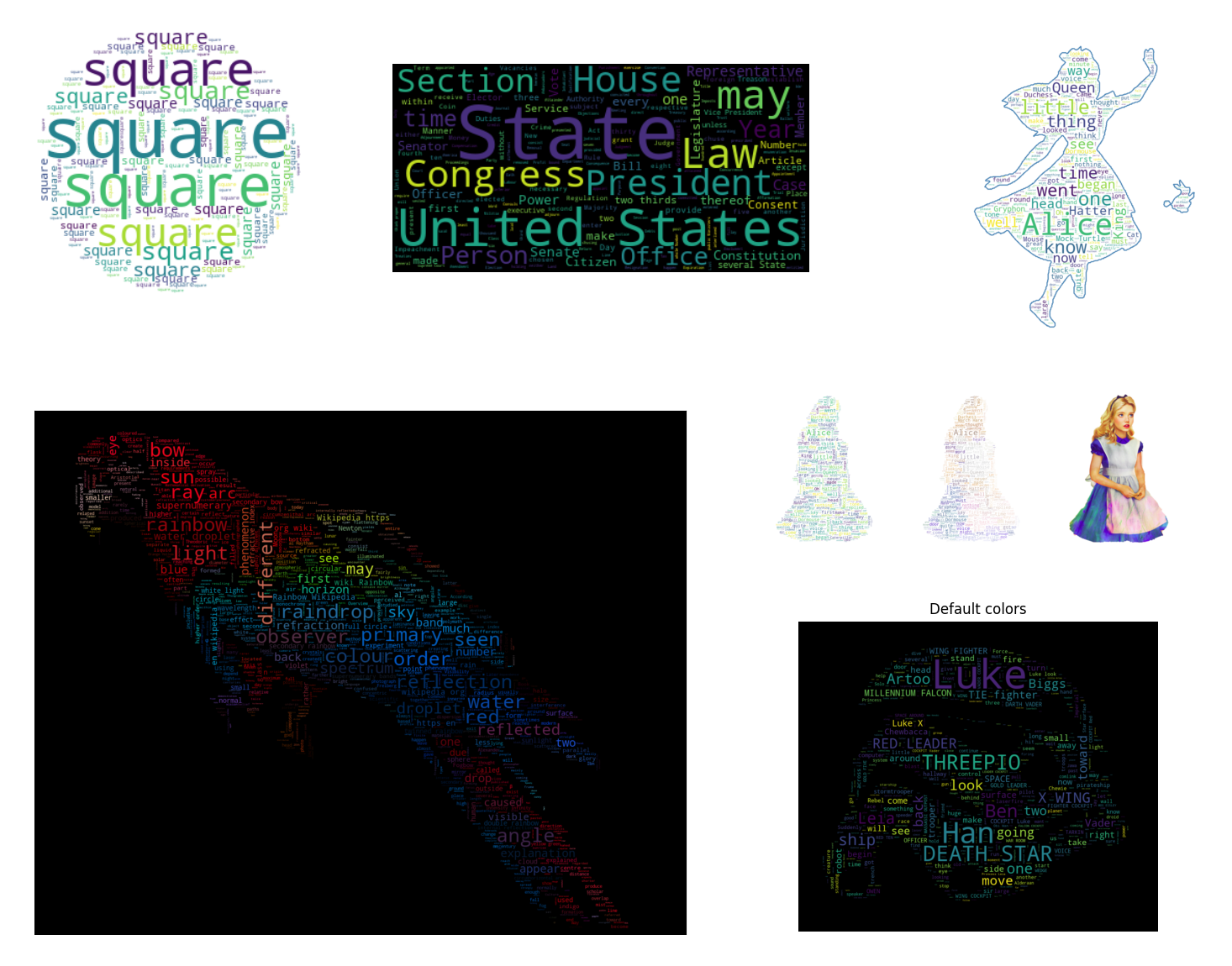

用 Matplotlib 展示词云图像:

import matplotlib.pyplot as plt

plt.imshow(wc)

plt.axis("off")

plt.show()

词云图像如下:

4,对古诗做词云分析

我在这里准备了一个案例,是对1000 首古诗做词云分析。

代码目录如下:

wordcloud/

├── SimHei.ttf

├── gushi.txt

└── gushi_wordcloud.py

其中:

我将代码也放在这里,方便查看:

#!/usr/bin/env python

# coding=utf-8

import os

import sys

import jieba

from wordcloud import WordCloud

if sys.version.startswith('2.'):

reload(sys)

sys.setdefaultencoding('utf-8')

# 去掉一些作者的名字

STOPWORDS = [

u'李白', u'杜甫', u'辛弃疾', u'李清照', u'苏轼',

u'李商隐', u'王维', u'白居易', u'李煜', u'杜牧',

]

def load_file(file_path):

if sys.version.startswith('2.'):

with open(file_path) as f:

lines = f.readlines()

else:

with open(file_path, encoding='utf-8') as f:

lines = f.readlines()

content = ''

for line in lines:

line = line.encode('unicode-escape').decode('unicode-escape')

line = line.strip().rstrip('\n')

content += line

words = jieba.cut(content)

l = []

for w in words:

# 如果词的长度小于 2,则舍去

if len(w) < 2: continue

l.append(w)

return ' '.join(l)

if __name__ == '__main__':

file_path = './gushi.txt'

content = load_file(file_path)

wc = WordCloud(

font_path="./SimHei.ttf",

stopwords=STOPWORDS,

width=2000, height=1200)

wc.generate(content)

wc.to_file("wordcloud.jpg")

其中:

STOPWORDS停用词列表,是一些作者的名字。load_file方法用于加载文本,其中用到了 jieba 分词。

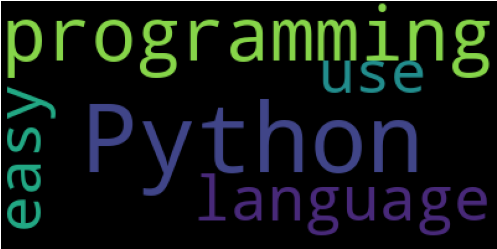

最后将词云图像保存在了 wordcloud.jpg 文件中,如下:

我们也可以从词云对象的words_ 属性中查看每个词的权重,这里我列出前十个:

('明月', 1.0)

('今日', 0.9130434782608695)

('不知', 0.8405797101449275)

('何处', 0.8260869565217391)

('不见', 0.8115942028985508)

('春风', 0.7536231884057971)

('无人', 0.7536231884057971)

('不可', 0.7536231884057971)

('万里', 0.7536231884057971)

('现代', 0.6666666666666666)

(本节完。)

推荐阅读:

欢迎关注作者公众号,获取更多技术干货。

如何用Python 制作词云-对1000首古诗做词云分析的更多相关文章

- 如何用Python做词云(收藏)

看过之后你有什么感觉?想不想自己做一张出来? 如果你的答案是肯定的,我们就不要拖延了,今天就来一步步从零开始做个词云分析图.当然,做为基础的词云图,肯定比不上刚才那两张信息图酷炫.不过不要紧,好的开始 ...

- 一步一步教你如何用Python做词云

前言 在大数据时代,你竟然会在网上看到的词云,例如这样的. 看到之后你是什么感觉?想不想自己做一个? 如果你的答案是正确的,那就不要拖延了,现在我们就开始,做一个词云分析图,Python是一个当下很流 ...

- python 生成18年写过的博客词云

文章链接:https://mp.weixin.qq.com/s/NmJjTEADV6zKdT--2DXq9Q 回看18年,最有成就的就是有了自己的 博客网站,坚持记录,写文章,累计写了36篇了,从一开 ...

- Python给小说做词云

闲暇时间喜欢看小说,就想着给小说做词云,展示小说的主要内容.开发语言是Python,主要用到的库有wordcloud.jieba.scipy.代码很简单,首先用jieba.cut()函数做分词,生成以 ...

- python3做词云分析

python3做词云 其实词云一般分为两种,一个是权重比,一个是频次分析 主要还是体现在自然语言方向,难度较大,但这里我们用jieba词库 主要思路, 后端算数据+前端生成图(D3-cloud-好像是 ...

- 纯前端实现词云展示+附微博热搜词云Demo代码

前言 最近工作中做了几个数据可视化大屏项目,其中也有用到了词云展示,以前做词云都是用python库来生成图片显示的,这次用了纯前端的实现(Ctrl+V真好用),同时顺手做个微博热搜的词云然后记录一下~ ...

- 做词云时报错cannot import name ‘WordCloud‘ from partially initialized module ‘wordcloud‘的解决办法

问题: 在做词云时,运行时出现该问题,wordcloud安装成功,但运行出错,错误提示是:cannot import name 'WordCloud' from partially initializ ...

- 词云wordcloud类介绍&python制作词云图&词云图乱码问题等小坑

词云图,大家一定见过,大数据时代大家经常见,我们今天就来用python的第三方库wordcloud,来制作一个大数据词云图,同时会降到这个过程中遇到的各种坑, 举个例子,下面是我从自己的微信上抓的微信 ...

- python制作词云

需要模块wordcloud,pip install wordcloud安装即可.代码: , #边距background_color='black',#指定背景颜色font_path='simhei.t ...

随机推荐

- Windows上Jenkins插件下载慢解决方法

替换文件内容 Jenkins/updates/default.json 替换 updates.jenkins-ci.org/download 为 mirrors.tuna.tsinghua.edu.c ...

- MQ消息中间件,面试能问些什么?

MQ消息中间件,面试能问些什么? 为什么使用消息队列?消息队列的优点和缺点? kafka.activemq.rabbitmq.rocketmq都有什么优缺点? 面试官角度分析: (1)你知不知道你们系 ...

- Codeforces375D Tree and Queries

dsu on tree 题目链接 点我跳转 题目大意 给定一棵 \(n\) 个节点的树,根节点为 \(1\).每个节点上有一个颜色 \(c_i\) \(m\) 次询问. 每次询问给出 \(u\) \( ...

- 分布式监控系统之Zabbix proxy

前文我们了解了zabbix 使用snmp和jmx信道采集数据的相关使用配置,回顾请参考https://www.cnblogs.com/qiuhom-1874/p/14029864.html:今天我们来 ...

- F - LCS 题解(最长公共子序列记录路径)

题目链接 题目大意 给你两个字符串,任意写出一个最长公共子序列 字符串长度小于3e3 题目思路 就是一个记录路径有一点要注意 找了好久的bug 不能直接\(dp[i][j]=dp[i-1][j-1]+ ...

- MySQL必知必会:简介undo log、truncate、以及undo log如何帮你回滚事物

目录 一.前言 二.undo log表空间 三.关于undo log默认的配置 四.如何将undo log放到单独的表空间 文章公众号首发,持续更新中 五.rollback segment 六.什么是 ...

- (1)Consul在linux环境的集群部署

1.Consul概念 1.1什么是Consul? Consul是一种服务网格解决方案,是HashiCorp公司推出的开源组件,由Go语言开发,部署起来很容易,只需要极少的可执行程序和配置.同时Cons ...

- LeetCode 029 Divide Two Integers

题目要求:Divide Two Integers Divide two integers without using multiplication, division and mod operator ...

- IdentityServer4系列 | 授权码模式

一.前言 在上一篇关于简化模式中,通过客户端以浏览器的形式请求IdentityServer服务获取访问令牌,从而请求获取受保护的资源,但由于token携带在url中,安全性方面不能保证.因此,我们可以 ...

- Cys_Control(一) 项目搭建

一.基础工程搭建 Cys_Controls Cys_Resource(注:一般类库默认不能引入资源文件,故直接创建Custom Control Library) Cys_Demo 删除默认文件夹及类, ...