从veth看虚拟网络设备的qdisc

背景

前段时间在测试docker的网络性能的时候,发现了一个veth的性能问题,后来给docker官方提交了一个PR,参考set tx_queuelen to 0 when create veth device,引起了一些讨论。再后来,RedHat的网络专家Jesper Brouer 出来详细的讨论了一下这个问题。

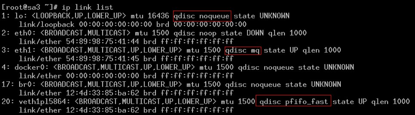

可以看到,veth设备qdisc队列,而环回设备/桥接设备是没qdisc队列的,参考br_dev_setup函数。

内核实现

在注册(创建)设备时,qdisc设置为noop_qdisc, register_netdevice -> dev_init_scheduler

void dev_init_scheduler(struct net_device *dev)

{

dev->qdisc = &noop_qdisc;

netdev_for_each_tx_queue(dev, dev_init_scheduler_queue, &noop_qdisc);

dev_init_scheduler_queue(dev, &dev->rx_queue, &noop_qdisc);

setup_timer(&dev->watchdog_timer, dev_watchdog, (unsigned long)dev);

}

打开设备时,如果没有配置qdisc时,就指定为默认的pfifo_fast队列: dev_open -> dev_activate,

void dev_activate(struct net_device *dev)

{

int need_watchdog;

/* No queueing discipline is attached to device;

create default one i.e. pfifo_fast for devices,

which need queueing and noqueue_qdisc for

virtual interfaces

*/

if (dev->qdisc == &noop_qdisc)

attach_default_qdiscs(dev);

...

}

static void attach_default_qdiscs(struct net_device *dev)

{

struct netdev_queue *txq;

struct Qdisc *qdisc;

txq = netdev_get_tx_queue(dev, 0);

if (!netif_is_multiqueue(dev) || dev->tx_queue_len == 0) {

netdev_for_each_tx_queue(dev, attach_one_default_qdisc, NULL);

dev->qdisc = txq->qdisc_sleeping;

atomic_inc(&dev->qdisc->refcnt);

} else {///multi queue

qdisc = qdisc_create_dflt(dev, txq, &mq_qdisc_ops, TC_H_ROOT);

if (qdisc) {

qdisc->ops->attach(qdisc);

dev->qdisc = qdisc;

}

}

}

static void attach_one_default_qdisc(struct net_device *dev,

struct netdev_queue *dev_queue,

void *_unused)

{

struct Qdisc *qdisc;

if (dev->tx_queue_len) {

qdisc = qdisc_create_dflt(dev, dev_queue,

&pfifo_fast_ops, TC_H_ROOT);

if (!qdisc) {

printk(KERN_INFO "%s: activation failed\n", dev->name);

return;

}

/* Can by-pass the queue discipline for default qdisc */

qdisc->flags |= TCQ_F_CAN_BYPASS;

} else {

qdisc = &noqueue_qdisc;

}

dev_queue->qdisc_sleeping = qdisc;

}

创建noqueue

开始尝试直接删除设备默认的pfifo_fast队列,发现会出错:

# tc qdisc del dev vethd4ea root

RTNETLINK answers: No such file or directory

# tc -s qdisc ls dev vethd4ea

qdisc pfifo_fast 0: root refcnt 2 bands 3 priomap 1 2 2 2 1 2 0 0 1 1 1 1 1 1 1 1

Sent 29705382 bytes 441562 pkt (dropped 0, overlimits 0 requeues 0)

backlog 0b 0p requeues 0

后来看到Jesper Brouer给出一个替换默认队列的方式,尝试了一下,成功完成。

替换默认的qdisc队列

# tc qdisc replace dev vethd4ea root pfifo limit 100

# tc -s qdisc ls dev vethd4ea

qdisc pfifo 8001: root refcnt 2 limit 100p

Sent 264 bytes 4 pkt (dropped 0, overlimits 0 requeues 0)

backlog 0b 0p requeues 0

# ip link show vethd4ea

9: vethd4ea: <BROADCAST,UP,LOWER_UP> mtu 1500 qdisc pfifo master docker0 state UP mode DEFAULT qlen 1000

link/ether 3a:15:3b:e1:d7:6d brd ff:ff:ff:ff:ff:ff

修改队列长度

# ifconfig vethd4ea txqueuelen 0

删除qdisc

# tc qdisc del dev vethd4ea root

# ip link show vethd4ea

9: vethd4ea: <BROADCAST,UP,LOWER_UP> mtu 1500 qdisc noqueue master docker0 state UP mode DEFAULT

link/ether 3a:15:3b:e1:d7:6d brd ff:ff:ff:ff:ff:ff

可以看到,UP的veth设备成功修改成noqueue。

小结

总之,给虚拟网络设备创建默认的qdisc,是不太合理的。这会让虚拟机(或者容器)的网络瓶颈过早的出现在qdisc,而不是真实的物理设备(除非应用需要创建qdisc)。更多详细参考这里。

本文转自https://hustcat.github.io/veth/

从veth看虚拟网络设备的qdisc的更多相关文章

- Linux 虚拟网络设备 veth-pair 详解,看这一篇就够了

本文首发于我的公众号 Linux云计算网络(id: cloud_dev),专注于干货分享,号内有 10T 书籍和视频资源,后台回复「1024」即可领取,欢迎大家关注,二维码文末可以扫. 前面这篇文章介 ...

- [转]UOS 中的虚拟网络设备

随着网络技术,虚拟化技术的发展,越来越多的高级网络设备被加入了到了 Linux 中,这些设备在 UOS 中起到了广泛而关键的作用,包括 Open vSwitch.TAP 设备.Veth 设备等等,梳理 ...

- linux 虚拟网络设备的使用

1. linux 常见虚拟网络设备分类 常见虚拟网络设备有:bridge, tun/tap, veth-pairs, macvlan, macvtap等.有一篇博文写的挺好的,图文并茂:虚拟网络设备, ...

- 云计算底层技术-虚拟网络设备(Bridge,VLAN)( 转发)

云计算底层技术-虚拟网络设备(Bridge,VLAN) Posted on September 24, 2017 by opengers in openstack openstack底层技术-各种虚拟 ...

- Linux 虚拟网络设备详解之 Bridge 网桥

本文首发于我的公众号 Linux云计算网络(id: cloud_dev),专注于干货分享,号内有 10T 书籍和视频资源,后台回复「1024」即可领取,欢迎大家关注,二维码文末可以扫. 前面几篇文章介 ...

- 【转】TUN/TAP虚拟网络设备

转: 原文:https://www.cnblogs.com/wyzhou/p/9286864.html ------------------------------------------------ ...

- [转]Linux虚拟网络设备之tun/tap

转, 原文:https://segmentfault.com/a/1190000009249039 -------------------------------------------------- ...

- 一文总结 Linux 虚拟网络设备 eth, tap/tun, veth-pair

本文首发于我的公众号 Linux云计算网络(id: cloud_dev),专注于干货分享,号内有 10T 书籍和视频资源,后台回复「1024」即可领取,欢迎大家关注,二维码文末可以扫. Linux 虚 ...

- [原创] 详解云计算网络底层技术——虚拟网络设备 tap/tun 原理解析

本文首发于我的公众号 Linux云计算网络(id: cloud_dev),专注于干货分享,号内有 10T 书籍和视频资源,后台回复「1024」即可领取,欢迎大家关注,二维码文末可以扫. 在云计算时代, ...

随机推荐

- CSS过滤器

CSS过滤器(CSS filters)最初是为了向SVG矢量图提供不同的图片效果.现在,CSS filters 不在局限于在SVG中使用,也可以在图片.文字和其它元素上使用.CSS过滤器效果并不难理解 ...

- HTML 30分钟入门教程

作者:deerchao 转载请注明来源 本文目标 30分钟内让你明白HTML是什么,并对它有一些基本的了解.一旦入门后,你可以从网上找到更多更详细的资料来继续学习. 什么是HTML HTML是英文Hy ...

- UE4 UriEncode 问题

当Uri 路径中带中文字符时,需要进行编码 否则会照成不可预见错误: FString temp = FGenericPlatformHttp::UrlEncode(queryStr); FString ...

- linux 录制并回放终端会话

发现一个比较好玩的命令,然后这块做一下记录 以下内容复制来源于 LINUX shell 脚本攻略第二版 当你需要为别人在终端上演示某些操作或是需要准备一个命令行教程时,通常得一边手动输入命令一边演示, ...

- 认识Java

java出生地:SUN Microsystems Inc<开源> -SUN : Standford University Network java之父:James Gosling ...

- oracle xmltype导入并解析Excel数据 (一)创建表与序

表说明: T_EXCEL_IMPORT_DATASRC: Excel数据存储表,(使用了xmltype存储Excel数据) 部分字段说明: BUSINESSTYPE: Excel模板类型,一个Exce ...

- Draw_extend使用OpenGL显示数据点

//alter load_map.dev //safety verion 2016/1/12 #include <iostream> #include <fstream> #i ...

- 购物车数字加减按钮HTML+CSS+JS(有需要嫌麻烦的小伙伴拿走不谢)

之前在写详情页的时候,如下图 因为自己嫌麻烦,就去看其他网站是怎么写的,想直接拿来用,后来看来看去觉得写得很麻烦,于是最后还是决定自己写,附上HTML+CSS+JS代码,一条龙一站式贴心服务2333 ...

- Oracle监听小问题

啥情况 宁波_弈风 15:17:40 宁波_弈风 15:17:49 默认配置路径 宁波_弈风 15:18:09 宁波_弈风 15:19:13 我原来一直都在SAMPLE文件里面配置和保存,因为 ...

- 如何让iOS 保持界面流畅?这些技巧你知道吗

如何让iOS 保持界面流畅?这些技巧你知道吗 作者:ibireme这篇文章会非常详细的分析 iOS 界面构建中的各种性能问题以及对应的解决思路,同时给出一个开源的微博列表实现,通过实际的代码展示如 ...