Mapreduce-实现webcount代码

参考博文:https://blog.csdn.net/qq_41035588/article/details/90514824

首先安装一个Hadoop-Eclipse-Plugin 方便来对于hdfs进行管理

参考地址:http://dblab.xmu.edu.cn/blog/hadoop-build-project-using-eclipse/

配置好Hadoop-Ecllipse-Plugin之后

建立一个txt文档,里面的内容如下:

买家id 商品id 收藏日期

-- ::

-- ::

-- ::

-- ::

-- ::

-- ::

-- ::

-- ::

-- ::

-- ::

-- ::

-- ::

-- ::

-- ::

-- ::

-- ::

-- ::

-- ::

-- ::

-- ::

-- ::

-- ::

-- ::

-- ::

-- ::

-- ::

-- ::

-- ::

-- ::

-- ::

然后建立一个java项目

然后把所有的包都导进去,重点是mapreduce,common,yarn,hdfs的包

然后再输入代码:

package mapreduce; import java.io.IOException;

import java.util.StringTokenizer;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.Mapper;

import org.apache.hadoop.mapreduce.Reducer;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat; public class WordCount { public static class doMapper extends Mapper<Object, Text, Text, IntWritable>{

//第一个object表示输入key的类型,第二个text表示输入value的类型;第三个text表示输出建的类型;

//第四个INtWritable表示输出值的类型 public static final IntWritable one = new IntWritable(1);

public static Text word = new Text();

@Override

protected void map(Object key, Text value, Context context)

//key value是输入的key value context是记录输入的key,value

throws IOException, InterruptedException {

StringTokenizer tokenizer = new StringTokenizer(value.toString(), "\t");

//StringTokenizer是Java的工具包中的一个类,用于将字符串进行拆分

word.set(tokenizer.nextToken());

//返回当前位置到下一个分隔符之间的字符串

context.write(word, one);

//讲word存到容器中计一个数

}

}

public static class doReducer extends Reducer<Text, IntWritable, Text, IntWritable>{

//输入键类型,输入值类型 输出建类型,输出值类型

private IntWritable result = new IntWritable();

@Override

protected void reduce(Text key, Iterable<IntWritable> values, Context context)

throws IOException, InterruptedException {

int sum = 0;

for (IntWritable value : values) {

sum += value.get();

}

result.set(sum);

context.write(key, result);

}

}

public static void main(String[] args) throws IOException, ClassNotFoundException, InterruptedException {

Job job = Job.getInstance();

job.setJobName("WordCount");

job.setJarByClass(WordCount.class);

job.setMapperClass(doMapper.class);

job.setReducerClass(doReducer.class);

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(IntWritable.class);

Path in = new Path("hdfs://localhost:9000/mymapreduce1/in/buyer_favorite1");

Path out = new Path("hdfs://localhost:9000/mymapreduce1/out");

FileInputFormat.addInputPath(job, in);

FileOutputFormat.setOutputPath(job, out);

System.exit(job.waitForCompletion(true) ? 0 : 1);

}

}

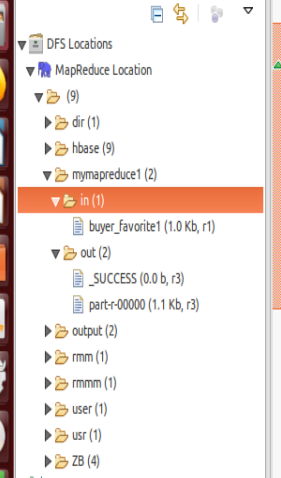

然后运行之后查看左边的菜单:

双击part-r-00000就有返回的值了

最重要的问题就是分隔的问题

- StringTokenizer tokenizer = new StringTokenizer(value.toString(),"\t");

这个是根据tab键来进行分割,但是我们复制粘贴后就是空格所以要换成空格

Mapreduce-实现webcount代码的更多相关文章

- MapReduce框架结构及代码示例

一个完整的 mapreduce 程序在分布式运行时有三类实例进程: 1.MRAppMaster:负责整个程序的过程调度及状态协调 2.MapTask:负责 map 阶段的整个数据处理流程 3.Redu ...

- [大牛翻译系列]Hadoop(15)MapReduce 性能调优:优化MapReduce的用户JAVA代码

6.4.5 优化MapReduce用户JAVA代码 MapReduce执行代码的方式和普通JAVA应用不同.这是由于MapReduce框架为了能够高效地处理海量数据,需要成百万次调用map和reduc ...

- 使用mapreduce计算环比的实例

最近做了一个小的mapreduce程序,主要目的是计算环比值最高的前5名,本来打算使用spark计算,可是本人目前spark还只是简单看了下,因此就先改用mapreduce计算了,今天和大家分享下这个 ...

- MapReduce工作流多种实现方式

学习 hadoop,必不可少的就是编写 MapReduce 程序.当然,对于简单的分析程序,我们只需一个 MapReduce 任务就能搞定,然而对于比较复杂的分析程序,我们可能需要多个Job或者多个M ...

- Hadoop学习笔记—11.MapReduce中的排序和分组

一.写在之前的 1.1 回顾Map阶段四大步骤 首先,我们回顾一下在MapReduce中,排序和分组在哪里被执行: 从上图中可以清楚地看出,在Step1.4也就是第四步中,需要对不同分区中的数据进行排 ...

- [大牛翻译系列]Hadoop(19)MapReduce 文件处理:基于压缩的高效存储(二)

5.2 基于压缩的高效存储(续) (仅包括技术27) 技术27 在MapReduce,Hive和Pig中使用可分块的LZOP 如果一个文本文件即使经过压缩后仍然比HDFS的块的大小要大,就需要考虑选择 ...

- MapReduce链接作业

对于简单的分析程序,我们只需一个MapReduce就能搞定,然而对于比较复杂的分析程序,我们可能需要多个Job或者多个Map或者Reduce进行计算.下面我们来说说多个Job或者多个MapReduce ...

- 十九、Hadoop学记笔记————Hbase和MapReduce

概要: hadoop和hbase导入环境变量: 要运行Hbase中自带的MapReduce程序,需要运行如下指令,可在官网中找到: 如果遇到如下问题,则说明Hadoop的MapReduce没有权限访问 ...

- 从分治算法到 Hadoop MapReduce

从分治算法说起 要说 Hadoop MapReduce 就不得不说分治算法,而分治算法其实说白了,就是四个字 分而治之 .其实就是将一个复杂的问题分解成多组相同或类似的子问题,对这些子问题再分,然后再 ...

随机推荐

- myeclipse 出现换行符和空格符 解决方案 换行出现乱码

请参看百度经验 https://jingyan.baidu.com/article/acf728fd2639e4f8e510a399.html myeclipse 2014 自定义视图Customiz ...

- Python练习_文件操作_day8

1. 1.作业 1,有如下文件,a1.txt,里面的内容为: 老男孩是最好的学校, 全心全意为学生服务, 只为学生未来,不为牟利. 我说的都是真的.哈哈 分别完成以下的功能: a,将原文件全部读出来并 ...

- cookie和session,sessionStorage、localStorage和cookie的区别

1.cookie 含义: 存储在访问者的计算机中的变量,即存储在客户端 创建一个cookie /* getCookie方法判断document.cookie对象中是否存有cookie,若有则判断该co ...

- js写guess网页

(一)布局 猜前 -> 猜后 (二)明确实现功能和具体实现: 1.网页生 ...

- dubbo常见异常及解决方式

1.出现RpcException: Failed to invoke the method post in the service com.xxx.xxx.xxx异常怎么办?表示调用失败1.检查网络是 ...

- word生成目录的pdf

在很多情况下,需要将Word转换为带目录书签的PDF,方便pdf阅读,所以可以使用word自带的pdf转换,在转换时设置相关即可 注意:待转换Word中应该有目录,可以用Word中的标题来自动生成目录 ...

- Elasticsearch 9300无法访问,客户端出现NoNodeAvailableException[None of the configured nodes are available: [{#transport#‐1}{exvgJLR‐RlCNMJy‐hzKtnA}

1. 进入容器 docker exec ‐it ID /bin/bash 2. 拷贝配置文件到宿主机 docker cp ID:/usr/share/elasticsearch/config/el ...

- Linux学习之七-配置Telnet连接Linux服务器

配置Telnet连接Linux服务器 通过telnet可以从windows平台访问linux 服务器 ,实现和ssh 客户端一样的效果,区别在于通过ssh连接更安全. 检查Linux系统中是否安装了t ...

- 目标检测---搬砖一个ALPR自动车牌识别的环境

目标检测---搬砖一个ALPR自动车牌识别的环境 参考License Plate Detection and Recognition in Unconstrained Scenarios@https: ...

- JDK源码那些事儿之红黑树基础下篇

说到HashMap,就一定要说到红黑树,红黑树作为一种自平衡二叉查找树,是一种用途较广的数据结构,在jdk1.8中使用红黑树提升HashMap的性能,今天就来说一说红黑树,上一讲已经给出插入平衡的调整 ...