python实现线性回归之简单回归

代码来源:https://github.com/eriklindernoren/ML-From-Scratch

首先定义一个基本的回归类,作为各种回归方法的基类:

class Regression(object):

""" Base regression model. Models the relationship between a scalar dependent variable y and the independent

variables X.

Parameters:

-----------

n_iterations: float

The number of training iterations the algorithm will tune the weights for.

learning_rate: float

The step length that will be used when updating the weights.

"""

def __init__(self, n_iterations, learning_rate):

self.n_iterations = n_iterations

self.learning_rate = learning_rate def initialize_wights(self, n_features):

""" Initialize weights randomly [-1/N, 1/N] """

limit = 1 / math.sqrt(n_features)

self.w = np.random.uniform(-limit, limit, (n_features, )) def fit(self, X, y):

# Insert constant ones for bias weights

X = np.insert(X, 0, 1, axis=1)

self.training_errors = []

self.initialize_weights(n_features=X.shape[1]) # Do gradient descent for n_iterations

for i in range(self.n_iterations):

y_pred = X.dot(self.w)

# Calculate l2 loss

mse = np.mean(0.5 * (y - y_pred)**2 + self.regularization(self.w))

self.training_errors.append(mse)

# Gradient of l2 loss w.r.t w

grad_w = -(y - y_pred).dot(X) + self.regularization.grad(self.w)

# Update the weights

self.w -= self.learning_rate * grad_w def predict(self, X):

# Insert constant ones for bias weights

X = np.insert(X, 0, 1, axis=1)

y_pred = X.dot(self.w)

return y_pred

说明:初始化时传入两个参数,一个是迭代次数,另一个是学习率。initialize_weights()用于初始化权重。fit()用于训练。需要注意的是,对于原始的输入X,需要将其最前面添加一项为偏置项。predict()用于输出预测值。

接下来是简单线性回归,继承上面的基类:

class LinearRegression(Regression):

"""Linear model.

Parameters:

-----------

n_iterations: float

The number of training iterations the algorithm will tune the weights for.

learning_rate: float

The step length that will be used when updating the weights.

gradient_descent: boolean

True or false depending if gradient descent should be used when training. If

false then we use batch optimization by least squares.

"""

def __init__(self, n_iterations=100, learning_rate=0.001, gradient_descent=True):

self.gradient_descent = gradient_descent

# No regularization

self.regularization = lambda x: 0

self.regularization.grad = lambda x: 0

super(LinearRegression, self).__init__(n_iterations=n_iterations,

learning_rate=learning_rate)

def fit(self, X, y):

# If not gradient descent => Least squares approximation of w

if not self.gradient_descent:

# Insert constant ones for bias weights

X = np.insert(X, 0, 1, axis=1)

# Calculate weights by least squares (using Moore-Penrose pseudoinverse)

U, S, V = np.linalg.svd(X.T.dot(X))

S = np.diag(S)

X_sq_reg_inv = V.dot(np.linalg.pinv(S)).dot(U.T)

self.w = X_sq_reg_inv.dot(X.T).dot(y)

else:

super(LinearRegression, self).fit(X, y)

这里使用两种方式进行计算。如果规定gradient_descent=True,那么使用随机梯度下降算法进行训练,否则使用标准方程法进行训练。

最后是使用:

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

from sklearn.datasets import make_regression

import sys

sys.path.append("/content/drive/My Drive/learn/ML-From-Scratch/") from mlfromscratch.utils import train_test_split, polynomial_features

from mlfromscratch.utils import mean_squared_error, Plot

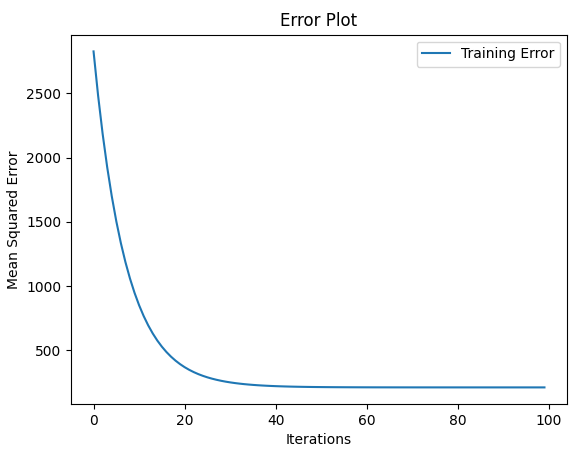

from mlfromscratch.supervised_learning import LinearRegression def main(): X, y = make_regression(n_samples=100, n_features=1, noise=20) X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.4) n_samples, n_features = np.shape(X) model = LinearRegression(n_iterations=100) model.fit(X_train, y_train) # Training error plot

n = len(model.training_errors)

training, = plt.plot(range(n), model.training_errors, label="Training Error")

plt.legend(handles=[training])

plt.title("Error Plot")

plt.ylabel('Mean Squared Error')

plt.xlabel('Iterations')

plt.savefig("test1.png")

plt.show() y_pred = model.predict(X_test)

mse = mean_squared_error(y_test, y_pred)

print ("Mean squared error: %s" % (mse)) y_pred_line = model.predict(X) # Color map

cmap = plt.get_cmap('viridis') # Plot the results

m1 = plt.scatter(366 * X_train, y_train, color=cmap(0.9), s=10)

m2 = plt.scatter(366 * X_test, y_test, color=cmap(0.5), s=10)

plt.plot(366 * X, y_pred_line, color='black', linewidth=2, label="Prediction")

plt.suptitle("Linear Regression")

plt.title("MSE: %.2f" % mse, fontsize=10)

plt.xlabel('Day')

plt.ylabel('Temperature in Celcius')

plt.legend((m1, m2), ("Training data", "Test data"), loc='lower right')

plt.savefig("test2.png")

plt.show() if __name__ == "__main__":

main()

利用sklearn库生成线性回归数据,然后将其拆分为训练集和测试集。

utils下的mean_squared_error():

def mean_squared_error(y_true, y_pred):

""" Returns the mean squared error between y_true and y_pred """

mse = np.mean(np.power(y_true - y_pred, 2))

return mse

结果:

Mean squared error: 532.3321383700828

python实现线性回归之简单回归的更多相关文章

- 机器学习经典算法具体解释及Python实现--线性回归(Linear Regression)算法

(一)认识回归 回归是统计学中最有力的工具之中的一个. 机器学习监督学习算法分为分类算法和回归算法两种,事实上就是依据类别标签分布类型为离散型.连续性而定义的. 顾名思义.分类算法用于离散型分布预測, ...

- python实现线性回归

参考:<机器学习实战>- Machine Learning in Action 一. 必备的包 一般而言,这几个包是比较常见的: • matplotlib,用于绘图 • numpy,数组处 ...

- python求线性回归斜率

一. 先说我对这个题目的理解 直线的x,y方程是这样的:y = kx+b, k就是斜率. 求线性回归斜率, 就是说 有这么一组(x, y)的对应值——样本.如果有四组,就说样本量是4.根据这些样本,做 ...

- 吴裕雄 python 机器学习——线性回归模型

import numpy as np from sklearn import datasets,linear_model from sklearn.model_selection import tra ...

- python模拟线性回归的点

构造符合线性回归的数据点 import numpy as np import tensorflow as tf import matplotlib.pyplot as plt # 随机生成1000个点 ...

- python机器学习---线性回归案例和KNN机器学习案例

散点图和KNN预测 一丶案例引入 # 城市气候与海洋的关系研究 # 导包 import numpy as np import pandas as pd from pandas import Serie ...

- Python机器学习/LinearRegression(线性回归模型)(附源码)

LinearRegression(线性回归) 2019-02-20 20:25:47 1.线性回归简介 线性回归定义: 百科中解释 我个人的理解就是:线性回归算法就是一个使用线性函数作为模型框架($ ...

- 机器学习之线性回归(纯python实现)][转]

本文转载自:https://juejin.im/post/5a924df16fb9a0634514d6e1 机器学习之线性回归(纯python实现) 线性回归是机器学习中最基本的一个算法,大部分算法都 ...

- 【机器学习】线性回归python实现

线性回归原理介绍 线性回归python实现 线性回归sklearn实现 这里使用python实现线性回归,没有使用sklearn等机器学习框架,目的是帮助理解算法的原理. 写了三个例子,分别是单变量的 ...

随机推荐

- [vijos]1051送给圣诞夜的极光<BFS>

送给圣诞夜的极光 题目链接:https://www.vijos.org/p/1051 这是一道很水很水的宽搜水题,我主要是觉得自己在搜素这一块有点生疏于是随便找了一题练手,找到这么一道水题,原本以为可 ...

- 1063 Set Similarity (25分)

Given two sets of integers, the similarity of the sets is defined to be /, where Nc is the number ...

- 1033 To Fill or Not to Fill (25分)(贪心)

With highways available, driving a car from Hangzhou to any other city is easy. But since the tank c ...

- Redis设计与实现笔记 - hash

基本结构如下 初始状态一直使用 dictht[0],即 0 号哈希表 在发生扩容 rehash的时候,开始渐进式向 dictht[1]哈希表转移, 转移完成后交换 dicth[0] 与 dictht[ ...

- HttpClient来自官方的JSON扩展方法

System.Net.Http.Json Json的序列化和反序列化是我们日常常见的操作,通过System.Net.Http.Json我们可以用少量的代码实现上述操作.正如在github设计文档中所描 ...

- CF633(div.2)C. Powered Addition

题目描述 http://codeforces.com/contest/1339/problem/C 给定一个长度为 \(n\) 的无序数组,你可以在第 \(x\) 秒进行一次下面的操作. 从数组选取任 ...

- ssh秘钥免交互批量分发脚本

将以下内容保存为.sh文件后运行即可,需根据各自情况修改ip_up和ip_arr #!/bin/bash #脚本功能:ssh秘钥免交互批量分发 #制 作 人:罗钢 联系方式:278554547@qqc ...

- 会 python 的一定会爬虫吗,来看看

文章更新于:2020-02-18 注:python 爬虫当然要安装 python,如何安装参见:python 的安装使用和基本语法 一.什么是网络爬虫 网络爬虫就是用代码模拟人类去访问网站以获取我们想 ...

- Linux 压缩备份篇(一 压缩与解压缩)

.Z compress程序压缩的档案 .bz2 bzip2程序压缩的档案 .gz gzip程序压缩的档案 .t ...

- 8.4 StringBuilder的介绍及用法(String 和StringBuilder区别)

* StringBuilder:是一个可变的字符串.字符串缓冲区类.** String和StringBuilder的区别:* String的内容是固定的.(方法区的内容)* StringBuilder ...