hadoop 完全分布式搭建总结

完全分布式---------------

1.配置文件

[core-site.xml]

hdfs 地址 fs.defaultFS=hdfs://s129:8020/

[hdfs-site.xml] 副本

replication=1 //伪分布

replication=3 //完全分布

[mapred-site.xml] yarn框架

mapreduce.framework.name=yarn

[yarn-site.xml] 资源管理器主机名

rm.name=s129

[slaves]

s128

s127

s126

2.分发文件

a)ssh

openssh-server //sshd

openssh-clients //ssh

openssh //ssh-keygen

b)scp/rsync

3.格式化文件系统

$>hadoop namenode -format

4.启动hadoop所有进程

//start-dfs.sh + start-yarn.sh

$>start-all.sh

5.xcall.sh jps

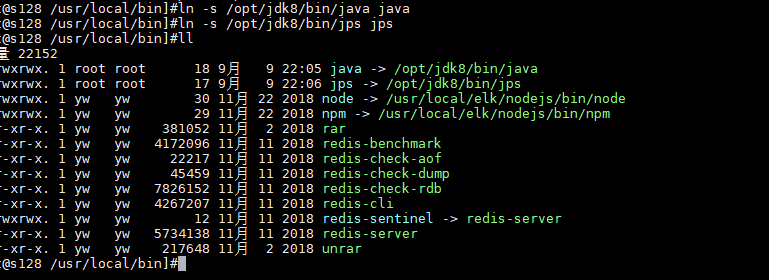

创建符号连接 ln -s xxxx xx

ln -s /opt/jdk8/bin/java java

ln -s /opt/jdk8/bin/jps jps

/usr/local/bin/jps

/usr/local/bin/java

6.查看jps进程

$>xcall.sh jps

或

$>netstat -tunpl | grep 端口号

7.关闭centos的防火墙

$>sudo service firewalld stop // <=6.5 start/stop/status/restart

$>sudo systemctl stop firewalld // 7.0 停止 start/stop/status/restart

$>sudo systemctl disable firewalld //关闭

$>sudo systemctl enable firewalld //启用

7.最终通过webui

http://s201:50070/

符号连接

----------------

1.修改符号连接的owner

$>chown -h centos:centos xxx //-h:针对连接本身,而不是所指文件.

2.修改符号链接

$>ln -sfT index.html index //覆盖原有的连接。

运行命令

start-all.sh 启动所有的Hadoop守护进程。包括NameNode、 Secondary NameNode、DataNode、JobTracker、 TaskTrack

stop-all.sh 停止所有的Hadoop守护进程。包括NameNode、 Secondary NameNode、DataNode、JobTracker、 TaskTrack

start-dfs.sh 启动Hadoop HDFS守护进程NameNode、SecondaryNameNode和DataNode

stop-dfs.sh 停止Hadoop HDFS守护进程NameNode、SecondaryNameNode和DataNode

hadoop-daemons.sh start namenode 单独启动NameNode守护进程

hadoop-daemons.sh stop namenode 单独停止NameNode守护进程

hadoop-daemons.sh start datanode 单独启动DataNode守护进程

hadoop-daemons.sh stop datanode 单独停止DataNode守护进程

hadoop-daemons.sh start secondarynamenode 单独启动SecondaryNameNode守护进程

hadoop-daemons.sh stop secondarynamenode 单独停止SecondaryNameNode守护进程

start-mapred.sh 启动Hadoop MapReduce守护进程JobTracker和TaskTracker

stop-mapred.sh 停止Hadoop MapReduce守护进程JobTracker和TaskTracker

hadoop-daemons.sh start jobtracker 单独启动JobTracker守护进程

hadoop-daemons.sh stop jobtracker 单独停止JobTracker守护进程

hadoop-daemons.sh start tasktracker 单独启动TaskTracker守护进程

hadoop-daemons.sh stop tasktracker 单独启动TaskTracker守护进程

hadoop模块

-------------------

common //

hdfs //

mapreduce //

yarn //

进程

------------------

[hdfs]start-dfs.sh

NameNode NN

DataNode DN

SecondaryNamenode 2NN

[yarn]start-yarn.sh

ResourceMananger RM

NodeManager NM

脚本分析

-------------------

sbin/start-all.sh

--------------

libexec/hadoop-config.sh

start-dfs.sh

start-yarn.sh

sbin/start-dfs.sh

--------------

libexec/hadoop-config.sh

sbin/hadoop-daemons.sh --config .. --hostname .. start namenode ...

sbin/hadoop-daemons.sh --config .. --hostname .. start datanode ...

sbin/hadoop-daemons.sh --config .. --hostname .. start sescondarynamenode ...

sbin/hadoop-daemons.sh --config .. --hostname .. start zkfc ... //

sbin/start-yarn.sh

--------------

libexec/yarn-config.sh

bin/yarn-daemon.sh start resourcemanager

bin/yarn-daemons.sh start nodemanager

sbin/hadoop-daemons.sh

----------------------

libexec/hadoop-config.sh

slaves

hadoop-daemon.sh

sbin/hadoop-daemon.sh

-----------------------

libexec/hadoop-config.sh

bin/hdfs ....

sbin/yarn-daemon.sh

-----------------------

libexec/yarn-config.sh

bin/yarn

bin/hadoop

------------------------

hadoop verion //版本

hadoop fs //文件系统客户端.

hadoop jar //

hadoop classpath

hadoop checknative

bin/hdfs

------------------------

dfs // === hadoop fs

classpath

namenode -format

secondarynamenode

namenode

journalnode

zkfc

datanode

dfsadmin

haadmin

fsck

balancer

jmxget

mover

oiv

oiv_legacy

oev

fetchdt

getconf

groups

snapshotDiff

lsSnapshottableDir

portmap

nfs3

cacheadmin

crypto

storagepolicies

version

hdfs常用命令

--------------------

hdfs dfs -ls / (查看文件系统列表)

$>hdfs dfs -mkdir /usr/local/hadoop/ (创建目录)

$>hdfs dfs -ls -r /usr/local/hadoop/ (查看)

$>hdfs dfs -lsr /usr/local/hadoop/(递归查看)

$>hdfs dfs -put jdk-8u191-linux-x64.tar.gz /usr/local/hadoop/ (复制文件)

$>hdfs dfs -get /usr/local/hadoop/ xxxx (获取文件)

$>hdfs dfs -rm -r -f /usr/local/hadoop/ (删除)

no route

--------------------

关闭防火墙。

$>su root

$>xcall.sh "service firewalld stop"

$>xcall.sh "systemctl disable firewalld"

hdfs

--------------------

500G

1024G = 2T/4T

切割。

寻址时间:10ms左右

磁盘速率 : 100M /s

64M

128M //让寻址时间占用读取时间的1%.

1ms

1 / 100

size = 181260798

block-0 : 134217728

block-1 : 47043070

--------------------

b0.no : 1073741829

b1.no : 1073741830

HA

-----------------------

high availability,高可用性。通常用几个9衡量。

99.999%

SPOF:

-----------------------

single point of failure,单点故障。解决:多配置节点至少两个

secondarynamenode 辅助名称节点 (定期抓取名称节点数据 不高可用)

----------------------

HDFS

找到所有的配置文件

----------------------

1.tar开hadoop-2.7.3.tar.gz

hadoop-2.7.3\share\hadoop\common\hadoop-common-2.7.3.jar\core-default.xml

hadoop-2.7.3\share\hadoop\hdfs\hadoop-hdfs-2.7.3.jar\hdfs-default.xml

hadoop-2.7.3\share\hadoop\mapreduce\hadoop-mapreduce-client-core-2.7.3.jar\mapred-default.xml

hadoop-2.7.3\share\hadoop\yarn\hadoop-yarn-common-2.7.3.jar\yarn-site.xml

本地模式

-----------

[core-site.xml]

fs.defaultFS=file:/// //默认值

配置hadoop临时目录

---------------------

1.配置[core-site.xml]文件

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://s129/</value>

</property>

<!--- 配置新的本地目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/hadoop</value>

</property>

</configuration>

//以下属性均由hadoop.tmp.dir决定,在hdfs-site.xml文件中配置。

dfs.namenode.name.dir=file://${hadoop.tmp.dir}/dfs/name

dfs.datanode.data.dir=file://${hadoop.tmp.dir}/dfs/data

dfs.datanode.data.dir=file://${hadoop.tmp.dir}/dfs/data

dfs.namenode.checkpoint.dir=file://${hadoop.tmp.dir}/dfs/namesecondary

dfs.namenode.checkpoint.dir=file://${hadoop.tmp.dir}/dfs/namesecondary

2.分发core-site.xml文件

$>xsync core-site.xml

3.格式化文件系统,只对namenode的本地目录进行初始化。

$>hadoop namenode -format //hdfs namenode -format

4.启动hadoop

$>start-dfs.sh

使用xcall.sh在所有节点上创建jps符号连接,指向/soft/jdk/bin/jps

------------------------------------------------------------------

1.切换到root用户

$>su root

2.创建符号连接

$>xcall.sh "ln -sfT /soft/jdk/bin/jps /usr/local/bin/jps"

3.修改jps符号连接的owner

$>xcall.sh "chown -h centos:centos /usr/local/bin/jps"

4.查看所有主机上的java进程

$>xcall.sh jps

在centos桌面版中安装eclipse 在虚拟机中编写代码

----------------------------

1.下载eclipse linux版

eclipse-jee-mars-R-linux-gtk-x86_64.tar.gz

2.tar开到/soft下,

$>tar -xzvf eclipse-jee-mars-R-linux-gtk-x86_64.tar.gz -C /soft

3.启动eclipse

$>cd /soft/eclipse

$>./eclipse & //后台启动

4.创建桌面快捷方式

$>ln -s /soft/eclipse/eclipse ~/Desktop/eclipse

5.

hadoop 完全分布式搭建总结的更多相关文章

- hadoop完全分布式搭建HA(高可用)

2018年03月25日 16:25:26 D调的Stanley 阅读数:2725 标签: hadoop HAssh免密登录hdfs HA配置hadoop完全分布式搭建zookeeper 配置 更多 个 ...

- 超详细解说Hadoop伪分布式搭建--实战验证【转】

超详细解说Hadoop伪分布式搭建 原文http://www.tuicool.com/articles/NBvMv2原原文 http://wojiaobaoshanyinong.iteye.com/b ...

- 3.hadoop完全分布式搭建

3.Hadoop完全分布式搭建 1.完全分布式搭建 配置 #cd /soft/hadoop/etc/ #mv hadoop local #cp -r local full #ln -s full ha ...

- Hadoop伪分布式搭建(一)

下面内容主要说明在Windows虚拟机上面,怎么搭建一个Hadoop伪分布式,并如何运行wordcount程序和网页查看HDFS文件系统. 1 相关软件下载和安装 APACH官网提供hadoop版本 ...

- Hadoop伪分布式搭建步骤

说明: 搭建环境是VMware10下用的是Linux CENTOS 32位,Hadoop:hadoop-2.4.1 JAVA :jdk7 32位:本文是本人在网络上收集的HADOOP系列视频所附带的 ...

- Hadoop 完全分布式搭建

搭建环境 https://www.cnblogs.com/YuanWeiBlogger/p/11456623.html 修改主机名------------------- 1./etc/hostname ...

- hadoop 伪分布式搭建

下载hadoop1.0.4版本,和jdk1.6版本或更高版本:1. 安装JDK,安装目录大家可以自定义,下面是我的安装目录: /usr/jdk1.6.0_22 配置环境变量: [root@hadoop ...

- Hadoop完全分布式搭建过程中遇到的问题小结

前一段时间,终于抽出了点时间,在自己本地机器上尝试搭建完全分布式Hadoop集群环境,也是借助网络上虾皮的Hadoop开发指南系列书籍一步步搭建起来的,在这里仅代表hadoop初学者向虾皮表示衷心的感 ...

- Hadoop完全分布式搭建流程

centos7 搭建完全分布式 Hadoop 环境 SSR 前言 本次教程是以先创建 四台虚拟机 为基础,再配置好一台虚拟机的情况下,直接复制文件到另外的虚拟机中(这样做大大简化了安装流程) 且本次 ...

- Hadoop伪分布式搭建CentOS

所需软件及版本: jdk-7u80-linux-x64.tar.gz hadoop-2.6.0.tar.gz 1.安装JDK Hadoop 在需在JDK下运行,注意JDK最好使用Oracle的否则可能 ...

随机推荐

- Vue基础学习 --- 全局组件与局部组件

组件分为 全局组件 局部组件 全局组件 // 语法---Vue.component('组件名', {组件参数}) Vue.component('com1', { template: '<butt ...

- Windows平台上运行Tomcat

从之前的学习中知道,可以调用Bootstrap类将Toomcat作为一个独立的应用程序来运行,在Windows平台上,可以调用startup.bat批处理文件来启动Tomcat,或运行shutdown ...

- Workstation 14 Returns EFI Network Start PXE over IPv4 When Installing New Win10 Guest O/S

当启动出现“Click any key to boot from DVD”时候,需要键盘点击一下,即可解决. 参考:https://communities.vmware.com/thread/5730 ...

- post请求头中常见content-type(非常重要)

定义和用法 enctype 属性规定在发送到服务器之前应该如何对表单数据进行编码.默认地,表单数据会编码为 "application/x-www-form-urlencoded". ...

- ADT中创建Android的Activity

去创建Activity New->Other->Android->Android Activity->BlankActivity: 输入对应的信息: 创建完毕后,可以看到新建了 ...

- 如何在 Linux 中更改 swappiness

交换空间是 RAM 内存已满时使用的硬盘的一部分.交换空间可以是专用交换分区或交换文件.当 Linux 系统耗尽物理内存时,非活动页面将从 RAM 移动到交换空间.Swappiness 是一个 Lin ...

- 从0开始学爬虫9之requests库的学习之环境搭建

从0开始学爬虫9之requests库的学习之环境搭建 Requests库的环境搭建 环境:python2.7.9版本 参考文档:http://2.python-requests.org/zh_CN/l ...

- Access与SQL中的IsNull(),IS NULL的区别

Access也有IsNull函数,但意义和参数却和T-SQL中的不同. 在T-SQL(也就是SQL Server所支持的SQL语言)中,IsNull的作用是把空值替代成指定的值.然而在Access中, ...

- rs-enumerate-devices data

realsense rs2::context ctx; auto devicelist = ctx.query_devices(); if (devicelist.size() > 0) { r ...

- Django中的QuerySet查询优化之prefetch_related

转载的,做个笔记,原文链接 在数据库有外键的时候,使用 select_related() 和 prefetch_related() 可以很好的减少数据库请求的次数,从而提高性能.本文通过一个简单的例子 ...