论文解读(SentiX)《SentiX: A Sentiment-Aware Pre-Trained Model for Cross-Domain Sentiment Analysis》

Note:[ wechat:Y466551 | 可加勿骚扰,付费咨询 ]

论文信息

论文标题:SentiX: A Sentiment-Aware Pre-Trained Model for Cross-Domain Sentiment Analysis

论文作者:Jie Zhou, Junfeng Tian, Rui Wang, Yuanbin Wu, Wenming Xiao, Liang He

论文来源:

论文地址:download

论文代码:download

视屏讲解:click

1 介绍

出发点:预先训练好的语言模型已被广泛应用于跨领域的 NLP 任务,如情绪分析,实现了最先进的性能。然而,由于用户在不同域间的情绪表达的多样性,在源域上对预先训练好的模型进行微调往往会过拟合,导致在目标域上的结果较差;

思路:通过大规模 review 数据集的领域不变情绪知识对情感软件语言模型(SENTIX)进行预训练,并将其用于跨领域情绪分析任务,而无需进行微调。本文提出了一些基于现有的标记和句子级别的词汇和注释的训练前任务,如表情符号、情感词汇和评级,而不受人为干扰。进行了一系列的实验,结果表明,该模型具有巨大的优势。

预训练模型在跨域情感分析上存在的问题:

- 现有的预训练模型侧重于通过自监督策略学习语义内容,而忽略了预训练短语的情绪特定知识;

- 在微调阶段,预训练好的模型可能会通过学习过多的特定领域的情绪知识而过拟合源域,从而导致目标域的性能下降;

贡献:

- 提出了 SENTIX 用于跨域情绪分类,以在大规模未标记的多域数据中学习丰富的域不变情绪知识;

- 在标记水平和句子水平上设计了几个预训练目标,通过掩蔽和预测来学习这种领域不变的情绪知识;

- 实验表明,SENTIX 获得了最先进的跨领域情绪分析的性能,并且比 BERT 需要更少的注释数据才能达到等效的性能;

2 方法

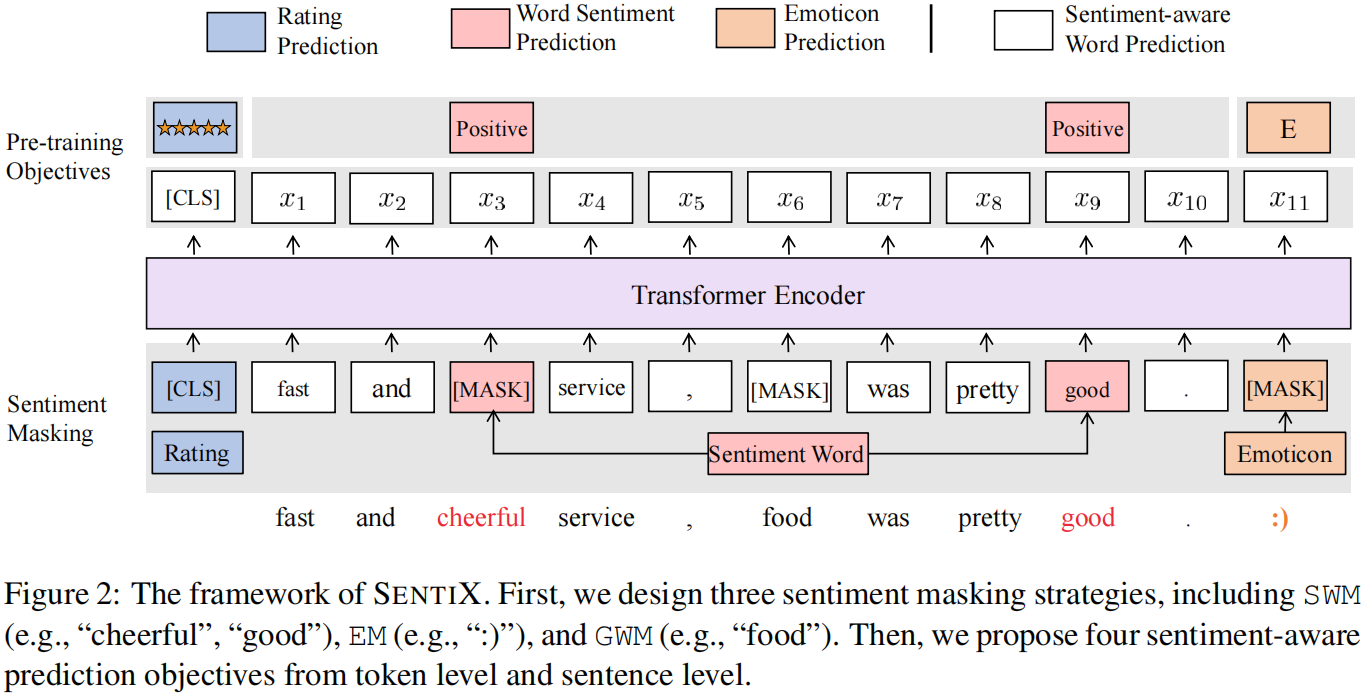

2.1 模型框架

2.2 Sentiment Masking

评论包含了许多半监督的情绪信号,如 情绪词汇、表情符号 和 评级,而大规模的评论数据可以从像 Yelp 这样的在线评论网站上获得。

- 情绪词汇(Sentiment Words):积极(P),消极(N),其他(0);

- 情感符(Emoticons):经常用于表示用户情感的特殊符号,如(“)”、“(”、“:”、“D”),本文选择语料库中经常出现的 100 个特殊符号作为情感符,并将其标记为 “E”,其他为 “0”;

- 评分(Rating):情绪评分分为 5 个等级;

策略:

- Sentiment Word Masking (SWM):为丰富情绪信息,用 30% 的比率掩盖了情绪词;

- Emoticon Masking (EM):由于一个句子中的表情符号数量相对较少,并且删除表情符号不会影响句子的语义信息,所以为每个句子屏蔽了 50% 的表情符号;

- General Word Masking (GWM):如果只关注情感词和表情符号,模型可能会失去其他单词的一般语义信息。因此,使用 [MASK] 并用 15% 的比率替换句子中的一般单词来学习语义信息;

2.3 Pre-training Objectives

$\mathcal{L}_{w}=-\frac{1}{|\hat{\mathcal{X}}|} \sum_{\hat{x} \in \hat{\mathcal{X}}} \frac{1}{|\hat{x}|} \sum_{i=1}^{|\hat{x}|} \log \left(P\left(\left|x_{i}\right| \hat{x}_{i}\right)\right)$

Word Sentiment Prediction (WSP)

根据情感知识,把词的情绪分为积极的、消极的和其他的。因此,设计了 WSP 来学习标记的情感知识。我们的目的是推断单词 $w_{i}$ 的情绪极性 $s_{i}$ 根据 $h_{i}$,$P\left(s_{i} \mid \hat{x_{i}}\right)= \operatorname{Softmax}\left(W_{s} \cdot h_{i}+b_{s}\right) $。这里使用交叉熵损失:

$\mathcal{L}_{s}=-\frac{1}{|\hat{\mathcal{X}}|} \sum_{\hat{x} \in \hat{\mathcal{X}}} \frac{1}{|\hat{x}|} \sum_{i=1}^{|\hat{x}|} \log \left(P\left(s_{i} \mid \hat{x}_{i}\right)\right)$

Rating Prediction (RP)

以上任务侧重于学习 Token 水平的情感知识。评级代表了句子级评论的情绪得分。推断评级将带来句子水平的情感知识。与BERT类似,使用最终状态 $h_{[\mathrm{CLS}]}$ 作为句子表示。该评级由 $P(r \mid \hat{x})=\operatorname{Softmax}\left(W_{r} \cdot h_{[C L S]}+b_{r}\right)$ 进行预测,并根据预测的评级分布计算损失:

$\mathcal{L}_{r}=-\frac{1}{|\hat{\mathcal{X}}|} \sum_{\hat{x} \in \hat{\mathcal{X}}} \log (P(r \mid \hat{x}))$

2.4 Joint Training

$\mathcal{L}=\mathcal{L}_{T}+\mathcal{L}_{S}$

其中:

$\mathcal{L}_{T}=\mathcal{L}_{w}+\mathcal{L}_{s}+\mathcal{L}_{e} $

$\mathcal{L}_{S}=\mathcal{L}_{r}$

3 实验

论文解读(SentiX)《SentiX: A Sentiment-Aware Pre-Trained Model for Cross-Domain Sentiment Analysis》的更多相关文章

- CVPR2020论文解读:三维语义分割3D Semantic Segmentation

CVPR2020论文解读:三维语义分割3D Semantic Segmentation xMUDA: Cross-Modal Unsupervised Domain Adaptation for 3 ...

- VLDB'22 HiEngine极致RTO论文解读

摘要:<Index Checkpoints for Instant Recovery in In-Memory Database Systems>是由华为云数据库创新Lab一作发表在数据库 ...

- itemKNN发展史----推荐系统的三篇重要的论文解读

itemKNN发展史----推荐系统的三篇重要的论文解读 本文用到的符号标识 1.Item-based CF 基本过程: 计算相似度矩阵 Cosine相似度 皮尔逊相似系数 参数聚合进行推荐 根据用户 ...

- CVPR2019 | Mask Scoring R-CNN 论文解读

Mask Scoring R-CNN CVPR2019 | Mask Scoring R-CNN 论文解读 作者 | 文永亮 研究方向 | 目标检测.GAN 推荐理由: 本文解读的是一篇发表于CVPR ...

- AAAI2019 | 基于区域分解集成的目标检测 论文解读

Object Detection based on Region Decomposition and Assembly AAAI2019 | 基于区域分解集成的目标检测 论文解读 作者 | 文永亮 学 ...

- Gaussian field consensus论文解读及MATLAB实现

Gaussian field consensus论文解读及MATLAB实现 作者:凯鲁嘎吉 - 博客园 http://www.cnblogs.com/kailugaji/ 一.Introduction ...

- zz扔掉anchor!真正的CenterNet——Objects as Points论文解读

首发于深度学习那些事 已关注写文章 扔掉anchor!真正的CenterNet——Objects as Points论文解读 OLDPAN 不明觉厉的人工智障程序员 关注他 JustDoIT 等 ...

- NIPS2018最佳论文解读:Neural Ordinary Differential Equations

NIPS2018最佳论文解读:Neural Ordinary Differential Equations 雷锋网2019-01-10 23:32 雷锋网 AI 科技评论按,不久前,NeurI ...

- [论文解读] 阿里DIEN整体代码结构

[论文解读] 阿里DIEN整体代码结构 目录 [论文解读] 阿里DIEN整体代码结构 0x00 摘要 0x01 文件简介 0x02 总体架构 0x03 总体代码 0x04 模型基类 4.1 基本逻辑 ...

- 【抓取】6-DOF GraspNet 论文解读

[抓取]6-DOF GraspNet 论文解读 [注]:本文地址:[抓取]6-DOF GraspNet 论文解读 若转载请于明显处标明出处. 前言 这篇关于生成抓取姿态的论文出自英伟达.我在读完该篇论 ...

随机推荐

- 2021-10-02:单词搜索。给定一个 m x n 二维字符网格 board 和一个字符串单词 word 。如果 word 存在于网格中,返回 true ;否则,返回 false 。单词必须按照字母

2021-10-02:单词搜索.给定一个 m x n 二维字符网格 board 和一个字符串单词 word .如果 word 存在于网格中,返回 true :否则,返回 false .单词必须按照字母 ...

- springboot 自动装配的原理

自动装配原理 问题就是为什么我们直接导入依赖就可以使用了,甚至不用配置web.xml,tomcat等,springboot内部是如何实现的? 主启动类上的注解@SpringBootApplicatio ...

- HTML转为PDF,图片导出失败的终极解决方案

如题项目有需求将一个页面导出为pdf,然而页面中的图片却始终无法导出成功 文章目录 一.导出的方法 二.初步测试的结果 三.使用f12查找原油 四.方案一 五.方案二 六.方案三 七.完整代码 1.使 ...

- weexplus真机调试

一.连接真机 C:\Users\Lenovo>adb devices List of devices attached C9K7N15722004375 device 确定连接无误,否则执行we ...

- GPT-4多态大模型研究

1.概述 GPT-4是OpenAI最新的系统,能够产生更安全和更有用的回应.它是一个大型的多模态模型(接受图像和文本输入,输出文本),在各种专业和学术的基准测试中展现了人类水平的表现.例如,它在模拟的 ...

- 前端开发如何更好的避免样式冲突?级联层(CSS@layer)

作者:vivo 互联网前端团队 - Zhang Jiqi 本文主要讲述了CSS中的级联层(CSS@layer),讨论了级联以及级联层的创建.嵌套.排序和浏览器支持情况.级联层可以用于避免样式冲突,提高 ...

- Windows/Linux 下功能强大的桌面截图软件

说到桌面截图软件,很多人首先想到的是 QQ 自带的截图,或者更高级功能更强大的 Snipaste 截图工具. 独立版本的 QQ 截图至少我目前没找到官方正式的下载链接,默认需要安装和打开 QQ 才能使 ...

- 10 款 VS Code 插件神器,第 7 款超级实用!

VS Code 是这两年非常热门的一款 IDE,它不仅有提升开发体验的界面.轻量化的编辑器,还有丰富而强大的插件,这些优秀的插件使得 VS Code 生态体系更加吸引人,让开发效率大大提升.本文来介绍 ...

- [ARM汇编]计算机原理与数制基础—1.1.1计算机的基本原理

计算机是一种能够根据指令集自动.高速处理数据的现代化设备.它的基本原理可以总结为:输入.存储.处理和输出数据.接下来,我们将详细介绍这些基本原理. 输入 计算机通过输入设备(如键盘.鼠标等)接收外部数 ...

- GPT3的技术突破:实现更准确、更真实的语言生成

目录 1. 引言 2. 技术原理及概念 3. 实现步骤与流程 4. 应用示例与代码实现讲解 5. 优化与改进 6. 结论与展望 7. 附录:常见问题与解答 GPT-3 技术突破:实现更准确.更真实的语 ...