Python爬虫知识点四--scrapy框架

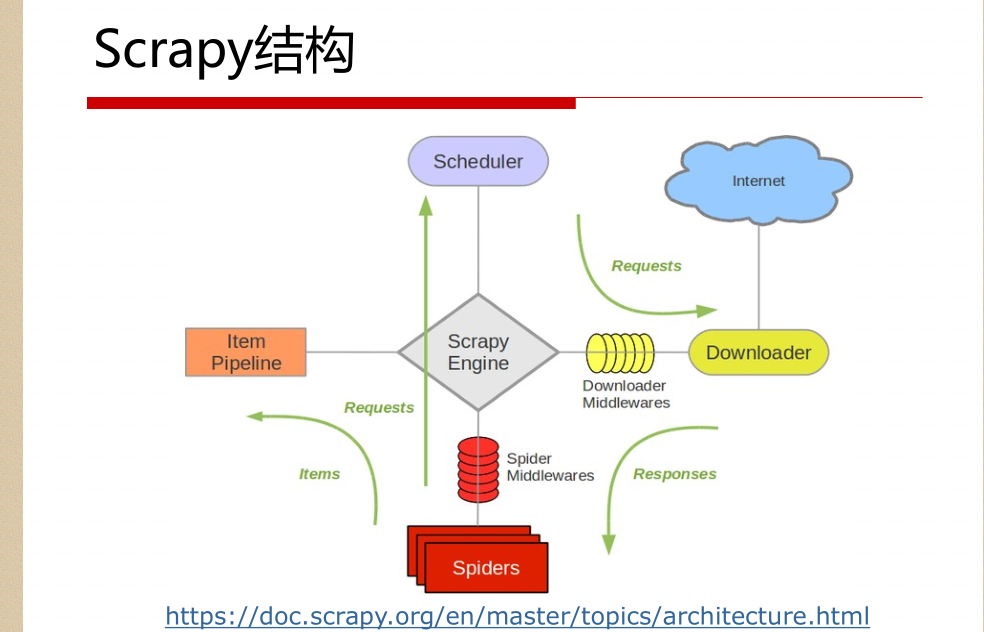

一。scrapy结构数据

解释:

1.名词解析:

o 引擎(Scrapy Engine)

o 调度器(Scheduler)

o 下载器(Downloader)

o 蜘蛛(Spiders)

o 项目管道(Item Pipeline)

o 下载器中间件(Downloader Middlewares)

o 蜘蛛中间件(Spider Middlewares)

o 调度中间件(Scheduler Middlewares)

2.具体解析

绿线是数据流向

从初始URL开始,Scheduler会将其交给Downloader进

行下载

下载之后会交给Spider进行分析

Spider分析出来的结果有两种

一种是需要进一步抓取的链接,如 “下一页”的链接,它们

会被传回Scheduler;另一种是需要保存的数据,它们被送到Item Pipeline里,进行

后期处理(详细分析、过滤、存储等)。

在数据流动的通道里还可以安装各种中间件,进行必

要的处理。

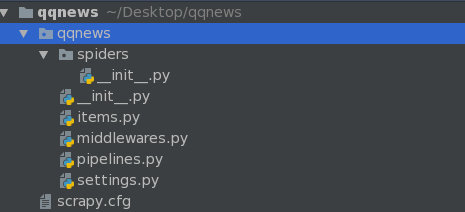

二。初始化爬虫框架 Scrapy

命令: scrapy startproject qqnews

ps:真正的项目是在spiders里面写入的

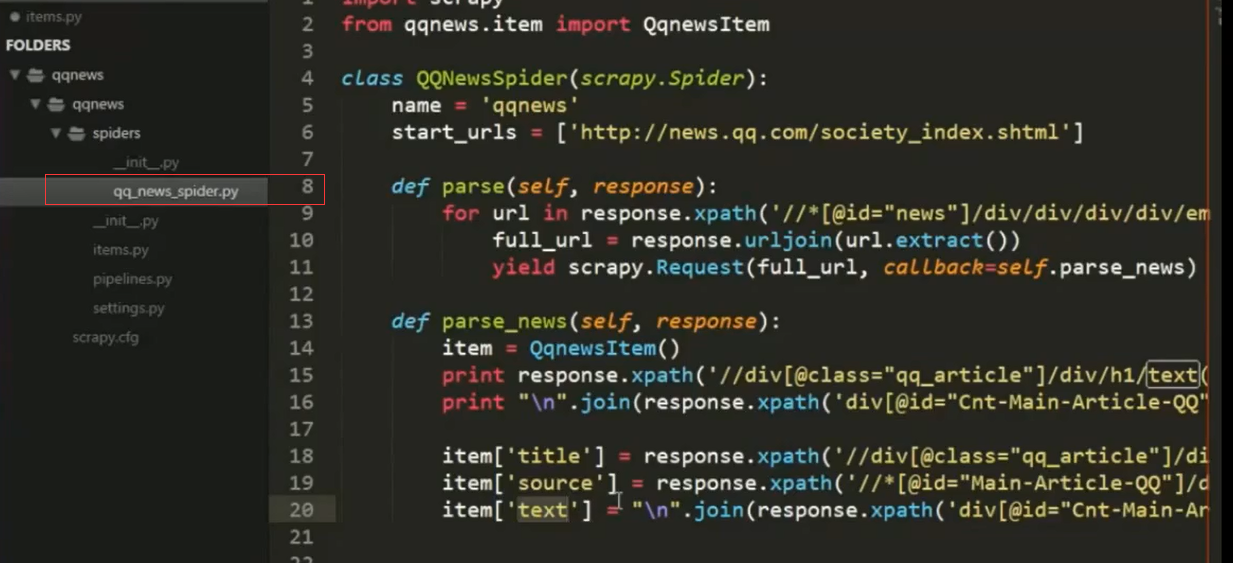

三。scrapy组件spider

爬取流程

1. 先初始化请求URL列表,并指定下载后处

理response的回调函数。

2. 在parse回调中解析response并返回字典,Item

对象,Request对象或它们的迭代对象。

3 .在回调函数里面,使用选择器解析页面内容

,并生成解析后的结果Item。

4. 最后返回的这些Item通常会被持久化到数据库

中(使用Item Pipeline)或者使用Feed exports将

其保存到文件中。

标准项目结构实例:

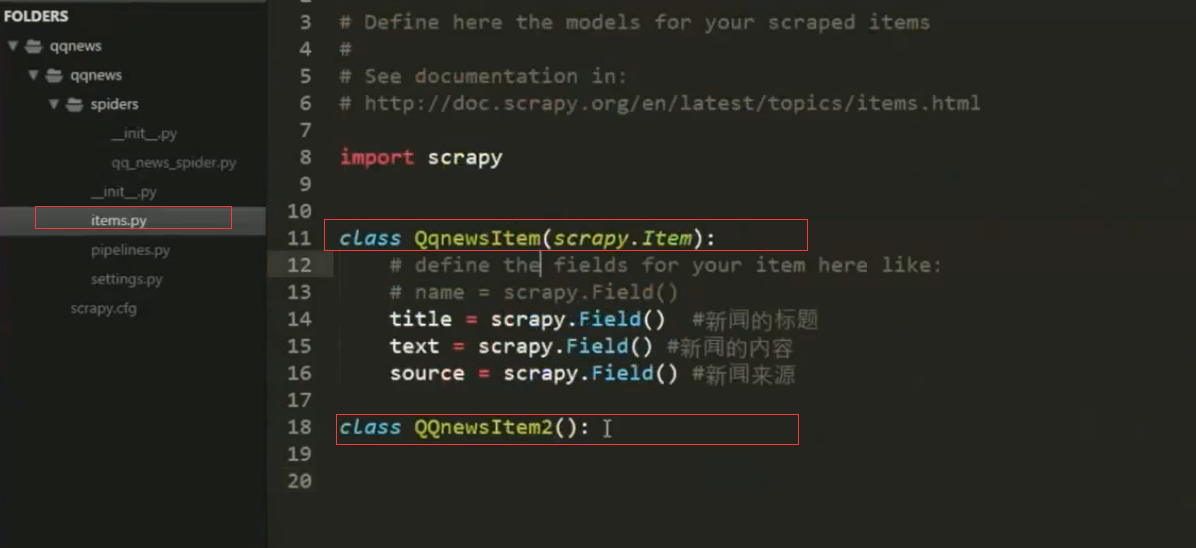

1.items结构:定义变量,根据不同种数据结构定义

2.spider结构中引入item里面,并作填充item

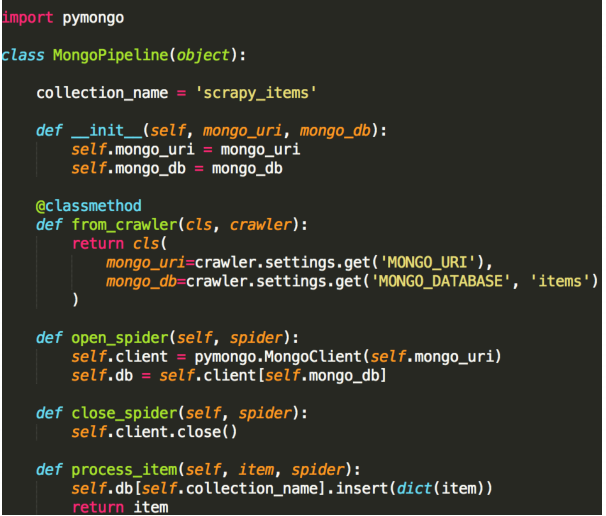

3。pipline去清洗,验证,存入数据库,过滤等等 后续处理

Item Pipeline常用场景

清理HTML数据

验证被抓取的数据(检查item是否包含某些字段)

重复性检查(然后丢弃)

将抓取的数据存储到数据库中

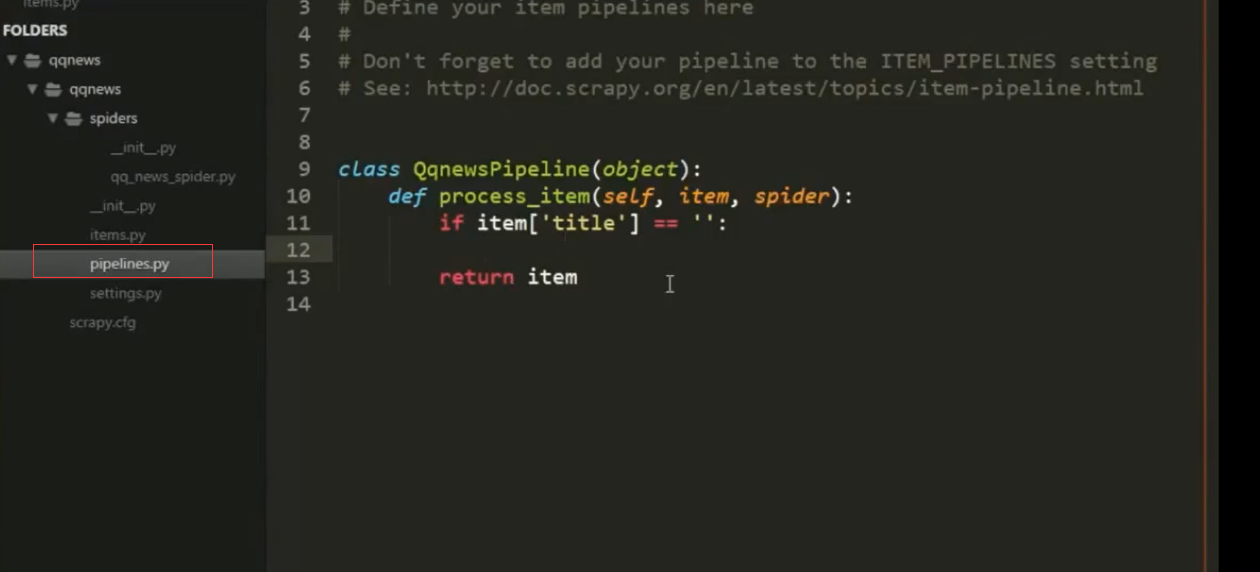

4.Scrapy组件Item Pipeline

经常会实现以下的方法:

open_spider(self, spider) 蜘蛛打开的时执行

close_spider(self, spider) 蜘蛛关闭时执行

from_crawler(cls, crawler) 可访问核心组件比如配置和

信号,并注册钩子函数到Scrapy中

pipeline真正处理逻辑

定义一个Python类,实现方法process_item(self, item,

spider)即可,返回一个字典或Item,或者抛出DropItem

异常丢弃这个Item。

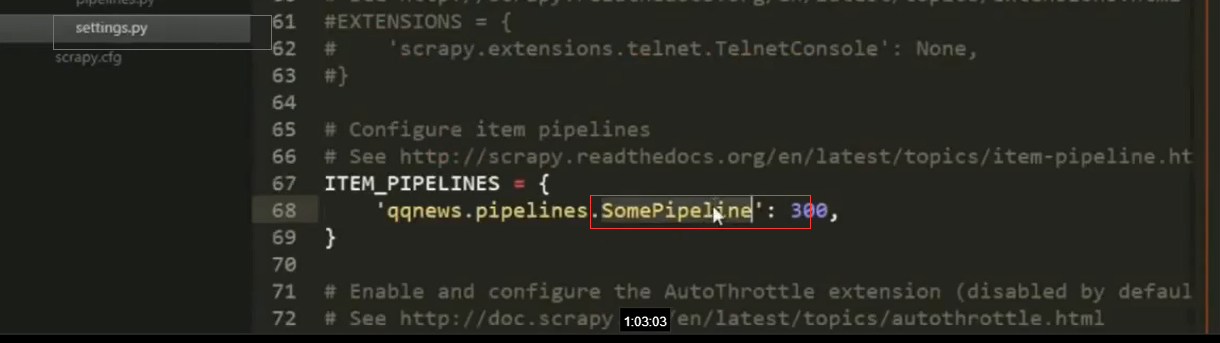

5.settings中定义哪种类型的pipeline

持续更新中。。。。,欢迎大家关注我的公众号LHWorld.

Python爬虫知识点四--scrapy框架的更多相关文章

- Python爬虫进阶之Scrapy框架安装配置

Python爬虫进阶之Scrapy框架安装配置 初级的爬虫我们利用urllib和urllib2库以及正则表达式就可以完成了,不过还有更加强大的工具,爬虫框架Scrapy,这安装过程也是煞费苦心哪,在此 ...

- python爬虫入门(六) Scrapy框架之原理介绍

Scrapy框架 Scrapy简介 Scrapy是用纯Python实现一个为了爬取网站数据.提取结构性数据而编写的应用框架,用途非常广泛. 框架的力量,用户只需要定制开发几个模块就可以轻松的实现一个爬 ...

- 零基础写python爬虫之使用Scrapy框架编写爬虫

网络爬虫,是在网上进行数据抓取的程序,使用它能够抓取特定网页的HTML数据.虽然我们利用一些库开发一个爬虫程序,但是使用框架可以大大提高效率,缩短开发时间.Scrapy是一个使用Python编写的,轻 ...

- python爬虫学习之Scrapy框架的工作原理

一.Scrapy简介 Scrapy是一个为了爬取网站数据,提取结构性数据而编写的应用框架. 可以应用在包括数据挖掘,信息处理或存储历史数据等一系列的程序中. 其最初是为了 页面抓取 (更确切来说, 网 ...

- PYTHON 爬虫笔记十一:Scrapy框架的基本使用

Scrapy框架详解及其基本使用 scrapy框架原理 Scrapy是一个为了爬取网站数据,提取结构性数据而编写的应用框架. 其可以应用在数据挖掘,信息处理或存储历史数据等一系列的程序中.其最初是为了 ...

- python 爬虫相关含Scrapy框架

1.从酷狗网站爬取 新歌首发的新歌名字.播放时长.链接等 from bs4 import BeautifulSoup as BS import requests import re import js ...

- 芝麻HTTP:Python爬虫进阶之Scrapy框架安装配置

初级的爬虫我们利用urllib和urllib2库以及正则表达式就可以完成了,不过还有更加强大的工具,爬虫框架Scrapy,这安装过程也是煞费苦心哪,在此整理如下. Windows 平台: 我的系统是 ...

- 【Python爬虫实战】Scrapy框架的安装 搬运工亲测有效

windows下亲测有效 http://blog.csdn.net/liuweiyuxiang/article/details/68929999这个我们只是正确操作步骤详解的搬运工

- 第三百三十四节,web爬虫讲解2—Scrapy框架爬虫—Scrapy爬取百度新闻,爬取Ajax动态生成的信息

第三百三十四节,web爬虫讲解2—Scrapy框架爬虫—Scrapy爬取百度新闻,爬取Ajax动态生成的信息 crapy爬取百度新闻,爬取Ajax动态生成的信息,抓取百度新闻首页的新闻rul地址 有多 ...

随机推荐

- 常用Linux操作命令

查看物理CPU个数:cat /proc/cpuinfo| grep "physical id"| sort| uniq| wc -l 查看每个物理CPU中的核数:cat /proc ...

- C 指针的几个注意点

1.静态指针在初始化时必须使用编译时可以确定地址表达式完成赋值,如 static int a; static int* pa = &a;//初始化时必须使用可以确定地址的表达式 int b; ...

- [Java第一课]环境变量的配置以及eclipse一些常用快捷键

1.环境变量的配置(这里对xp系统电脑来说:) 首先安装jdk软件. 然后在我的电脑(右键)-->属性-->高级-->环境变量-->系统变量(注意)-->新建(新建两个p ...

- Vue2.0 v-for 中 :key 到底有什么用?

其实不只是vue,react中在执行列表渲染时也会要求给每个组件添加上key这个属性. 要解释key的作用,不得不先介绍一下虚拟DOM的Diff算法了. 我们知道,vue和react都实现了一套虚拟D ...

- PHP设计模式三:原型设计模式

一.什么是原型设计模式 原型设计模式使用一种克隆技术来复制实例化的对象,新对象是通过复制原型实例创建的.原型设计模式的目的是通过使用克隆以减少 实例化对象的开销. 在原型设计模式中,Client类是不 ...

- LeetCode 561. Array Partition I (数组分隔之一)

Given an array of 2n integers, your task is to group these integers into n pairs of integer, say (a1 ...

- iOS下OpenCV开发用OC还是Swift

本文为作者原创,转载请注明出处(http://www.cnblogs.com/mar-q/)by 负赑屃 其实标题中这个问题并不准确,准确的说法应该是iOS下的OpenCV开发是使用OC还是Swift ...

- 使用OpenCV训练Haar like+Adaboost分类器的常见问题

<FAQ:OpenCV Haartraining>——使用OpenCV训练Haar like+Adaboost分类器的常见问题 最近使用OpenCV训练Haar like+Adaboost ...

- struts2(二)之配置文件详解与结果视图

前言 前面介绍了struts2的一个程序的大概流程,还有它的配置文件. 一.struts.xml文件元素详解 1.1.package元素 1)作用 在struts2的配置文件中引入了面向对象思想,使用 ...

- linux GCC 编译多个.c/.h文件

基本认识: #include <xxx>:首先去系统目录中找头文件,如果没有在到当前目录下找.像标准的头文件 stdio.h.stdlib.h等用这个方法. #include " ...