大数据学习——spark学习

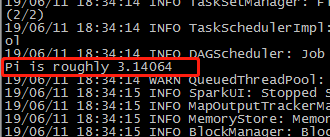

计算圆周率

[root@mini1 bin]# ./run-example SparkPi

[root@mini1 bin]# ./run-example SparkPi

[root@mini1 bin]# ./run-example SparkPi

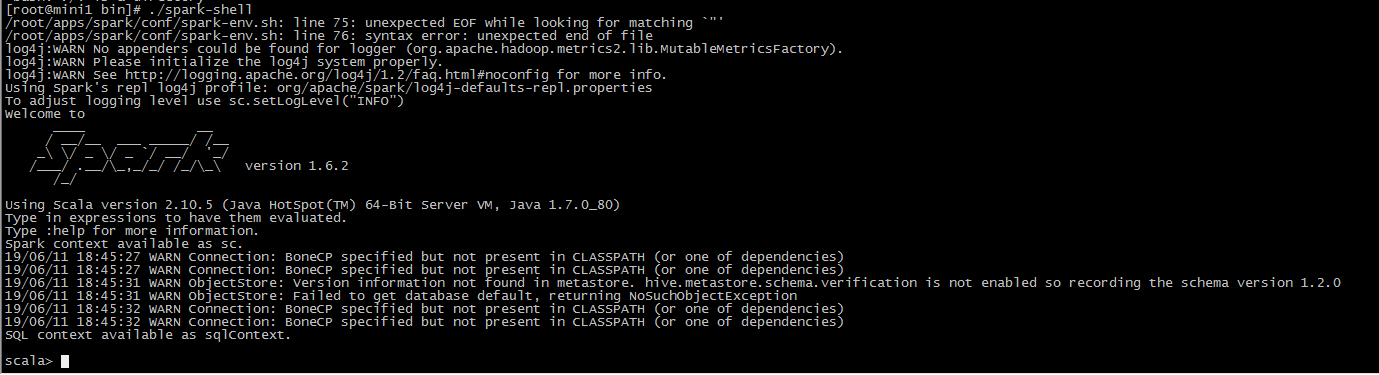

运行spark-shell的两种方式:

1直接运行spark-shell

单机通过多线程跑任务,只运行一个进程叫submit

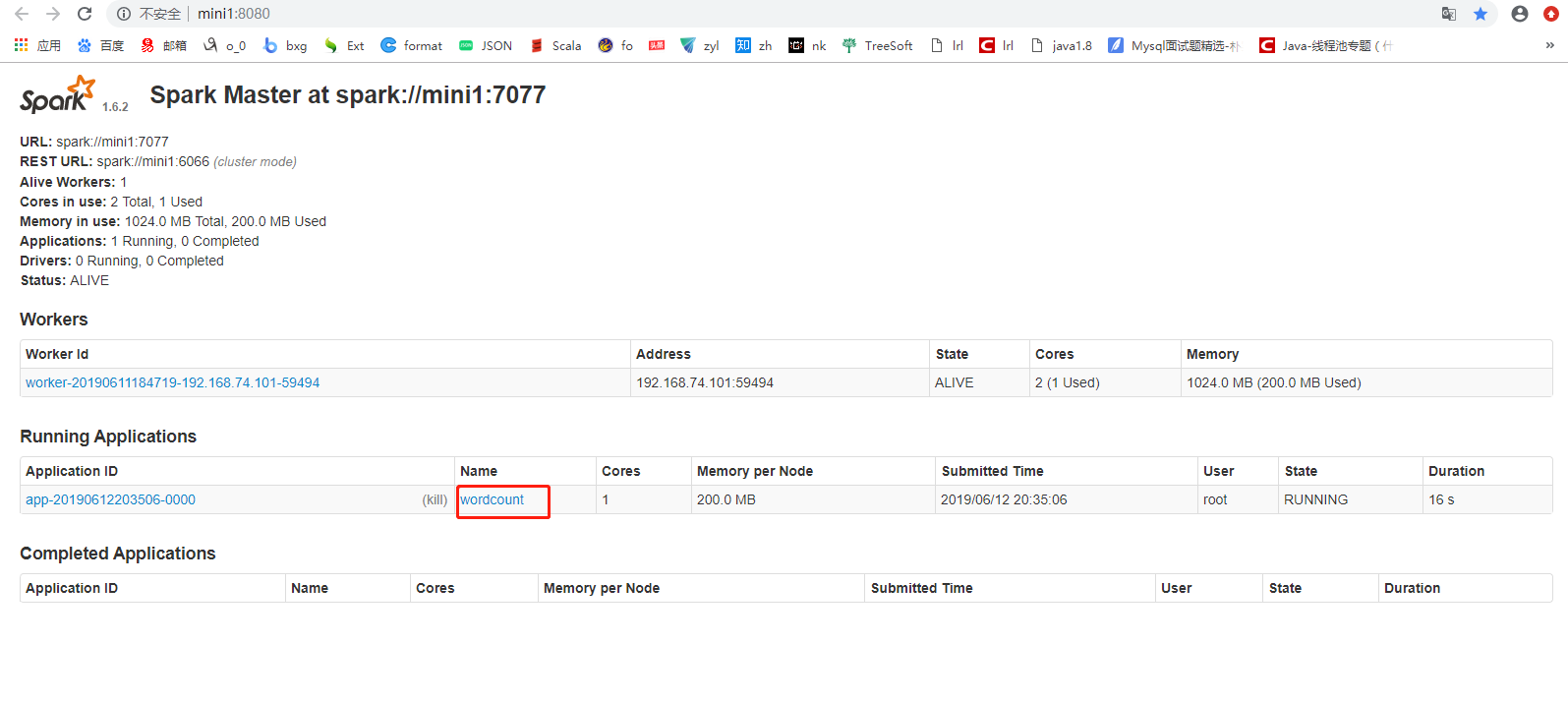

2运行spark-shell --master spark://mini1:7077

将任务运行在集群中,运行submit在master上,运行executor在worker上

启动

[root@mini1 bin]# ./spark-shell

hdfs

hadoop/sbin/start-dfs.sh

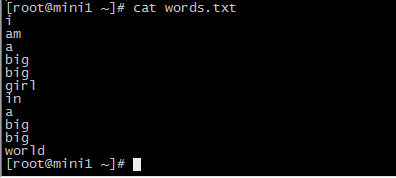

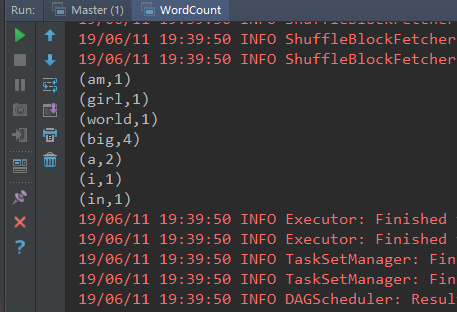

计算wordcount

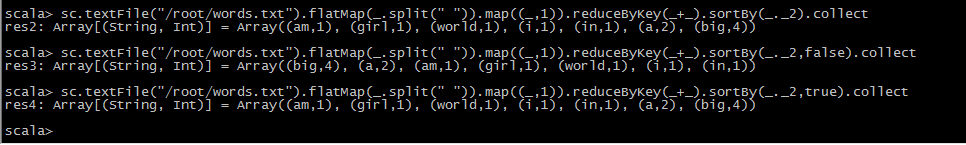

sc.textFile("/root/words.txt").flatMap(_.split(" ")).map((_,)).reduceByKey(_+_).collect

升序,降序排列

mapReduce执行流程

从hdfs采集数据

上传文件 hdfs dfs -put words.txt /

sc.textFile("hdfs://mini1:9000/words.txt").flatMap(_.split(" ")).map((_,)).reduceByKey(_+_).sortBy(_._2,false).collect

通过spark的api写wordcount

本地运行

import org.apache.spark.rdd.RDD

import org.apache.spark.{SparkConf, SparkContext} /**

* Created by Administrator on 2019/6/11.

*/

object WordCount extends App {

//创建conf,设置应用的名字和运行的方式,local[2]运行2线程,产生两个文件结果 val conf = new SparkConf().setAppName("wordcount").setMaster("local[2]") //创建sparkcontext

val sc = new SparkContext(conf) val file: RDD[String] = sc.textFile("hdfs://mini1:9000/words.txt")

val words: RDD[String] = file.flatMap(_.split(" "))

//压平,分割每一行数据为每个单词

val tuple: RDD[(String, Int)] = words.map((_, 1))

//将单词转换为(单词,1)

val result: RDD[(String, Int)] = tuple.reduceByKey(_ + _)

//将相同的key进行汇总聚合

val resultSort: RDD[(String, Int)] = result.sortBy(_._2, false) //排序

// result.collect() //在命令行打印

resultSort.foreach(println) }

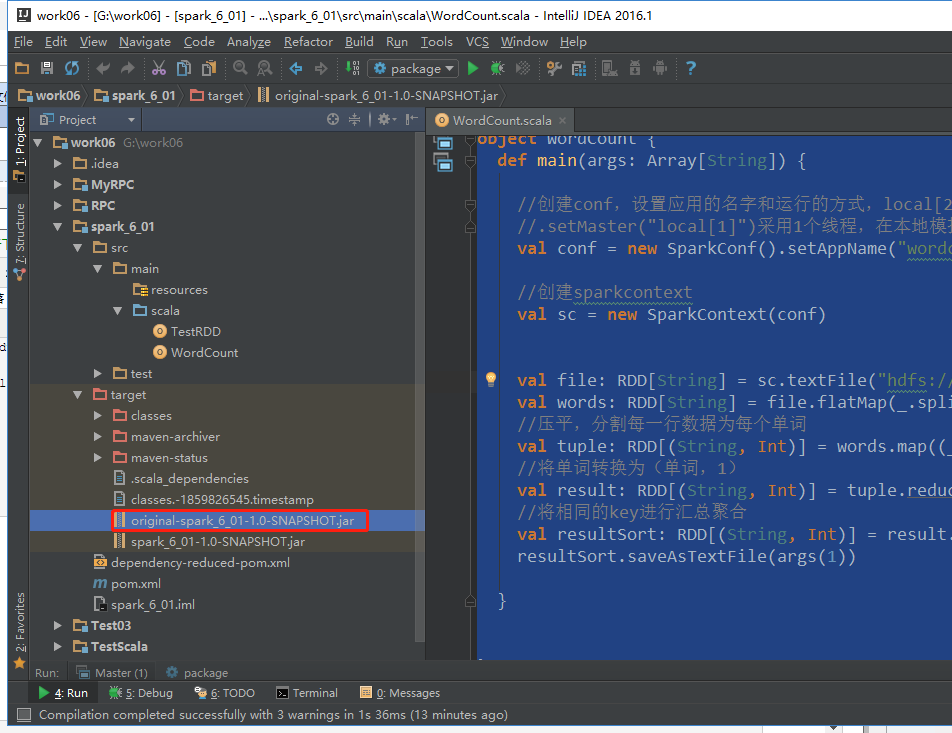

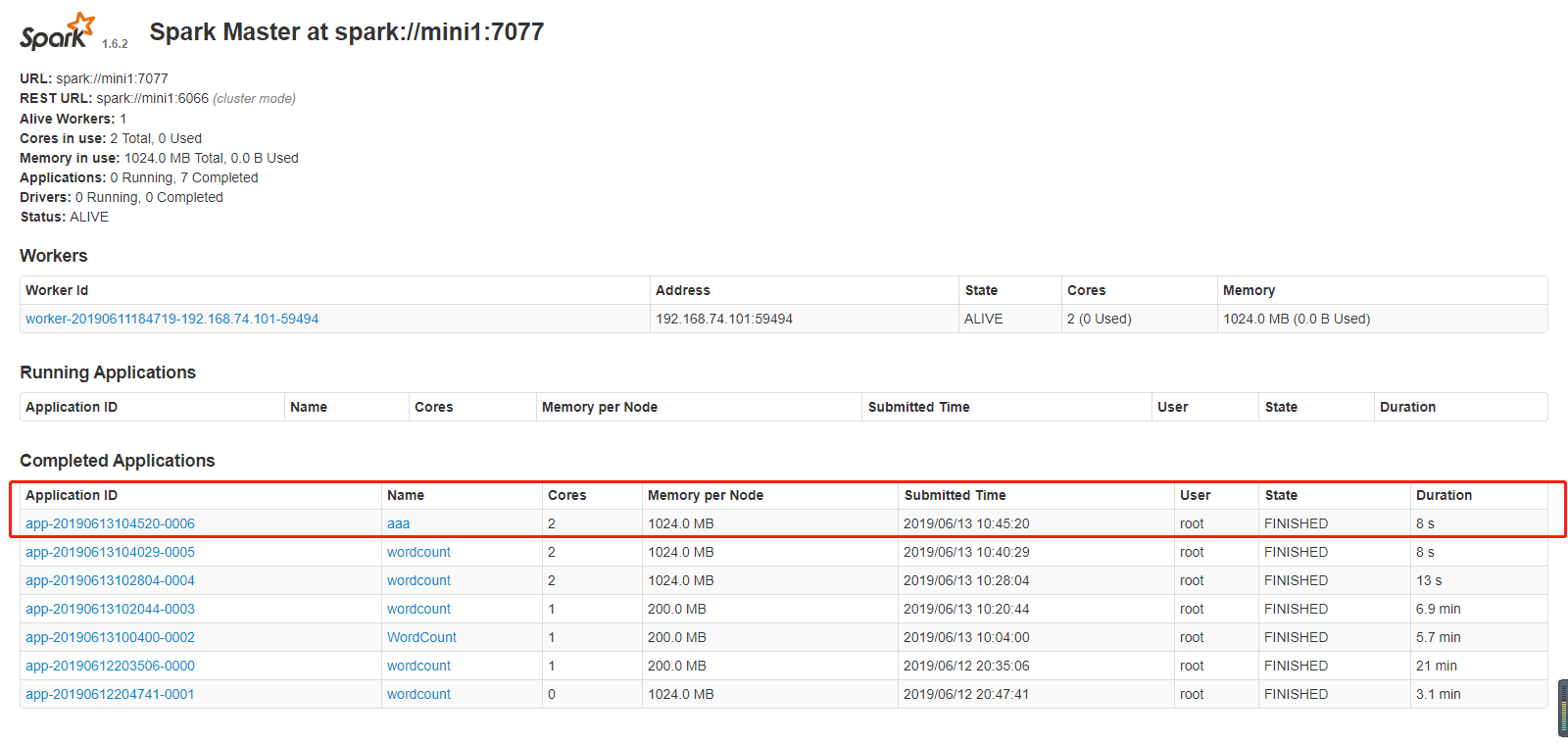

集群运行

import org.apache.spark.rdd.RDD

import org.apache.spark.{SparkConf, SparkContext} /**

* Created by Administrator on 2019/6/11.

*/

object WordCount {

def main(args: Array[String]) { //创建conf,设置应用的名字和运行的方式,local[2]运行2线程,产生两个文件结果

//.setMaster("local[1]")采用1个线程,在本地模拟spark运行模式

val conf = new SparkConf().setAppName("wordcount") //创建sparkcontext

val sc = new SparkContext(conf) val file: RDD[String] = sc.textFile("hdfs://mini1:9000/words.txt")

val words: RDD[String] = file.flatMap(_.split(" "))

//压平,分割每一行数据为每个单词

val tuple: RDD[(String, Int)] = words.map((_, 1))

//将单词转换为(单词,1)

val result: RDD[(String, Int)] = tuple.reduceByKey(_ + _)

//将相同的key进行汇总聚合

val resultSort: RDD[(String, Int)] = result.sortBy(_._2, false) //排序

resultSort.saveAsTextFile(args(1)) } }

打包

把该代码包传到任意一台装有spark的机器上

我上传到了bin下

提交

[root@mini1 bin]# ./spark-submit --help

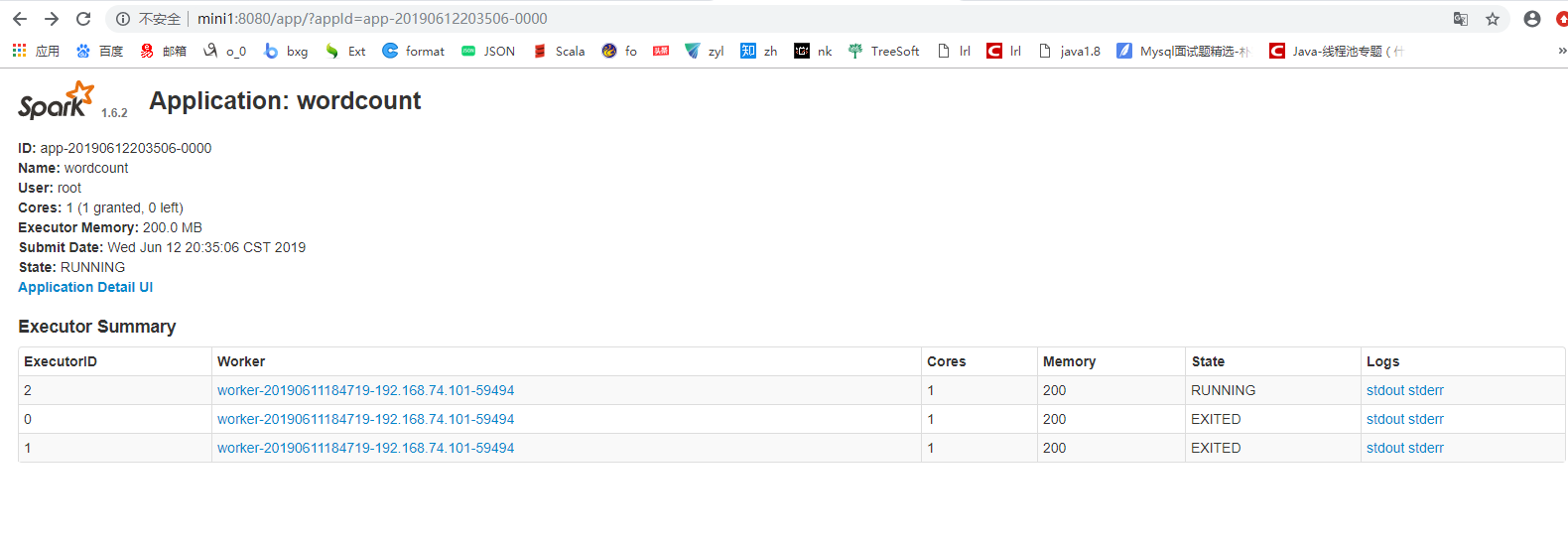

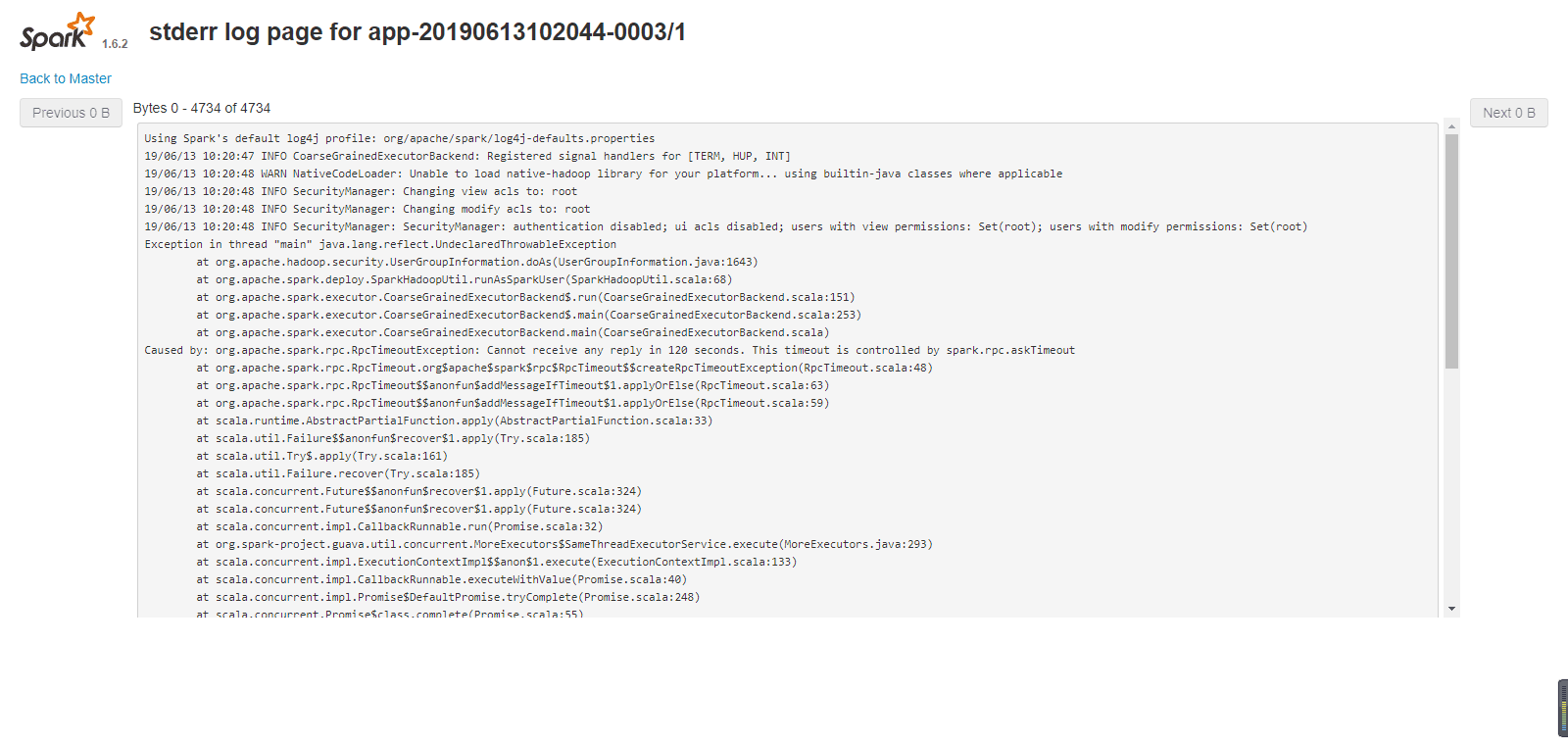

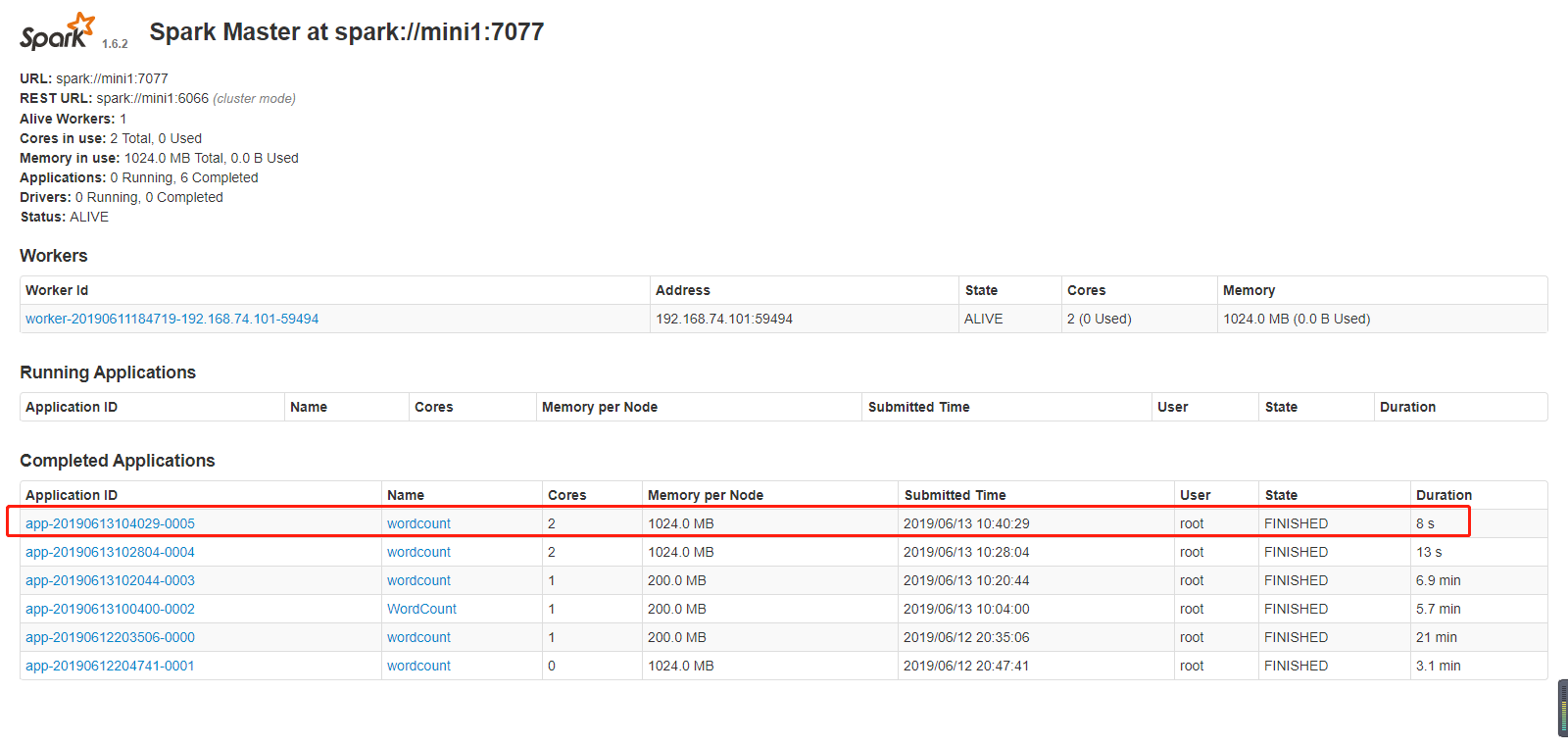

#开始加了这两个参数 导致一直运行失败,链接超时,还去问了初夏老师

[root@mini1 bin]# ./spark-submit --master spark://mini1:7077--class com.cyf.WordCount --executor-memory 200M --total-executor-cores 1 original-spark_6_01-1.0-SNAPSHOT.jar hdfs://mini1:9000/words.txt hdfs://mini1:9000/ceshi/wordcountcluster

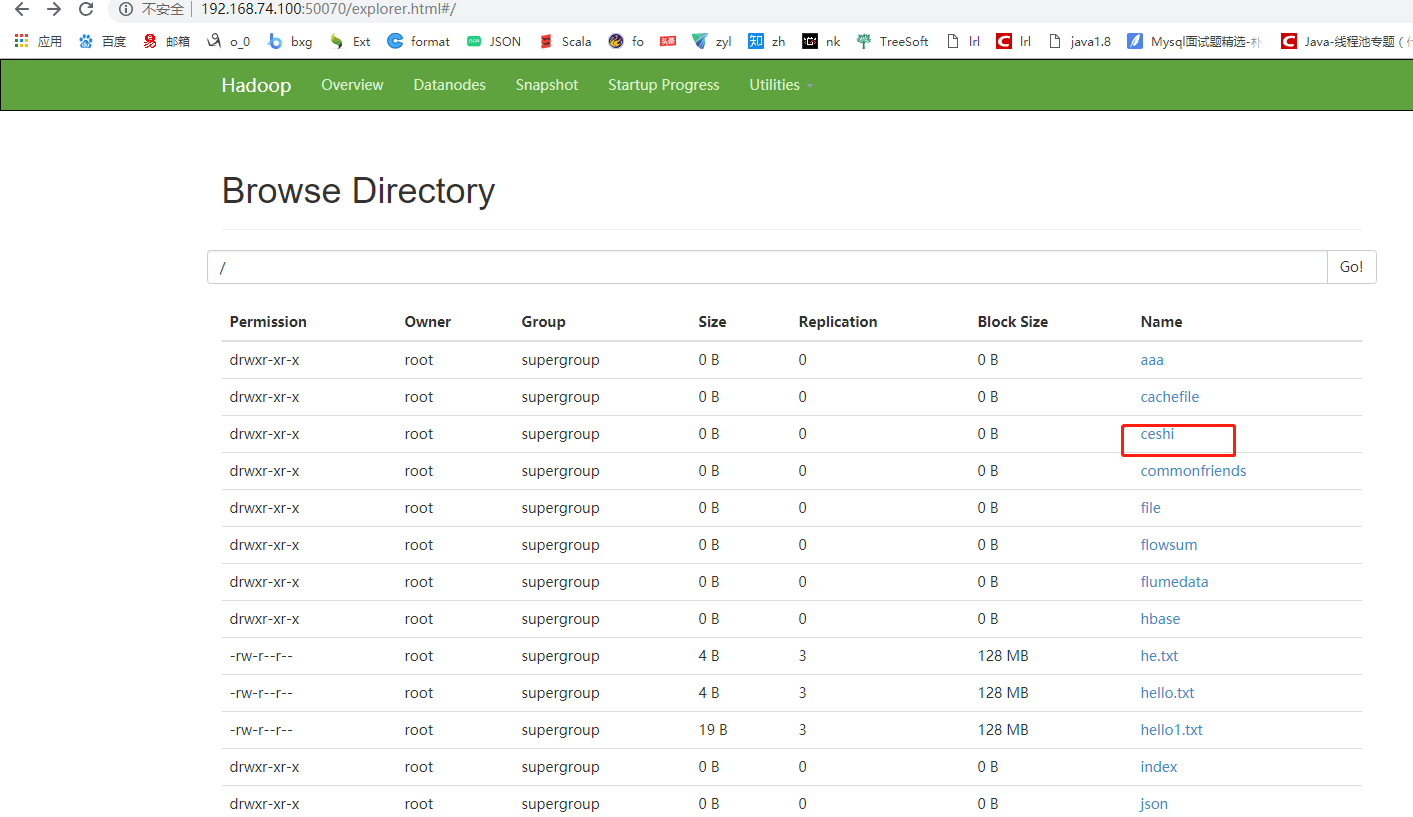

[root@mini1 bin]#./spark-submit --master spark://mini1:7077 --class com.cyf.WordCount original-spark_6_01-1.0-SNAPSHOT.jar hdfs://mini1:9000/words.txt hdfs://mini1:9000/ceshi/wordcountcluster

开始加上边两个参数运行,一直报连接超时的错误

后来把参数去掉,运行成功了

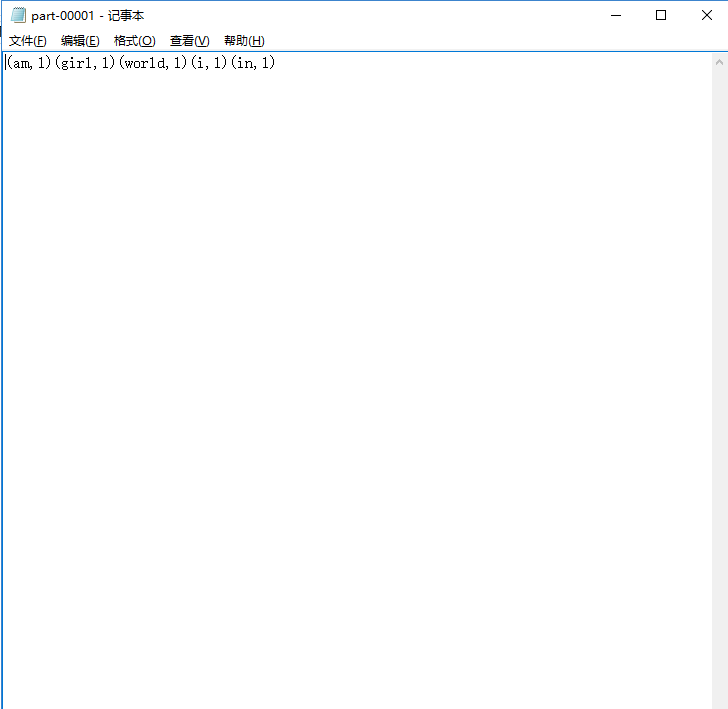

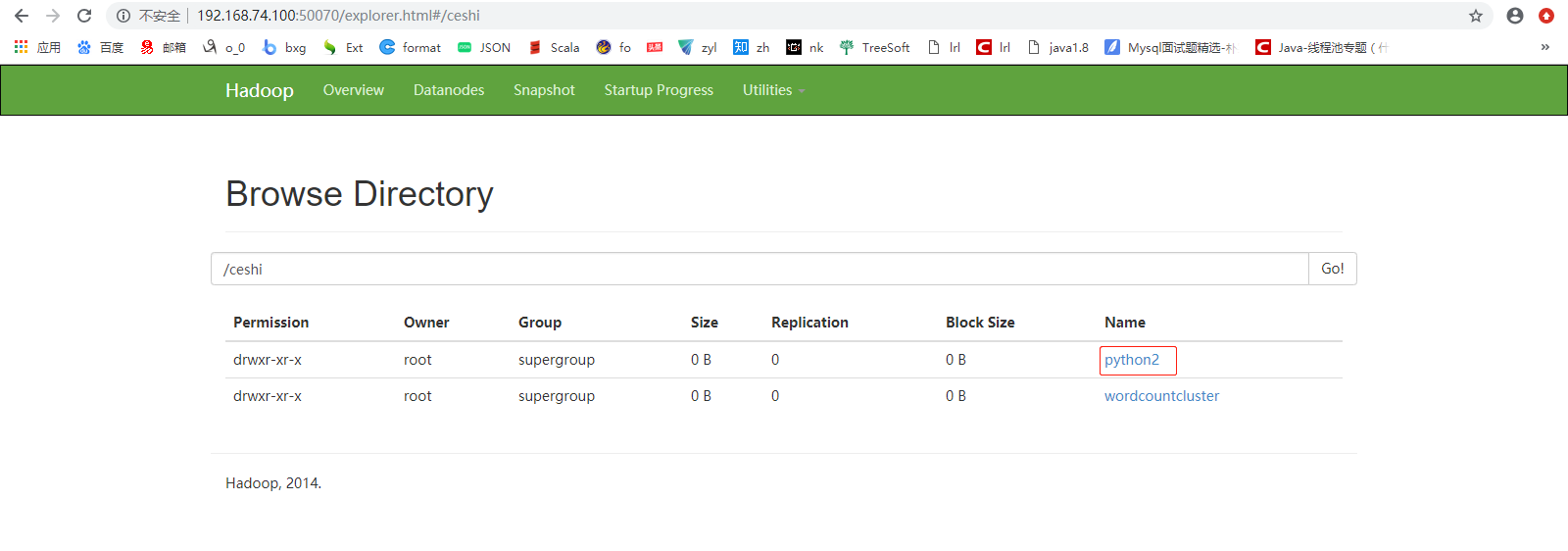

python

wo.py

#!/usr/bin/python

from pyspark import SparkContext, SparkConf

conf = SparkConf().setAppName("aaa").setMaster("spark://mini1:7077")

sc = SparkContext(conf=conf)

data = ["tom", "lilei", "tom", "lilei", "wangsf"]

rdd = sc.parallelize(data).map(lambda x: (x, )).reduceByKey(lambda a, b: a + b).saveAsTextFile("hdfs://mini1:9000/ceshi/python2")

上传,运行

[root@mini1 bin]# ./spark-submit wo.py

大数据学习——spark学习的更多相关文章

- 【福利】送Spark大数据平台视频学习资料

没有套路真的是送!! 大家都知道,大数据行业spark很重要,那话我就不多说了,贴心的大叔给你找了份spark的资料. 多啰嗦两句,一个好的程序猿的基本素养是学习能力和自驱力.视频给了你们,能不能 ...

- 【互动问答分享】第8期决胜云计算大数据时代Spark亚太研究院公益大讲堂

“决胜云计算大数据时代” Spark亚太研究院100期公益大讲堂 [第8期互动问答分享] Q1:spark线上用什么版本好? 建议从最低使用的Spark 1.0.0版本,Spark在1.0.0开始核心 ...

- 【互动问答分享】第15期决胜云计算大数据时代Spark亚太研究院公益大讲堂

"决胜云计算大数据时代" Spark亚太研究院100期公益大讲堂 [第15期互动问答分享] Q1:AppClient和worker.master之间的关系是什么? AppClien ...

- 【互动问答分享】第13期决胜云计算大数据时代Spark亚太研究院公益大讲堂

“决胜云计算大数据时代” Spark亚太研究院100期公益大讲堂 [第13期互动问答分享] Q1:tachyon+spark框架现在有很多大公司在使用吧? Yahoo!已经在长期大规模使用: 国内也有 ...

- 【互动问答分享】第10期决胜云计算大数据时代Spark亚太研究院公益大讲堂

“决胜云计算大数据时代” Spark亚太研究院100期公益大讲堂 [第10期互动问答分享] Q1:Spark on Yarn的运行方式是什么? Spark on Yarn的运行方式有两种:Client ...

- 【互动问答分享】第7期决胜云计算大数据时代Spark亚太研究院公益大讲堂

“决胜云计算大数据时代” Spark亚太研究院100期公益大讲堂 [第7期互动问答分享] Q1:Spark中的RDD到底是什么? RDD是Spark的核心抽象,可以把RDD看做“分布式函数编程语言”. ...

- 【互动问答分享】第6期决胜云计算大数据时代Spark亚太研究院公益大讲堂

“决胜云计算大数据时代” Spark亚太研究院100期公益大讲堂 [第6期互动问答分享] Q1:spark streaming 可以不同数据流 join吗? Spark Streaming不同的数据流 ...

- 【大数据】Hive学习笔记

第1章 Hive基本概念 1.1 什么是Hive Hive:由Facebook开源用于解决海量结构化日志的数据统计. Hive是基于Hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张表, ...

- 大数据-spark-hbase-hive等学习视频资料

不错的大数据spark学习资料,连接过期在评论区评论,再给你分享 https://pan.baidu.com/s/1ts6RNuFpsnc39tL3jetTkg

- 想转行大数据,开始学习 Hadoop?

学习大数据首先要了解大数据的学习路线,首先搞清楚先学什么,再学什么,大的学习框架知道了,剩下的就是一步一个脚印踏踏实实从最基础的开始学起. 这里给大家普及一下学习路线:hadoop生态圈——Strom ...

随机推荐

- wordpress安装后首页无法进入 The file 'wp-config.php' already exists

问题是缓存导致,具体还没研究是怎么产生的缓存.chrome浏览器解决方法: 1. 网址后面加参数进入网站 2. 打开控制台-network 3. 刷新页面 4. 控制台-network,右键请求的文件 ...

- Brackets安装angularjs插件

Brackets是Adobe公司研发的一款开源WEB前端开发框架,界面清爽简约,代码提示功能比较强大,而且支持第三方插件,其提供的插件库中有大量的对Brackets感兴趣的开发人员所开发的插件,使用者 ...

- cssText在js中写样式表兼容全部

oDiv.style.cssText="width:100px;height:200px;";是前面的升级版(oDiv.style.width='200px';) <styl ...

- hihoCoder #1165 : 益智游戏 (挑战赛11 B题)

题意:在一个序列中找到两个数a和b,使得a*b的因子个数最多,输出最多的因子个数. 思路:数据较多,处理会很慢.对序列中每个数字进行质数分解求因子个数,然后按照因子个数降序排列,对前50个因子最多的数 ...

- MovieReview—Despicable Me 3(神偷奶爸3)

Minions&Unicorn The film focuses on the story of Grew and the bastard Bled. A variety of ...

- UVA 11732 strcmp() Anyone (Trie+链表)

先两两比较,比较次数是两者相同的最长前缀长度*2+1,比较特殊的情况是两者完全相同时候比较次数是单词长度*2+2, 两个单词'末尾\0'和'\0'比较一次,s尾部'\0'和循环内'\0'比较一次. 因 ...

- 为管理复杂组件状态困扰?试试 vue 简单状态管理 Store 模式【转】

https://juejin.im/post/5cd50849f265da03a54c3877 在 vue 中,通信有几种形式: 父子组件 emit/on vuex 中共享 state 跨组件 Eve ...

- 1066: 输入n个数和输出调整后的n个数

1066: 输入n个数和输出调整后的n个数 Time Limit: 1 Sec Memory Limit: 128 MBSubmit: 2739 Solved: 1578[Submit][Stat ...

- 队列的add与offer的区别

两个方法都表示往队列里添加元素 但是当出现异常时,add方法抛出异常 而offer则返回的是false,就是啥事也没有,也不抛异常,也没有添加成功!

- linux简单常用命令

除了yum命令,还有些简单的命令,在此记录一下,加深记忆: free -h 查询内存和交换分区. rpm -qa | grep libaio 查看当前环境是否安装某rpm软件包