Coursera-AndrewNg(吴恩达)机器学习笔记——第二周编程作业

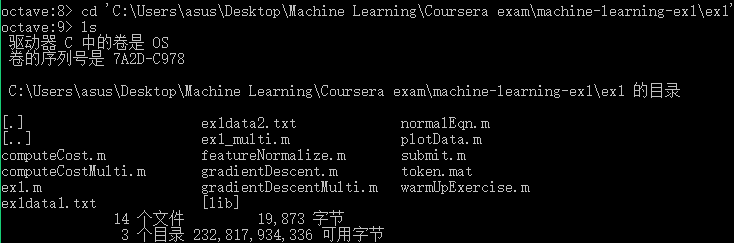

一.准备工作

- 从网站上将编程作业要求下载解压后,在Octave中使用cd命令将搜索目录移动到编程作业所在目录,然后使用ls命令检查是否移动正确。如:

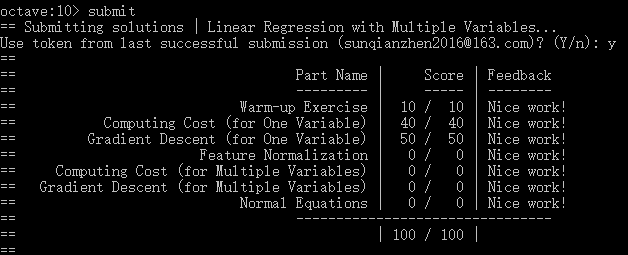

- 提交作业:提交时候需要使用自己的登录邮箱和提交令牌,如下:

二.单变量线性回归

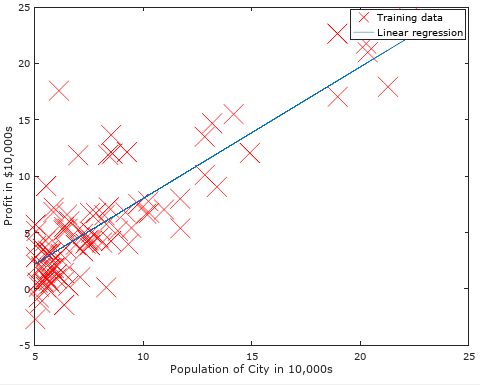

绘制图形:rx代表图形中标记的点为红色的x,数字10表示标记的大小。

plot(x, y, 'rx', 'MarkerSize', ); % Plot the data

计算代价函数(Cost Funtion):迭代次数1500,学习速率0.01. iterations = 1500; alpha = 0.01;

注意需给原始数据X添加一列值为1的属性:X = [ones(m, 1), data(:,1)]; theta = zeros(2, 1);

function J = computeCost(X, y, theta) %文件名为computeCost.m

m = length(y); % number of training examples

J = /(*m)*sum((X*theta-y).^);

end

梯度下降(Gradient Descent ):

function [theta, J_history] = gradientDescent(X, y, theta, alpha, num_iters) %文件名为gradientDescent.m

m = length(y); % number of training examples

J_history = zeros(num_iters, );

for iter = :num_iters

temp=X'*(X*theta-y);

theta=theta-/m*alpha*temp;

J_history(iter) = computeCost(X, y, theta);

end

end

然后绘制出我们使用经过梯度下降求出的最优参数θ值所做预测的图形,如下:

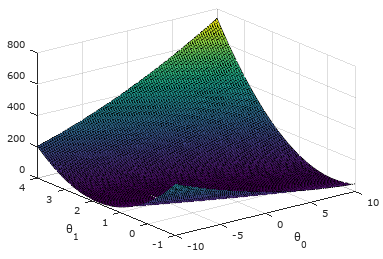

可视化J(θ):

使用表面图进行可视化:

theta0_vals = linspace(-, , ); %生成范围在[-10,10]之间100个点的线性行矢量,即维数为1*100的矩阵

theta1_vals = linspace(-, , ); %生成范围在[-1,4]之间100个点的线性行矢量,即维数为1*100的矩阵 J_vals = zeros(length(theta0_vals), length(theta1_vals)); %对应的代价函数值,维数为100*100

% Fill out J_vals

for i = :length(theta0_vals) %计算代价函数值

for j = :length(theta1_vals)

t = [theta0_vals(i); theta1_vals(j)];

J_vals(i,j) = computeCost(X, y, t);

end

end % Because of the way meshgrids work in the surf command, we need to transpose J_vals before calling surf, or else the axes will be flipped

J_vals = J_vals'; %surface函数的特性,必须进行转置。其实就是因为θ0和θ1要和行列坐标x,y对齐。

% Surface plot

figure;

surf(theta0_vals, theta1_vals, J_vals) %绘制表面图

xlabel('\theta_0'); ylabel('\theta_1');

结果如下:从图中可看出代价函数值J(θ)有全局最优解(最低点)。

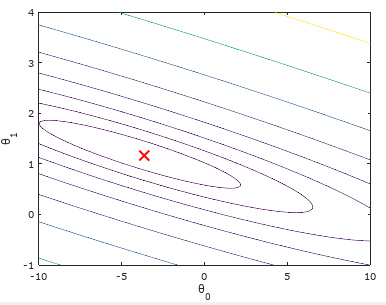

使用等高线图进行可视化:(logspace函数和linspace函数类似,此处作用生成将区间[10-2,103]等分20份的1*20矩阵)

figure; %这里的J_vals在前面进行了转置,所以此处不用转置!

contour(theta0_vals, theta1_vals, J_vals, logspace(-, , ))

xlabel('\theta_0'); ylabel('\theta_1'); %用到了转义字符'\theta_0'和'\theta_1'.

hold on;

plot(theta(), theta(), 'rx', 'MarkerSize', , 'LineWidth', );

结果如下:可以看出我们求出的最优参数θ所对应的代价值,正好位于等高线图最低的位置!

三.多变量线性回归(选做)

特征规则化:

function [X_norm, mu, sigma] = featureNormalize(X) %文件名为featureNormalize.m

X_norm = X;

mu = zeros(, size(X, )); %记录每个特征xi的平均值

sigma = zeros(, size(X, )); %记录每个特征xi的标准差值 for i=:size(X,),

mu(i)=mean(X(:,i)); %使用公式mean求平均值

sigma(i)=std(X(:,i)); %使用公式std求标准差值

X_norm(:,i)=(X_norm(:,i)-mu(i))/sigma(i);

end

end

代价函数和梯度下降:和单变量相同(省略)

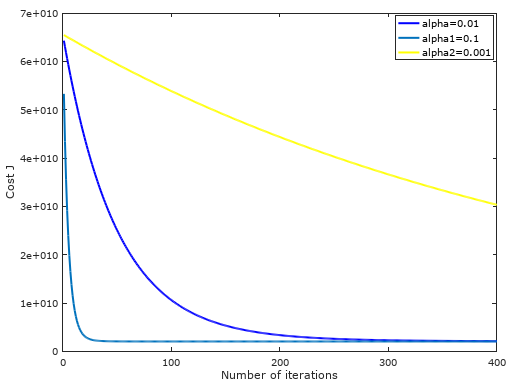

不同学习速率下,随着迭代次数的增加,代价函数值逐渐收敛图形:可以发现学习速率为0.01最为合适!

房价预测:Estimate the price of a 1650 sq-ft, 3 br house

% Estimate the price of a sq-ft, br house

% ====================== YOUR CODE HERE ======================

% Recall that the first column of X is all-ones. Thus, it does

% not need to be normalized.

x_try=[ ];

x_try()=x_try()-mu();

x_try()=x_try()-mu();

x_try()=x_try()/sigma();

x_try()=x_try()/sigma();

price = [ones(, ) x_try]*theta; % 这里的theta是我们前面经过梯度下降求出的

正规方程求参数theta:

function [theta] = normalEqn(X, y)

theta = zeros(size(X, ), );

theta=pinv(X'*X)*X'*y;

end

无~

Coursera-AndrewNg(吴恩达)机器学习笔记——第二周编程作业的更多相关文章

- Coursera-AndrewNg(吴恩达)机器学习笔记——第二周编程作业(线性回归)

一.准备工作 从网站上将编程作业要求下载解压后,在Octave中使用cd命令将搜索目录移动到编程作业所在目录,然后使用ls命令检查是否移动正确.如: 提交作业:提交时候需要使用自己的登录邮箱和提交令牌 ...

- Coursera-AndrewNg(吴恩达)机器学习笔记——第二周

一.多变量线性回归问题(linear regression with multiple variables) 搭建环境OctaveWindows的安装包可由此链接获取:https://ftp.gnu. ...

- Coursera-AndrewNg(吴恩达)机器学习笔记——第四周编程作业(多分类与神经网络)

多分类问题——识别手写体数字0-9 一.逻辑回归解决多分类问题 1.图片像素为20*20,X的属性数目为400,输出层神经元个数为10,分别代表1-10(把0映射为10). 通过以下代码先形式化展示数 ...

- Coursera-AndrewNg(吴恩达)机器学习笔记——第一周

一.初识机器学习 何为机器学习?A computer program is said to learn from experience E with respect to some task T an ...

- 吴恩达机器学习笔记(六) —— 支持向量机SVM

主要内容: 一.损失函数 二.决策边界 三.Kernel 四.使用SVM (有关SVM数学解释:机器学习笔记(八)震惊!支持向量机(SVM)居然是这种机) 一.损失函数 二.决策边界 对于: 当C非常 ...

- Machine Learning|Andrew Ng|Coursera 吴恩达机器学习笔记

Week1: Machine Learning: A computer program is said to learn from experience E with respect to some ...

- Machine Learning|Andrew Ng|Coursera 吴恩达机器学习笔记(完结)

Week 1: Machine Learning: A computer program is said to learn from experience E with respect to some ...

- 吴恩达机器学习笔记 —— 19 应用举例:照片OCR(光学字符识别)

http://www.cnblogs.com/xing901022/p/9374258.html 本章讲述的是一个复杂的机器学习系统,通过它可以看到机器学习的系统是如何组装起来的:另外也说明了一个复杂 ...

- [吴恩达机器学习笔记]12支持向量机5SVM参数细节

12.支持向量机 觉得有用的话,欢迎一起讨论相互学习~Follow Me 参考资料 斯坦福大学 2014 机器学习教程中文笔记 by 黄海广 12.5 SVM参数细节 标记点选取 标记点(landma ...

随机推荐

- 【Android 应用开发】 自定义 圆形进度条 组件

转载著名出处 : http://blog.csdn.net/shulianghan/article/details/40351487 代码下载 : -- CSDN 下载地址 : http://down ...

- μC/OS-II与RT-Thread对比——任务调度

在任务调度器的实现上,μC/OS-II和RT-Thread都采用了位图调度(bitmap scheduling),任务优先级的值越小则代表具有越高的优先级,主要区别在于实现形式,是采用多 ...

- mxGraph进阶(一)mxGraph教程-开发入门指南

mxGraph教程-开发入门指南 概述 mxGraph是一个JS绘图组件适用于需要在网页中设计/编辑Workflow/BPM流程图.图表.网络图和普通图形的Web应用程序.mxgraph下载包中包括用 ...

- ABB机器人基础培训资料整理与总结

之前对机械臂了解较少,这方面知识比较匮乏.只使用过PowercCube六自由度机械臂. 感谢ABB公司何老师的耐心指导. 学习资料汇总:(最重要的ABB Robot 官网就不列出了,这里以中文资料为主 ...

- 9、Libgdx的输入处理

(官网:www.libgdx.cn) 不同的平台有着不同的输入方式.桌面用户可以通过键盘和鼠标与应用进行交互,基于浏览器的游戏也是这样.在Android中,鼠标被触摸屏所替代,通常没有实体键盘.And ...

- 12_Android中HttpClient的应用,doGet,doPost,doHttpClientGet,doHttpClient请求,另外借助第三方框架实现网络连接的应用,

准备条件, 编写一个web项目.编写一个servlet,若用户名为lisi,密码为123,则返回"登录成功",否则"登录失败".项目名为ServerIth ...

- 10_Android中通过HttpUrlConnection访问网络,Handler和多线程使用,读取网络html代码并显示在界面上,ScrollView组件的使用

编写如下项目: 2 编写Android清单文件 <?xml version="1.0" encoding="utf-8"?> <mani ...

- 《java入门第一季》之Arrays类

前面介绍了排序问题(见博客http://blog.csdn.net/qq_32059827/article/details/51362390):二分查找问题(见博客http://blog.csdn.n ...

- 《java入门第一季》之类小案例(模拟用户登录)

首先是做一个用户登录的小案例.在此基础上加入其它逻辑. import java.util.Scanner; /* * 模拟登录,给三次机会,并提示还有几次.如果登录成功,就可以玩猜数字小游戏了. * ...

- IP协议详解(转)

本文转载自博文协议森林05 我尽力 (IP协议详解).这篇博文写的很有趣味,特转载! IPv4与IPv6头部的对比 我们已经在IP接力中介绍过,一个IP包分为头部(header)和数据(payload ...