MR案例:Reduce-Join

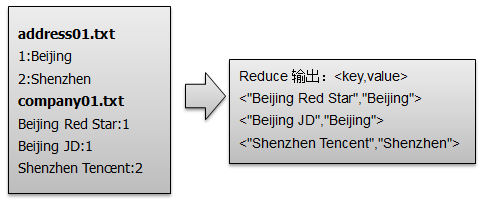

问题描述:两种类型输入文件:address(地址)和company(公司)进行一对多的关联查询,得到地址名(例如:Beijing)与公司名(例如:Beijing JD、Beijing Red Star)的关联信息。可参考MR案例:Map-Join

1.map阶段:对比之前的单表关联可知,reduce阶段的key必须为关联两表的key,即address.Id = company.Id。则两表经过map处理输出的key必须是Id。

Class Map<LongWritable, Text, LongWritable, Text>{

method map(){

// 获取文件的每一行数据,并以":"分割

String[] line = value.toString().split(":");

//split对应的文件名

String fileName = ((FileSplit) context.getInputSplit()).getPath().getName();

//处理company文件的value信息:"Beijing Red Star:1"

if (path.indexOf("company") >= 0){

//<key,value> --<"1","company:Beijing Red Star">

context.write(new LongWritable(line[1]), new Text("company" + ":" + line[0]));

}

//处理adress文件的value信息:"1:Beijing"

else if (path.indexOf("address") >= 0){

//<key,value> --<"1","address:Beijing">

context.write(new LongWritable(line[0]), new Text("address" + ":" + line[1]));

}

}

}

2.reduce阶段:首先对输入<key, values>即<”1”,[“company:Beijing Red Star”,”company:Beijing JD”,”address:Beijing”]>的values值进行遍历获取到单元信息value(例如”company:Beijing Red Star”),然后根据value中的标识符(company和address)将公司名和地址名分别存入到company集合和address集合,最后对company集合和address集合进行笛卡尔积运算得到company与address的关系,并进行输出。

Class Reducer<LongWritable, Text, Text, Text>{

method reduce(){

//用来存储 company 和 address 的集合

List<String> companys = new ArrayList<String>();

List<String> addresses = new ArrayList<String>();

for(Text text : v2s){

String[] result = text.toString().split(":");

//以 company 开头的value存储到 company 集合中

if(result[0].equals("company")){

companys.add(result[1]);

}

//以 address 开头的value存储到 address 集合中

else if(result[0].equals("address")){

addresses.add(result[1]);

}

}

/**

* 如果只判断左表addresses.size()!=0;则转化为 左外连接 --> LEFT OUTER JOIN

* 如果只判断右表companys.size()!=0;则转化为 右外连接 --> RIGHT OUTER JOIN

* 左右都不判断,则转化为 全外连接 --> FULL OUTER JOIN

*/

// 求笛卡尔积

if(0 != companys.size()&& 0 != addresses.size()){

for(int i=0;i<companys.size();i++){

for(int j=0;j<addresses.size();j++){

//<key,value>--<"Beijing JD","Beijing">

context.write(new Text(companys.get(i)), new Text(addresses.get(j)));

}

}

}

}

}

MR案例:Reduce-Join的更多相关文章

- Hadoop学习之路(二十一)MapReduce实现Reduce Join(多个文件联合查询)

MapReduce Join 对两份数据data1和data2进行关键词连接是一个很通用的问题,如果数据量比较小,可以在内存中完成连接. 如果数据量比较大,在内存进行连接操会发生OOM.mapredu ...

- MR案例:倒排索引

1.map阶段:将单词和URI组成Key值(如“MapReduce :1.txt”),将词频作为value. 利用MR框架自带的Map端排序,将同一文档的相同单词的词频组成列表,传递给Combine过 ...

- MapReduce编程之Reduce Join多种应用场景与使用

在关系型数据库中 Join 是非常常见的操作,各种优化手段已经到了极致.在海量数据的环境下,不可避免的也会碰到这种类型的需求, 例如在数据分析时需要连接从不同的数据源中获取到数据.不同于传统的单机模式 ...

- MR案例:小文件处理方案

HDFS被设计来存储大文件,而有时候会有大量的小文件生成,造成NameNode资源的浪费,同时也影响MapReduce的处理效率.有哪些方案可以合并这些小文件,或者提高处理小文件的效率呢? 1). 所 ...

- MapReduce之Reduce Join

一 介绍 Reduce Join其主要思想如下: 在map阶段,map函数同时读取两个文件File1和File2,为了区分两种来源的key/value数据对,对每条数据打一个标签(tag), 比如:t ...

- MR案例:CombineFileInputFormat

CombineFileInputFormat是一个抽象类.Hadoop提供了两个实现类CombineTextInputFormat和CombineSequenceFileInputFormat. 此案 ...

- MR案例:倒排索引 && MultipleInputs

本案例采用 MultipleInputs类 实现多路径输入的倒排索引.解读:MR多路径输入 package test0820; import java.io.IOException; import j ...

- MR案例:输出/输入SequenceFile

SequenceFile文件是Hadoop用来存储二进制形式的key-value对而设计的一种平面文件(Flat File).在SequenceFile文件中,每一个key-value对被看做是一条记 ...

- MR案例:外连接代码实现

[外连接]是在[内连接]的基础上稍微修改即可.具体HQL语句详见Hive查询Join package join.map; import java.io.IOException; import java ...

随机推荐

- Struts2的表单标签还可以为集合中的对象赋值

•Struts 还允许填充 Collection 里的对象, 这常见于需要快速录入批量数据的场合 代码如下 : TestCollectionAction.java package com.atgu ...

- PHP使用 DOMDocument创建和解析xml文件

<!-- DOMDocument生成XML文件 --><?php//声明一个DOMDocument对象$_doc=new DOMDocument('1.0', 'utf-8'); / ...

- SignalR循序渐进(一)简单的聊天程序

前阵子把玩了一下SignalR,起初以为只是个real-time的web通讯组件.研究了几天后发现,这玩意简直屌炸天,它完全就是个.net的双向异步通讯框架,用它能做很多不可思议的东西.它基于Owin ...

- qt model view 编程总结

看不见的root的 QModelIndex() 是 无效的 list 和table 的index 函数中的parent参数就只要 root QModelIndex 就可以,因为没有层级概念 Model ...

- new Option() 创建一个option标签

//add() 方法用于向 <select> 添加一个 <option> 元素. //new Option() 创建一个option标签 school.add(new Opti ...

- 【云安全与同态加密_调研分析(4)】云计算安全领域主要研究成果——By Me

下表列举了在云安全问题研究表现突出的ICT公司和研究机构以及其在云计算安全方面主要研究成果: ◆ICT公司和研究机构(云计算安全领域主要研究成果)◆ ◆机构名称◆ ◆机构类别◆ ◆主要研究成果◆ ◆备 ...

- Angular 回到顶部 滚动到特定的页面位置

$timeout(function() { // $location.hash('bottom'); // $anchorScroll(); // var a=angular.element(&quo ...

- Linux:Centos7升级内核(转)

更新前,内核版本为: uname -r 3.10.0-327.10.1.el7.x86_64 升级的方法: 1.导入key rpm --import https://www.elrepo.org/RP ...

- Java中二叉树存储结构实现

一.二叉树 二叉树指的是每个节点最多只能有两个子树的有序树.通常左边的子树被称为“左子树”(left subtree),右边的子树被称为右子树. 二叉树的每个节点最多只有2棵子树,二叉树的子树次序不能 ...

- 新式转型操作符[条款9] --《C++必知必会》

在旧式转型(cast)下面隐藏着一些见不得人的.鬼鬼祟祟的东西.他们的语法形式使其在一段代码中通常很难引起人们的注意,但它们可能会搞一些可怕的破坏活动,就好比你冷不丁被一个恶棍猛击一拳似的.让我们阐明 ...