【项目实战】pytorch实现逻辑斯蒂回归

视频指导:https://www.bilibili.com/video/BV1Y7411d7Ys?p=6

一些数据集

在pytorch框架下,里面面有配套的数据集,pytorch里面有一个torchversion的包,他可以提供相应的,比如MNIST这种很基础的数据集,但是安装的时候这些数据集不会包含在包里面,所以需要下载,具体代码以及解释如下:

import torchvision

train_set = torchvision.datasets.MNIST(root= '../dataset/mnist', train=True, download=True) //root后面表示把数据集安装在什么位置,train表示是要训练集还是测试集,download表示是否需要下载(如果没有下载就需要下载)

text_set = torchvision.datasets.MNIST(root= '../dataset/mnist', train=False, download=True)

还有一个叫做CIFAR-10 的数据集,训练集里面包含了5w个样本,测试集包含了1w个样本,内容就是一些图片,被分成了十类,分别表示不同的事务

import torchvision

train_set = torchvision.datasets.CIFAR10(...)

text_set = torchvision.datasets.CIFAR10(...)

逻辑斯蒂回归

首先我们自己设计几个数据

x_data = torch.Tensor([[1.0], [2.0], [3.0]])

y_data = torch.Tensor([[0], [0], [1]])

然后开始设计模型

class LogisiticRegressionModel(torch.nn.Module):

def __init__(self):

super(LogisiticRegressionModel, self).__init__()

self.linear = torch.nn.Linear(1, 1)

def forward(self,x):

y_pred = F.sigmoid(self.linear(x))

return y_pred

这里和昨天不一样的地方在于forward里面使用了逻辑斯蒂回归

然后是优化器和损失函数

model = LogisiticRegressionModel()

critertion = torch.nn.BCELoss(size_average=False)

optimizer = torch.optim.SGD(model.parameters(),lr=0.01)

损失函数采用的是BCE,就是交叉熵损失

开始训练

for epoch in range(1000):

y_pred = model(x_data)

loss = critertion(y_pred,y_data)

print(epoch, loss.item())

optimizer.zero_grad()

loss.backward()

optimizer.step()

结果可视化

用matplotlib进行绘图可以使结果可视化,具体代码和解释如下

import numpy as np

import matplotlib.pyplot as plt

x = np.linspace(0, 10, 200) //意思就是在0到10之间弄出来两百个点

x_t = torch.Tensor(x).view((200, 1)) //把他变成200行一列的矩阵

y_t = model(x_t) //送入模型

y = y_t.data.numpy() //用numpy接收y_data的数据

plt.plot(x, y) //绘图

plt.plot([0, 10], [0.5, 0.5], c='r') //表示在0到10,0.5到0.5上面画一条线(显然是一条直线)

plt.ylabel('probability of pass')

plt.grid()

plt.show()

总结

第一遍跑有一个警告

UserWarning: nn.functional.sigmoid is deprecated. Use torch.sigmoid instead. warnings.warn

查了一下,把

F.sigmoid(self.hidden(x))

#修改成以下语句

torch.sigmoid(self.hidden(x))

即可

估计是版本问题吧

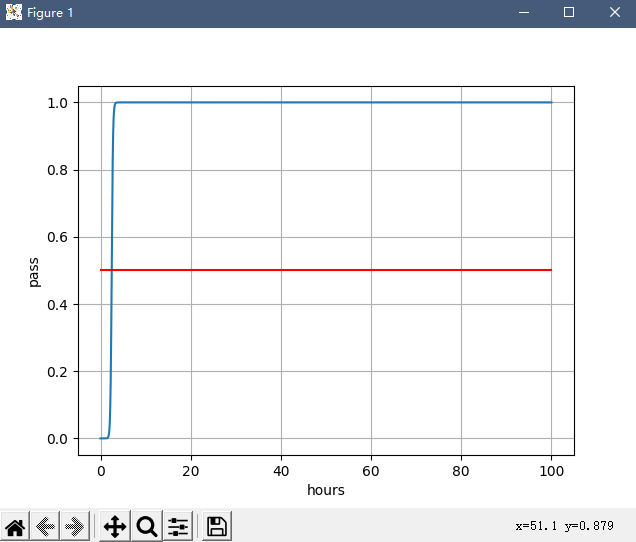

然后我有魔改了一下代码,具体如下

import torch

x_data = torch.Tensor([[1.0], [2.0], [3.0]])

y_data = torch.Tensor([[0], [0], [1]])

class LogisiticRegressionModel(torch.nn.Module):

def __init__(self):

super(LogisiticRegressionModel, self).__init__()

self.linear = torch.nn.Linear(1, 1)

def forward(self,x):

y_pred = torch.sigmoid(self.linear(x))

return y_pred

model = LogisiticRegressionModel()

critertion = torch.nn.BCELoss(size_average=False)

optimizer = torch.optim.SGD(model.parameters(), lr=0.01)

for epoch in range(50000):

y_pred = model(x_data)

loss = critertion(y_pred,y_data)

print(epoch, loss.item())

optimizer.zero_grad()

loss.backward()

optimizer.step()

import numpy as np

import matplotlib.pyplot as plt

x = np.linspace(0, 100, 2000)

x_t = torch.Tensor(x).view((2000, 1))

y_t = model(x_t)

y = y_t.data.numpy()

plt.plot(x, y)

plt.plot([0, 100], [0.5, 0.5], c='r')

plt.xlabel('hours')

plt.ylabel('pass')

plt.grid()

plt.show()

最后的结果,我愿称之为,过拟合之王

哈哈哈哈哈,很有意思

- 总之整个代码编写就分这几步:

- 准备数据;

- 设计模型;

- 构造损失函数和优化器;

- 训练过程;

- 打印结果

熟悉了就可以搞出自己的模型了

【项目实战】pytorch实现逻辑斯蒂回归的更多相关文章

- python机器学习实现逻辑斯蒂回归

逻辑斯蒂回归 关注公众号"轻松学编程"了解更多. [关键词]Logistics函数,最大似然估计,梯度下降法 1.Logistics回归的原理 利用Logistics回归进行分类的 ...

- 【转】机器学习笔记之(3)——Logistic回归(逻辑斯蒂回归)

原文链接:https://blog.csdn.net/gwplovekimi/article/details/80288964 本博文为逻辑斯特回归的学习笔记.由于仅仅是学习笔记,水平有限,还望广大读 ...

- 机器学习之LinearRegression与Logistic Regression逻辑斯蒂回归(三)

一 评价尺度 sklearn包含四种评价尺度 1 均方差(mean-squared-error) 2 平均绝对值误差(mean_absolute_error) 3 可释方差得分(explained_v ...

- [置顶] 局部加权回归、最小二乘的概率解释、逻辑斯蒂回归、感知器算法——斯坦福ML公开课笔记3

转载请注明:http://blog.csdn.net/xinzhangyanxiang/article/details/9113681 最近在看Ng的机器学习公开课,Ng的讲法循循善诱,感觉提高了不少 ...

- 【分类器】感知机+线性回归+逻辑斯蒂回归+softmax回归

一.感知机 详细参考:https://blog.csdn.net/wodeai1235/article/details/54755735 1.模型和图像: 2.数学定义推导和优化: 3.流程 ...

- spark机器学习从0到1逻辑斯蒂回归之(四)

逻辑斯蒂回归 一.概念 逻辑斯蒂回归(logistic regression)是统计学习中的经典分类方法,属于对数线性模型.logistic回归的因变量可以是二分类的,也可以是多分类的.logis ...

- 逻辑斯蒂回归(Logistic Regression)

逻辑回归名字比较古怪,看上去是回归,却是一个简单的二分类模型. 逻辑回归的模型是如下形式: 其中x是features,θ是feature的权重,σ是sigmoid函数.将θ0视为θ0*x0(x0取值为 ...

- 逻辑斯蒂回归VS决策树VS随机森林

LR 与SVM 不同 1.logistic regression适合需要得到一个分类概率的场景,SVM则没有分类概率 2.LR其实同样可以使用kernel,但是LR没有support vector在计 ...

- [转]逻辑斯蒂回归 via python

# -*- coding:UTF-8 -*-import numpydef loadDataSet(): return dataMat,labelMat def sigmoid(inX): retur ...

随机推荐

- Sentinel-流量防卫兵

1.背景 1.1 简介 Sentinel 以流量为切入点,从流量控制.熔断降级.系统负载保护等多个维度保护服务的稳定性. Sentinel 具有以下特征 丰富的应用场景:Sentinel 承接了阿里巴 ...

- DBSync新增对MongoDB、ES的支持

数据库同步工具DBSync近日进行了升级,最新版本为V1.9,新增了对MongoDB.Elasticseach(ES)的支持,具体情况:1.支持同型库之间的同步,如:MongoDB至MongoDB,E ...

- Lambda表达式的无参数无返回值的练习和Lambda表达式有参数有返回值的练习

使用Lambda(无参无返回) 说明:给定一个厨师(Cook)接口,内含唯一的抽象方法makeFood,且无参数.无返回值.如下: public interface Cook{ public abst ...

- 图扑 Web 可视化引擎在仿真分析领域的应用

前言 在数字孪生和仿真研究过程中,会产生大量和三维空间相关的数值信息,比如设备外观的扫描数据.地形扫描数据.生产设备温度场/压力场.流体的速度场.流体扩散,以及各种仿真数据:速度,压力,应力,温度 ...

- 倍增求RMQ

RMQ,即区间最值查询,给定一个序列,求区间l-r的最大值.最小值. st表求RMQ,预处理On*logn,查询O1. 预处理: void init_rmq() { for(rll j=1;j< ...

- .NET 跨平台应用开发动手教程 |用 Uno Platform 构建一个 Kanban-style Todo App

作者:Steven Giesel 翻译:Alan Wang 校对:李卫涵 – 微软 MVP 排版:Rani Sun 有什么比参考包含分步说明和代码示例的动手教程更好的学习新技术的方式呢?当你完成或 f ...

- linux学习随笔2之防火墙

centos7默认使用的防火墙是firewalld 查看所有打开的端口: firewall-cmd --zone=public --list-ports 更新防火墙规则: firewall-cmd - ...

- docker Compose 部署springboot+vue前端端分离项目

温馨提示:如果有自己的服务器最好不过了,这样部署网项目就可以上线了.没有的话,只能使用localhost 本机访问啦,记得替换 ngixn 中的ip地址.域名为localhost. (一) 准备工作 ...

- 聚是一团火散作满天星,前端Vue.js+elementUI结合后端FastAPI实现大文件分片上传

原文转载自「刘悦的技术博客」https://v3u.cn/a_id_175 分片上传并不是什么新概念,尤其是大文件传输的处理中经常会被使用,在之前的一篇文章里:python花式读取大文件(10g/50 ...

- 从零开始Blazor Server(8)--增加菜单以及调整位置

这篇干啥 这篇文章主要是把前面的一些东西稍微调整一下,使其更适合后面的内容. 主要是两个事,一个是把原来的PermissionEntity直接变成MenuEntity,直接让最后一级是菜单,这样后面就 ...