weight decay 和正则化caffe

正则化是为了防止过拟合,因为正则化能降低权重

caffe默认L2正则化

代码讲解的地址:http://alanse7en.github.io/caffedai-ma-jie-xi-4/

重要的一个回答:https://stats.stackexchange.com/questions/29130/difference-between-neural-net-weight-decay-and-learning-rate

按照这个答主的说法,正则化损失函数,正则化之后的损失函数如下:

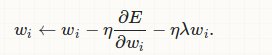

这个损失函数求偏导就变成了:加号前面是原始损失函数求偏导,加号后面就变成了  *w,这样梯度更新就变了下式:

*w,这样梯度更新就变了下式:

wi←wi−η∂E∂wi−ηλwi.

L2正则化的梯度更新公式,与没有加regulization正则化相比,每个参数更新的时候多剪了正则化的值,相当于让每个参数多剪了weight_decay*w原本的值

根据caffe中的代码也可以推断出L1正则化的公式:

把 替换成

替换成 *w的绝对值

*w的绝对值

所以求偏导的时候就变成了,当w大于0为 ,当w小于0为-

,当w小于0为-

void SGDSolver<Dtype>::Regularize(int param_id) {

const vector<shared_ptr<Blob<Dtype> > >& net_params = this->net_->params();

const vector<float>& net_params_weight_decay =

this->net_->params_weight_decay();

Dtype weight_decay = this->param_.weight_decay();

string regularization_type = this->param_.regularization_type();

Dtype local_decay = weight_decay * net_params_weight_decay[param_id];

switch (Caffe::mode()) {

case Caffe::CPU: {

if (local_decay) {

if (regularization_type == "L2") {

// add weight decay

caffe_axpy(net_params[param_id]->count(),

local_decay,

net_params[param_id]->cpu_data(),

net_params[param_id]->mutable_cpu_diff());

} else if (regularization_type == "L1") {

caffe_cpu_sign(net_params[param_id]->count(),

net_params[param_id]->cpu_data(),

temp_[param_id]->mutable_cpu_data());

caffe_axpy(net_params[param_id]->count(),

local_decay,

temp_[param_id]->cpu_data(),

net_params[param_id]->mutable_cpu_diff());

} else {

LOG(FATAL) << "Unknown regularization type: " << regularization_type;

}

}

break;

}

caffe_axpy的实现在util下的math_functions.cpp里,实现的功能是y = a*x + y,也就是相当于把梯度更新值和weight_decay*w加起来了

caffe_sign的实现在util下的math_functions.hpp里,通过一个宏定义生成了caffe_cpu_sign这个函数,函数实现的功能是当value>0返回1,<0返回-1

weight decay 和正则化caffe的更多相关文章

- PyTorch 中 weight decay 的设置

先介绍一下 Caffe 和 TensorFlow 中 weight decay 的设置: 在 Caffe 中, SolverParameter.weight_decay 可以作用于所有的可训练参数, ...

- dying relu 和weight decay

weight decay就是在原有loss后面,再加一个关于权重的正则化,类似与L2 正则,让权重变得稀疏: 参考:https://www.zhihu.com/question/24529483 dy ...

- 权重衰减(weight decay)与学习率衰减(learning rate decay)

本文链接:https://blog.csdn.net/program_developer/article/details/80867468“微信公众号” 1. 权重衰减(weight decay)L2 ...

- weight decay(权值衰减)、momentum(冲量)和normalization

一.weight decay(权值衰减)的使用既不是为了提高你所说的收敛精确度也不是为了提高收敛速度,其最终目的是防止过拟合.在损失函数中,weight decay是放在正则项(regularizat ...

- 在神经网络中weight decay

weight decay(权值衰减)的最终目的是防止过拟合.在损失函数中,weight decay是放在正则项(regularization)前面的一个系数,正则项一般指示模型的复杂度,所以weigh ...

- 【tf.keras】AdamW: Adam with Weight decay

论文 Decoupled Weight Decay Regularization 中提到,Adam 在使用时,L2 与 weight decay 并不等价,并提出了 AdamW,在神经网络需要正则项时 ...

- weight decay (权值衰减)

http://blog.sina.com.cn/s/blog_890c6aa30100z7su.html 在机器学习或者模式识别中,会出现overfitting,而当网络逐渐overfitting时网 ...

- [转载]理解weight decay

http://blog.sina.com.cn/s/blog_a89e19440102x1el.html

- 【撸码caffe四】 solver.cpp&&sgd_solver.cpp

caffe中solver的作用就是交替低啊用前向(forward)算法和后向(backward)算法来更新参数,从而最小化loss,实际上就是一种迭代的优化算法. solver.cpp中的Solver ...

随机推荐

- REQUIRED与REQUIRED_NEW

出处: https://blog.csdn.net/selfsojourner/article/details/74561745 spring 事务的传播行为中,有两个容易混淆的行为:REQUIRED ...

- Linux环境搭建禅道项目管理工具

1.开源版安装包下载 [root@iZbp ~]# wget http://dl.cnezsoft.com/zentao/9.0.1/ZenTaoPMS.9.0.1.zbox_64.tar.gz 2. ...

- Kure讲HTML_列表标签及表单标签

首先我上个图来告诉大家什么是列表 左侧的这一部分就可以称为是列表或者叫树,其实我们可以通过div+css实现列表,可是考虑语义化的问题,我们还是看看html提供好的列表标签,html提供了两种列表,一 ...

- js的事件冒泡

先来段代码 <!DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN" "http://www.w ...

- dos文件格式转换为Unix文件格式

做linux开发的,一般还是在windows上装个虚拟机,在windows上开发, 所以就会出现dos文件与unix文件格式不一致,当windows上的文件在linux上用的时候,经常在每行的末尾会出 ...

- Mvc内建功能(DefaultModelBinder)自动绑定。

在做Asp.Net MVC项目中,都知道View负责页面展示数据或者提供页面收集数据,而所展示的数据或者收集的数据都是从Controller的Action中获取或提交到Controller的Actio ...

- php数组的定义

数组的主要作用就是存储数据,修改数据. 数组:就是把多个数据放在一起管理. 数组可以存入多个不同类型的数据,是一个复合数据类型. 在PHP中,有两种方式定义数组 //$array = array( ...

- 在Centos7中安装Docker并实例化Mysql

首先 本文是一篇安装流程,从初始的Centos7安装Docker后实例化一个Mysql的整个流程,其中会包含一些需要注意的疑点和坑. 实例化的Mysql是将数据和配置保存在宿主机. 注意,在安装Doc ...

- Android 修改圆形progressBar颜色

查了半天资料,没查到怎样修改progressBar的方法,全都是重新写个ProgressBar,其实很简单在只要一句xml里一句化就可以 android:indeterminateTint=" ...

- 【起航计划 028】2015 起航计划 Android APIDemo的魔鬼步伐 27 App->Preferences->Launching preferences 其他activity获取Preference中的值

前给例子介绍了如何使用PreferenceActivity 来显示修改应用偏好,用户对Preferences的修改自动存储在应用对应的Shared Preferences中. 本例介绍了如何从一个Ac ...