MeteoInfoLab脚本示例:创建netCDF文件(合并文件)

在MeteoInfoLab中增加了创建netCDF文件并写入数据的功能,这里利用合并多个netCDF文件为一个新的netCDF文件为例。

1、创建一个可写入的netCDF文件对象(下面用ncfile表示),用addfile函数,第一个参数是文件名,第二次参数'c'表示创建新的netCDF文件。

ncfile = addfile(outfn, 'c')

2、添加维(Dimensions),用ncfile的adddim函数,两个参数分别是维名称和维长度。

stn = 26564

stdim = ncfile.adddim('station', stn)

3、添加全局属性,用ncfile的addgroupattr函数,两个参数分别是属性名称和属性值。

ncfile.addgroupattr('Conventions', 'Unidata Observation Dataset v1.0')

4、添加变量,用ncfile的addvar函数,三个参数分别是变量名称、变量数据类型和变量维列表。并给变量添加一些属性用变量对象的addattr函数。

var = ncfile.addvar('streamflow', 'float', [tdim, stdim])

var.addattr('long_name', 'River Flow')

var.addattr('units', 'meter^3 / sec')

5、创建netCDF文件,上面的步骤都是对netCDF文件的设置,完成之后需要create函数表示设置已完成,可以开始写数据了。

ncfile.create()

6、写数据,用ncfile的write函数,参数分别是变量和要写入的数组,origin是各维起点的列表,可以控制写入某个变量的部分数据。如果要写入的数组的维数和变量的维数不一致,需要用reshape函数来确保二者有相同的维数。

ncfile.write(variables[3], flow, origin=origin)

7、关闭netCDF文件,数据写完之后需要关闭netCDF文件。

ncfile.flush()

ncfile.close()

示例脚本程序(合并4个不同时次的netCDF文件为一个新的netCDF文件):

datadir = 'D:/Temp/nc'

outfn = os.path.join(datadir, 'join_file.nc')

#New netCDF file

ncfile = addfile(outfn, 'c')

#Add dimensions

stn = 26564

recdim = ncfile.adddim('recNum', stn)

stdim = ncfile.adddim('station', stn)

iddim = ncfile.adddim('id_len', 11)

tdim = ncfile.adddim('time', 4)

#Add global attributes

ncfile.addgroupattr('Conventions', 'Unidata Observation Dataset v1.0')

ncfile.addgroupattr('cdm_datatype', 'Station')

ncfile.addgroupattr('geospatial_lat_max', '90.0')

ncfile.addgroupattr('geospatial_lat_min', '-90.0')

ncfile.addgroupattr('geospatial_lon_max', '180.0')

ncfile.addgroupattr('geospatial_lon_min', '-180.0')

ncfile.addgroupattr('stationDimension', 'station')

ncfile.addgroupattr('missing_value', -8.9999998E15)

ncfile.addgroupattr('stream_order_output', 1)

#Add variables

variables = []

var = ncfile.addvar('latitude', 'float', [stdim]) #Latitude

var.addattr('long_name', 'station latitude')

var.addattr('units', 'degrees_north')

variables.append(var)

var = ncfile.addvar('longitude', 'float', [stdim]) #Longitude

var.addattr('long_name', 'station longitude')

var.addattr('units', 'degrees_east')

variables.append(var)

var = ncfile.addvar('altitude', 'float', [stdim]) #Altitude

var.addattr('long_name', 'station altitude')

var.addattr('units', 'meters')

variables.append(var)

var = ncfile.addvar('streamflow', 'float', [tdim, stdim]) #Stream flow - Add time dimension

var.addattr('long_name', 'River Flow')

var.addattr('units', 'meter^3 / sec')

variables.append(var)

tvar = ncfile.addvar('time', 'int', [tdim])

tvar.addattr('long_name', 'time')

tvar.addattr('units', 'hours since 1900-01-01 00:00:0.0')

#Creat netCDF file

ncfile.create()

#Write data

stime = datetime.datetime(2015,8,2,0)

etime = datetime.datetime(2015,8,2,3)

st = datetime.datetime(1900,1,1)

fi = 0

while stime <= etime:

print stime

fn = os.path.join(datadir, stime.strftime('%Y%m%d%H') + '00.CHRTOUT_DOMAIN2')

if os.path.exists(fn):

print '\t' + fn

f = addfile(fn)

hours = (stime - st).total_seconds() // 3600

origin = [fi]

ncfile.write(tvar, array([hours]), origin=origin)

if fi == 0:

lat = f['latitude'][:]

ncfile.write(variables[0], lat)

lon = f['longitude'][:]

ncfile.write(variables[1], lon)

alt = f['altitude'][:]

ncfile.write(variables[2], alt)

flow = f['streamflow'][:]

origin = [fi, 0]

shape = [1, stn]

flow = flow.array.reshape(shape)

ncfile.write(variables[3], flow, origin=origin)

fi += 1

stime = stime + datetime.timedelta(hours=1) #close netCDF file

ncfile.flush()

ncfile.close() print 'Finished!'

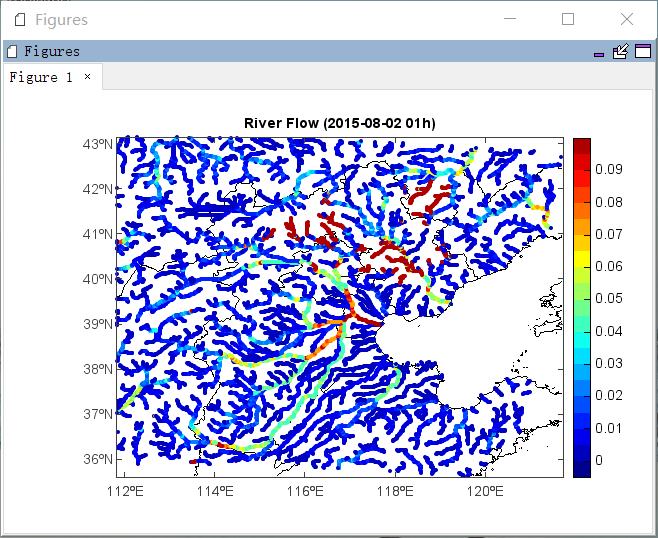

对合并后的文件绘图:

f = addfile('D:/Temp/nc/join_file.nc')

lon = f['longitude'][:]

lat = f['latitude'][:]

var = f['streamflow']

flow = var[1,:]

axesm()

mlayer = shaperead('D:/Temp/Map/bou2_4p.shp')

geoshow(mlayer)

levs = arange(0, 0.1, 0.005)

layer = scatterm(lon, lat, flow, levs, edge=False)

colorbar(layer)

t = f.gettime(1)

title('River Flow (' + t.strftime('%Y-%m-%d %Hh)'))

MeteoInfoLab脚本示例:创建netCDF文件(合并文件)的更多相关文章

- MeteoInfoLab脚本示例:MODIS AOD

MODIS的气溶胶光学厚度(AOD)产品应用很广,数据可以在Giovanni上下载:http://disc.sci.gsfc.nasa.gov/giovanni/overview/index.html ...

- MeteoInfoLab脚本示例:加载图片和透明图层

MeteoInfoLab的georead函数提供了读取shape文件.image文件(JPG.PNG等,需要有相应的地理定位文件)文件生成图层的功能(事实上shaperead也是同样的功能,不过函数名 ...

- MeteoInfoLab脚本示例:计算垂直螺旋度

尝试编写MeteoInfoLab脚本计算垂直螺旋度,结果未经验证. 脚本程序: print 'Open data files...' f_uwnd = addfile('D:/Temp/nc/uwnd ...

- MeteoInfoLab脚本示例:闪电位置图

这个脚本示例读取文本格式的闪电数据,读出每条闪电记录的经纬度和强度,在地图上绘制出每个闪电的位置,并用符号和颜色区分强度正负.数据格式如下:0 2009-06-06 00:01:16.6195722 ...

- MeteoInfoLab脚本示例:FY-3C全球火点HDF数据

FY-3C全球火点HDF数据包含一个FIRES二维变量,第一维是火点数,第二维是一些属性,其中第3.4列分别是火点的纬度和经度.下面的脚本示例读出所有火点经纬度并绘图.脚本程序: #Add data ...

- MeteoInfoLab脚本示例:读取远程文件

利用Unidata netCDF Java库对远程文件的读取能力(OpenDAP, ADDE, THREDDS等),可以读取远程文件并绘图.脚本程序: fn = 'http://monsoondata ...

- MeteoInfoLab脚本示例:合并数组

对于全球数据来说,经度要么是-180 - 180,要么是0 - 360,都会存在边界数据不连续的问题.比如0 - 360的数据,怎么得到 -20 - 30度的连续格点数据就是个问题(跨越了数据的经度边 ...

- MeteoInfoLab脚本示例:Hamawari-8 netCDF data

示例数据:ftp://ftp.bom.gov.au/anon/sample/catalogue/Satellite/IDE00220.201507140300.nc 该数据的分辨率很高(22000*2 ...

- MeteoInfoLab脚本示例:Trajectory

示例读取HYSPLIT模式输出的气团轨迹数据文件,生成轨迹图层,并显示轨迹各节点的气压图.脚本程序: f = addfile_hytraj('D:/MyProgram/Distribution/jav ...

随机推荐

- 从通达信导出文件获取A股所有股票代号名称(至2020年2月24日)

下文是讲述如何从通达信的输出文件中获得股票信息,如果想用Java爬虫从网页爬取信息请参考:https://www.cnblogs.com/xiandedanteng/p/12808381.html 要 ...

- 【API进阶之路】用API打造一条自动化内容生产流水线

摘要:搞定了内容审核之后,我又把抓取工具.内容审核API.文本摘要生成API串联在一起,从抓到审再到编,建立了一条自动化的内容生产流水线,编辑团队只需要做优质内容的推荐就可以了. 上周,运营部将官网上 ...

- 嵌入式Linux软链接使用技巧

软链接概述 软链接是Linux下常用的一种共享文件方式.目录的方式,这种方式类似于Windows下的快捷方式.一般一个文件或者目录在不同的路径都需要的时候,可以通过创建软链接的方式来共享,这样只系统下 ...

- .NET Core表达式树的梳理

最近要重写公司自己开发的ORM框架:其中有一部分就是查询的动态表达式:于是对这方面的东西做了一个简单的梳理 官网的解释: 表达式树以树形数据结构表示代码,其中每一个节点都是一种表达式,比如方法调用和 ...

- 安卓自动化测试工具Monkey简单使用

一.首先安装adb 地址:http://www.downza.cn/soft/219906.html安装到D盘下,安装的过程中自己注意下不要安装上全家桶.找到这个压缩包:解压到当前文件夹: 二.将ad ...

- oracle数据处理之逻辑备份与恢复

逻辑备份与恢复 17.1 传统的导入导出exp/imp:传统的导出导入程序指的是exp/imp,用于实施数据库的逻辑备份和恢复. 导出程序exp将数据库中的对象定义和数据备份到一个操作系统二进制文件中 ...

- 乔悟空-CTF-i春秋-Web-Backdoor

2020.09.05 每次遇到不会的,想两分钟就放弃了,直接奔wp,一看wp发现,wc,就这?我怎么没想到--心里想着下道题一定自己想,不看wp,然后周而复始

- [剑指Offer]18-题目一:删除链表的节点 题目二:删除链表中重复节点

题目一 题目 O(1)时间复杂度删除给定链表节点. 题解 用待删除节点后一个节点的值覆盖待删除节点值,更新链接关系. 注意链表只有一个节点:删除尾结点:删除头节点的处理. 代码 class ListN ...

- [HDU2553]N皇后问题(DFS)

题目链接 http://acm.hdu.edu.cn/showproblem.php?pid=2553 题意 n<=10,输出N皇后问题的方法数. 题解 可以使用各种方法.这里使用DFS. 使用 ...

- Shell编程(4)

shell函数 shell中允许将一组命令集合或语句形成一段可用代码,这些代码块称为shell函数.给这段代码起个名字称为函数名,后续可以直接调用该段代码. 格式 func() { #指定函数名 co ...