redis百万级数据存取

Jedis jedis0 = new Jedis("localhost", 6379);

jedis0.auth("123456");

Pipeline pipelined = jedis0.pipelined();

Set<String> keys = jedis0.keys("batch*");

for (String key:keys){

pipelined.get(key);

}

List<Object> objects = pipelined.syncAndReturnAll();

long l1 = System.currentTimeMillis();

for (Object src:objects){

System.out.println(src);

}

long l2 = System.currentTimeMillis();

System.out.println("耗时:"+(l2-l1)+"ms");

}

使用Pipeline百万级数据7

Jedis jedis0 = new Jedis("localhost", 6379);

jedis0.auth("123456");

long l1 = System.currentTimeMillis();

for (int i = 0; i < 1000000; i++) {

jedis0.get("batch" + i);

}

long l2 = System.currentTimeMillis();

System.out.println("耗时:" + (l2 - l1) + "ms");

普通get去获取耗时:耗时:48622ms

前提redis版本要支持缓存,redis源码每次缓存8192个字节,

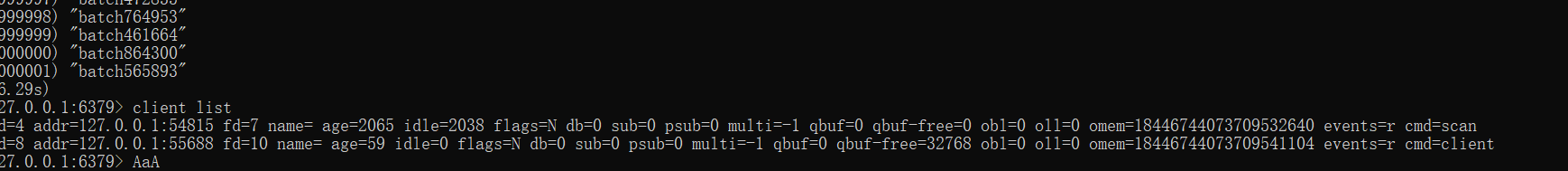

# client-output-buffer-limit <class> <hard limit> <soft limit> <soft seconds>超过这个限制直接断开连接,不然存了

client-output-buffer-limit normal 0 0 0

client-output-buffer-limit slave 256mb 64mb 60

client-output-buffer-limit pubsub 32mb 8mb 60

obl:输出缓存区长度

oll: 使用缓存的数量

omen:obl和oll占用的内内存

使用时要控制内存,因为使用Pipeline即使用本地客户端内存,也用服务端内存,适合用实施性不高的场景

redis百万级数据存取的更多相关文章

- 实战手记:让百万级数据瞬间导入SQL Server

想必每个DBA都喜欢挑战数据导入时间,用时越短工作效率越高,也充分的能够证明自己的实力.实际工作中有时候需要把大量数据导入数据库,然后用于各种程序计算,本文将向大家推荐一个挑战4秒极限让百万级数据瞬间 ...

- 【转 】实战手记:让百万级数据瞬间导入SQL Server

想必每个DBA都喜欢挑战数据导入时间,用时越短工作效率越高,也充分的能够证明自己的实力.实际工作中有时候需要把大量数据导入数据库,然后用于各种程序计算,本文将向大家推荐一个挑战4秒极限让百万级数据瞬间 ...

- 构建ASP.NET MVC4+EF5+EasyUI+Unity2.x注入的后台管理系统(37)-文章发布系统④-百万级数据和千万级数据简单测试

原文:构建ASP.NET MVC4+EF5+EasyUI+Unity2.x注入的后台管理系统(37)-文章发布系统④-百万级数据和千万级数据简单测试 系列目录 我想测试EF在一百万条数据下的显示时间! ...

- EF查询百万级数据的性能测试--多表连接复杂查询

相关文章:EF查询百万级数据的性能测试--单表查询 一.起因 上次做的是EF百万级数据的单表查询,总结了一下,在200w以下的数据量的情况(Sql Server 2012),EF是可以使用,但是由于 ...

- poi实现百万级数据导出

注意使用 SXSSFWorkbook 此类在构造表格和处理行高的时候效率极高,刚开始时我使用的 XSSFWorkbook 就出现构造表格效率极低,一万行基本需要3秒左右,那当导出百万级数据就慢的要死啦 ...

- redis通过json方案存取对象com.alibaba.fastjson.JSONException: syntax error, expect

问题描述: redis基于json方案存取对象时报错:com.alibaba.fastjson.JSONException: syntax error, expect com.alibaba.fast ...

- Sql Server中百万级数据的查询优化

原文:Sql Server中百万级数据的查询优化 万级别的数据真的算不上什么大数据,但是这个档的数据确实考核了普通的查询语句的性能,不同的书写方法有着千差万别的性能,都在这个级别中显现出来了,它不仅考 ...

- Mongo查询百万级数据性能问题及JAVA优化问题

Mongo查询百万级数据 使用分页 skip和limit 效率会相当慢 那么怎么解决呢 上代码 全部查询数据也会特别慢 Criteria criteria = new Criteria(); ...

- 详解如何挑战4秒内百万级数据导入SQL Server(转)

对于大数据量的导入,是DBA们经常会碰到的问题,在这里我们讨论的是SQL Server环境下百万级数据量的导入,希望对大家有所帮助.51CTO编辑向您推荐<SQL Server入门到精通&g ...

随机推荐

- Maven BOM!拿来吧你

what BOM? BOM(Bill of Materials)是由Maven提供的功能,它通过定义一整套相互兼容的jar包版本集合, 使用时只需要依赖该BOM文件,即可放心的使用需要的依赖jar包, ...

- 【剑指offer】27. 二叉树的镜像

剑指 Offer 27. 二叉树的镜像 知识点:二叉树:递归:栈 题目描述 请完成一个函数,输入一个二叉树,该函数输出它的镜像. 示例 输入:root = [4,2,7,1,3,6,9] 输出:[4, ...

- 【排序+模拟】魔法照片 luogu-1583

题目描述 一共有n(n≤20000)个人(以1--n编号)向佳佳要照片,而佳佳只能把照片给其中的k个人.佳佳按照与他们的关系好坏的程度给每个人赋予了一个初始权值W[i].然后将初始权值从大到小进行排序 ...

- sentry_sdk 错误日志监控 Flask配置

https://www.cnblogs.com/sui776265233/p/11348169.html 开源的平台,为小服务日志监控统一管理 pip install --upgrade sentry ...

- Skywalking-04:扩展Metric监控信息

扩展 Metric 监控信息 官方文档 Source and Scope extension for new metrics 案例:JVM Thread 增加 Metrics 修改 Thread 的定 ...

- jvm源码解读--05 常量池 常量项的解析JVM_CONSTANT_Utf8

当index=18的时候JVM_CONSTANT_Utf8 case JVM_CONSTANT_Utf8 : { cfs->guarantee_more(2, CHECK); // utf8_l ...

- 构建后端第5篇之---Idea 查看继承 实现关系图

first question: how to show a class children class : move mousrmark to class name , Ctrl + H how t ...

- vue源码阅读笔记

1.yarn test [文件名] -t [name-of-spec(describe or test )] 直接运行yarn test,会测试所有测试文件:yarn test 后面只跟文件名的话会 ...

- Linux系统进入redis并查询值

1.进入redisredis-cli -h ip -p port2.查看具体信息info 3.得到redis中存储的所有key值KEYS *4.获取指定key值的value值get "key ...

- 微信JSSDK的使用步骤

步骤一:绑定域名 先登录微信公众平台进入"公众号设置"的"功能设置"里填写"JS接口安全域名".(登录后可在"开发者中心" ...