DeepFool: a simple and accurate method to fool deep neural networks

@article{moosavidezfooli2016deepfool:,

title={DeepFool: A Simple and Accurate Method to Fool Deep Neural Networks},

author={Moosavidezfooli, Seyedmohsen and Fawzi, Alhussein and Frossard, Pascal},

pages={2574--2582},

year={2016}}

概

本文从几何角度介绍了一种简单而有效的方法.

主要内容

adversarial的目的:

\Delta(x;\hat{k}):= \min_{r} \|r\|_2 \: \mathrm{subject} \: \mathrm{to} \: \hat{k}(x+r) \not = \hat{k}(x),

\]

其中\(\hat{k}(x)\)为对\(x\)的标签的一个估计.

二分类模型

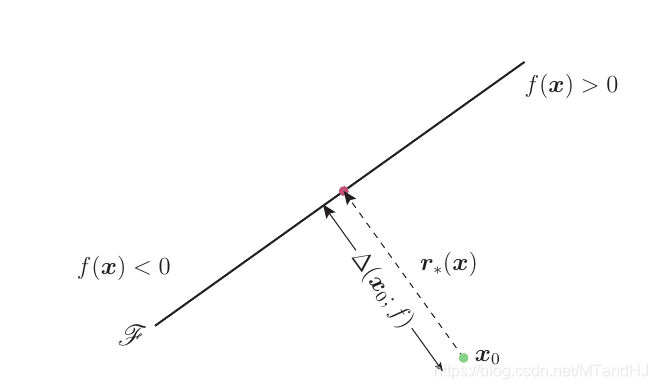

当模型是一个二分类模型时,

\]

其中\(f:\mathbb{R}^n \rightarrow \mathbb{R}\)为分类器, 并记\(\mathcal{F}:= \{x: f(x)=0\}\)为分类边界.

\(f\)为线性

即\(f(x)=w^Tx+b\):

假设\(x_0\)在\(f(x)>0\)一侧, 则

\]

\(f\)为一般二分类

此时, 我们\(f\)的一阶近似为

\]

此时分类边界为\(\mathcal{F} =\{x:f(x_0)+\nabla^T f(x_0) (x-x_0)=0\}\),此时\(w=\nabla f(x_0),b=f(x_0),\) 故

r_*(x_0) \approx -\frac{f(x_0)}{\|\nabla f(x_0)\|_2^2} \nabla f(x_0).

\]

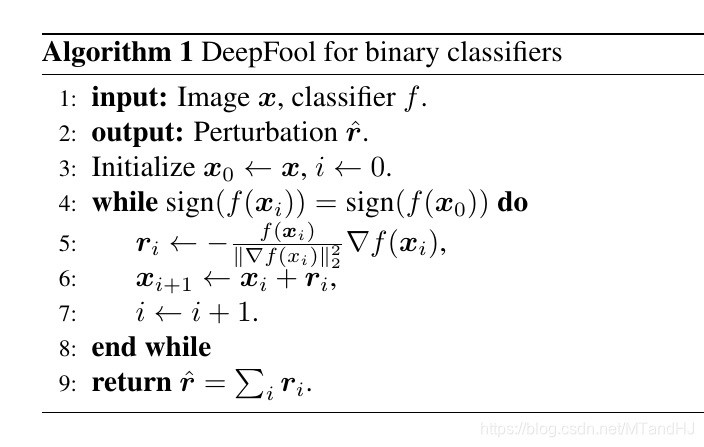

所以, 每次

x_{i+1} = x_i+r_i,

\]

直到\(\hat{k}(x_i) \not= \hat{k}(x_0)\)是停止, 算法如下

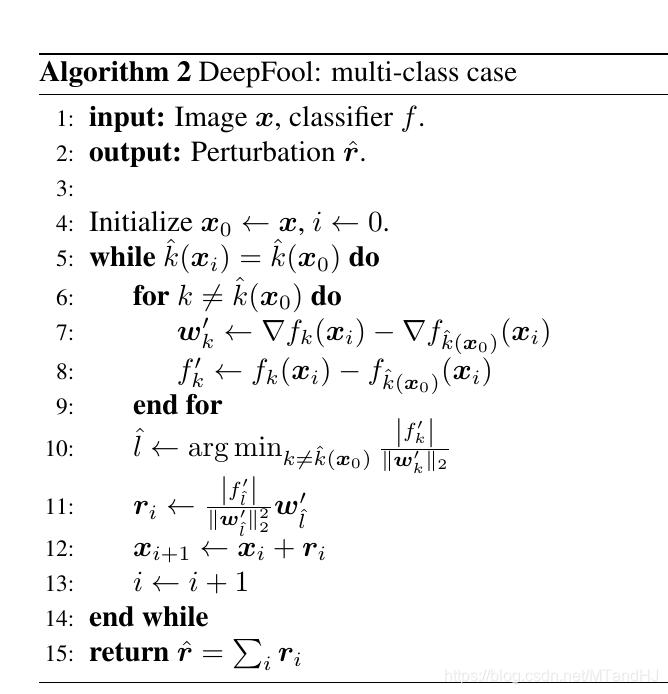

多分类问题

\(f:\mathbb{R}^n \rightarrow \mathbb{R}^c\), 此时

\hat{k}(x) = \arg \max_k f_k(x).

\]

\(f\)仿射

即\(f(x) = W^Tx + b\), 设\(W\)的第\(k\)行为\(w_k\),

P=\cap_{k=1}^c \{x: f_{\hat{k}(x_0)}(x) \ge f_k(x)\},

\]

为判定为\(\hat{k}(x_0)\)的区域, 则\(x+r\)应落在\(P^{c}\), 而

\]

当\(f\)为仿射的时候, 实际上就是找\(x_0\)到各分类边界(与\(x_0\)有关的)最短距离,

\hat{l}(x_0) = \arg \min _{k \not = \hat{k}(x_0)} \frac{|f_k(x_0) - f_{\hat{k}(x_0)}(x_0)|}{\|w_k-w_{\hat{k}(x_0)}\|_2},

\]

则

r_*(x_0)= \frac{|f_{\hat{l}(x_0)}(x_0) - f_{\hat{k}(x_0)}(x_0)|}{\|w_{\hat{l}(x_0)}-w_{\hat{k}(x_0)}\|_2^2}(w_{\hat{l}(x_0)}-w_{\hat{k}(x_0)}),

\]

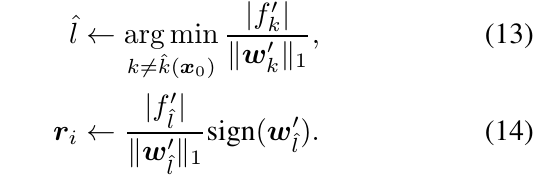

\(f\)为一般多分类

\tilde{P}_i=\cap_{k=1}^c \{x: f_{\hat{k}(x_0)}(x_i) + \nabla^T f_{\hat{k}(x_0)}(x_i) (x-x_i)\ge f_k(x_i) + \nabla^Tf_k(x_i)(x-x_i)\},

\]

则

\]

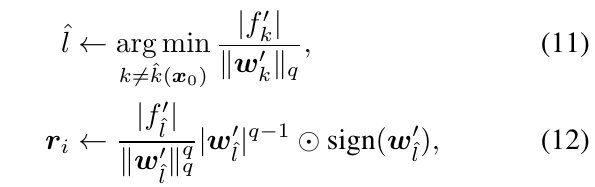

\(l_p\)

\(p \in (1, \infty)\)的时候

考虑如下的问题

\min & \|r\|_p^p \\

\mathrm{s.t.} & w^T(x+r)+b=0,

\end{array}

\]

利用拉格朗日乘子

\]

由KKT条件可知(这里的\(r_k\)表示第\(k\)个元素)

\]

注: 这里有一个符号的问题, 但是可以把符号放入\(c_k\)中进而不考虑,

故

\]

其中\(q=\frac{p}{p-1}\)为共轭指数, 并\(c=[c_1,\ldots]^T\),且\(|c_i|=|c_j|,\) 记\(w^{q-1}=[|w_1|^{q-1},\ldots]^T\),又

\]

故

\]

故

\]

\(p=1\), 设\(w\)的绝对值最大的元素为\(w_{m}\), 则

\]

\(\mathrm{1}_m\)为第\(m\)个元素为1, 其余元素均为0的向量.

\(p=\infty\),

\]

故:

\(p \in [1, \infty)\):

\(p=\infty\):

注: 因为, 仅仅到达边界并不足够, 往往希望更进一步, 所以在最后(?)\(x=x+ (1+\eta) r\), 文中取\(\eta=0.02\).

DeepFool: a simple and accurate method to fool deep neural networks的更多相关文章

- Dropout: A Simple Way to Prevent Neural Networks fromOverfitting

https://www.cs.toronto.edu/~hinton/absps/JMLRdropout.pdf Deep neural nets with a large number of par ...

- AUGMIX : A SIMPLE DATA PROCESSING METHOD TO IMPROVE ROBUSTNESS AND UNCERTAINTY

目录 概 主要内容 实验的指标 Dan Hendrycks, Norman Mu,, et. al, AUGMIX : A SIMPLE DATA PROCESSING METHOD TO IMPRO ...

- 论文笔记系列-Simple And Efficient Architecture Search For Neural Networks

摘要 本文提出了一种新方法,可以基于简单的爬山过程自动搜索性能良好的CNN架构,该算法运算符应用网络态射,然后通过余弦退火进行短期优化运行. 令人惊讶的是,这种简单的方法产生了有竞争力的结果,尽管只需 ...

- 小米造最强超分辨率算法 | Fast, Accurate and Lightweight Super-Resolution with Neural Architecture Search

本篇是基于 NAS 的图像超分辨率的文章,知名学术性自媒体 Paperweekly 在该文公布后迅速跟进,发表分析称「属于目前很火的 AutoML / Neural Architecture Sear ...

- PyNest——Part1:neurons and simple neural networks

neurons and simple neural networks pynest – nest模拟器的界面 神经模拟工具(NEST:www.nest-initiative.org)专为仿真点神经元的 ...

- 【论文阅读】DCAN: Deep Contour-Aware Networks for Accurate Gland Segmentation

DCAN: Deep Contour-Aware Networks for Accurate Gland Segmentation 作者:Hao Chen Xiaojuan Qi Lequan Yu ...

- simple factory, factory method, abstract factory

simple factory good:1 devide implementation and initialization2 use config file can make system more ...

- ThiNet: A Filter Level Pruning Method for Deep Neural Network Compression笔记

前言 致力于滤波器的剪枝,论文的方法不改变原始网络的结构.论文的方法是基于下一层的统计信息来进行剪枝,这是区别已有方法的. VGG-16上可以减少3.31FLOPs和16.63倍的压缩,top-5的准 ...

- 论文笔记——ThiNet: A Filter Level Pruning Method for Deep Neural Network Compreesion

论文地址:https://arxiv.org/abs/1707.06342 主要思想 选择一个channel的子集,然后让通过样本以后得到的误差最小(最小二乘),将裁剪问题转换成了优化问题. 这篇论文 ...

随机推荐

- Git命令行演练-团队开发

** 团队开发必须有一个共享库,这样成员之间才可以进行协作开发** ### 0. 共享库分类 > 本地共享库(只能在本地面对面操作) - 电脑文件夹/U盘/移动硬盘 & ...

- MySQL(1):SQLyog

数据库(DataBase,简称DB) 一. 基本数据库操作命令 flush privileges 刷新数据库 show databases 显示所有数据库 use dbname 打开某个数据库 sho ...

- 【Linux】【Services】【Package】rpm包制作

1. 概念 1.1. BUILD:源代码解压之后存放的位置 1.2. RPMS:制作完成之后的RPM包的存放位置,包括架构的子目录,比如x86,x86_64 1.3. SOURCES:所有的原材料都应 ...

- Spring Cloud简单项目创建

一.Zuul 原文链接 Zuul的主要功能是路由转发和过滤器.路由功能是微服务的一部分,比如/api/user转发到到user服务,/api/shop转发到到shop服务.zuul默认和Ribbon结 ...

- java中的迭代器的含义

可迭代是Java集合框架下的所有集合类的一种共性,也就是把集合中的所有元素遍历一遍.迭代的过程需要依赖一个迭代器对象,那么什么是迭代器呢? 迭代器(Iterator)模式,又叫做游标模式,它的含义是, ...

- 【MySQL】学生成绩

统计每个人的总成绩排名 select stu.`name`,sum(stu.score) as totalscore from stu GROUP BY `name` order by totalsc ...

- 【Matlab】imagesc的使用

imagesc(A) 将矩阵A中的元素数值按大小转化为不同颜色,并在坐标轴对应位置处以这种颜色染色 imagesc(x,y,A) x,y决定坐标范围 x,y应是两个二维向量,即x=[x1 x2],y= ...

- Web系统与自控系统数据通讯架构 之 OPC DA DataChangeEventHandler 非热点数据更新策略 ,

在使用OPC 采集 工控数据时,在DA模式下.采集数据通常用到 DataChangeEventHandler这个事件.但有时会遇到一些问题,就是当数据不变化时时不会触发 DataChange 这个事件 ...

- Python——连接数据库操作

一.数据库基础用法 要先配置环境变量,然后cmd安装:pip install pymysql 1.连接MySQL,并创建wzg库 #引入decimal模块 import pymysql #连接数据库 ...

- drone使用git tag作为镜像tag

官方自动tag plugin/docker 已支持自动标签,使用方法如下 steps: - name: docker image: plugins/docker settings: repo: foo ...