2.1-2.2 HBase数据存储

一、HBase数据检索流程

一篇介绍HBase数据读写流程的解析的博文:http://hbasefly.com/2016/12/21/hbase-getorscan/?wsfatm=uqvhl3

1、命名空间

##查看命名空间

hbase(main):001:0> list_namespace

NAMESPACE

2019-05-21 13:31:59,854 WARN [main] util.NativeCodeLoader: Unable to load native-hadoop library for your platform... using builtin-java classes where applicable

default

hbase ##查看命名空间下的表

hbase(main):003:0> list_namespace_tables 'hbase'

TABLE

meta

namespace

2 row(s) in 0.0260 seconds ##查看某个命名空间下的表数据

hbase(main):004:0> scan 'hbase:meta'

2、数据检索流程

#####

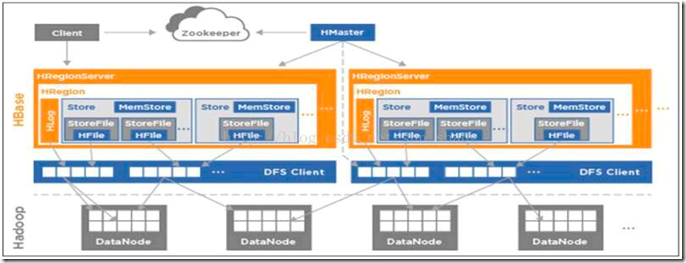

由图可以看出,存储模块主要包括了ZooKeeper集群、HMaster、HRegionServer。 ZooKeeper: Hbase是强依赖于ZooKeeper,我们读或写一个表的数据,都会优先访问ZooKeeper。 通常是集群中单独的3/5台服务器。 HMaster通常是Hadoop集群中的一台或两台(backup-Master)。 HRegionServer通常是Hadoop集群中的部分或全部, HRegionServer通常和datanode部署在同一台服务器上,比如datanode是10个HRegionServer可以是10个或小于10个; ##client--->server

1、客户端首先会根据配置文件中zookeeper地址连接zookeeper,并读取/<hbase-rootdir>/meta-region-server节点信息,该节点信息存储HBase元数据(hbase:meta)表所在的RegionServer地址以及访问端口等信息。用户可以通过zookeeper命令(get /<hbase-rootdir>/meta-region-server)查看该节点信息。 2、根据hbase:meta所在RegionServer的访问信息,客户端会将该元数据表加载到本地并进行缓存。然后在表中确定待检索rowkey所在的RegionServer信息。 3、根据数据所在RegionServer的访问信息,客户端会向该RegionServer发送真正的数据读取请求。服务器端接收到该请求之后需要进行复杂的处理,具体的处理流程将会是这个专题的重点。 通过上述对客户端以及HBase系统的交互分析,可以基本明确两点:

1、客户端只需要配置zookeeper的访问地址以及根目录,就可以进行正常的读写请求。不需要配置集群的RegionServer地址列表。 2、客户端会将hbase:meta元数据表缓存在本地,因此上述步骤中前两步只会在客户端第一次请求的时候发生,之后所有请求都直接从缓存中加载元数据。如果集群发生某些变化导致hbase:meta元数据更改,客户端再根据本地元数据表请求的时候就会发生异常,此时客户端需要重新加载一份最新的元数据表到本地。

2.1-2.2 HBase数据存储的更多相关文章

- 使用MapReduce读取HBase数据存储到MySQL

Mapper读取HBase数据 package MapReduce; import org.apache.hadoop.hbase.Cell; import org.apache.hadoop.hba ...

- BigData NoSQL —— ApsaraDB HBase数据存储与分析平台概览

一.引言 时间到了2019年,数据库也发展到了一个新的拐点,有三个明显的趋势: 越来越多的数据库会做云原生(CloudNative),会不断利用新的硬件及云本身的优势打造CloudNative数据库, ...

- HBase 数据存储结构

在HBase中, 从逻辑上来讲数据大概就长这样: 单从图中的逻辑模型来看, HBase 和 MySQL 的区别就是: 将不同的列归属与同一个列族下 支持多版本数据 这看着感觉也没有那么太大的区别呀, ...

- HBase数据存储

HRegionServer  HBase的数据文件都存储在HDFS上,格式主要有两种: - HFile:HBase中KeyValue数据的存储格式,HFile是Hadoop的二进制文件,实际上Sto ...

- hbase数据加盐(Salting)存储与协处理器查询数据的方法

转自: https://blog.csdn.net/finad01/article/details/45952781 ----------------------------------------- ...

- HBase介绍(2)---数据存储结构

在本文中的HBase术语:基于列:column-oriented行:row列组:column families列:column单元:cell 理解HBase(一个开源的Google的BigTable实 ...

- 万亿级日志与行为数据存储查询技术剖析——Hbase系预聚合方案、Dremel系parquet列存储、预聚合系、Lucene系

转自:http://www.infoq.com/cn/articles/trillion-log-and-data-storage-query-techniques?utm_source=infoq& ...

- Spark Streaming接收Kafka数据存储到Hbase

Spark Streaming接收Kafka数据存储到Hbase fly spark hbase kafka 主要参考了这篇文章https://yq.aliyun.com/articles/60712 ...

- 大数据存储利器 - Hbase 基础图解

由于疫情原因在家办公,导致很长一段时间没有更新内容,这次终于带来一篇干货,是一篇关于 Hbase架构原理 的分享. Hbase 作为实时存储框架在大数据业务下承担着举足轻重的地位,可以说目前绝大多数大 ...

随机推荐

- Can't open named pipe to host: . pipe: MySQL

今天遇到mysql连接odbc时报例如以下错误:Can't open named pipe to host: . pipe: MySQL 错误截图例如以下: 依照网上说的方法包含mysql的官方说法都 ...

- javascript 高级编程系列 - 继承

1. 原型链继承 (缺点:子类继承父类的引用类型的属性值会在各个实例中共享,创建子类实例时无法向父类构造函数传递参数) // 定义父类构造函数 function SuperClass(father, ...

- Linux kernel Wikipedia

http://en.wikipedia.org/wiki/Linux_kernel Development model The current development model of the Lin ...

- Day1 [上]- 认识Python

python简单介绍: python的创始人为吉多·范罗苏姆(Guido van Rossum).1989年的圣诞节期间,吉多·范罗苏姆为了在阿姆斯特丹打发时间,决心开发一个新的脚本解释程序,作为AB ...

- Docker在centos下安装以及常见错误解决

系列目录 Docker安装(使用阿里云镜像) Docker从1.13版本之后采用时间线的方式作为版本号,分为社区版CE和企业版EE. 社区版是免费提供给个人开发者和小型团体使用的,企业版会提供额外的收 ...

- C# 通过Hook的方法 屏蔽快捷键

#region 屏蔽Windows功能键(快捷键) public delegate int HookProc(int nCode, int wParam, IntPtr lParam ...

- 在Livemedia的基础上开发自己的流媒体客户端 V 0.01

在Livemedia的基础上开发自己的流媒体客户端 V 0.01 桂堂东 xiaoguizi@gmail.com 2004-10 2004-12 友情申明: 本文档适合已经从事流媒体传输工作或者对网络 ...

- 线程中调用Updatedata的问题

随便发个自定义消息,然后在 CMyDialog的自定义消息处理函数中 UpdateDate().因为 UpdateDate用到了线程本地存储.不能跨线程的 UpdateData只能在主线程中使用,将U ...

- Android自己定义控件--下拉刷新的实现

我们在使用ListView的时候.非常多情况下须要用到下拉刷新的功能.为了了解下拉刷新的底层实现原理,我採用自己定义ListView控件的方式来实现效果. 实现的基本原理是:自己定义ListView, ...

- funhub 独立游戏团队诚邀策划,美术,技术,QA 大大加入(可远程办公)

我们刚成立的的独立游戏团队,base:广州,团队陆陆续续已经有 6 个成员了,现在还缺的岗位有策划,美术.不过有其 他岗位的仁人志士也可加入. 另外,我们支持远程办公,这是互联网行业的天然优势,一定要 ...