用MapReduce读HBase写MongoDB样例

1、版本信息:

Hadoop版本:2.7.1

HBase版本:1.2.1

MongDB版本:3.4.14

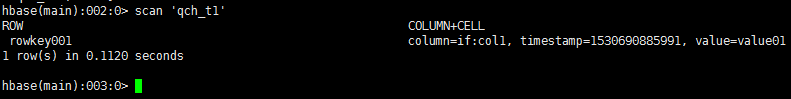

2、HBase表名及数据:

3、Maven依赖:

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>2.7.1</version>

</dependency>

<dependency>

<groupId>org.mongodb</groupId>

<artifactId>mongo-java-driver</artifactId>

<version>3.4.3</version>

</dependency>

<dependency>

<groupId>org.mongodb.mongo-hadoop</groupId>

<artifactId>mongo-hadoop-core</artifactId>

<version>2.0.2</version>

</dependency>

<dependency>

<groupId>org.apache.hbase</groupId>

<artifactId>hbase-client</artifactId>

<version>1.1.1</version>

</dependency>

<dependency>

<groupId>org.apache.hbase</groupId>

<artifactId>hbase-server</artifactId>

<version>1.1.1</version>

</dependency>

<dependency>

<groupId>org.apache.hbase</groupId>

<artifactId>hbase-common</artifactId>

<version>1.1.1</version>

</dependency>

4、MapReduce程序:

package mapreduce; import com.mongodb.BasicDBObject;

import com.mongodb.hadoop.MongoOutputFormat;

import com.mongodb.hadoop.io.BSONWritable;

import com.mongodb.hadoop.util.MongoConfigUtil;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.hbase.client.Result;

import org.apache.hadoop.hbase.client.Scan;

import org.apache.hadoop.hbase.io.ImmutableBytesWritable;

import org.apache.hadoop.hbase.mapreduce.TableMapReduceUtil;

import org.apache.hadoop.hbase.mapreduce.TableMapper;

import org.apache.hadoop.hbase.util.Bytes;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job; import java.io.IOException;

import java.util.UUID; public class HBaseToMongo {

public static void main(String[] args) throws Exception {

Long st = System.currentTimeMillis(); Configuration config = new Configuration();

config.set("dfs.socket.timeout", "180000");

config.set("hbase.zookeeper.property.clientPort", "2181");

config.set("hbase.zookeeper.quorum", "10.11.2.4,10.11.2.5,10.11.2.6"); // The format of the URI is:

// mongodb://[username:password@]host1[:port1][,host2[:port2],...[,hostN[:portN]]][/[database][?options]]

String uri = "mongodb://10.11.2.15:27017,10.11.2.16:27017,10.11.2.17:27017/postal.qch_test";

MongoConfigUtil.setOutputURI(config, uri); Job job = Job.getInstance(config);

job.setJobName("HBaseToMongo");

job.setJarByClass(FilterMapper.class);

job.setOutputFormatClass(MongoOutputFormat.class);

job.setNumReduceTasks(0);

TableMapReduceUtil.initTableMapperJob("qch_t1", new Scan(),

FilterMapper.class, ImmutableBytesWritable.class, BSONWritable.class, job); System.exit( job.waitForCompletion( true ) ? 0 : 1 );

System.out.println("HBaseToMongo:" + (System.currentTimeMillis() - st));

} static class FilterMapper extends TableMapper<Text, BSONWritable> {

@Override

protected void map(ImmutableBytesWritable key,

Result value, Context context) throws IOException, InterruptedException {

String col = getStrByByte(value.getValue("if".getBytes(), "col1".getBytes()));

BSONWritable bsonWritable = new BSONWritable();

BasicDBObject doc = new BasicDBObject();

doc.put("_id", UUID.randomUUID().toString());

doc.put("col", col);

bsonWritable.setDoc(doc);

context.write(new Text(key.toString()), bsonWritable);

} private String getStrByByte(byte[] by) {

String str = "";

if (by != null && by.length > 0) {

str = Bytes.toString(by);

}

return str;

}

}

}

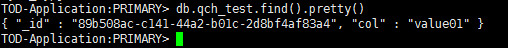

5、运行结果:

6、程序源码:

用MapReduce读HBase写MongoDB样例的更多相关文章

- Spark读HBase写MySQL

1 Spark读HBase Spark读HBase黑名单数据,过滤出当日新增userid,并与mysql黑名单表内userid去重后,写入mysql. def main(args: Array[Str ...

- HBase Filter程序样例及Shell(图)

==过滤器执行流程== reset() : reset the filter state before filtering a new row. filterAllRemaining(): true ...

- hbase java api样例(版本1.3.1,新API)

hbase版本:1.3.1 目的:HBase新API的使用方法. 尝试并验证了如下几种java api的使用方法. 1.创建表 2.创建表(预分区) 3.单条插入 4.批量插入 5.批量插入(客户端缓 ...

- Spring-boot+Spring-batch+hibernate+Quartz简单批量读文件写数据用例

本文程序集成了Spring-boot.Spring-batch.Spring-data-jpa.hibernate.Quartz.H2等.完整代码在Github上共享,地址https://github ...

- Java连接MongoDB样例

package com.moonlit.example; import com.mongodb.BasicDBObject; import com.mongodb.BulkWriteOperation ...

- MapReduce计算每年最大值测试样例生成程序

Demo.java package com.java; import java.io.BufferedWriter; import java.io.File; import java.io.FileW ...

- 使用SALT-API进入集成开发的简单样例

测试的时候,可以CURL -K,但真正作集成的时候,却是不可以的. 必须,不可以让TOKEN满天飞吧. 现在进入这个阶段了.写个样例先: import salt import salt.auth im ...

- hdu1011(树形背包)(提供一个特殊样例)

题目链接:http://acm.hdu.edu.cn/showproblem.php?pid=1011 Starship Troopers Time Limit: 10000/5000 MS (Jav ...

- hadoop学习;block数据块;mapreduce实现样例;UnsupportedClassVersionError异常;关联项目源代码

对于开源的东东,尤其是刚出来不久,我认为最好的学习方式就是能够看源代码和doc,測试它的样例 为了方便查看源代码,关联导入源代码的项目 先前的项目导入源代码是关联了源代码文件 block数据块,在配置 ...

随机推荐

- 6-20 No Less Than X in BST(20 分)

You are supposed to output, in decreasing order, all the elements no less than X in a binary search ...

- Spring boot启动原理

1.入口类 /** * springboot应用的启动入口 */ @RestController @SpringBootApplication public class SampleApplicati ...

- TVS 选型

TVS 选型 主要用于 IO 保护 TVS 的电压不要小于正常工作的电压,不然会影响正常工作. ESD 的电压很高,但是时间很短. TVS 有节电容,用于高速线路时要注意. 有双向的,也有单向的,还有 ...

- bzoj 3328 PYXFIB——单位根反演

题目:https://www.lydsy.com/JudgeOnline/problem.php?id=3328 单位根反演主要就是有 \( [k|n] = \frac{1}{k}\sum\limit ...

- 智能家居入门DIY——【五、执行命令】

前面几篇介绍了ESP8266使用AT命令来连接WIFI实现一系列功能.这一篇介绍一下使用Wemos D1 Wifi来进行开发,当然也可以用常见的8针ESP8266来完成(只是需要按网上的方法将Ardu ...

- redis位图

<?php function frstr($str){ return str_pad($str,8,'0',STR_PAD_LEFT); } $php=''; $p= frstr(decbin( ...

- python + docker, 实现天气数据 从FTP获取以及持久化(二)-- python操作MySQL数据库

前言 在这一节中,我们主要介绍如何使用python操作MySQL数据库. 准备 MySQL数据库使用的是上一节中的docker容器 “test-mysql”. Python 操作 MySQL 我们使用 ...

- pythonNetday06

进程 Process(target,name,args,kwargs) p.pid : 创建的新的进程的PID号 p.is_alive() 判断进程是否处于alive状态 p.daemon = Tru ...

- django-csrf_exempt

from django.views.decorators.csrf import csrf_exempt @csrf_exempt # 前端ajax请求时需要验证,否则403def fun(reque ...

- c# 二维码支持中文

/// <summary> /// 生成二维码,保存成图片 /// </summary> static void Generate1(string text) { Barcod ...