eclipse添加hadoop开发插件

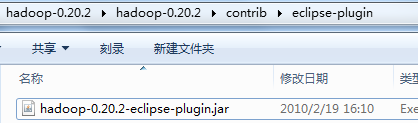

在开发hadoop的时候去查找了一下eclipse marketplace是没有找到hadoop的插件,上网又找了一下发现原来hadoop中其实是带有这样的插件的,

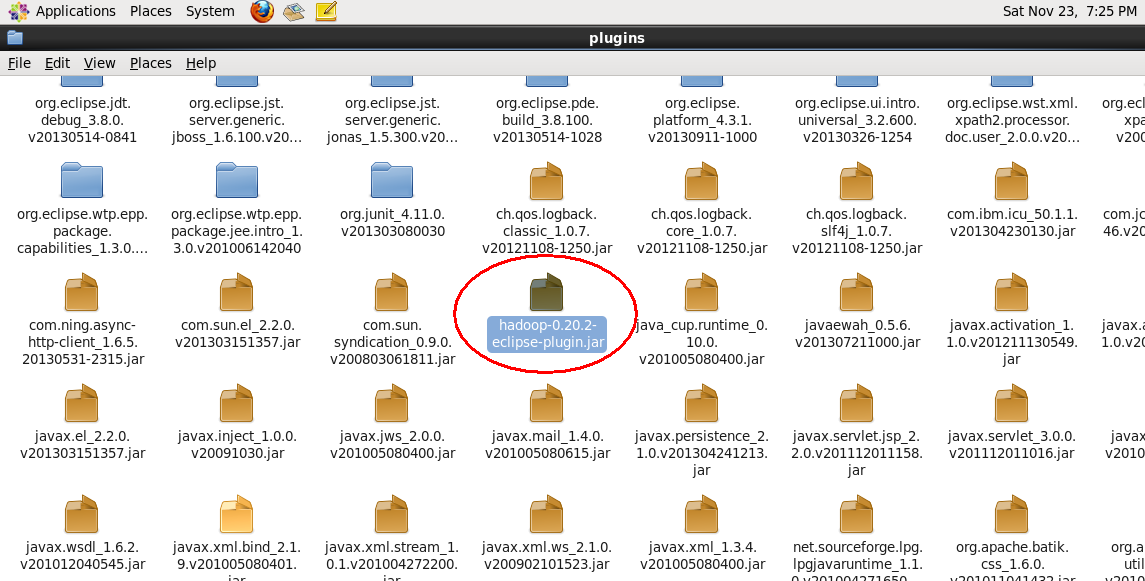

其实很简单只要将这个插件复制到eclipse/plugins目录下然后重启eclipse就可以了

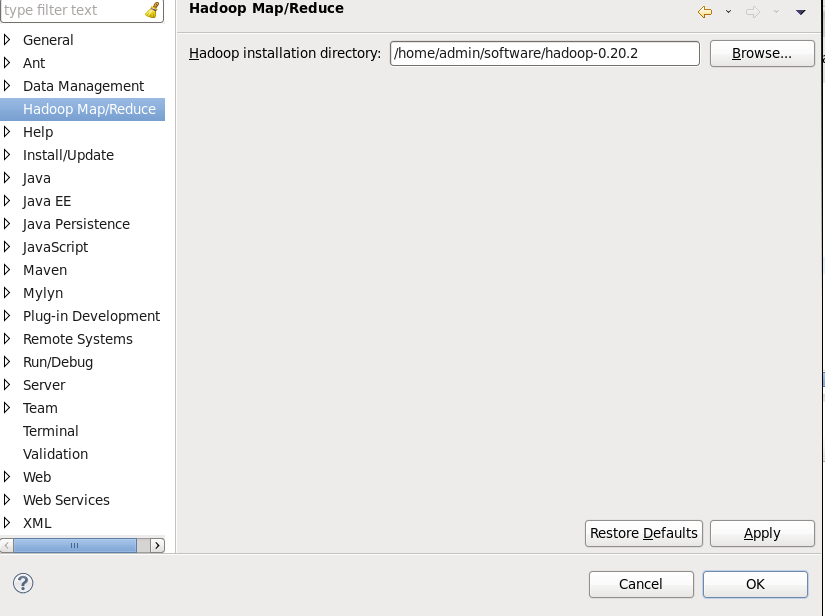

重启之后就可以看到eclipse == 》window ==》 preferences 可以看到多了一个Hadoop Map/Reduce 点击Browse按钮找到你的hadoop的解压目录如图:

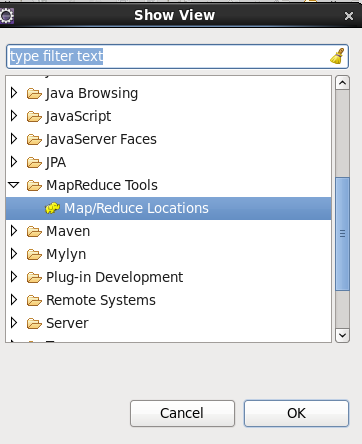

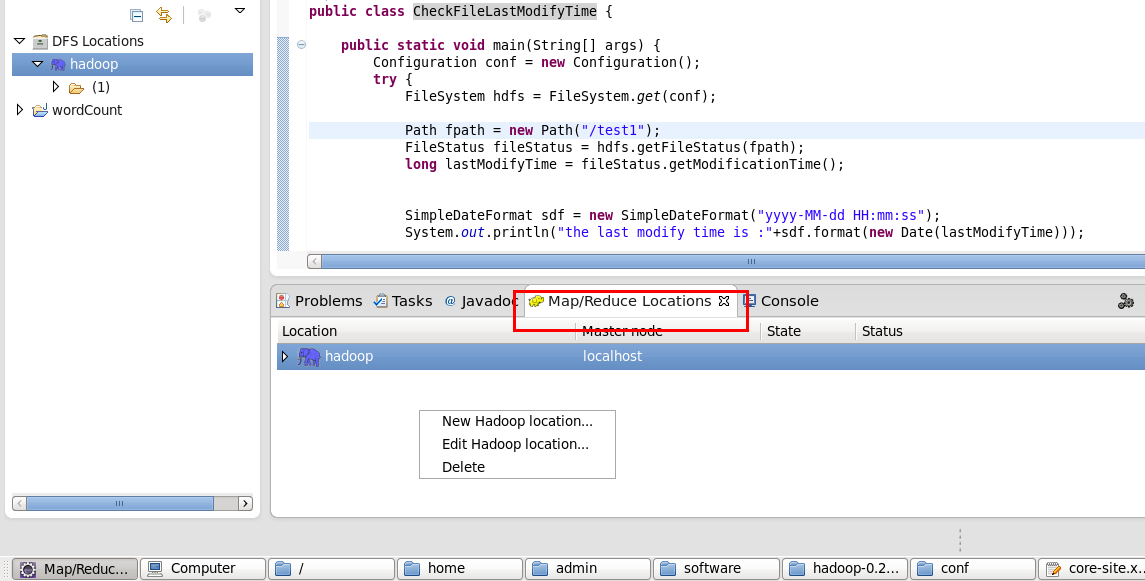

配置好了环境之后我们来创建一个本地连接,点击Windows==》show view ==》 other 选择MapReduce Tools ==》Map/Reduce Location

然后我们新建一个本地连接,这这里右键 New hadoop Location

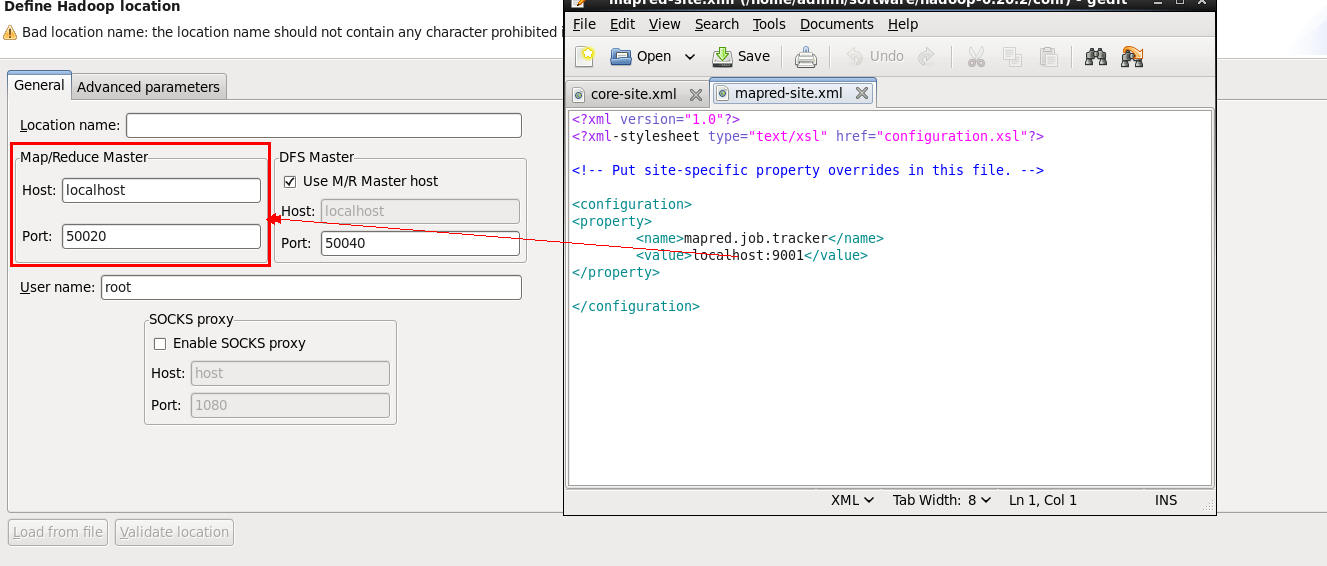

然后我们的配置host:这里的Map/Reduce Master对应hadoop配置文件中的mapred-site.xml

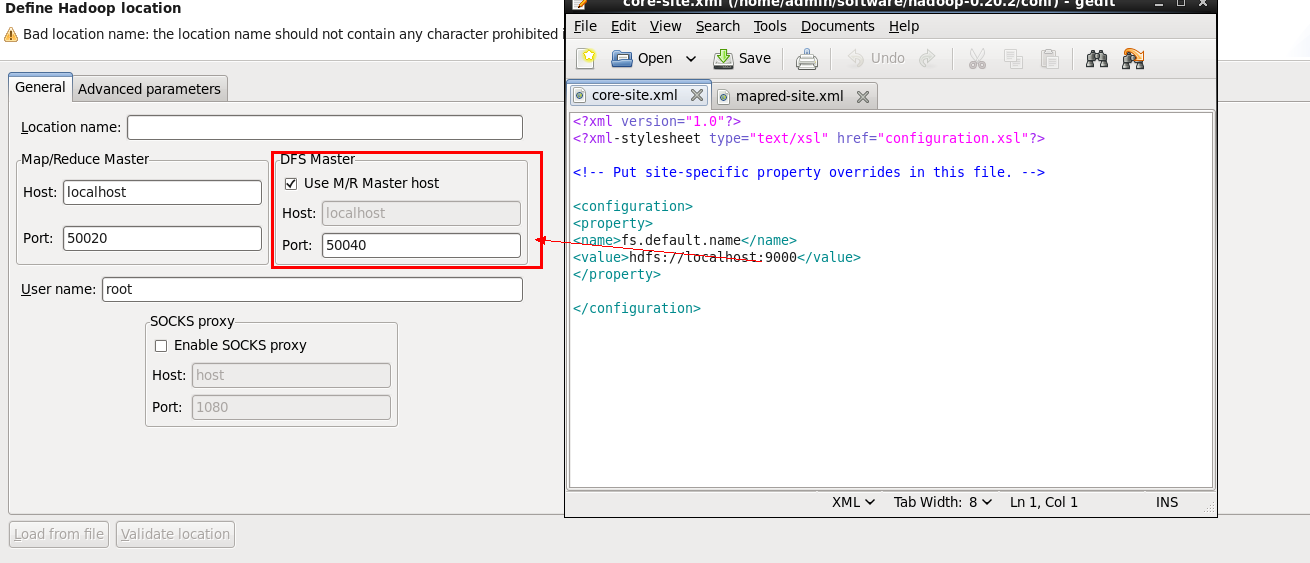

DFS Master的配置对应core-site.xml详细请看图

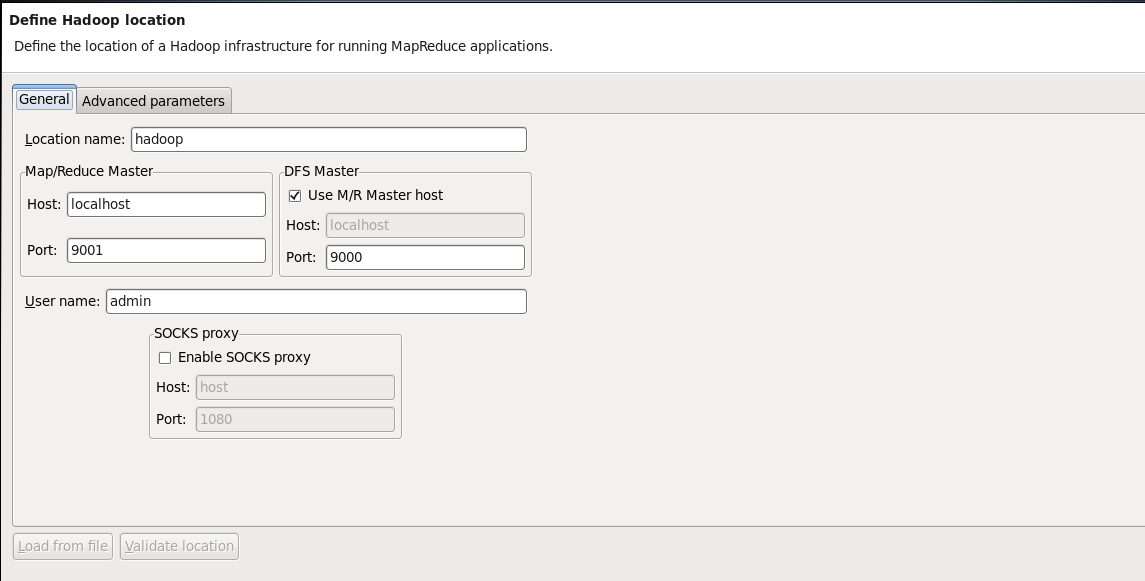

配置好后的应该是这样的:

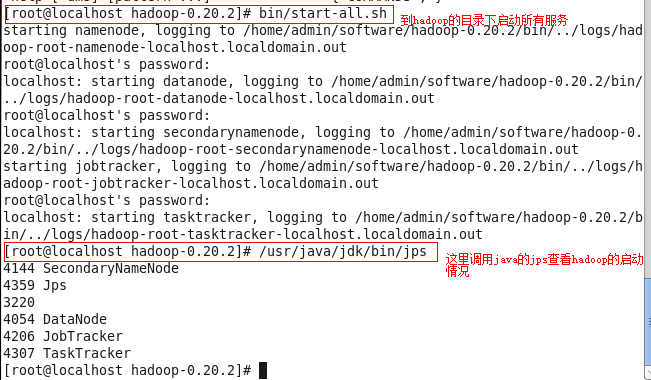

这里配置好之后我们可以启动hadoop来简单的测试一下

如果跟上面的输出信息一样证明正常启动了,如果没有正常启动估计是在配置的时候除了问题。下面我给几个简单的小测试程序可以运行一下

package com.hadoop.test; import java.io.IOException; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileStatus;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path; /**

* copy local file to hadoop system 将文件拷贝到HDFS

* @author root

*

*/

public class ConpyFile { public static void main(String[] args) {

//get local system configuration

Configuration conf = new Configuration();

try { FileSystem hdfs = FileSystem.get(conf); Path src = new Path("/home/admin/test3");

Path dst = new Path("/"); hdfs.copyFromLocalFile(src, dst);; FileStatus files[] = hdfs.listStatus(dst); for(int i = 0; i < files.length; i++){

System.out.println("status :"+files[i]);

}

} catch (IOException e) {

e.printStackTrace();

} } }

这里注意我的文件是已经创建的然后拷贝到hdfs上如果在上传的时候找不到文件可能跟linux下的权限有关系。建议修改权限就可以了。

package com.hadoop.test; import java.io.IOException; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataOutputStream;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path; /**

* create a hdfs file 创建hdfs文件

* @author root

*

*/

public class CreateHDFSFile { public static void main(String[] args) {

Configuration conf = new Configuration(); //获取系统的hadoop的配置环境

try {

FileSystem hdfs = FileSystem.get(conf);//获取文件系统对象

byte bytes[] = "Hello word !".getBytes();

Path dfs = new Path("/test");

FSDataOutputStream outputStream = hdfs.create(dfs);

outputStream.write(bytes, 0, bytes.length);

} catch (IOException e) {

// TODO Auto-generated catch block

e.printStackTrace();

} } }

重命名hadoop系统中的一个文件的名称:

package com.hadoop.test; import java.io.IOException; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path; /**

* rename hdfs file

* @author root

*

*/

public class ReNameHDFSFile { public static void main(String[] args) {

Configuration conf = new Configuration();

FileSystem hdfs;

try {

hdfs = FileSystem.get(conf);

Path frpath = new Path("/test3");

Path topath = new Path("/test1");

boolean isRename = hdfs.rename(frpath, topath);

System.out.println("rename is finish:"+isRename); } catch (IOException e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

}

}

检查文件的最后的修改时间:

package com.hadoop.test; import java.io.IOException;

import java.text.SimpleDateFormat;

import java.util.Date; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileStatus;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path; /**

* check hdfs file last modify time

* @author root

*

*/

public class CheckFileLastModifyTime { public static void main(String[] args) {

Configuration conf = new Configuration();

try {

FileSystem hdfs = FileSystem.get(conf); Path fpath = new Path("/test1");

FileStatus fileStatus = hdfs.getFileStatus(fpath);

long lastModifyTime = fileStatus.getModificationTime(); SimpleDateFormat sdf = new SimpleDateFormat("yyyy-MM-dd HH:mm:ss");

System.out.println("the last modify time is :"+sdf.format(new Date(lastModifyTime))); } catch (IOException e) {

// TODO Auto-generated catch block

e.printStackTrace();

} } }

eclipse添加hadoop开发插件的更多相关文章

- Ubuntu环境下eclipse的hadoop开发

在安装好hadoop伪分布式后,开始搭建eclipse的hadoop开发环境 我的版本信息如下: Ubuntu 版本 12.10 Hadoop版本 1.2.1 Java版本 1.6.0_31(命令j ...

- [原创] 毕设---在myeclipes中安装Hadoop开发插件

1.安装Hadoop开发插件 hadoop安装包contrib/目录下有个插件hadoop-0.20.2-eclipse-plugin.jar,拷贝到myeclipse根目录下/dropins目录下. ...

- 在ubuntu下使用Eclipse搭建Hadoop开发环境

一.安装准备1.JDK版本:jdk1.7.0(jdk-7-linux-i586.tar.gz)2.hadoop版本:hadoop-1.1.1(hadoop-1.1.1.tar.gz)3.eclipse ...

- JBPM学习第2篇:为Eclipse添加JBPM开发支持

1.Eclipse添加JBoss支持插件 参考:Eclipse添加JBoss支持 若已安装,直接跳过! 2.Eclipse添加Drools插件 jbpm-installer-full解压后的文件夹中找 ...

- 为Eclipse添加反编译插件,更好的调试

为Eclipse添加反编译插件,更好的调试 一般来说,我们的项目或多或少的都会引用一些外部jar包,如果可以查看jar包的源代码,对于我们的调试可以说是事半功倍. 1.下载并安装jad.exe.将ja ...

- 在windows环境中用eclipse搭建hadoop开发环境

1. 整体环境和设置 1.1 hadoo1.0.4集群部署在4台VMWare虚拟机中,这四台虚拟机都是通过NAT模式连接主机 集群中/etc/hosts文件配置 #本机127.0.0.1 localh ...

- 基于Eclipse搭建hadoop开发环境

一.基础环境准备 1.Eclipse 下载地址:http://pan.baidu.com/s/1slArxAP 2.JDK1.8 下载地址:http://pan.baidu.com/s/1i5iNy ...

- perl环境配置以及Eclipse安装perl开发插件

简介: 这篇文章将详细介绍 EPIC 组件的安装,EPIC 编辑环境,调试运行环境,着重介绍如何使用 EPIC 来快速.简便.准确地调试 Perl 语言程序,包括对于 Perl 程序的单步执行,断点用 ...

- eclipse基础及开发插件

Eclipse:http://www.eclipse.org/downloads/ Compare Package:http://www.eclipse.org/downloads/packages/ ...

随机推荐

- log4.net

1 简介 1.1Log4net的优点: 几乎所有的大型应用都会有自己的用于跟踪调试的API.因为一旦程序被部署以后,就不太可能再利用专门的调试工具了.然而一个管理员可能需要有一套强大的日志系统 ...

- Rstudio安装

1.https://www.r-project.org/下载R语言(注意32位还是46位系统). 2.安装R,尽量默认安装路径,安装路径不要有中文. 3.https://www.rstudio.com ...

- ThinkSNS插件的使用方法

1.插件包放到/addons/plugin/ 目录下. 2.自定义一个插件钩子:修改/apps/public/Tpl/default/Index/index.html,约在65行左右,添加下面钩子.{ ...

- ssh-keygen 无密码登陆需要注意一个问题

从今天开始记录一下工程上的小知识. ssh-keygen -t rsa cat id_rsa.pub >> authorized_keys后,切记,将authrorized_keys文件的 ...

- Codeforces Round #181 (Div. 2) B. Coach 带权并查集

B. Coach 题目连接: http://www.codeforces.com/contest/300/problem/A Description A programming coach has n ...

- 【项目实例】使用C#开发纽曼USB来电通来电弹屏客户端小结

基于CRM客户和咨询者的普遍需求,老板决定在CRM系统上加入来电弹屏功能,所谓来电弹屏,就是当一个电话打入时,电脑会弹出该电话号码对应的客户.联系人或者供应商详细信息,如果是新号码,则添加一个新的客户 ...

- python中import失败解决的简单办法

例如:import pkg_resources失败 可以print sys.path查看,从其他机器上cp -r过来即可,如下例子: 从另外一个正常的机器上scp过来/usr/ali/lib/pyth ...

- 【android开发】Android防止内存溢出浅析

近期项目做得差点儿相同了,測试出现了一些问题,当中一个就是内存溢出问题,在三星手机上測试最easy出现内存溢出,在其它手机上,比方华为就没有发生,也是比較郁闷.这个问题在之前的公司,做项目时也遇到过, ...

- 【JavaScript】重温Javascript继承机制

上段时间,团队内部有过好几次给力的分享,这里对西风师傅分享的继承机制稍作整理一下,适当加了些口语化的描述,留作备案. 一.讲个故事吧 澄清在先,Java和Javascript是雷锋和雷峰塔的关系.Ja ...

- java中无符号类型的处理

在Java中,不存在Unsigned无符号数据类型,但可以轻而易举的完成Unsigned转换. 方案一:如果在Java中进行流(Stream)数据处理,可以用DataInputStream类对Stre ...