Python实现结巴分词统计高频中文词汇

代码

1 # 读取文件

2 fn = open('youxi.txt', 'rt', encoding='utf-8') # 打开文件

3 string_data = fn.read() # 读出整个文件

4 fn.close() # 关闭文件

5

6 # 文本预处理

7 pattern = re.compile(u'\t|\n|\.|-|:|;|\)|\(|\?|"') # 定义正则表达式匹配模式

8 string_data = re.sub(pattern, '', string_data) # 将符合模式的字符去除

9

10 # 文本分词

11 seg_list_exact = jieba.cut(string_data, cut_all=False) # 精确模式分词

12 object_list = []

13

14 # 分词并去除停用词

15 remove_words = set()

16 fr = open('stopword.txt', encoding = 'UTF-8')

17 for word in fr:

18 remove_words.add(str(word).strip())

19 fr.close()

20

21 for word in seg_list_exact: # 循环读出每个分词

22 if word not in remove_words: # 如果不在去除词库中

23 object_list.append(word) # 分词追加到列表

24

25 # 词频统计

26 word_counts = collections.Counter(object_list) # 对分词做词频统计

27 word_counts_top10 = word_counts.most_common(100) # 获取前100最高频的词

28 print(word_counts_top10) # 输出检查

需要引入的库

1 import re # 正则表达式库

2 import collections # 词频统计库

3 import numpy as np # numpy数据处理库

4 import jieba # 结巴分词

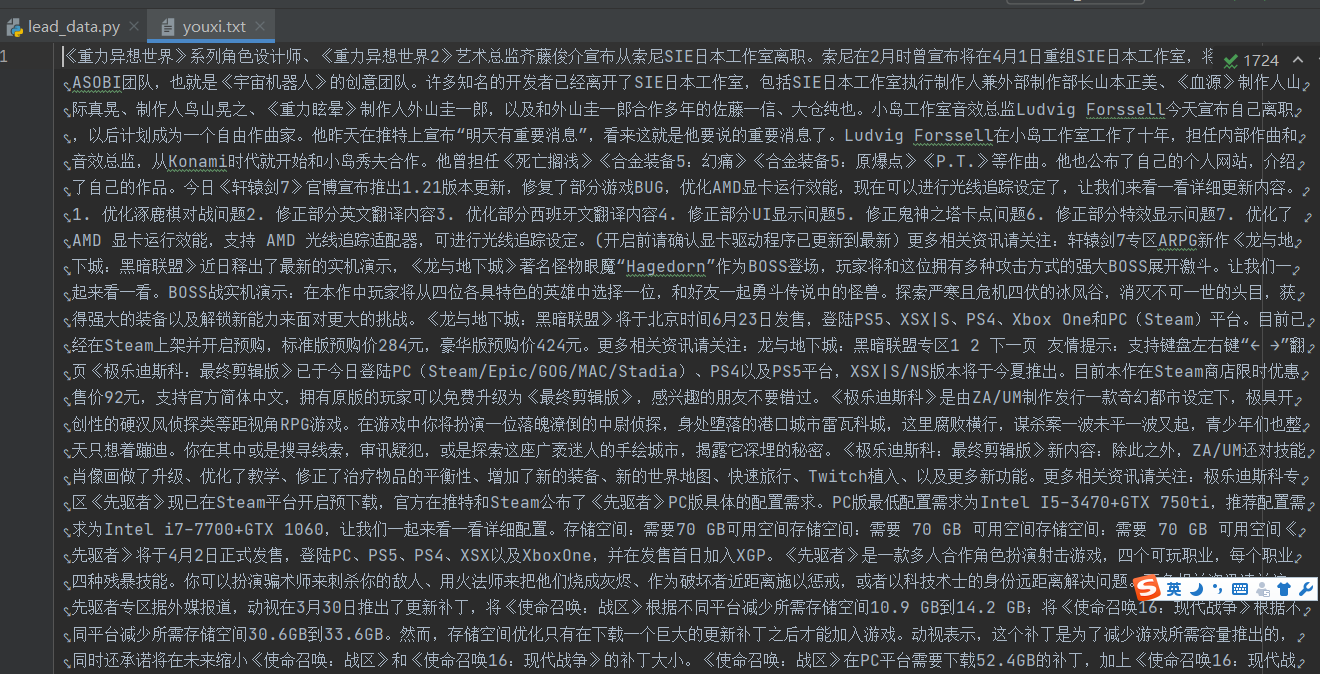

文件内容示例

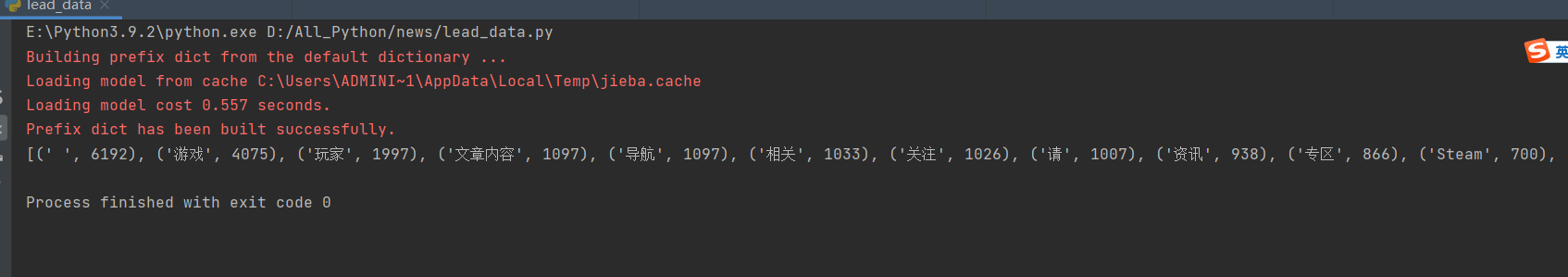

处理结果示例(前100)

Python实现结巴分词统计高频中文词汇的更多相关文章

- Python中结巴分词使用手记

手记实用系列文章: 1 结巴分词和自然语言处理HanLP处理手记 2 Python中文语料批量预处理手记 3 自然语言处理手记 4 Python中调用自然语言处理工具HanLP手记 5 Python中 ...

- 中文分词接口api,采用结巴分词PHP版中文分词接口

中文分词,分词就是将连续的字序列按照一定的规范重新组合成词序列的过程.我们知道,在英文的行文中,单词之间是以空格作为自然分界符的,而中文只是字.句和段能通过明显的分界符来简单划界,唯独词没有一个形式上 ...

- python中文分词:结巴分词

中文分词是中文文本处理的一个基础性工作,结巴分词利用进行中文分词.其基本实现原理有三点: 基于Trie树结构实现高效的词图扫描,生成句子中汉字所有可能成词情况所构成的有向无环图(DAG) 采用了动态规 ...

- python 中文分词:结巴分词

中文分词是中文文本处理的一个基础性工作,结巴分词利用进行中文分词.其基本实现原理有三点: 基于Trie树结构实现高效的词图扫描,生成句子中汉字所有可能成词情况所构成的有向无环图(DAG) 采用了动态规 ...

- Simple: SQLite3 中文结巴分词插件

一年前开发 simple 分词器,实现了微信在两篇文章中描述的,基于 SQLite 支持中文和拼音的搜索方案.具体背景参见这篇文章.项目发布后受到了一些朋友的关注,后续也发布了一些改进,提升了项目易用 ...

- 结巴分词和自然语言处理HanLP处理手记

手记实用系列文章: 1 结巴分词和自然语言处理HanLP处理手记 2 Python中文语料批量预处理手记 3 自然语言处理手记 4 Python中调用自然语言处理工具HanLP手记 5 Python中 ...

- python jieba分词(结巴分词)、提取词,加载词,修改词频,定义词库 -转载

转载请注明出处 “结巴”中文分词:做最好的 Python 中文分词组件,分词模块jieba,它是python比较好用的分词模块, 支持中文简体,繁体分词,还支持自定义词库. jieba的分词,提取关 ...

- 中文分词之结巴分词~~~附使用场景+demo(net)

常用技能(更新ing):http://www.cnblogs.com/dunitian/p/4822808.html#skill 技能总纲(更新ing):http://www.cnblogs.com/ ...

- Python 结巴分词(1)分词

利用结巴分词来进行词频的统计,并输出到文件中. 结巴分词github地址:结巴分词 结巴分词的特点: 支持三种分词模式: 精确模式,试图将句子最精确地切开,适合文本分析: 全模式,把句子中所有的可以成 ...

- 结巴(jieba)中文分词及其应用实践

中文文本分类不像英文文本分类一样只需要将单词一个个分开就可以了,中文文本分类需要将文字组成的词语分出来构成一个个向量.所以,需要分词. 这里使用网上流行的开源分词工具结巴分词(jieba),它可以有效 ...

随机推荐

- http 与 tcp 的一些学习

HTTP 是一个基于 TCP/IP 通信协议来传递数据的协议,传输的数据类型为 HTML 文件,.图片文件, 查询结果等. HTTP 协议一般用于 B/S 架构().浏览器作为 HTTP 客户端通过 ...

- VMware虚拟机Ubuntu系统如何占满整个屏幕

VMware虚拟机Ubuntu系统分辨率调节 桌面右击--Disoplay Settings 选择一个跟本机系统一样或者相近的.(本机小米笔记本win11,具体看自己的情况) 结束.

- springboot-@Async默认线程池导致OOM问题

目录 内存溢出的三种类型: 初步分析: 代码分析: 最终解决办法: 内存溢出的三种类型: 第一种OutOfMemoryError: PermGen space,发生这种问题的原意是程序中使用了大量的j ...

- 揭秘可视化图探索工具 NebulaGraph Explore 是如何实现图计算的

前言 在可视化图探索工具 NebulaGraph Explorer 3.1.0 版本中加入了图计算工作流功能,针对 NebulaGraph 提供了图计算的能力,同时可以利用工作流的 nGQL 运行能力 ...

- RocketMQ(8) 消费幂等

1 什么是消费幂等 当出现消费者对某条消息重复消费的情况时,重复消费的结果与消费一次的结果是相同的,并且多次消 费并未对业务系统产生任何负面影响,那么这个消费过程就是消费幂等的. 幂等:若某操作执行多 ...

- Java 数组嵌套

1 public static void main(String[] args) 2 { 3 int[] arr = new int[] {8,6,3,1,9,5,4,7}; 4 int[] inde ...

- CPNtools协议建模安全分析---实例(三)

对于复杂的系统的建模或者协议的建模,各种颜色集的定义以及变量的声明很重要,要区分明确,对于函数行业进程的定义更加复杂.CPN对协议的描述只适合简单逻辑性的协议分析,如果协议包括复杂的算法,那么CPN就 ...

- 获取input[type="checkbox"]:checked 所在tr中特定元素

1.要求如下 2.html源码 <div class="btn"> <button type="button" onclick=" ...

- obs 录制教程 手机录屏用 向日葵 手机投屏 能用有线用有线的连接

obs 录制教程 手机录屏用 向日葵 手机投屏 稍微有点卡 华为手机有个投屏 笔记本不支持这个 miracast 淘宝有卖 投屏设备的,搜 miracast 100多米 免费的就用向日葵就得了. 最新 ...

- viewui tree 自定义化(源码copy出来改动)#添加 获取selected 解决方案

需求: 对树有title的点击效果,右侧有说明文字 和 按钮能点击,不能右键,系统用的壳已经有右键了. 出现的问题: viewui的tree有两年没更新了,对ui这块,是采取的render自定义,但是 ...