Paper | LISTEN, ATTEND AND SPELL: A NEURAL NETWORK FOR LARGE VOCABULARY CONVERSATIONAL SPEECH RECOGNITION

本文提出了一个基于神经网络的语音识别系统List, Attend and Spell(LAS),能够将语音直接转录为文字。

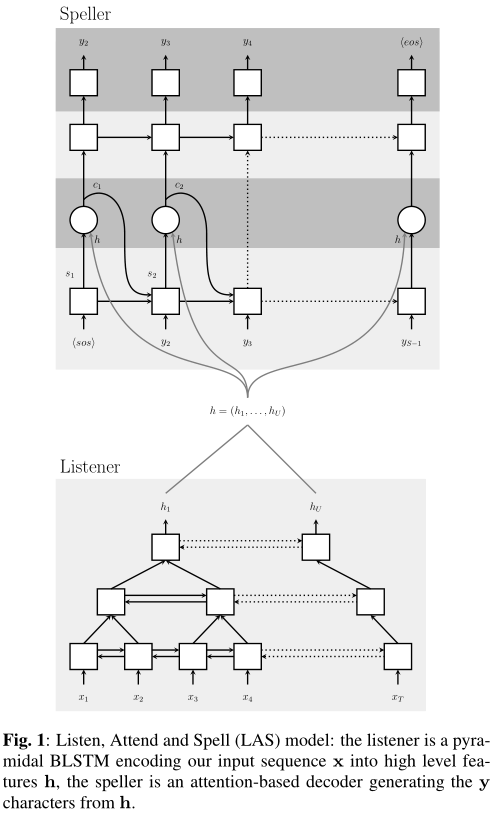

进步性:LAS将声学、发音和语言模型融合为一个神经模型,因此可以实现端到端。LAS只包含两部分:收听器(listener)和拼写器(speller)。收听器是一个金字塔循环网络编码器,拼写器是一个基于注意力机制的循环网络解码器。

1. 相关工作

当前最先进的语音识别器包含多个组分:声学模型、语言模型、发音模型和文本规范化模型。每个模型都有各自的假设和概率模型。也有工作尝试让这些组分联合训练,但一般是前端的声学模型会被迭代,后端的语言、发音和文本模型基本不变。

2. 方法细节

LAS的输入是一系列被过滤出来的bank spectra特征,输出是一系列字母、数字、标点符号、语气或未知符号。

LAS的基本方法是:在收听器,声音信号被编码为特征;拼写器根据 特征 以及 过去所有时刻的输出,依照条件概率的链式法则,来推断输入和输出符号之间的条件概率,然后选择条件概率最大者作为输出。

核心公式就是两个:

\[

\mathbf{h} = \text{Listen} (\mathbf{x})

\]

\[

P(y_i | \mathbf{x}, y_{<i}) = \text{AttendAndSpell} (y_{<i}, \mathbf{h})

\]

从图上就能观察出这两个公式。

2.1 收听器

整体框架如图,是一个金字塔形的多层双向LSTM结构。为什么不直接用LSTM呢?作者发现BiLSTM收敛巨慢无比,而且效果还不好。【看来应该是因为时间步太多导致收敛慢,因为每个时间步的输入差异大。因为有些句子单词很多】

在这个金字塔形BiLSTM中,每层的时间步数目会依次减半。实验中设了3层BiLSTM。

2.2 注意力和拼写

这里采用的是结合了注意力机制的单向LSTM。如图:

每一时刻的上下文向量由 特征向量 和 该时刻的状态向量 共同决定的:

\[

c_i = \text{AttentionContext} (s_i, \mathbf{h})

\]每一时刻的状态向量由 上一时刻的状态向量、上一时刻的输出 和 上一时刻的环境向量 共同决定:

\[

s_i = \text{RNN} (s_{i-1}, y_{i-1}, c_{i-1})

\]

那么具体这个上下文是怎么算的呢?其实是简单的加权组合:

\[

c_i = \sum_u \alpha_{i,u} h_u

\]

\(h_u\)就是第\(u\)个特征。而权重\(\alpha_{i,u}\)是将\(s_i\)和\(h_u\)分别输入MLP后,算内积得到的。注意最后所有的\(\alpha_{i,u}\)要输入softmax归一化。

在训练后,\(\alpha_{i,u}\)通常会收敛到某些\(u\)附近,即只与少数的\(h_u\)有关。

其他细节就不管了,因为我们也不做这个。

Paper | LISTEN, ATTEND AND SPELL: A NEURAL NETWORK FOR LARGE VOCABULARY CONVERSATIONAL SPEECH RECOGNITION的更多相关文章

- 语音识别2 -- Listen,Attend,and Spell (LAS)

LAS是Listen(Encoder),Attend,和Spell(Decoder)的简称 第一个步骤Listen(Encoder) listen的作用是输入一段语音信号,输出一段向量,去掉语音中的杂 ...

- Paper: ImageNet Classification with Deep Convolutional Neural Network

本文介绍了Alex net 在imageNet Classification 中的惊人表现,获得了ImagaNet LSVRC2012第一的好成绩,开启了卷积神经网络在cv领域的广泛应用. 1.数据集 ...

- 读paper:Deep Convolutional Neural Network using Triplets of Faces, Deep Ensemble, andScore-level Fusion for Face Recognition

今天给大家带来一篇来自CVPR 2017关于人脸识别的文章. 文章题目:Deep Convolutional Neural Network using Triplets of Faces, Deep ...

- (转)How Transformers Work --- The Neural Network used by Open AI and DeepMind

How Transformers Work --- The Neural Network used by Open AI and DeepMind Original English Version l ...

- (zhuan) Recurrent Neural Network

Recurrent Neural Network 2016年07月01日 Deep learning Deep learning 字数:24235 this blog from: http:/ ...

- (转)The Neural Network Zoo

转自:http://www.asimovinstitute.org/neural-network-zoo/ THE NEURAL NETWORK ZOO POSTED ON SEPTEMBER 14, ...

- Recurrent Neural Network(循环神经网络)

Reference: Alex Graves的[Supervised Sequence Labelling with RecurrentNeural Networks] Alex是RNN最著名变种 ...

- 论文笔记之:Progressive Neural Network Google DeepMind

Progressive Neural Network Google DeepMind 摘要:学习去解决任务的复杂序列 --- 结合 transfer (迁移),并且避免 catastrophic f ...

- 深度神经网络如何看待你,论自拍What a Deep Neural Network thinks about your #selfie

Convolutional Neural Networks are great: they recognize things, places and people in your personal p ...

随机推荐

- Git仓库分支管理

#前提条件:#一.使用命令“cd /d/BranchMgr”进入到需要进行分支管理的仓库的目录,“/d/BranchMgr”是仓库路径.如下图: ”Administrator@DESKTOP-VL6G ...

- SpringCloudGateWay修改请求路径,从注册中心获得服务

SpringCloudGateWay修改请求路径,从注册中心获得服务 @Resource private DiscoveryClient disClient; @Resource p ...

- python 基础学习笔记(8)--装饰器

**装饰器** - [ ] 装饰器和闭包有很大的联系.有时你需要在不改变源代码的情况下修改已经存在的函数.装饰器的运用可以提高效率,减少重复的代码. - [ ] 装饰器的实质是一个函数.它把一个函数作 ...

- Spring学习的第二天

第二天总共学习了以下内容: spring中的ioc常用注解: 案例使用xml方式和注解方式实现单表的CRUD操作(但还是需要xml配置文件,并不是纯注解的配置): 改造基于注解的Ioc案例,使用纯注解 ...

- excel文字随单元格大小变化

对于不想因为伸缩等,造成部分文字看不见 或者 格式变形等,可以采用缩小字体或适应文字: 1.excel中可以选择缩小字体填充,这样,缩小excel就不怕了: 2.word中,excel表设置适应文字 ...

- docker-19.03安装部署,阿里源加速

docker所依赖的包环境,为了方便不报错,推荐执行 [root@liujunjun ~]# yum install -y yum-utils device-mapper-persistent-dat ...

- 一些你不知道的js特性【一】

关于js 我们知道完整的js包括三个方面ECMAScript.DOM(文档对象模型).BOM(浏览器对象模型). ECMAScript定义了与宿主无关的预言基础,比如:语法(包含正则语法).类型.语句 ...

- Springcloud 中 SpringBoot 配置全集 (收藏版)

Springcloud 中 SpringBoot 配置全集 (收藏版) 疯狂创客圈 Java 高并发[ 亿级流量聊天室实战]实战系列 [博客园总入口 ] 前言 疯狂创客圈(笔者尼恩创建的高并发研习社群 ...

- Redis缓存与数据库一致性解决方案

背景 缓存是数据库的副本,应用在查询数据时,先从缓存中查询,如果命中直接返回,如果未命中,去数据库查询最新数据并返回,同时写入缓存. 缓存能够有效地加速应用的读写速度,同时也可以降低后端负载.是应用架 ...

- 【AGC035F】Two Histograms

Problem Description 你有一个 \(N\) 行.\(M\) 列的.每个格子都填写着 0 的表格.你进行了下面的操作: 对于每一行 \(i\) ,选定自然数 \(r_i\) (\(0\ ...