Hadoop集群搭建-HA高可用(手动切换模式)(四)

步骤和集群规划

1)保存完全分布式模式配置

2)在full配置的基础上修改为高可用HA

3)第一次启动HA

4)常规启动HA

5)运行wordcount

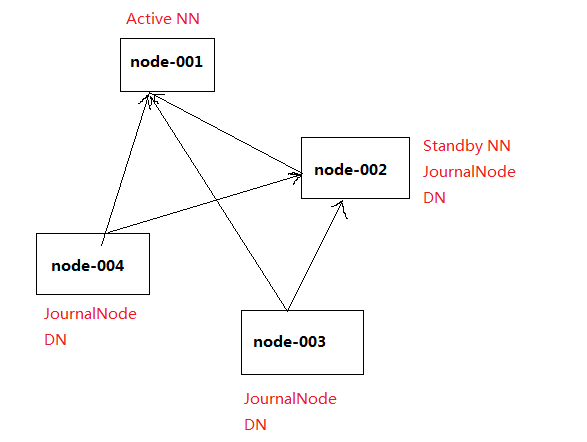

集群规划:

centos虚拟机:node-001、node-002、node-003、node-004

node-001:Active NN、JournalNode、resourcemanger

node-002:Standby NN、DN、JournalNode、nodemanger

node-003:DN、JournalNode、nodemanger

node-004:DN、JournalNode、nodemanger

一、保存full完全分布式配置

cp -r hadoop/ hadoop-full

二、修改配置成为HA(yarn部署)

主要修改core-site.xml、hdfs-site.xml、yarn-site.xml

1.修改core-site.xml文件

<configuration> <property>

<name>fs.defaultFS</name>

<value>hdfs://mycluster</value>

</property> </configuration>

2.修改hdfs-site.xml

<configuration>

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

<!--定义nameservices逻辑名称-->

<property>

<name>dfs.nameservices</name>

<value>mycluster</value>

</property>

<!--映射nameservices逻辑名称到namenode逻辑名称-->

<property>

<name>dfs.ha.namenodes.mycluster</name>

<value>nn1,nn2</value>

</property>

<!--映射namenode逻辑名称到真实主机名称(RPC)-->

<property>

<name>dfs.namenode.rpc-address.mycluster.nn1</name>

<value>node-001:8020</value>

</property>

<!--映射namenode逻辑名称到真实主机名称(RPC)-->

<property>

<name>dfs.namenode.rpc-address.mycluster.nn2</name>

<value>node-002:8020</value>

</property>

<!--映射namenode逻辑名称到真实主机名称(HTTP)-->

<property>

<name>dfs.namenode.http-address.mycluster.nn1</name>

<value>node-001:50070</value>

</property>

<!--映射namenode逻辑名称到真实主机名称(HTTP)-->

<property>

<name>dfs.namenode.http-address.mycluster.nn2</name>

<value>node-002:50070</value>

</property> <property>

<name>dfs.namenode.name.dir</name>

<value>file:///home/lims/bd/hdfs/name</value>

<description>Determines where on the local filesystem the DFS name node

should store the name table(fsimage). If this is a comma-delimited list

of directories then the name table is replicated in all of the

directories, for redundancy. </description>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:///home/lims/bd/hdfs/data</value>

<description>Determines where on the local filesystem an DFS data node

should store its blocks. If this is a comma-delimited

list of directories, then data will be stored in all named

directories, typically on different devices.

Directories that do not exist are ignored.

</description>

</property> <!--配置journalnode集群位置信息及目录-->

<property>

<name>dfs.namenode.shared.edits.dir</name>

<value>qjournal://node-002:8485;node-003:8485;node-004:8485/mycluster</value>

</property>

<property>

<name>dfs.journalnode.edits.dir</name>

<value>/home/lims/bd/hdfs/journal</value>

</property>

<!--配置故障切换实现类-->

<property>

<name>dfs.client.failover.proxy.provider.mycluster</name>

<value>org.apache.hadoop.hdfs.server.namenode.ha.ConfiguredFailoverProxyProvider</value>

</property>

<!--指定切换方式为SSH免密钥方式-->

<property>

<name>dfs.ha.fencing.methods</name>

<value>sshfence</value>

</property>

<property>

<name>dfs.ha.fencing.ssh.private-key-files</name>

<value>/home/lims/.ssh/id_dsa</value>

</property>

<!--设置自动切换-->

<property>

<name>dfs.ha.automatic-failover.enabled.mycluster</name>

<value>false</value>

</property>

</configuration>

3.用scp分发到各个节点

scp hadoop/* lims@node-002:/home/lims/bd/hadoop-2.8.5/etc/hadoop

scp hadoop/* lims@node-003:/home/lims/bd/hadoop-2.8.5/etc/hadoop

scp hadoop/* lims@node-004:/home/lims/bd/hadoop-2.8.5/etc/hadoop

三、第一次启动HA

1)分别在node-002,node-003,node-004三个节点启动journalnode

hadoop-daemon.sh start journalnode

2)在node-001上格式化namenode

hdfs namenode -format

3)在node-001上启动namenode

hadoop-daemon.sh start namenode

4)在node-002,即另一台namenode上同步nn1的CID等信息

hdfs namenode -bootstrapStandby

5)在node-001上启动其他服务

start-dfs.sh

5)手动切换node-001为active状态

hdfs haadmin -transitionToActive nn1

四、常规启动HA

1)启动hdfs

start-dfs.sh

2)启动yarn

start-yarn.sh

Hadoop集群搭建-HA高可用(手动切换模式)(四)的更多相关文章

- EMQ集群搭建实现高可用和负载均衡(百万级设备连接)

一.EMQ集群搭建实现高可用和负载均衡 架构服务器规划 服务器IP 部署业务 作用 192.168.81.13 EMQTTD EMQ集群 192.168.81.22 EMQTTD EMQ集群 192. ...

- Flink 集群搭建,Standalone,集群部署,HA高可用部署

基础环境 准备3台虚拟机 配置无密码登录 配置方法:https://ipooli.com/2020/04/linux_host/ 并且做好主机映射. 下载Flink https://www.apach ...

- Redis操作及集群搭建以及高可用配置

NoSQL - Redis 缓存技术 Redis功能介绍 数据类型丰富 支持持久化 多种内存分配及回收策略 支持弱事务 支持高可用 支持分布式分片集群 企业缓存产品介绍 Memcached: 优点:高 ...

- 2-20 MySQL集群搭建实现高可用

MySQL集群概述和安装环境 MySQL Cluster是MySQL适合于分布式计算环境的高实用.高冗余版本.Cluster的汉语是"集群"的意思.它采用了NDB Cluster ...

- Storm集群开启HA高可用

Storm开启HA高可用,包括Nimbus和UI开启两个及以上的进程. 基于已经安装好的Storm集群,开启关键节点角色的HA高可用. Storm安装请参考Storm集群安装Version1.0.1 ...

- flink的集群的HA高可用

对于一个企业级的应用,稳定性是首要要考虑的问题,然后才是性能,因此 HA 机制是必不可少的: 和 Hadoop 一代一样,从架构中我们可以很明显的发现 JobManager 有明显的单点问题(SPOF ...

- activeMQ集群搭建及高可用

三台服务器搭建如下的集群,达到了高可用.也同时达到了负载的目的: /****************************************************************** ...

- Redis5以上版本伪集群搭建(高可用集群模式)

redis集群需要至少要三个master节点,我们这里搭建三个master节点,并且给每个master再搭建一个slave节点,总共6个redis节点,这里用一台机器(可以多台机器部署,修改一下ip地 ...

- Hadoop 集群搭建和维护文档

一.前言 -- 基础环境准备 节点名称 IP NN DN JNN ZKFC ZK RM NM Master Worker master1 192.168.8.106 * * * * * * maste ...

随机推荐

- javascript闭包学习

(function(){})()===>>>>函数会被立即执行function(){}是一个函数用括号包起来表示是函数表达式再加()表示函数自执行 如何理解闭包?1.定义和用 ...

- 关于 X509Certificate2 程序发布IIS后找不到文件路径的问题

有很多支付类.物联网等平台调用接口时需要用到证书: 通过X509Certificate2 类加载证书在程序发布之后发现无法找到证书路径,但是通过文件查找方法又可以检测到该文件. X509Certifi ...

- 关于CSRF

CSRF介绍 CSRF(Cross-site request forgery)跨站请求伪造,也被称为“One Click Attack”或者Session Riding,通常缩写为CSRF或者XSRF ...

- python 对Excel表格的写入

python对Excel表格写入需要导入xlrd ,和xlutils两个库 from xlrd import open_workbook from xlutils.copy import copy o ...

- hibernate-第一章-基础

一,简介 hibernate是一个开源的ORM框架,它对我们的jdbc进行了轻量级的对象封装,它将我们的POJO与数据库表简历映射关系,是一个全自动的ORM框架;hibernate可以自动生成SQL语 ...

- JS中函数常见的表现形式以及立即执行函数

函数常见的几种表现形式: 1.一般形式(函数声明): 会进行函数的预解释,函数会进行声明和定义,在函数体前面或则后面都可以进行调用. 2.函数表达式(匿名函数): 会进行函数的预解析,函数会进行声明但 ...

- HttpListener 实现web服务器

一.使用方法 1. Start()方法 允许此实例接受传入的请求.即开始监听 2. Stop()方法 处理完所有当前排队的请求后关闭HttpListener对象 3. GetContext()方法 ...

- .net基础学java系列(八)SpringBoot

嘟嘟独立博客 Spring-Boot干货系列 http://tengj.top/categories/Spring-Boot干货系列/ 龙码精神 Java Spring Boot VS .NetCor ...

- Delphi 10.3版本获取windows系统版本和CPU信息

procedure TForm1.Button1Click(Sender: TObject); var mm:TRegistry; cpu:string; begin mm:=TRegistry.Cr ...

- 向mysql中导入向导时如表xlsx

如果出现这种问题那么是因为没有打开这个文件,如果想导入这个文件需要到开这个文件,然后再导入