NLP相似度之tf-idf计算

当然,在学习过程中也是参考了很多其他的资料,代码都是一行一行敲出来的。

一、将多个文件合并成一个文件,避免频繁的打开和关闭

import sys for line in sys.stdin:

ss = line.strip().split('\t')

file_name = ss[0].strip()

file_context = ss[1].strip()

word_list = file_context.split(' ') word_set = set()

for word in word_list:

word_set.add(word) for word in word_set:

print '\t'.join([word, ''])

执行命令:就可以得到合并后的文件啦!!!

python convert.py input_tfidf_dir/ > merge_files.data

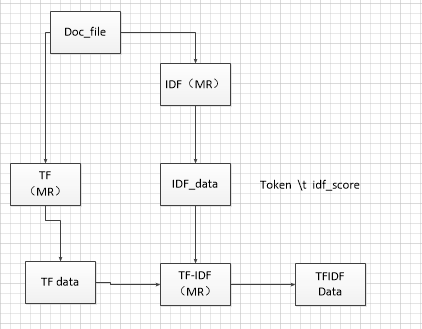

tf-idf计算流程图:

二 、计算IDF的值:

map阶段:读取每一行

import sys for line in sys.stdin:

ss = line.strip().split('\t')

file_name = ss[0].strip()

file_context = ss[1].strip()

word_list = file_context.split(' ') word_set = set()

for word in word_list:

word_set.add(word) for word in word_set:

print '\t'.join([word, ''])

reduce阶段:

import sys

import math current_word = None

doc_cnt = 508

count_pool = []

sum = 0 for line in sys.stdin:

ss = line.strip().split('\t')

if len(ss) != 2:

continue word, val = ss

if current_word == None:

current_word = word

if current_word != word:

for count in count_pool:

sum += count idf_score = math.log(float(doc_cnt) / (float(sum) + 1))

print '\t'.join([current_word, str(idf_score)]) current_word = word

count_pool = []

sum = 0 count_pool.append((int(val))) for count in count_pool:

sum += count idf_score = math.log(float(doc_cnt) / (float(sum) + 1))

print '\t'.join([current_word, str(idf_score)])

三、计算TF的值:

# 计算tf

# 读取合并后的数据

# 执行命令 cat merge_files.data | python map_tf.py mapper_func idf.data import sys word_dict = {}

idf_dict = {} # 读取计算的idf数据文件

def read_idf_file_func(idf_file_fd):

with open() as fd:

for line in fd:

ss = line.strip().split('\t')

if len(ss) != 2:

continue

token = ss[0].strip()

idf_score = ss[1].strip()

idf_dict[token] = float(idf_score)

return idf_dict # cat merge_files.data | python map_tf.py mapper_func

def mapper_func(idf_file_fd):

idf_dict = read_idf_file_func(idf_file_fd)

# 标准输入

for line in sys.stdin:

ss = line.strip().split('\t')

file_name = ss[0].strip()

file_context = ss[1].strip()

word_list = file_context.split(' ') for word in word_list:

if word not in word_dict:

word_dict[word] = 1

else:

word_dict[word] += 1 for k,v in word_dict.item():

if k not in idf_dict:

continue

print(file_name,k,v,idf_file_fd[k])

print(k,v) if __name__ == "__main__":

module = sys.modules[__name__]

func = getattr(module, sys.argv[1])

args = None

if len(sys.argv) > 1:

args = sys.argv[2:]

func(*args)

NLP相似度之tf-idf计算的更多相关文章

- TF/IDF(term frequency/inverse document frequency)

TF/IDF(term frequency/inverse document frequency) 的概念被公认为信息检索中最重要的发明. 一. TF/IDF描述单个term与特定document的相 ...

- TF/IDF计算方法

FROM:http://blog.csdn.net/pennyliang/article/details/1231028 我们已经谈过了如何自动下载网页.如何建立索引.如何衡量网页的质量(Page R ...

- 信息检索中的TF/IDF概念与算法的解释

https://blog.csdn.net/class_brick/article/details/79135909 概念 TF-IDF(term frequency–inverse document ...

- Elasticsearch由浅入深(十)搜索引擎:相关度评分 TF&IDF算法、doc value正排索引、解密query、fetch phrase原理、Bouncing Results问题、基于scoll技术滚动搜索大量数据

相关度评分 TF&IDF算法 Elasticsearch的相关度评分(relevance score)算法采用的是term frequency/inverse document frequen ...

- tf–idf算法解释及其python代码实现(下)

tf–idf算法python代码实现 这是我写的一个tf-idf的简单实现的代码,我们知道tfidf=tf*idf,所以可以分别计算tf和idf值在相乘,首先我们创建一个简单的语料库,作为例子,只有四 ...

- tf–idf算法解释及其python代码实现(上)

tf–idf算法解释 tf–idf, 是term frequency–inverse document frequency的缩写,它通常用来衡量一个词对在一个语料库中对它所在的文档有多重要,常用在信息 ...

- 文本分类学习(三) 特征权重(TF/IDF)和特征提取

上一篇中,主要说的就是词袋模型.回顾一下,在进行文本分类之前,我们需要把待分类文本先用词袋模型进行文本表示.首先是将训练集中的所有单词经过去停用词之后组合成一个词袋,或者叫做字典,实际上一个维度很大的 ...

- Elasticsearch学习之相关度评分TF&IDF

relevance score算法,简单来说,就是计算出,一个索引中的文本,与搜索文本,他们之间的关联匹配程度 Elasticsearch使用的是 term frequency/inverse doc ...

- tf idf公式及sklearn中TfidfVectorizer

在文本挖掘预处理之向量化与Hash Trick中我们讲到在文本挖掘的预处理中,向量化之后一般都伴随着TF-IDF的处理,那么什么是TF-IDF,为什么一般我们要加这一步预处理呢?这里就对TF-IDF的 ...

- 25.TF&IDF算法以及向量空间模型算法

主要知识点: boolean model IF/IDF vector space model 一.boolean model 在es做各种搜索进行打分排序时,会先用boolean mo ...

随机推荐

- cef-3.2623 build on vs2013

1. 参文"在Windows下编译Cef3.2623并加入mp3.mp4支持(附带源码包和最终DLL)"下载包 http://blog.csdn.net/zhuhongshu/ar ...

- 弹筐里同一个按钮判断是从哪里点击过来的form

点击弹框按钮 <form action="javascript:;" method="post"> <button type= ...

- mybatis逆向工程generatorConfiguration详细配置

<?xml version="1.0" encoding="UTF-8" ?> <!DOCTYPE generatorConfiguratio ...

- Mac OS X 操作系统下IntelliJ IDEA激活码(Activation code)破解

Mac OS X 操作系统(版本:10.13.6)下载并安装IntelliJ IDEA: Version: 2018.2.4 Download IntelliJ IDEA 下一步对IntelliJ I ...

- Java中BigDecimal的舍入模式

java.math.BigDecimal 不可变的.任意精度的有符号十进制数.BigDecimal 由任意精度的整数非标度值和32位的整数标度(scale)组成. 如果为零或正数,则标度是小数点后的位 ...

- Git版本库管理

Step 1 查看哪些历史提交过文件占用空间较大 使用以下命令可以查看占用空间最多的五个文件: git rev-list --objects --all | grep "$(git veri ...

- Ubuntu 18.04 下 Redis 环境搭建

一.安装 Redis ① 下载 wget http://download.redis.io/releases/redis-3.2.8.tar.gz ② 解压 tar -zxvf redis-3.2.8 ...

- unity打包安卓应用及生成签名

首先,先进行安卓应用的打包.File->build Settings 弹出界面后选择Android,注意,这里如果黄色区域内容与我这个不一致,说明电脑上没有安装studio(安卓开发环境),具体 ...

- Spring重要知识点整理

一.IOC(Inversion of Control):控制反转 (1)Spring Core最核心部分 (2)需要先了解依赖注入(Denpendency Injection)/把底层类作为参数传递给 ...

- winfrom程序Datagridview列名问题

之前在做程序的时候,有遇到过这个问题: 无法将类型“string”隐式转换为“System.Windows.Forms.DataGridViewTextBoxColume"解决方法 解决办法 ...