使用ELK收集分析MySQL慢查询日志

参考文档:https://www.cnblogs.com/bixiaoyu/p/9638505.html

MySQL开启慢查询不详述

MySQL5.7慢查询日志格式如下

/usr/local/mysql/bin/mysqld, Version: 5.7.22-log (MySQL Community Server (GPL)). started with:

Tcp port: 3306 Unix socket: /tmp/mysql3306.sock

Time Id Command Argument

# Time: 2019-02-23T01:01:52.922426+08:00

# User@Host: root[root] @ [172.16.90.53] Id: 25913

# Query_time: 1.393973 Lock_time: 0.000076 Rows_sent: 0 Rows_examined: 0

use hope-framework;

SET timestamp=1550854912;

INSERT INTO t_device_into_near_shop_tmp_data ( device_mac,

people_in,

people_out,

people_near,

request_message,

start_time,

start_timestamp,

create_time,

create_timestamp ) VALUES ( 'HA0A00734',

0,

0,

0,

'{"1:Counter 1":0,"0:Counter 0":0,"Records:2 Counter:3":"2000/04/19 20:21:00","2:Counter 2":0}',

'2019-02-23 01:01:51.512',

1550854911512,

'2019-02-23 01:01:51.512',

1550854911512 );

MySQL主机安装filebeat修改配置文件/etc/filebeat/filebeat.yml

filebeat.inputs:

- type: log

enabled: true

paths:

- /opt/log/mysql/slow3306.log

#- c:\programdata\elasticsearch\logs\*

exclude_lines: ['^\# Time|^/usr/local/mysql/bin/mysqld|^Tcp port|^Time'] #排除行

multiline.negate: true #多行合并

multiline.match: after

multiline.pattern: '^\# User|^\# Time'

tags: ["mysql-slow-log"] #打一个tags filebeat.config.modules:

path: ${path.config}/modules.d/*.yml reload.enabled: false setup.template.settings:

index.number_of_shards: 3 setup.kibana: output.logstash: #输出至logstash

hosts: ["192.168.1.4:5044"] processors:

- add_host_metadata: ~

- add_cloud_metadata: ~

- drop_fields: #删除无用的字段

fields: ["beat", "input", "source", "offset", "prospector"]

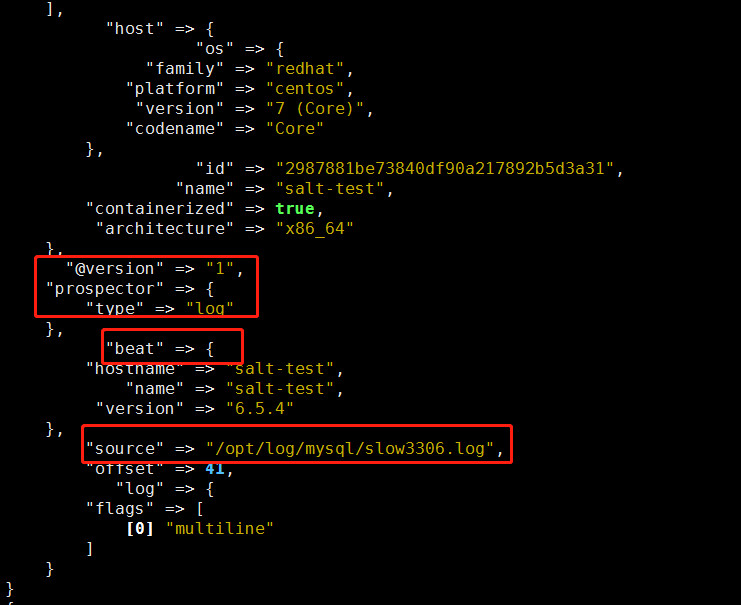

PS:删除的无用字段为以下几个字段

修改logstash输出测试/etc/logstash/conf.d/filebeat-logstash.conf

input{

beats{

port => 5044

}

}

output{

if "mysql-slow-log" in [tags] {

stdout{

codec => rubydebug

}

}

}

运行logstash

/usr/share/logstash/bin/logstash -f /etc/logstash/conf.d/filebeat-logstash.conf

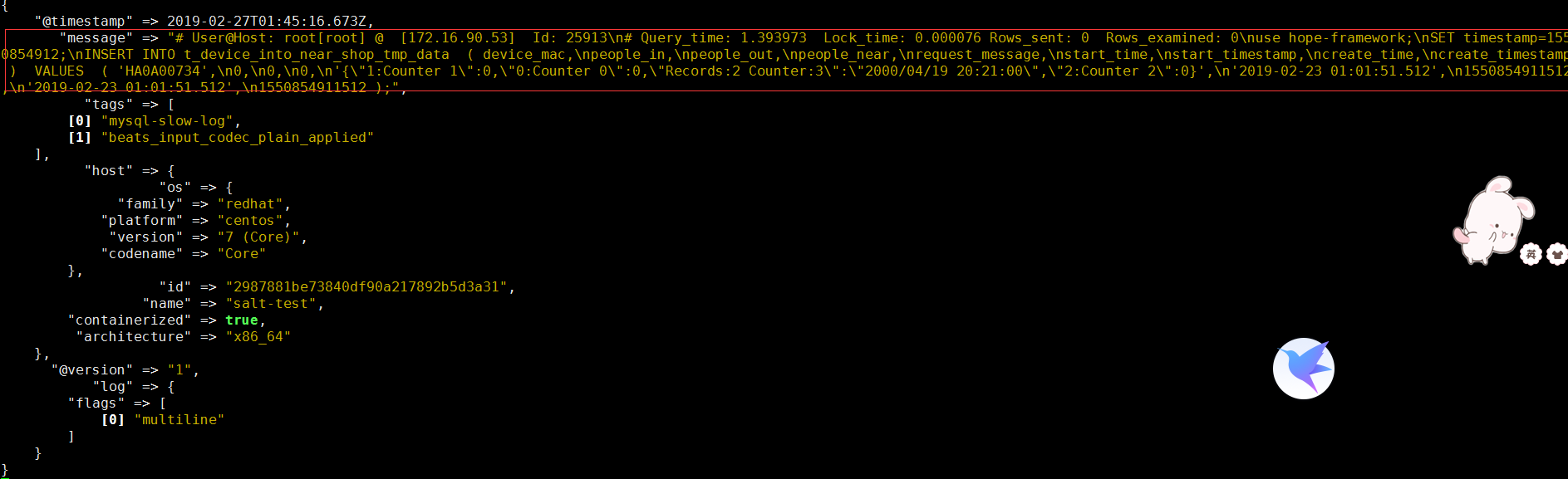

多行输出如下

增加filter过滤

input{

beats{

port => 5044

}

}

filter {

if "mysql-slow-log" in [tags] {

json {

source => "message"

}

grok {

match => [ "message" , "(?m)^#\s+User@Host:\s+%{USER:user}\[[^\]]+\]\s+@\s+(?:(?<clienthost>\S*) )?\[(?:%{IPV4:clientip})?\]\s+Id:\s+%{NUMBER:row_id:int}\n#\s+Query_time:\s+%{NUMBER:query_time:float}\s+Lock_time:\s+%{NUMBER:lock_time:float}\s+Rows_sent:\s+%{NUMBER:rows_sent:int}\s+Rows_examined:\s+%{NUMBER:rows_examined:int}\n\s*(?:use %{DATA:database};\s*\n)?SET\s+timestamp=%{NUMBER:timestamp};\n\s*(?<sql>(?<action>\w+)\b.*;)\s*(?:\n#\s+Time)?.*$" ]

}

date {

match => ["timestamp_mysql","UNIX"] #这里我们需要对日志输出进行时间格式转换,默认将timestamp_mysql的unix时间格式之后直接赋值给timestamp

target => "@timestamp"

}

mutate {

remove_field => "@version" #版本字段,删除不需要的字段

remove_field => "message" #在上述,我们已经对mysql的慢日志输出分段了,所以message输出已经是多余的了,故此删除

}

}

}

output{

if "mysql-slow-log" in [tags] {

elasticsearch{

hosts => ["192.168.1.4:9200"]

index => "mysql-slow-log-%{+YYYY.MM}"

}

stdout{

codec => rubydebug

}

}

}

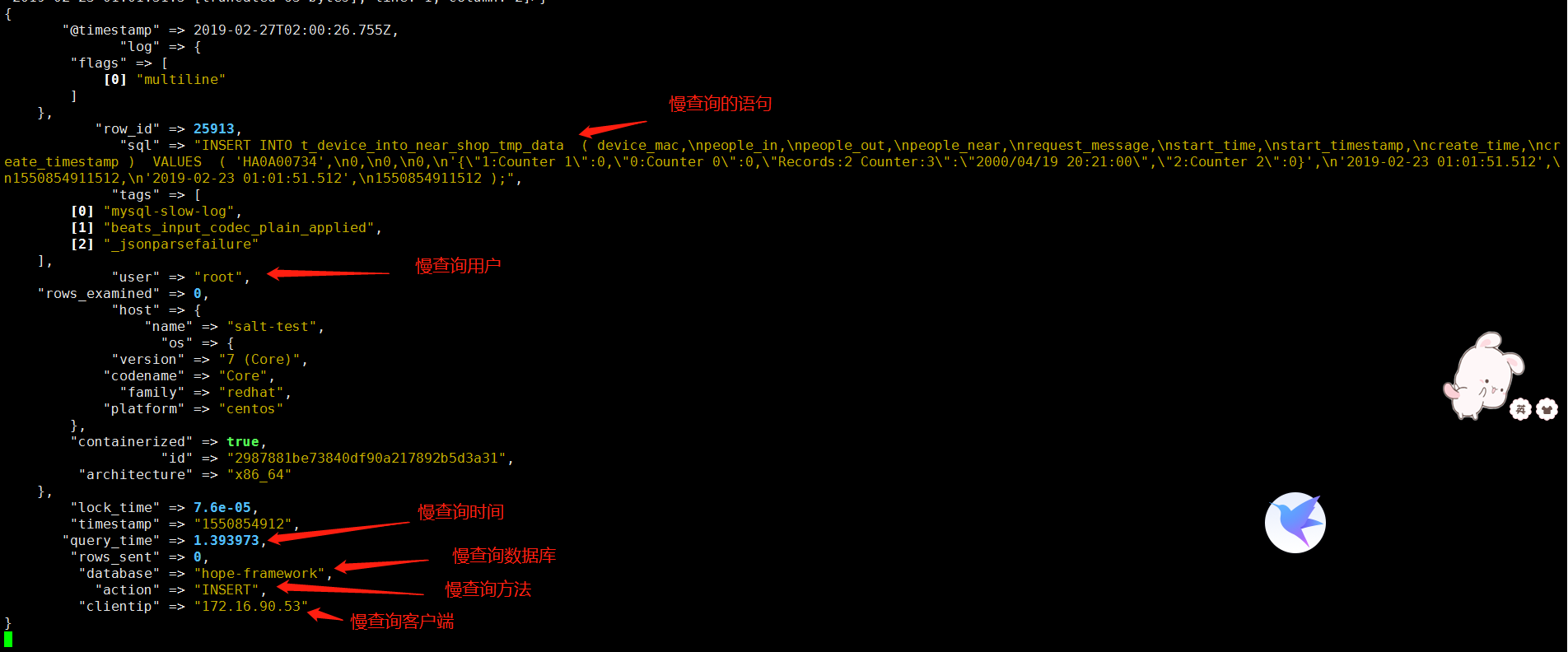

运行再次输出测试

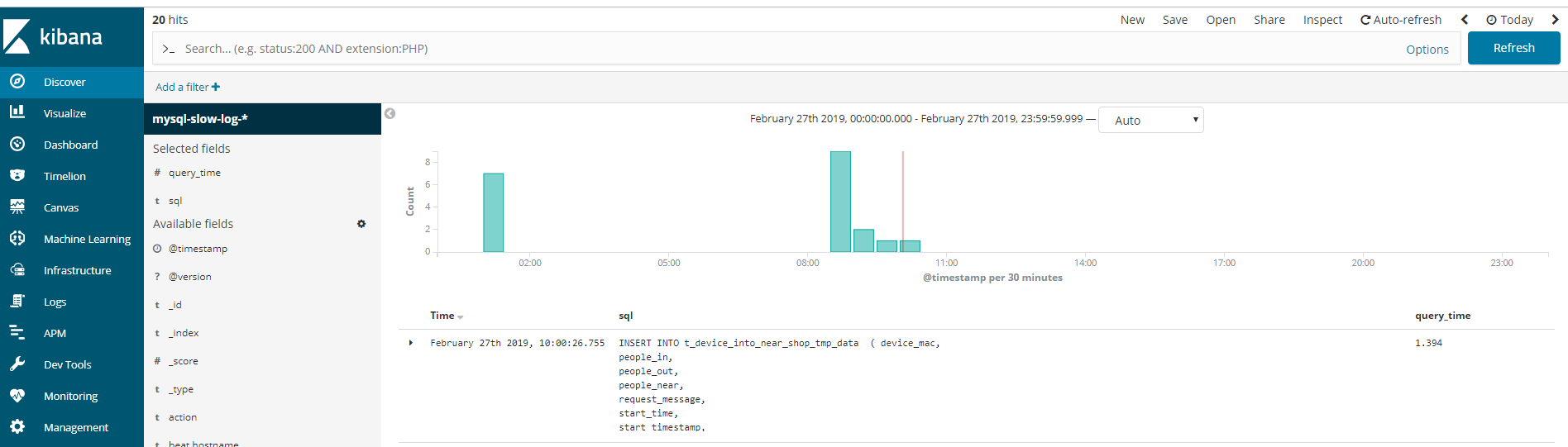

输出至elasticsearch即可使用kibana查询

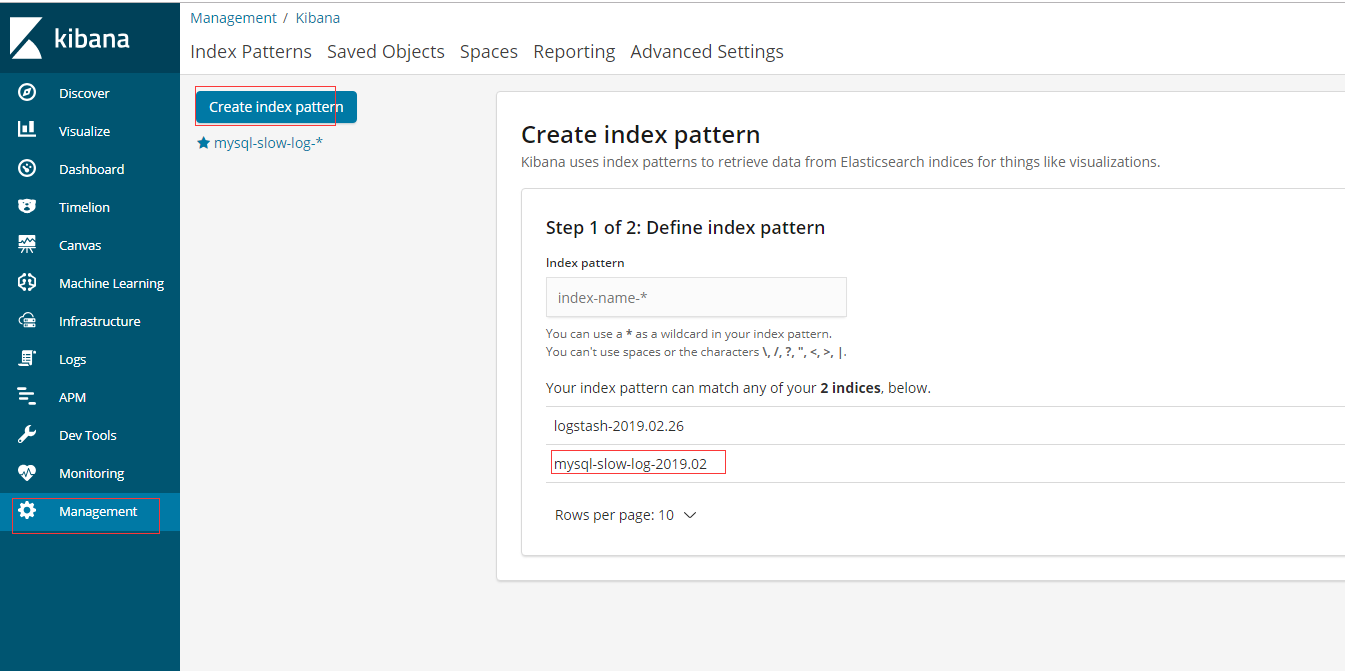

在kibana添加

使用ELK收集分析MySQL慢查询日志的更多相关文章

- 企业级中带你ELK如何实时收集分析Mysql慢查询日志

什么是Mysql慢查询日志? 当SQL语句执行时间超过设定的阈值时,便于记录到指定的日志文件中或者表中,所有记录称之为慢查询日志 为什么要收集Mysql慢查询日志? 数据库在运行期间,可能会存在这很多 ...

- ELK logstash 处理MySQL慢查询日志(初步)

写在前面:在做ELK logstash 处理MySQL慢查询日志的时候出现的问题: 1.测试数据库没有慢日志,所以没有日志信息,导致 IP:9200/_plugin/head/界面异常(忽然出现日志数 ...

- ELK logstash 处理MySQL慢查询日志

在生产环境下,logstash 经常会遇到处理多种格式的日志,不同的日志格式,解析方法不同.下面来说说logstash处理多行日志的例子,对MySQL慢查询日志进行分析,这个经常遇到过,网络上疑问也很 ...

- mysqlsla 分析mysql慢查询日志

发现有一个工具mysqlsla,分析查询日志比 mysqldumpslow分析的会更清晰明了! 安装mysqlsla: 下载mysqlsla-2.03.tar.gz [root@yoon export ...

- linux上开启和分析mysql慢查询日志

本人qq群也有许多的技术文档,希望可以为你提供一些帮助(非技术的勿加). QQ群: 281442983 (点击链接加入群:http://jq.qq.com/?_wv=1027&k=29Lo ...

- shell脚本分析mysql慢查询日志(slow log)

使用percona公司的pt-query-digest分析慢查询日志.分析.统计的结果的比較清晰 #!/bin/sh slowlog_path=/root/slow_query_log everysl ...

- mysql慢查询日志分析工具 mysqlsla(转)

mysql数据库的慢查询日志是非常重要的一项调优辅助日志,但是mysql默认记录的日志格式阅读时不够友好,这是由mysql日志记录规则所决定的,捕获一条就记录一条,虽说记录的信息足够详尽,但如果将浏览 ...

- MySQL慢查询日志工具mysqlsla

mysql数据库的慢查询日志是非常重要的一项调优辅助日志,但是mysql默认记录的日志格式阅读时不够友好,这是由mysql日志记录规则所决定的,捕获一条就记录一条,虽说记录的信息足够详尽,但如果将浏览 ...

- elk收集分析nginx access日志

elk收集分析nginx access日志 首先elk的搭建按照这篇文章使用elk+redis搭建nginx日志分析平台说的,使用redis的push和pop做队列,然后有个logstash_inde ...

随机推荐

- 阿里云服务器Centos7.4开放80端口的记录

问题: 阿里云服务器安装的是centos7, 搭建网站安装lnmp1.5后发现访问不了, 不明所以, 在一论坛找到关于80端口未开放的原因. 需求: 开放80端口.于是有了下面第一,二,三部分关于开放 ...

- 提取aar 包中的jar包,反编译再替换成新的aar

参考了 http://blog.csdn.net/hekewangzi/article/details/44676797 针对aar包,增加一些说明 aar包本质应该是zip文件.可以用360解压 ...

- Cacti 1.1.6 添加monitor和thold插件

以前一直使用0.8版本的cacti,最近升级到1.1.6之后,发现以前0.8用的插件已经不适用了,需要下载新的插件包进行导入到下面网址获取Cacti插件包https://github.com/Cact ...

- 3D建模软件的选择(UG,Solidworks,ProE)

转自:3D建模软件的选择(UG,Solidworks,ProE) 自述 咱是一个码农,和web.软件.控制台打交道太多了,很想玩玩炫的东西,于是学了点点PS,结果发现完全没有美术细胞TT.最近有碰到对 ...

- Atitit xml框架类库选型 attilax总结

Atitit xml框架类库选型 attilax总结 1. 1. XML类库可以分成2大类.标准的.这些类库通常接口和实现都是分开的1 2. Jdom 和dom4j1 2.1. 5.1. jdom1 ...

- 使用 .toLocaleString() 轻松实现多国语言价格数字格式化

用代码对数字进行格式化,显然不是逢三位加逗号这么简单.比如印度在数字分位符号上的处理,就堪称业界奇葩: 印度的数字读法用“拉克”(十万)和“克若尔”(千万),数字标法用不对称的数位分离,即小数点左侧首 ...

- 基于Openresty+的WEB安全防护系统架构--转

随着时间的推移,我们在实践中也不断的演进我们的服务部署方案,希望WEB防护,不只是单独的云WAF来保护服务,而有其它的相关服务,对WAF进行增强加固的合理配合.我们使用Openresty+系统构建了W ...

- pycharm开发python利器入门

内容包含:pycharm学习技巧 Learning tips.PyCharm3.0默认快捷键(翻译的).pycharm常用设置.pycharm环境和路径配置.Pycharm实用拓展功能:pycharm ...

- C#中怎么判断一个数组中是否存在某个数组值

(1) 第一种方法: ,,}; ); // 这里的1就是你要查找的值 ) // 不存在 else // 存在 (2) 第二种方法: string[] strArr = {"a",& ...

- 【iCore4 双核心板_ARM】例程二十三:LWIP_HTTP实验——网页服务器

实验现象: 核心代码: int main(void) { system_clock.initialize(); led.initialize(); adc.initialize(); delay.in ...