Spark:java api读取hdfs目录下多个文件

需求:

由于一个大文件,在spark中加载性能比较差。于是把一个大文件拆分为多个小文件后上传到hdfs,然而在spark2.2下如何加载某个目录下多个文件呢?

public class SparkJob {

public static void main(String[] args) {

String filePath = args[0];

// initialize spark session

String appName = "Streaming-MRO-Load-Multiple-CSV-Files-Test";

SparkSession sparkSession = SparkHelper.getInstance().getAndConfigureSparkSession(appName);

// reader multiple csv files.

try {

Dataset<Row> rows = sparkSession.read().option("delimiter", "|").option("header", false)

.csv(filePath).toDF(getNCellSchema());

rows.show(10);

} catch (Exception ex) {

ex.printStackTrace();

}

try {

Dataset<String> rows = sparkSession.read().textFile(filePath);

rows.show(10);

} catch (Exception ex) {

ex.printStackTrace();

}

SparkHelper.getInstance().dispose();

}

private static Seq<String> getNCellSchema() {

List<String> ncellColumns = "m_id,m_eid,m_int_id,.....";

List<String> columns = new ArrayList<String>();

for (String column : ncellColumns) {

columns.add(column);

}

Seq<String> columnsSet = JavaConversions.asScalaBuffer(columns);

return columnsSet;

}

}

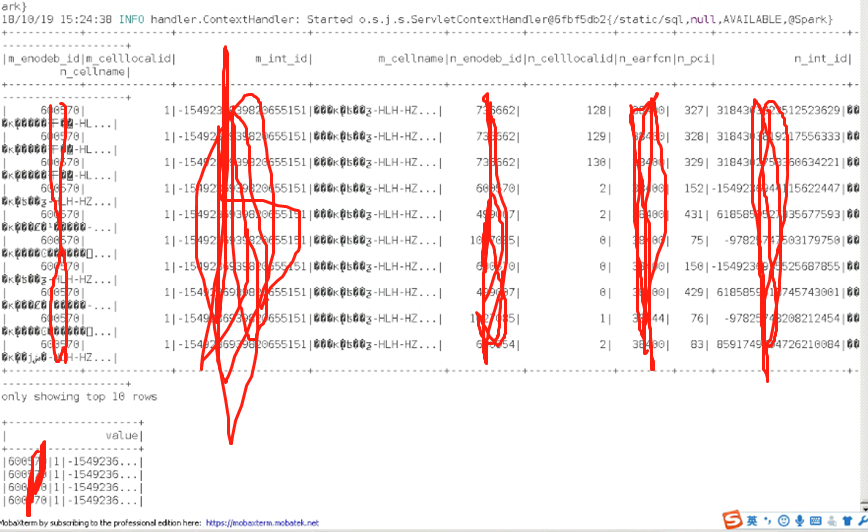

测试结果:

Spark:java api读取hdfs目录下多个文件的更多相关文章

- Java中读取某个目录下的所有文件和文件夹

import java.io.File; public class Test1 { public static void main(String[] args) { String path=" ...

- 使用JAVA API读取HDFS的文件数据出现乱码的解决方案

使用JAVA api读取HDFS文件乱码踩坑 想写一个读取HFDS上的部分文件数据做预览的接口,根据网上的博客实现后,发现有时读取信息会出现乱码,例如读取一个csv时,字符串之间被逗号分割 英文字符串 ...

- [转]读取assets目录下的数据库文件

在做Android应用的时候,不可避免要用到数据库.但是当我们把应用的apk部署到真机上的时候,已经创建好的数据库及其里边的数据是不能随着apk一起安装到真机上的. (PS:这篇博客解决了我前面博客中 ...

- java获取ubuntu某个目录下的所有文件信息

java获取ubuntu某个目录下的所有文件信息 public List<VCFile> getAllFiles(String basicDirName) { List<VCFile ...

- Python读取指定目录下指定后缀文件并保存为docx

最近有个奇葩要求 要项目中的N行代码 申请专利啥的 然后作为程序员当然不能复制粘贴 用代码解决.. 使用python-docx读写docx文件 环境使用python3.6.0 首先pip安装pytho ...

- 遍历并读取指定目录下的所有文件内容,写入Map集合然后输出在控制台和本地文件

public class FileWrite { public static void main(String[] args) throws Exception { //封装数据源目录 File sr ...

- Python读取一个目录下的所有文件

#!/usr/bin/python # -*- coding:utf8 -*- import os allFileNum = 0 def printPath(level, path): global ...

- Java API 读取HDFS的单文件

HDFS上的单文件: -bash-3.2$ hadoop fs -ls /user/pms/ouyangyewei/data/input/combineorder/repeat_rec_categor ...

- java 实现读取某个目录下指定类型的文件

我这里是读取txt类型的文件,在指定的目录下有不同类型的文件 实现代码,读取txt类型的文件并打印出该文件的绝对路径 package com.SBgong.test; import java.io.F ...

随机推荐

- cf1061D 贪心+multiset 好题!

cf上的思维题真好! 本题是在模拟的基础上贪心即可:将n段时间按照左端点(右端点为第二关键字)从小到大排序,然后遍历每一个时间段. 对于每一个时间段[li,ri],先找到multiset中最靠近li但 ...

- bzoj1036点权模板题

/* HYSBZ1036 树上有1-n个结点,每个节点都有一个权值w 操作 CHANGE u t:把结点u的权值改为t QMAX u v:询问从点u到v的路径上的节点的最大权值 QSUM u v:询问 ...

- django项目验证码(PIL库实现)

作个记录,这个东东,是可以到处照搬的. WINDOWS下和LINUX下,字体对象获取方式不一样. 为了用户体验,字体大小也重要的. 另外,为了照顾个别字母认不出来的人,提供刷新功能. 一,验证码函数 ...

- POJ 1065 Wooden Sticks【贪心】

题意: 有一些木棍,每个有长度和重量,要求把这些木棍排成若干两个属性值均不下降的序列.问至少要分为多少个序列.且要保证排出来的子序列数最少. 思路: ( 9 , 4 ) ,( 2 , 5 ) ,( 1 ...

- 安装及配置sublime

纯个人笔记,粗略编写,有时间再修改 参考:关于Sublime text3 配置及插件整理 参考:https://github.com/boontime/sublime-text3-config 参考: ...

- Jetbrains 2018 等系列软件激活破解除去黄色警告框方法(含多个平台)

现在以IDEA 2018软件在windows为例进行讲解破解方法,其它软件及其在不同平台的破解方法原理 大同小异,有需要的有兴趣的可以尝试一下. 最近更新了Intellij IDEA到2018.1.5 ...

- Android 7.0 PopupWindow 又引入新的问题,Google工程师也不够仔细么

Android7.0 PopupWindow的兼容问题 Android7.0 中对 PopupWindow 这个常用的控件又做了一些改动,修复了以前遗留的一些问题的同时貌似又引入了一些问题,本文通 ...

- epoll使用详解

目录 epoll介绍 Epoll的优点: 1.支持一个进程打开大数目的socket描述符(FD) 2.IO效率不随FD数目增加而线性下降 3.支持边缘触发模式 4.使用mmap加速内核与用户空间的消息 ...

- 几个文本处理工具的简单使用(wc,cut,sort,uniq,diff和patch)

wc wc命令用于报告文本文件的一些统计计数,例如行数.单词数.字节数等. 语法如下. wc [OPTION]... [FILE]... wc [OPTION]... --files0-from=F ...

- 【Java】同步阻塞式(BIO)TCP通信

TCP BIO 背景 网络编程的基本模型是Clien/Server模型,也就是两个进程之间进行相互通信,其中服务端提供位置信息(绑定的IP地址和监听端口),客户端通过连接操作向服务端监听的地址发起连接 ...