ELK+FileBeat+Log4Net搭建日志系统

ELK+FileBeat+Log4Net搭建日志系统

来源:https://www.zybuluo.com/muyanfeixiang/note/608470

标签(空格分隔): ELK Log4Net

项目中之前都是采用数据库来记录日志,虽然记录还算挺方便,但是每次都要到数据库来查询,如果日志在单独的数据库还好,只是有点麻烦。如果记录的日志数据库和生产正式库在一起,不仅会影响生产库的正常使用,也会带来安全隐患。

项目早期没有统一规划,也是时间仓促,没有做好日志的规划,所有日志都记录到数据库中。的确也遇到了性能问题,因此在了解ELK的基础上,使用其作为日志采集、处理和检索的几本框架。

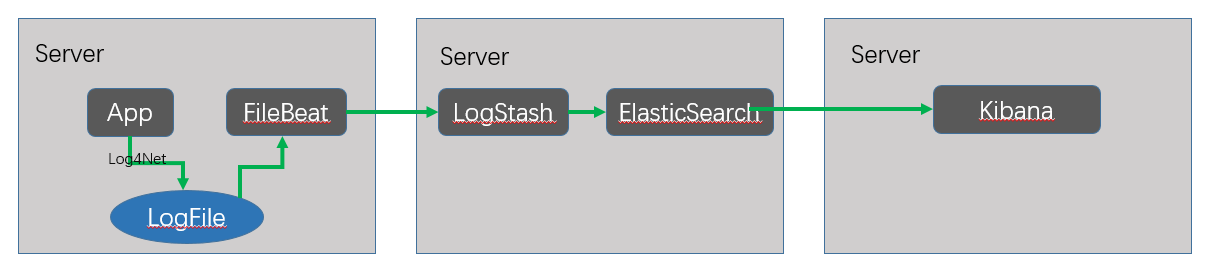

大体框架

日志数据流如下,应用将日志落地在本地文件,部署在每台服务器上的FileBeat负责收集日志,然后将日志发送给LogStash;LogStash将日志进行处理之后,比如parse等;然后将处理后的Json对象传递给ElasticSearch,进行落地并进行索引处理;最后通过Kibana来提供web界面,来查看日志等。因为ES是基于Lucene的,所以Kibana支持Lucene查询语法。

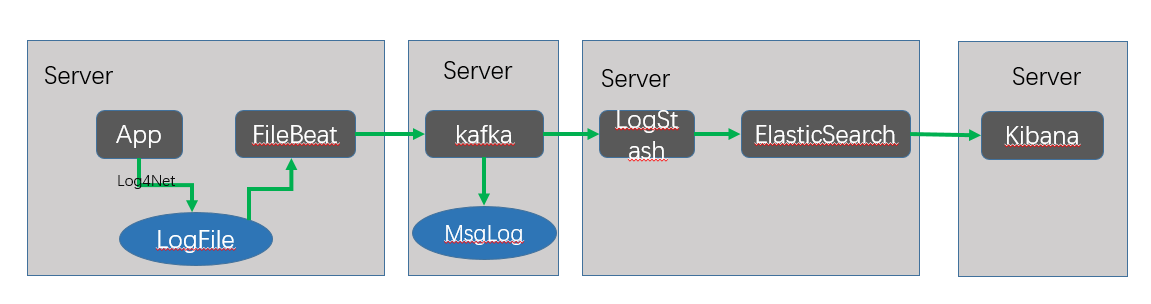

对于日志数据流特别大的情况,LogStash会造成拥堵,这个时候可以使用消息队列来进行缓冲。同时,日志一旦进过LogStash之后,会不方面一些流处理程序来读取。这个时候使用kafka就比较好了,因为kafka是将消息持久化在本地,流处理应用可以从消息的offset初始的地方来读取。加入kafka的后的流程如下:

配置过程

Log4Net配置

首先,最基本的引用Log4Net程序集,补多少。

其次,要在项目的AssemblyInfo.cs添加如下代码,这样配置才能给启作用。

[assembly: log4net.Config.XmlConfigurator(Watch = true)]

最后,也是最重要的就是在web.config(或app.config)中配置了。

在configSections中添加如下代码

<configSections>

<section name="log4net" type="log4net.Config.Log4NetConfigurationSectionHandler, log4net" />

</configSections>

添加log4net节点

<log4net>

<root>

<level value="ALL" />

<appender-ref ref="rollingFile" />

<appender-ref ref="ErrorRollingFile" />

</root>

<appender name="rollingFile" type="log4net.Appender.RollingFileAppender,log4net">

<filter type="log4net.Filter.LevelRangeFilter">

<levelMin value="DEBUG" />

<levelMax value="WARN" />

</filter>

<!--日志的路径-->

<param name="File" type="" value="D://WebLog//Log4NetTest.App//" />

<param name="Encoding" value="UTF-8"/>

<!--是否覆盖,默认是追加true-->

<param name="AppendToFile" value="true" />

<param name="RollingStyle" value="Date" />

<!--文件名称-->

<param name="DatePattern" value="yyyy-MM-dd'.Debug.log'" />

<!--设置无限备份=-1 ,最大备份数为1000-->

<param name="MaxSizeRollBackups" value="1000" />

<!--每个文件的大小-->

<param name="MaximumFileSize" value="102KB" />

<!--名称是否可以更改为false为可以更改-->

<param name="StaticLogFileName" value="false" />

<layout type="log4net.Layout.PatternLayout,log4net">

<!--输出格式-->

<param name="ConversionPattern" value="[%date] [%thread] %-5level Log4NetTest %logger %method [%message%exception]%n" />

</layout>

</appender>

<appender name="ErrorRollingFile" type="log4net.Appender.RollingFileAppender,log4net">

<filter type="log4net.Filter.LevelRangeFilter">

<levelMin value="ERROR" />

<levelMax value="FATAL" />

</filter>

<!--日志的路径-->

<param name="File" type="" value="D://WebLog//Log4NetTest.App//" />

<param name="Encoding" value="UTF-8"/>

<!--是否覆盖,默认是追加true-->

<param name="AppendToFile" value="true" />

<param name="RollingStyle" value="Date" />

<!--文件名称-->

<param name="DatePattern" value="yyyy-MM-dd'.Error.log'" />

<!--设置无限备份=-1 ,最大备份数为1000-->

<param name="MaxSizeRollBackups" value="1000" />

<!--每个文件的大小-->

<param name="MaximumFileSize" value="102KB" />

<!--名称是否可以更改为false为可以更改-->

<param name="StaticLogFileName" value="false" />

<layout type="log4net.Layout.PatternLayout,log4net">

<!--输出格式-->

<param name="ConversionPattern" value="[%date] [%thread] %-5level Log4NetTest %l [%message%n%exception]%n"/>

</layout>

</appender>

</log4net>

针对两种不同类型的应用日志,分别使用两种pattern,也分别记录到Debug.lg和Error.log文件中。

- 日志类型为Debug,Info,Warn的日志,使用[%date] [%thread] %-5level Log4NetTest %logger %method [%message%exception]%n模式,分别记录下时间,线程,日志等级,应用名称,日志记录类属性,日志记录方法,日志信息和异常

- 日志类型为Error和Fatal的日志,使用[%date] [%thread] %-5level Log4NetTest %l [%message%n%exception]%n,分别是时间,线程,日志等级,应用名称,出错位置(包含具体文件,以及所在行,需要PDB文件才能到行),日志信息和异常

分两类的主要原因就在于是否记录了出错位置,这个是比较耗性能的操作,所以对于常规的Debug,Info,Warn可以不记录位置。

除此之外,没有记录host,因为FileBeat在采集日志时候会自动记录hostname。这样log4net的基本配置就完成了。

FileBeat配置

只需简单的配置就即可使用,当然也可以配置的很复杂。配置文件filebeat.yml

一个input_type代表一个输入源,可选值只有log和stdin。

paths是日志采集路径,可以使用通配符。

document_type是可以用来表示日志类型。输入到logstash中对应[type],可以据此使用不同grok语法来parse,这里分为errorLog和debugLog。

multiline.pattern: '^\['

multiline.negate: true

multiline.match: after

上面这三个使用了将换行的日志或异常信息聚合为一个事件,因为默认FileBeat是按行来读取日志,然后传输给LogStash,如果没这个设置,就会造成日志分割为多个事件。

output.logstash就是输出的目标了。

然后直接运行filebeat.exe即可启动。当然也可以以服务方式启动。

filebeat.prospectors:

- input_type: log

# Paths that should be crawled and fetched. Glob based paths.

paths:

#- /var/log/*.log

- D:\WebLog\*\*.Error.log

document_type: errorLog

multiline.pattern: '^\['

multiline.negate: true

multiline.match: after

- input_type: log

# Paths that should be crawled and fetched. Glob based paths.

paths:

#- /var/log/*.log

- D:\WebLog\*\*.Debug.log

document_type: debugLog

#----------------------------- Logstash output --------------------------------

output.logstash:

# The Logstash hosts

hosts: ["localhost:5044"]

LogStash配置

在config文件夹添加配置文件first-pipeline.conf。

- input: 指定输入来源

- filter:是指定如何对日志进行处理。这里[type]就是来自filebeat中document_type。然后就是grok语法了。

- overwrite:是将原有message覆盖掉。如果将原有message完全match出来的话,是可以这样做的,可以节省空间。

- output:就是输出地址了。

- 运行

bin/logstash -f first-pipeline.conf --config.test_and_exit 测试配置文件

bin/logstash -f first-pipeline.conf --config.reload.automatic 自动加载配置文件的修改

input {

beats {

port => "5044"

}

}

# The filter part of this file is commented out to indicate that it is

# optional.

filter {

if [type] == "debugLog" {

grok {

match => {

"message" => "\[(?<datetime>\d{4}-\d{2}-\d{2}\s\d{2}:\d{2}:\d{2},\d{3})\]\s+\[(?<thread>.*)\]\s+(?<level>\w*)\s+(?<appname>\S*)\s+(?<class>\S*)\s+(?<method>\S*)\s+\[(?<message>.*)\]\s*"

}

overwrite => ["message"]

}

}

if [type] == "errorLog" {

grok {

match => {

"message" => "\[(?<datetime>\d{4}-\d{2}-\d{2}\s\d{2}:\d{2}:\d{2},\d{3})\]\s+\[(?<thread>.*)\]\s+(?<level>\w*)\s+(?<appname>\S*)\s+(?<location>\S*)\s+\[(?<message>.*)\]\s*"

}

overwrite => ["message"]

}

}

}

output {

elasticsearch { hosts => ["localhost:9200"] }

stdout { codec => rubydebug }

}

ElasticSearch配置

默认不需要配置,监听9200端口。直接运行即可

Kibana配置

elasticsearch.url: "http://localhost:9200"

默认连接es地址,如果本机测试无需修改。正式环境中连接到对应服务器就好。

server.port: 5601

监听端口5601,可修改到合适的端口。

然后直接运行就可启动。

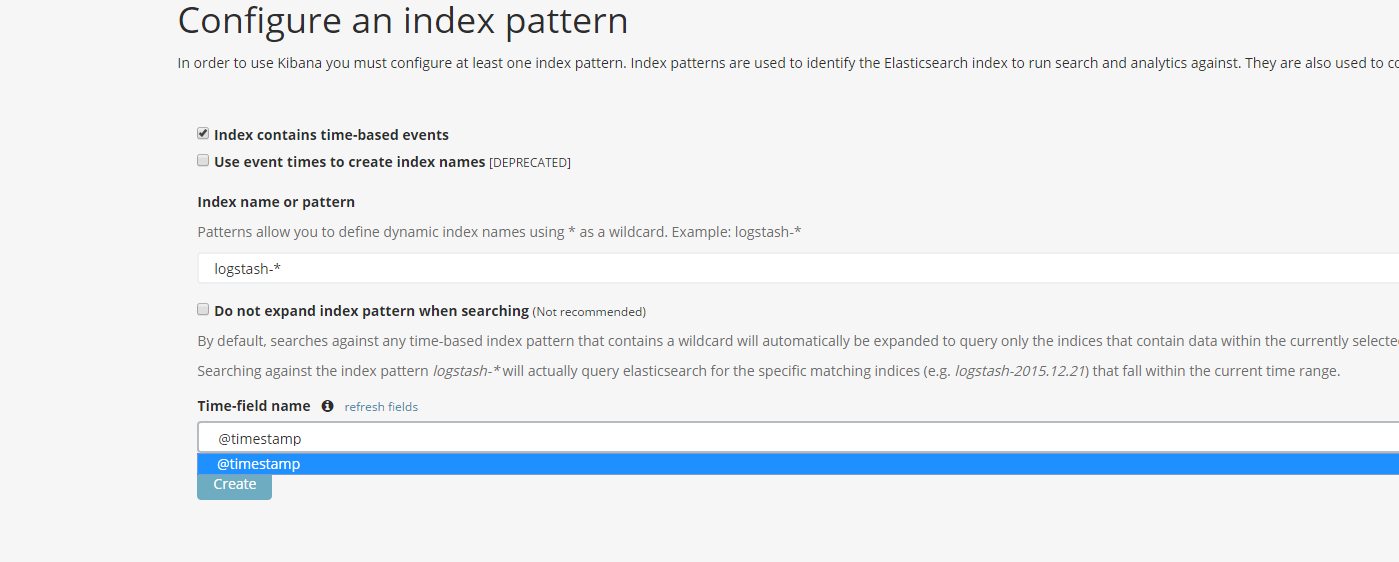

初次进入要指定index pattern。一般默认使用如下配置即可。

ELK+FileBeat+Log4Net搭建日志系统的更多相关文章

- ELK+FileBeat+Log4Net

ELK+FileBeat+Log4Net搭建日志系统 output { elasticsearch { hosts => ["localhost:9200"] } stdou ...

- 【ELK】5.spring boot日志集成ELK,搭建日志系统

阅读前必看: ELK在docker下搭建步骤 spring boot集成es,CRUD操作完整版 ============================================== 本章集成 ...

- 快速搭建日志系统——ELK STACK

什么是ELK STACK ELK Stack是Elasticserach.Logstash.Kibana三种工具组合而成的一个日志解决方案.ELK可以将我们的系统日志.访问日志.运行日志.错误日志等进 ...

- ELK+Filebeat 集中式日志解决方案详解

链接:https://www.ibm.com/developerworks/cn/opensource/os-cn-elk-filebeat/index.html?ca=drs- ELK Stack ...

- .NET基于Eleasticsearch搭建日志系统实战演练

一.需求背景介绍 1.1.需求描述 大家都知道C/S架构模式的客户端应用程序(比如:WinForm桌面应用.WPF.移动App应用程序.控制台应用程序.Windows服务等等)的日志记录都存储在本地客 ...

- spring mvc+ELK从头开始搭建日志平台

最近由于之前协助前公司做了点力所能及的事情,居然收到了一份贵重的端午礼物,是给我女儿的一个乐高积木,整个有7大包物件,我花了接近一天的时间一砖一瓦的组织起来,虽然很辛苦但是能够从过程中体验到乐趣.这次 ...

- 利用Asio搭建日志系统

Asio(http://think-async.com)官方示例中给出了一个比较初步的日志服务,主要代码在basic_logger.hpp.logger_service.hpp.logger_serv ...

- 【5】基于Log4Net的日志系统

阅读目录 日志系统应具备的特性 Log4Net 配置文件:log4net.config 初始化 输出信息 对Log4Net的封装 log4net.config复杂配置 不管是Web应用程序还是W ...

- Elasticsearch学习(5) Elasticsearch+logstash +filebeat+log4j的日志系统

最近需要使用Elasticsearch做一个日志系统,本文只介绍log4j内容同步到Elasticsearch,至于日志的查询和分类,会在后面介绍. 一.配置并打开Elasticsearch 这个操作 ...

随机推荐

- C# 设置和获取一个字节的某一位的值的方法

自己工作中遇到需要对单字节的高位.低位进行赋值,即一个字节byte,想要给每一位都赋值,这个值是动态来的,是0或是1. 好不容易收集到一些珍贵资料,整理一下: 一.设置 方法code: /// < ...

- 了解 JavaScript (5)– 翻转器(rollover)

用 JavaScript 最常用的效果就是,当用户将鼠标移动到图片上时,会改变网页上的图像,这样页面就能对用户的操作及时作出反应,这种称为 翻转器(rollover)效果很容易实现,而且有很多应用场合 ...

- jQuery中position()与offset()区别

使用jQuery获取元素位置时,我们会使用position()或offset()方法,两个方法都返回一个包含两个属性的对象-左边距和上边距,它们两个的不同点在于位置的相对点不同. 可以看看下边的图: ...

- Android NDK 同时编译多个Module

LOCAL_PATH := $(call my-dir) ## ## NDK 支持同时编译多个Module: ## 在配置的时候,每个Module需要 以 include $(CLEAR_VARS)开 ...

- [原]shader实现矩形圆角

哎!竭力想说清楚这个实现原理,并解释清楚shader里面的算法,结果发现越解释越不好理解,见谅! 一.实现目标:矩形四角是圆弧效果 二.实现的原理:通过每个角绘制1/4圆弧,剔除掉圆弧以外的部分. 原 ...

- webClient请求JAVA超时解决方案

private class MyWebClient: WebClient { protected override WebRequest GetWebRequest(Uri uri) { WebReq ...

- UFT\QTP 12 新特性

UFT\QTP 12 新特性 http://blog.csdn.net/testing_is_believing/article/details/22310297

- sloth——算法工程师标注数据的福音

一般算法工程师做标注,都要先开发个标注工具,无非下面几个选项: 1.mfc,C#,优点是交互界面友好,开发难度适中,缺点是没法跨平台 2.matlab,优点是可以跨平台,开发难度非常低,缺点是速度慢. ...

- MySQL降权:MySQL以Guests帐户启动设置方法

MySQL安装到Windows上,默认是以SYSTEM权限运行,如下图: SYSTEM是超级管理员.不是必须,不推荐用此权限运行任何程序. 本文将演示如何在GUEST帐户下运行MySQL. 第一步:建 ...

- iOS开发-pod install 出错 The dependency `AFNetworking (~> 2.6.0)` is not used in any concrete target.

低版本的cocoapods的Podfile文件pod install可以正常运行 platform :ios, '8.0' pod 'AFNetworking' 高版本的cocoapods的Podfi ...