Spark编程环境搭建(基于Intellij IDEA的Ultimate版本)(包含Java和Scala版的WordCount)(博主强烈推荐)

福利 => 每天都推送

为什么,我要在这里提出要用Ultimate版本。

IDEA Community(社区版)再谈之无奈之下还是去安装旗舰版

IntelliJ IDEA的黑白色背景切换(Ultimate和Community版本皆通用)

使用 IntelliJ IDEA 导入 Spark 最新源码及编译 Spark 源代码

IDEA里如何多种方式打jar包,然后上传到集群

IntelliJ IDEA(Community版本)的下载、安装和WordCount的初步使用(本地模式和集群模式)

IntelliJ IDEA(Ultimate版本)的下载、安装和WordCount的初步使用(本地模式和集群模式)

基于Intellij IDEA搭建Spark开发环境搭——参考文档

参考文档http://spark.apache.org/docs/latest/programming-guide.html

操作步骤

a)创建maven 项目

b)引入依赖(Spark 依赖、打包插件等等)

基于Intellij IDEA搭建Spark开发环境—maven vs sbt

a)哪个熟悉用哪个

b)Maven也可以构建scala项目

基于Intellij IDEA搭建Spark开发环境搭—maven构建scala项目

参考文档http://docs.scala-lang.org/tutorials/scala-with-maven.html

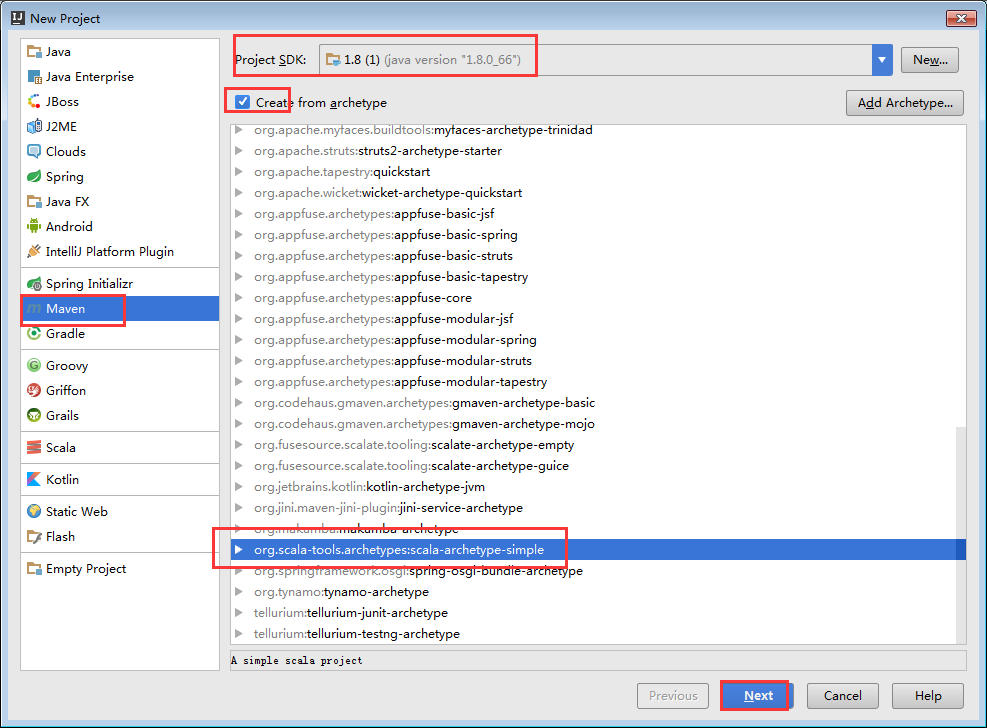

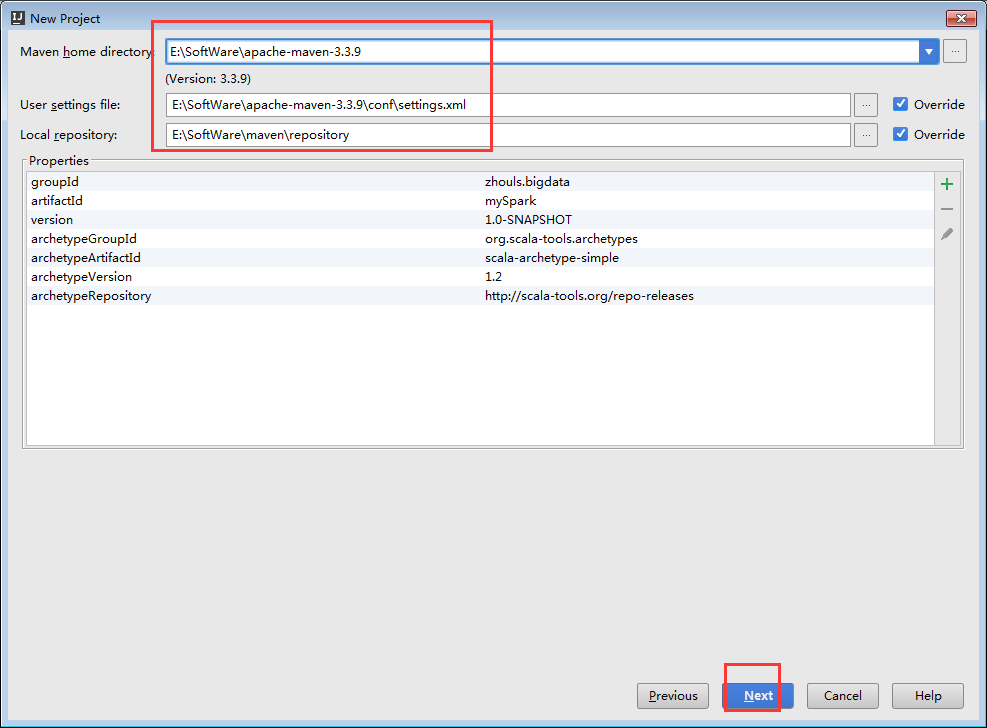

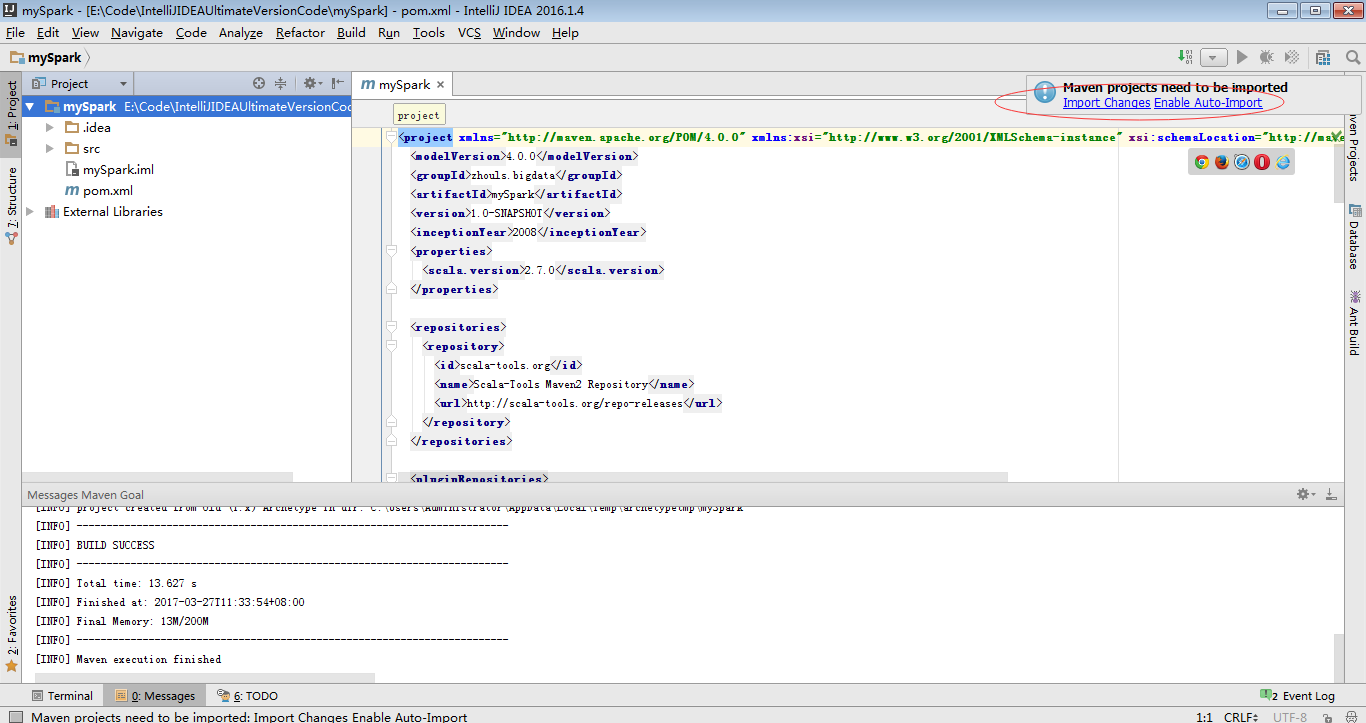

操作步骤

a) 用maven构建scala项目(基于net.alchim31.maven:scala-archetype-simple)

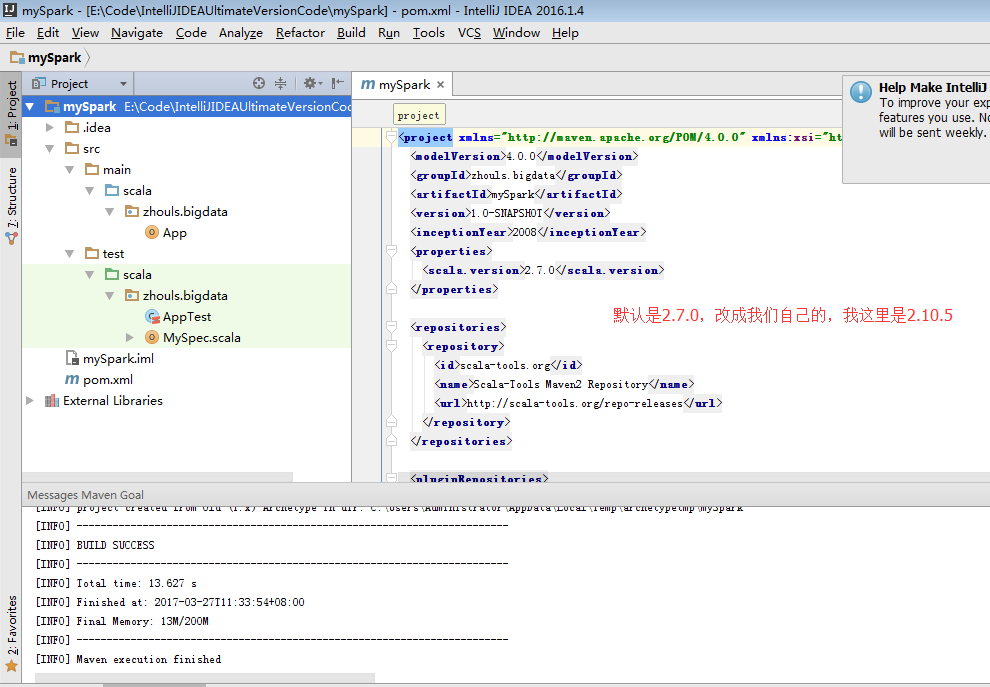

GroupId:zhouls.bigdata

ArtifactId:mySpark

Version:1.0-SNAPSHOT

mySpark E:\Code\IntelliJIDEAUltimateVersionCode\mySpark

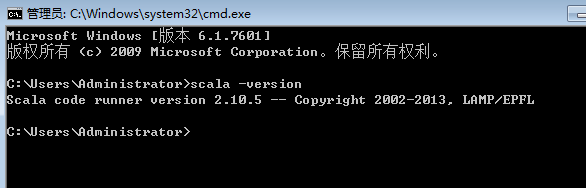

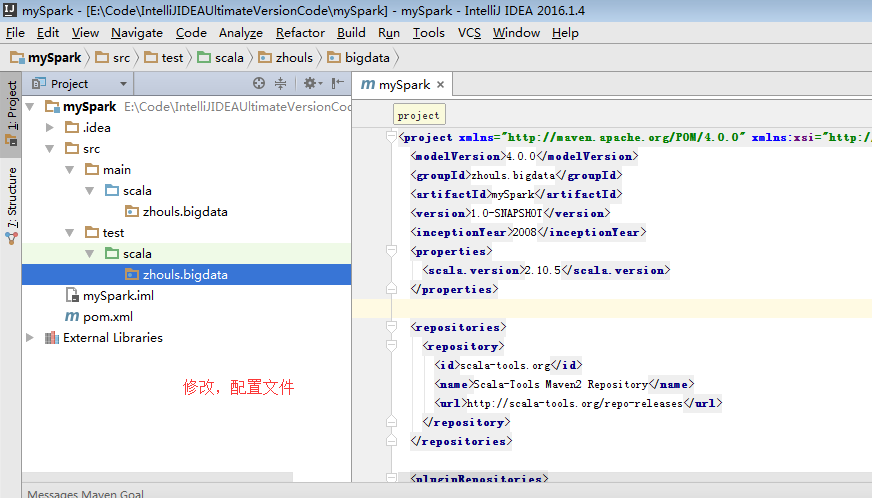

因为,我本地的scala版本是2.10.5

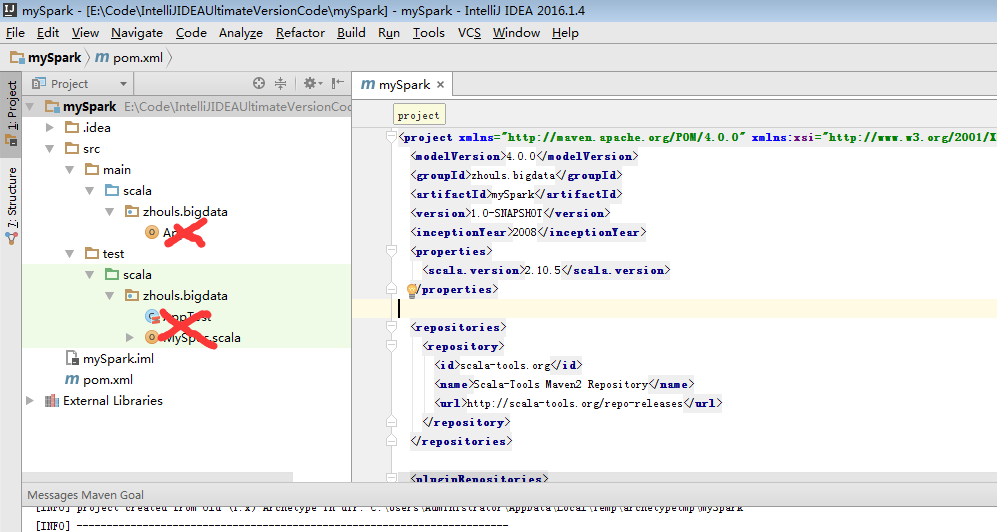

选中,delete就好。

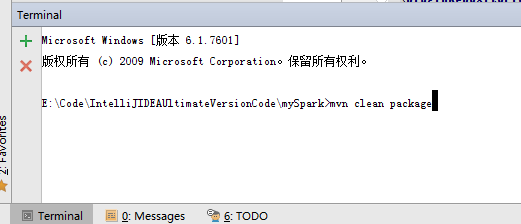

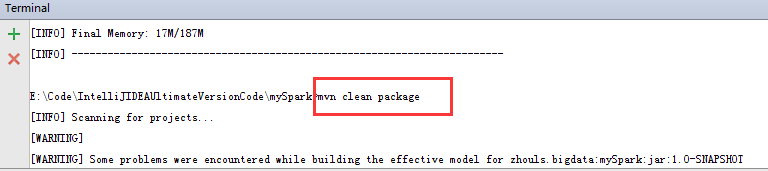

其实,这个就是windows里的cmd终端,只是IDEA它把这个cmd终端集成到这了。

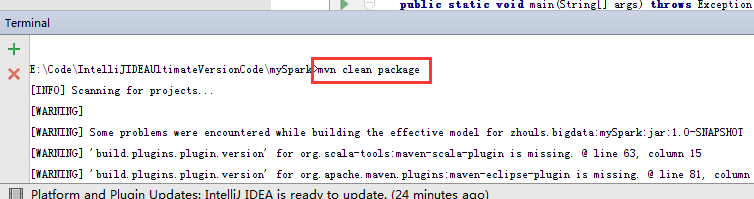

mvn clean package

这只是做个测试而已。

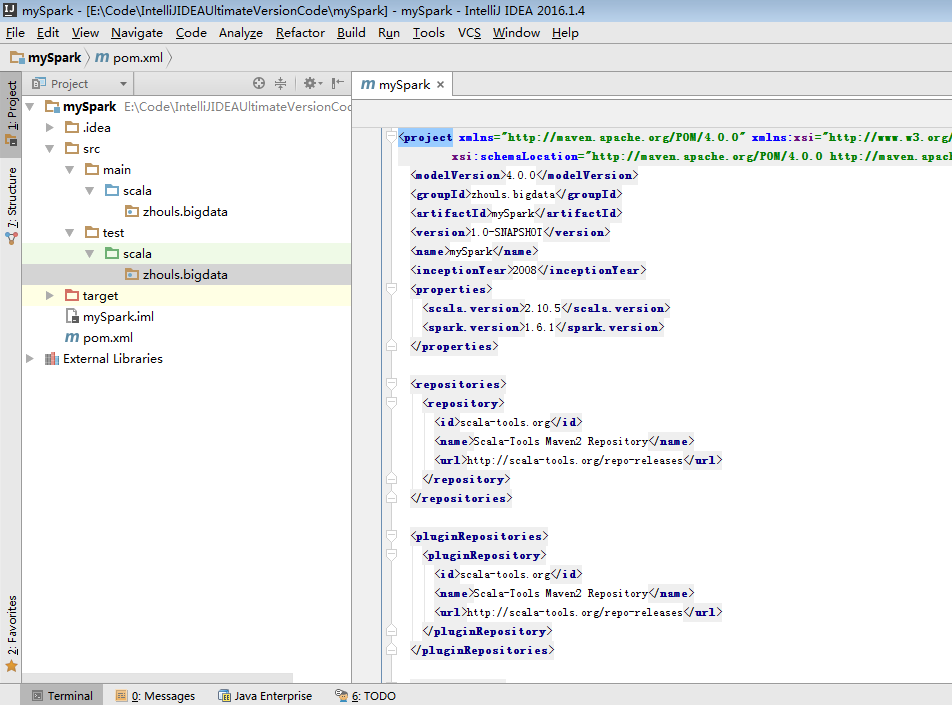

b)pom.xml引入依赖(spark依赖、打包插件等等)

注意:scala与java版本的兼容性

<project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/maven-v4_0_0.xsd">

<modelVersion>4.0.</modelVersion>

<groupId>zhouls.bigdata</groupId>

<artifactId>mySpark</artifactId>

<version>1.0-SNAPSHOT</version>

<name>mySpark</name>

<inceptionYear></inceptionYear>

<properties>

<scala.version>2.10.</scala.version>

<spark.version>1.6.</spark.version>

</properties> <repositories>

<repository>

<id>scala-tools.org</id>

<name>Scala-Tools Maven2 Repository</name>

<url>http://scala-tools.org/repo-releases</url>

</repository>

</repositories> <pluginRepositories>

<pluginRepository>

<id>scala-tools.org</id>

<name>Scala-Tools Maven2 Repository</name>

<url>http://scala-tools.org/repo-releases</url>

</pluginRepository>

</pluginRepositories> <dependencies>

<dependency>

<groupId>org.scala-lang</groupId>

<artifactId>scala-library</artifactId>

<version>${scala.version}</version>

</dependency>

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>4.4</version>

<scope>test</scope>

</dependency>

<dependency>

<groupId>org.specs</groupId>

<artifactId>specs</artifactId>

<version>1.2.</version>

<scope>test</scope>

</dependency>

<!--spark -->

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-core_2.</artifactId>

<version>${spark.version}</version>

<scope>provided</scope>

</dependency>

</dependencies> <build>

<!--

<sourceDirectory>src/main/scala</sourceDirectory>

<testSourceDirectory>src/test/scala</testSourceDirectory>

-->

<plugins>

<plugin>

<groupId>org.scala-tools</groupId>

<artifactId>maven-scala-plugin</artifactId>

<executions>

<execution>

<goals>

<goal>compile</goal>

<goal>testCompile</goal>

</goals>

</execution>

</executions>

<configuration>

<scalaVersion>${scala.version}</scalaVersion>

<args>

<arg>-target:jvm-1.5</arg>

</args>

</configuration>

</plugin>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-eclipse-plugin</artifactId>

<configuration>

<downloadSources>true</downloadSources>

<buildcommands>

<buildcommand>ch.epfl.lamp.sdt.core.scalabuilder</buildcommand>

</buildcommands>

<additionalProjectnatures>

<projectnature>ch.epfl.lamp.sdt.core.scalanature</projectnature>

</additionalProjectnatures>

<classpathContainers>

<classpathContainer>org.eclipse.jdt.launching.JRE_CONTAINER</classpathContainer>

<classpathContainer>ch.epfl.lamp.sdt.launching.SCALA_CONTAINER</classpathContainer>

</classpathContainers>

</configuration>

</plugin>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-shade-plugin</artifactId>

<version>2.4.</version>

<executions>

<!-- Run shade goal on package phase -->

<execution>

<phase>package</phase>

<goals>

<goal>shade</goal>

</goals>

<configuration>

<transformers>

<!-- add Main-Class to manifest file -->

<transformer

implementation="org.apache.maven.plugins.shade.resource.ManifestResourceTransformer">

<!--<mainClass>com.dajiang.MyDriver</mainClass>-->

</transformer>

</transformers>

<createDependencyReducedPom>false</createDependencyReducedPom>

</configuration>

</execution>

</executions>

</plugin>

</plugins>

</build>

<reporting>

<plugins>

<plugin>

<groupId>org.scala-tools</groupId>

<artifactId>maven-scala-plugin</artifactId>

<configuration>

<scalaVersion>${scala.version}</scalaVersion>

</configuration>

</plugin>

</plugins>

</reporting>

</project>

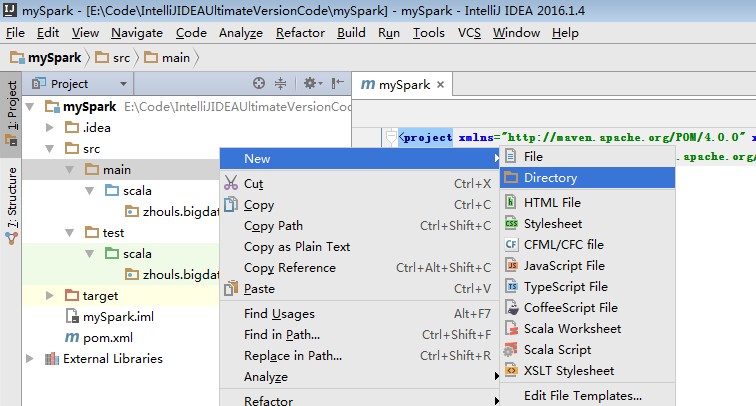

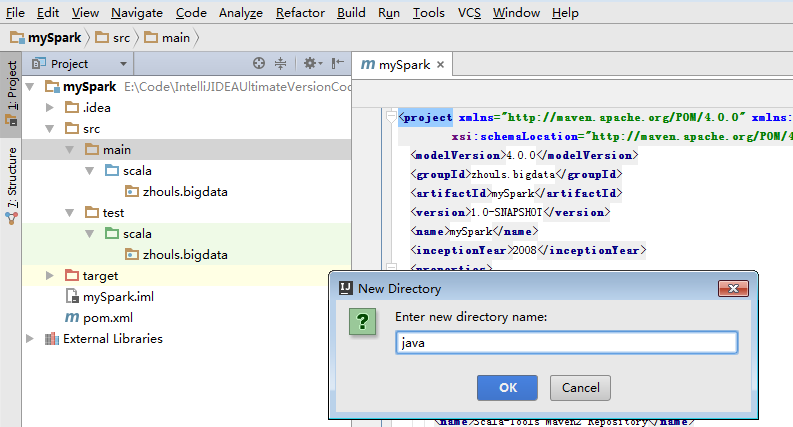

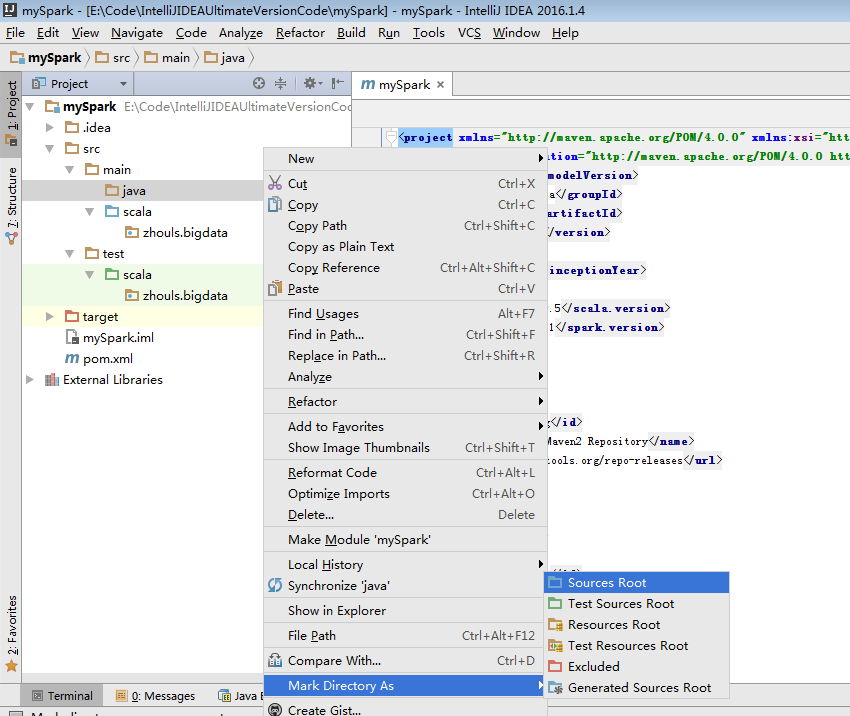

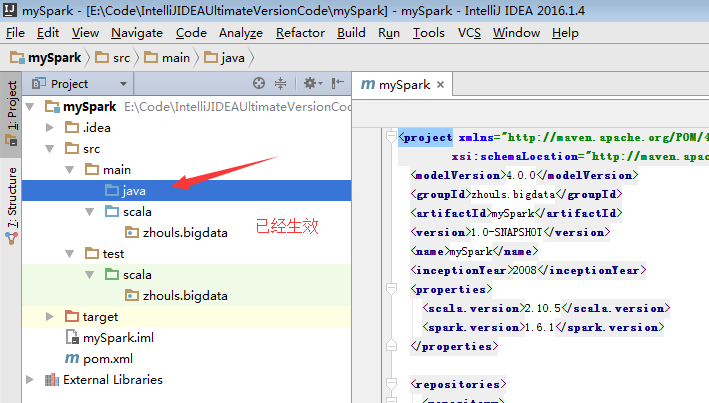

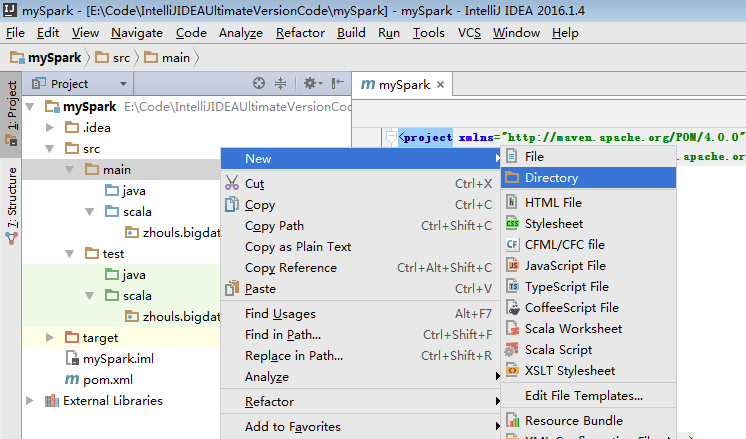

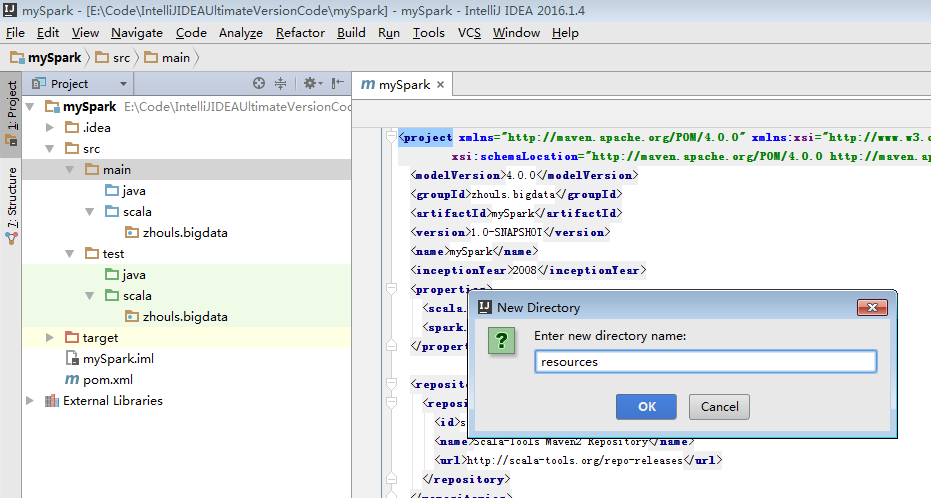

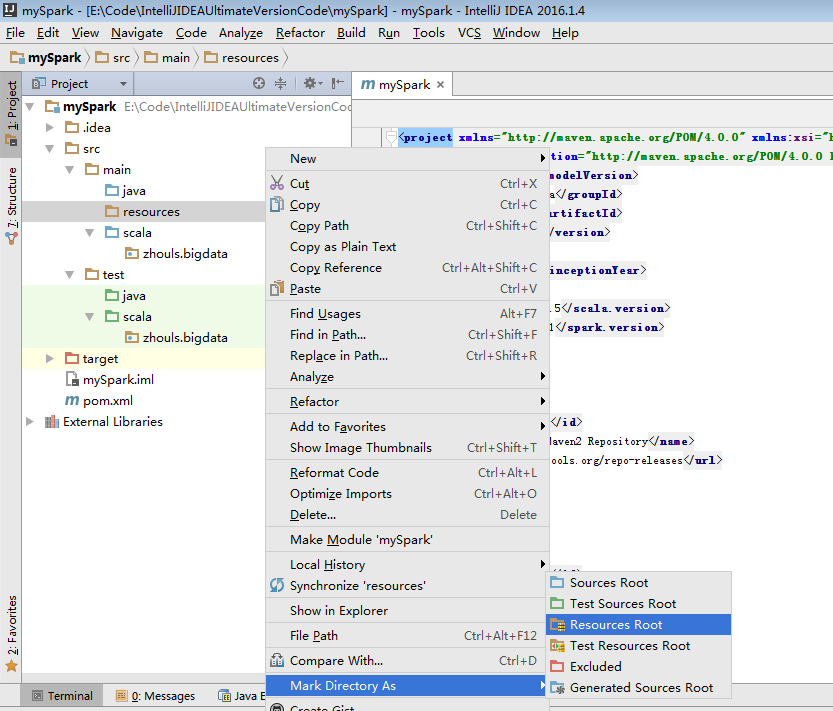

为了养成,开发规范。

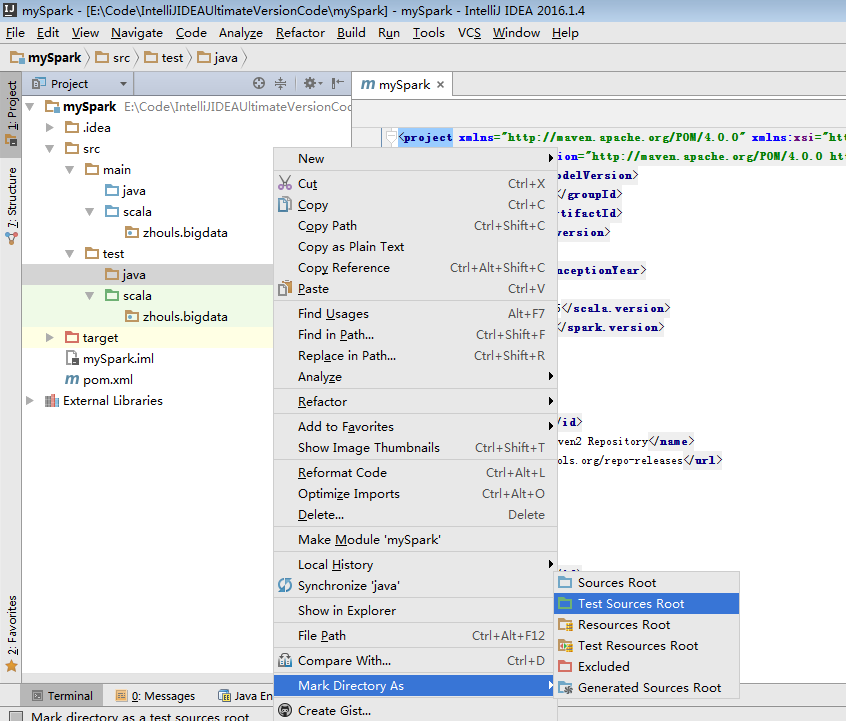

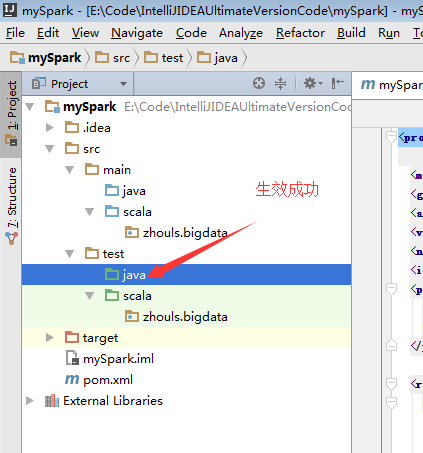

默认,创建是没有生效的,比如做如下,才能生效。

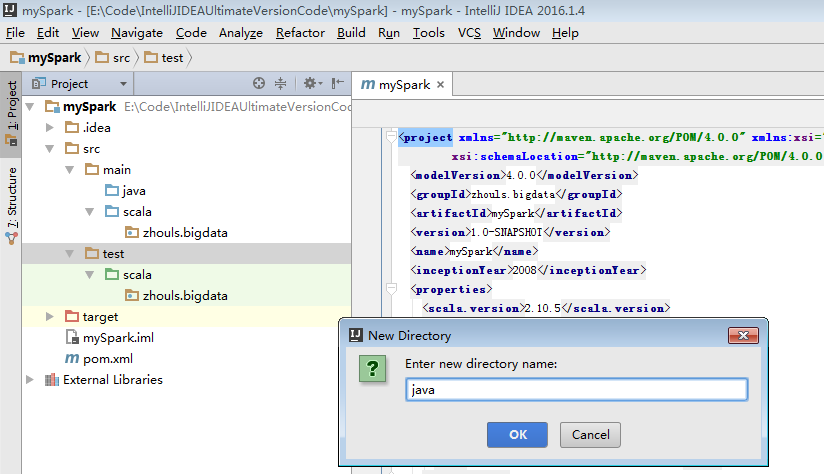

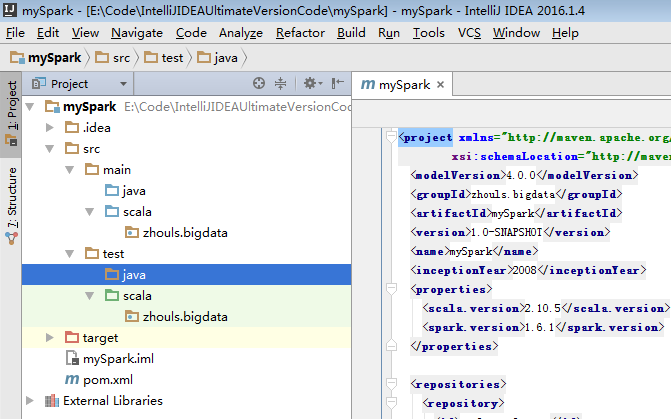

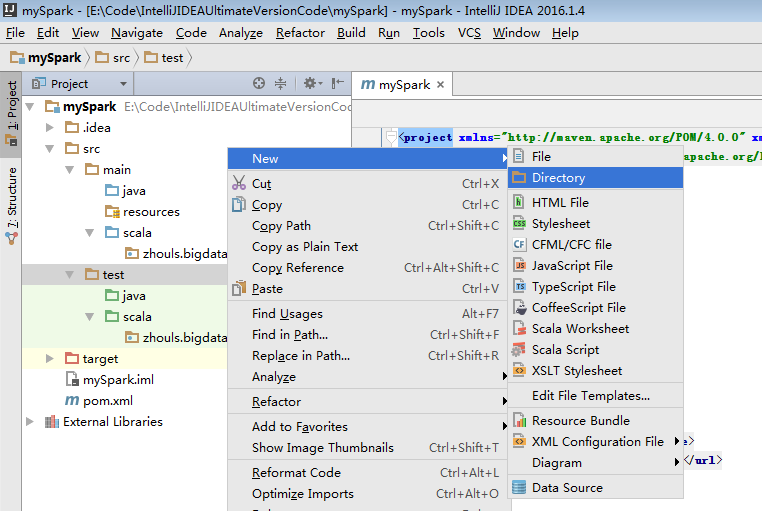

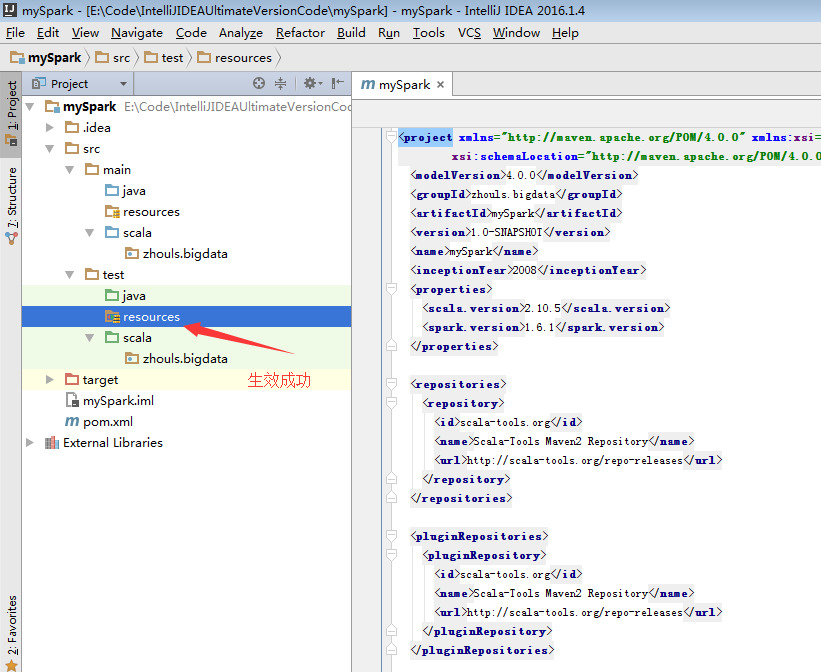

同样,对于下面的单元测试,也是一样

默认,也是没有生效的。

必须做如下的动作,才能生效。

开发第一个Spark程序

scala入门-01-IDEA安装scala插件

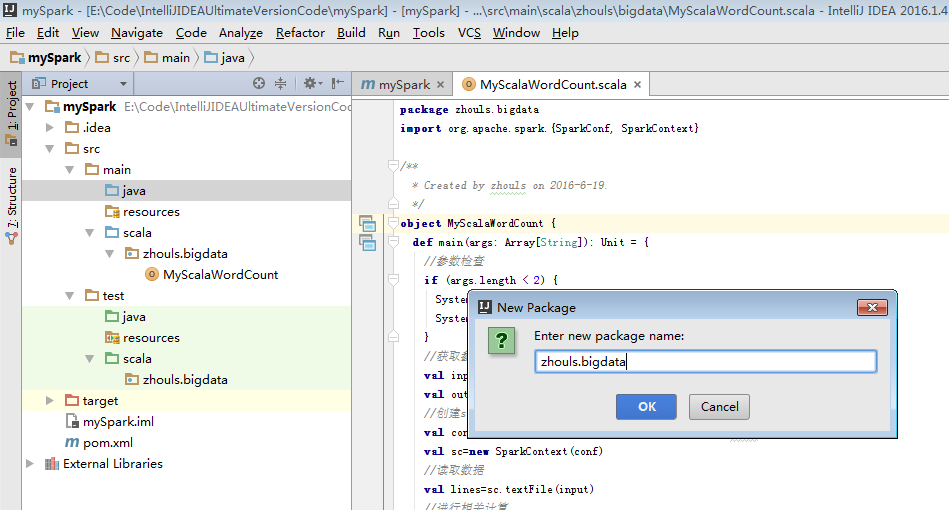

a) 第一个Scala版本的spark程序

package zhouls.bigdata

import org.apache.spark.{SparkConf, SparkContext} /**

* Created by zhouls on 2016-6-19.

*/

object MyScalaWordCount {

def main(args: Array[String]): Unit = {

//参数检查

if (args.length < 2) {

System.err.println("Usage: MyScalaWordCout <input> <output> ")

System.exit(1)

}

//获取参数

val input=args(0)

val output=args(1)

//创建scala版本的SparkContext

val conf=new SparkConf().setAppName("MyScalaWordCout ")

val sc=new SparkContext(conf)

//读取数据

val lines=sc.textFile(input)

//进行相关计算

val resultRdd=lines.flatMap(_.split(" ")).map((_,1)).reduceByKey(_+_)

//保存结果

resultRdd.saveAsTextFile(output)

sc.stop()

}

}

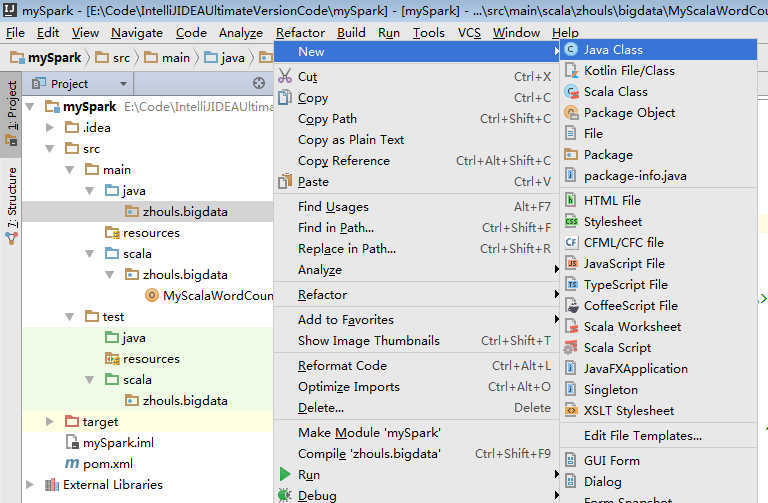

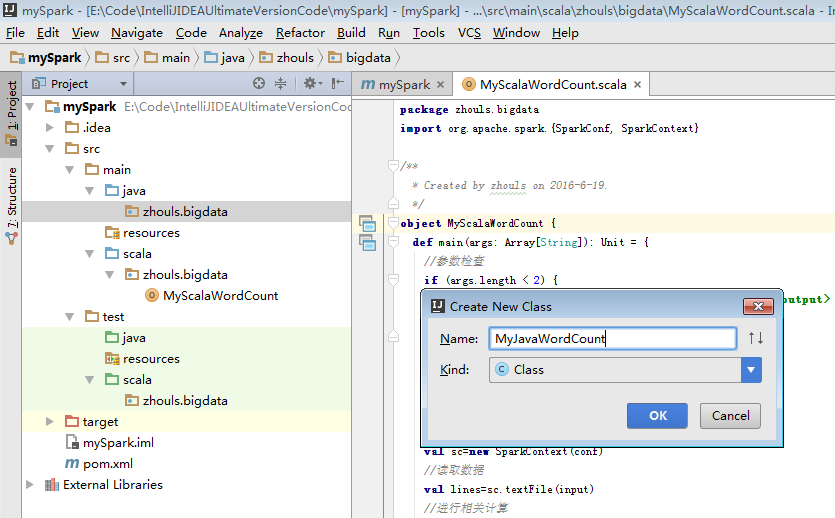

b) 第一个Java版本的spark程序

package zhouls.bigdata; import org.apache.spark.SparkConf;

import org.apache.spark.api.java.JavaPairRDD;

import org.apache.spark.api.java.JavaRDD;

import org.apache.spark.api.java.JavaSparkContext;

import org.apache.spark.api.java.function.FlatMapFunction;

import org.apache.spark.api.java.function.Function2;

import org.apache.spark.api.java.function.PairFunction;

import scala.Tuple2; import java.util.Arrays; /**

* Created by zhouls on 2016-6-19.

*/

public class MyJavaWordCount {

public static void main(String[] args) {

//参数检查

if(args.length<2){

System.err.println("Usage: MyJavaWordCount <input> <output> ");

System.exit(1);

}

//获取参数

String input=args[0];

String output=args[1]; //创建java版本的SparkContext

SparkConf conf=new SparkConf().setAppName("MyJavaWordCount");

JavaSparkContext sc=new JavaSparkContext(conf);

//读取数据

JavaRDD inputRdd=sc.textFile(input);

//进行相关计算

JavaRDD words=inputRdd.flatMap(new FlatMapFunction() {

public Iterable call(String line) throws Exception {

return Arrays.asList(line.split(" "));

}

}); JavaPairRDD result=words.mapToPair(new PairFunction() {

public Tuple2 call(String word) throws Exception {

return new Tuple2(word,1);

}

}).reduceByKey(new Function2() {

public Integer call(Integer x, Integer y) throws Exception {

return x+y;

}

});

//保存结果

result.saveAsTextFile(output);

//关闭sc

sc.stop();

}

}

或者

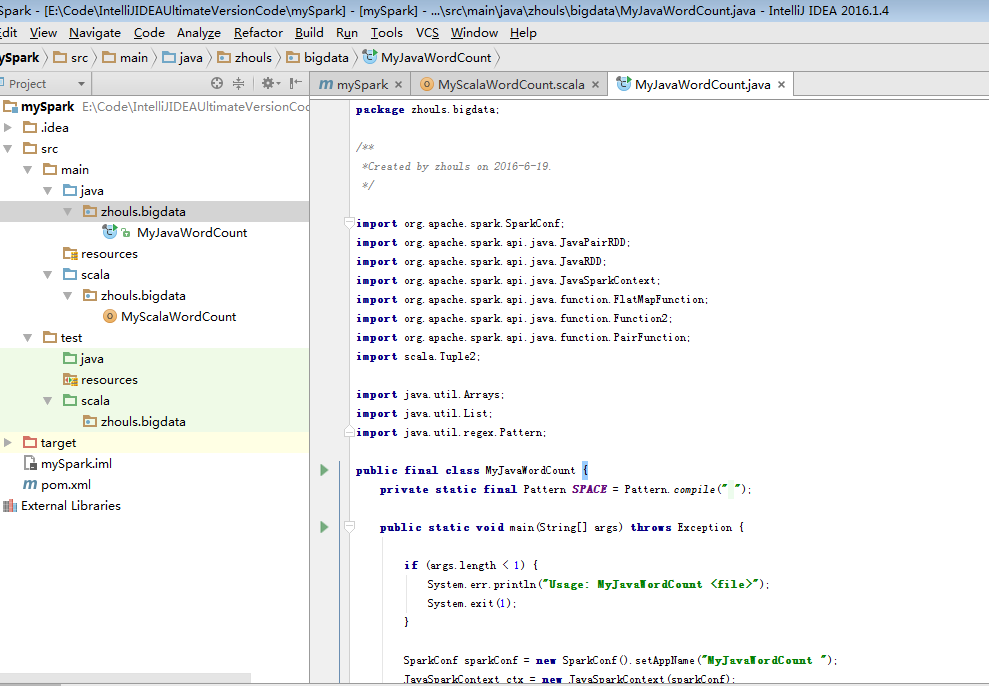

package zhouls.bigdata; /**

*Created by zhouls on 2016-6-19.

*/ import org.apache.spark.SparkConf;

import org.apache.spark.api.java.JavaPairRDD;

import org.apache.spark.api.java.JavaRDD;

import org.apache.spark.api.java.JavaSparkContext;

import org.apache.spark.api.java.function.FlatMapFunction;

import org.apache.spark.api.java.function.Function2;

import org.apache.spark.api.java.function.PairFunction;

import scala.Tuple2; import java.util.Arrays;

import java.util.List;

import java.util.regex.Pattern; public final class MyJavaWordCount {

private static final Pattern SPACE = Pattern.compile(" "); public static void main(String[] args) throws Exception { if (args.length < 1) {

System.err.println("Usage: MyJavaWordCount <file>");

System.exit(1);

} SparkConf sparkConf = new SparkConf().setAppName("MyJavaWordCount ");

JavaSparkContext ctx = new JavaSparkContext(sparkConf);

JavaRDD<String> lines = ctx.textFile(args[0], 1); JavaRDD<String> words = lines.flatMap(new FlatMapFunction<String, String>() {

public Iterable<String> call(String s) {

return Arrays.asList(SPACE.split(s));

}

}); JavaPairRDD<String, Integer> ones = words.mapToPair(new PairFunction<String, String, Integer>() {

public Tuple2<String, Integer> call(String s) {

return new Tuple2<String, Integer>(s, 1);

}

}); JavaPairRDD<String, Integer> counts = ones.reduceByKey(new Function2<Integer, Integer, Integer>() {

public Integer call(Integer i1, Integer i2) {

return i1 + i2;

}

}); List<Tuple2<String, Integer>> output = counts.collect();

for (Tuple2<?, ?> tuple : output) {

System.out.println(tuple._1() + ": " + tuple._2());

}

ctx.stop();

}

}

运行自己开发第一个Spark程序

Spark maven 项目打包

IDEA里如何多种方式打jar包,然后上传到集群

推荐下面这种方式

1、先切换到此工程路径下

默认,会到E:\Code\IntelliJIDEAUltimateVersionCode\mySpark>

mvn clean package

mvn package

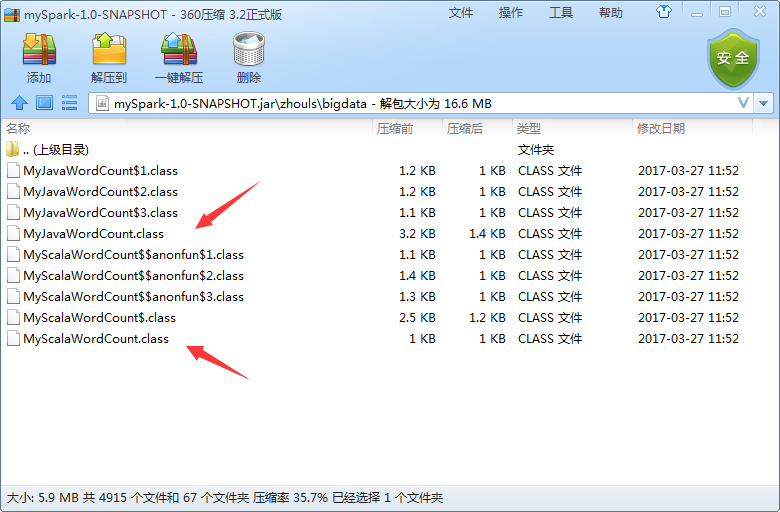

为了,更好的学习,其实,我们可以将它拷贝到桌面,去看看,是否真正打包进入。因为这里,是需要包括MyJavaWordCount.java和MyScalaWordCout.scala

准备好数据

[spark@sparksinglenode wordcount]$ pwd

/home/spark/testspark/inputData/wordcount

[spark@sparksinglenode wordcount]$ ll

total 4

-rw-rw-r-- 1 spark spark 92 Mar 24 18:45 wc.txt

[spark@sparksinglenode wordcount]$ cat wc.txt

hadoop spark

storm zookeeper

scala java

hive hbase

mapreduce hive

hadoop hbase

spark hadoop

[spark@sparksinglenode wordcount]$

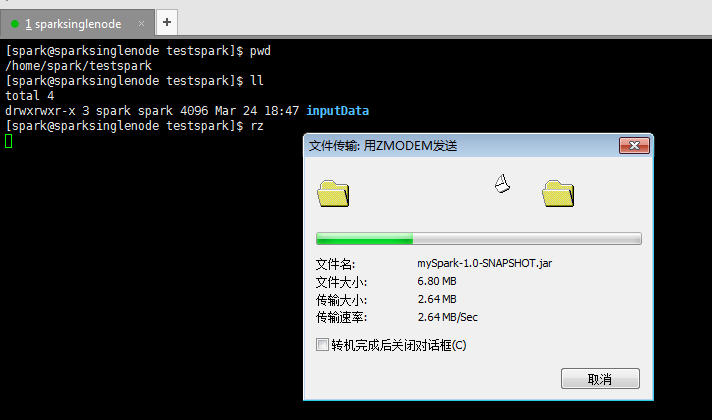

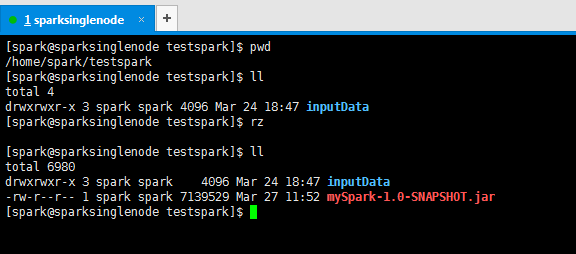

上传好刚之前打好的jar包

提交Spark 集群运行

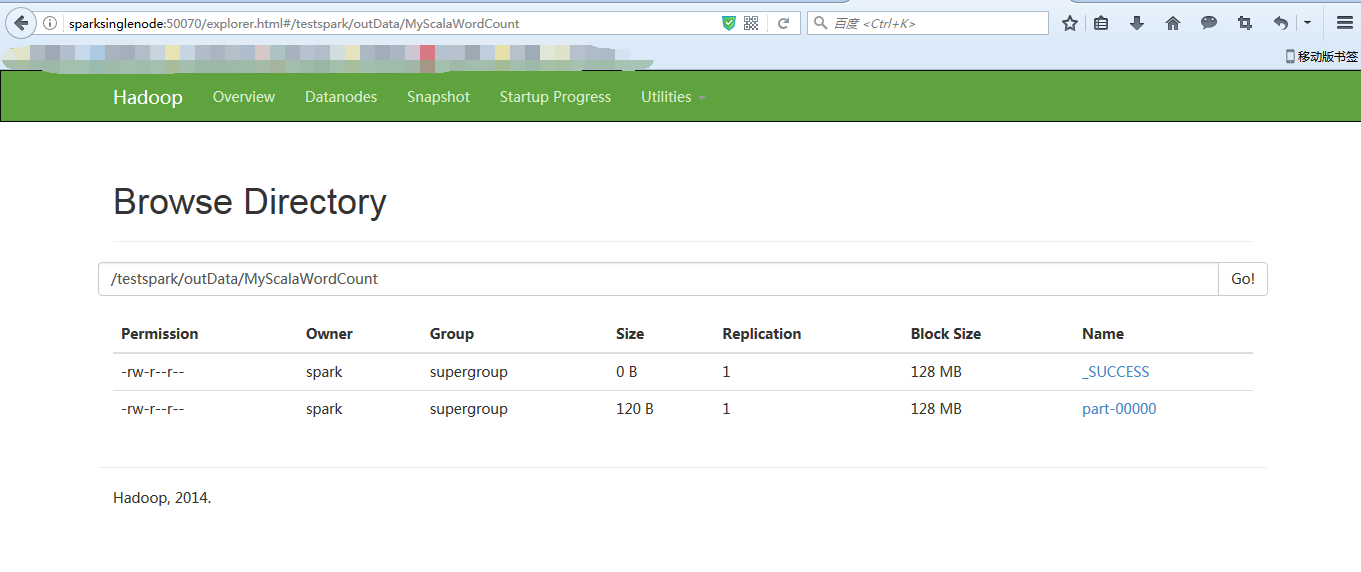

a) 提交Scala版本的Wordcount

到$SPARK_HOME安装目录下,去执行如下命令。

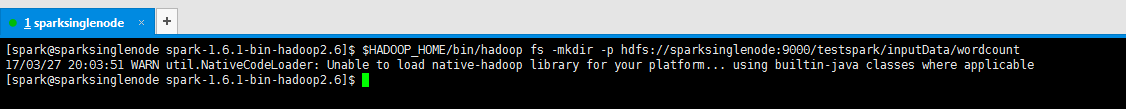

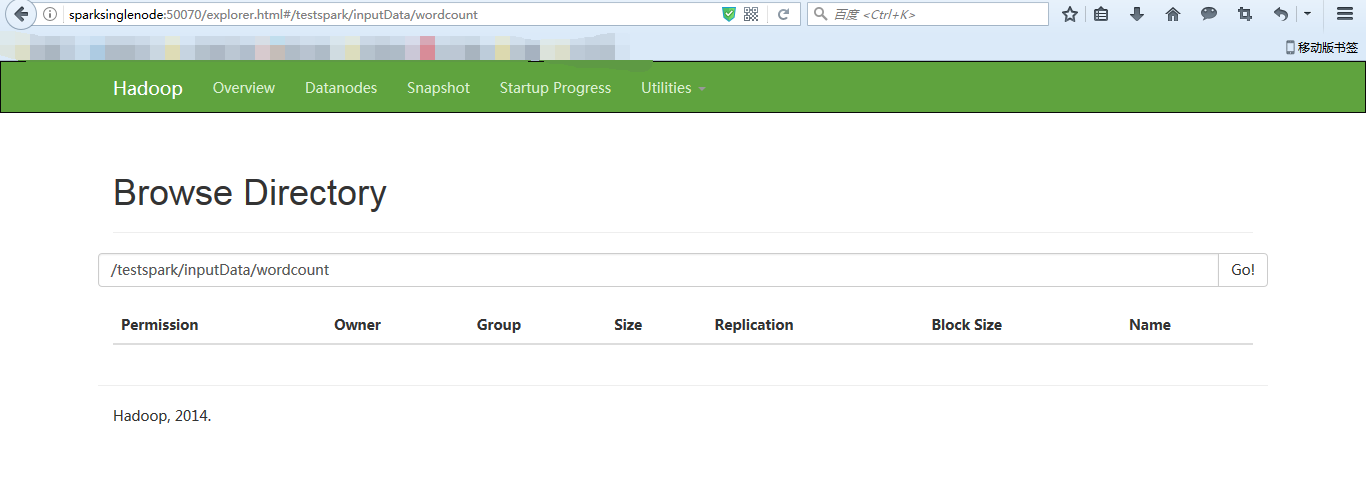

[spark@sparksinglenode spark-1.6.1-bin-hadoop2.6]$ $HADOOP_HOME/bin/hadoop fs -mkdir -p hdfs://sparksinglenode:9000/testspark/inputData/wordcount

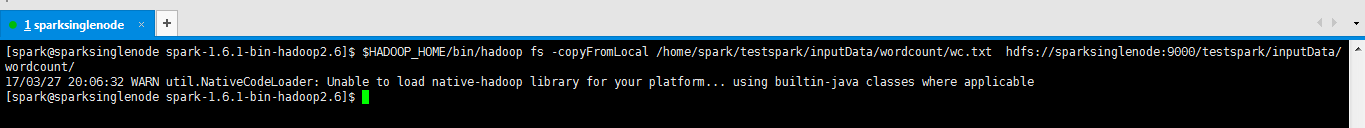

[spark@sparksinglenode spark-1.6.1-bin-hadoop2.6]$ $HADOOP_HOME/bin/hadoop fs -copyFromLocal /home/spark/testspark/inputData/wordcount/wc.txt hdfs://sparksinglenode:9000/testspark/inputData/wordcount/

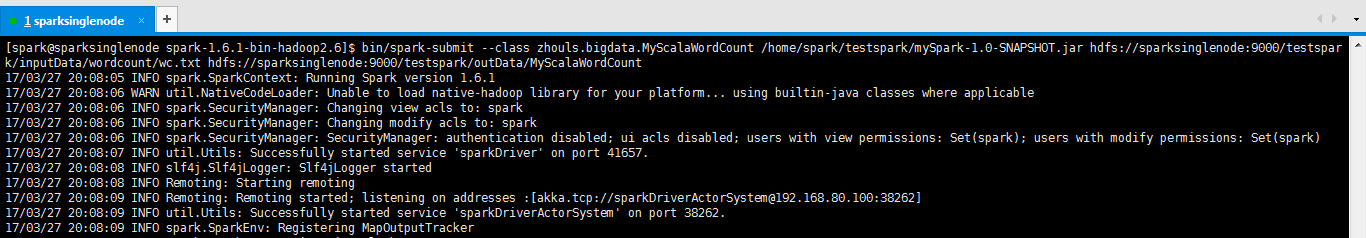

[spark@sparksinglenode spark-1.6.1-bin-hadoop2.6]$ bin/spark-submit --class zhouls.bigdata.MyScalaWordCount /home/spark/testspark/mySpark-1.0-SNAPSHOT.jar hdfs://sparksinglenode:9000/testspark/inputData/wordcount/wc.txt hdfs://sparksinglenode:9000/testspark/outData/MyScalaWordCount

注意,以上,是输入路径和输出都要在集群里。因为我这里的程序打包里,制定是在集群里(即hdfs)。所以只能用这种方法。

成功!

[spark@sparksinglenode spark-1.6.1-bin-hadoop2.6]$ $HADOOP_HOME/bin/hadoop fs -cat hdfs://sparksinglenode:9000/testspark/outData/MyScalaWordCount/part-*

17/03/27 20:12:55 WARN util.NativeCodeLoader: Unable to load native-hadoop library for your platform... using builtin-java classes where applicable

(storm zookeeper,1)

(hadoop spark,1)

(spark hadoop,1)

(mapreduce hive,1)

(scala java,1)

(hive hbase,1)

(hadoop hbase,1)

[spark@sparksinglenode spark-1.6.1-bin-hadoop2.6]$

注意:若想要在本地(即windows里或linux里能运行的话。则只需在程序代码里。注明是local就好,这个很简单。不多赘述,再打包。再运行就可以了。

[spark@sparksinglenode spark-1.6.1-bin-hadoop2.6]$ bin/spark-submit --class zhouls.bigdata.MyScalaWordCount /home/spark/testspark/mySpark-1.0-SNAPSHOT.jar /home/spark/testspark/inputData/wordcount/wc.txt /home/spark/testspark/outData/MyScalaWordCount

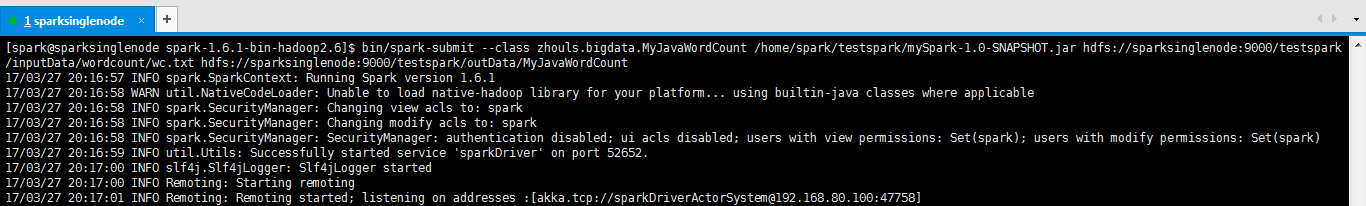

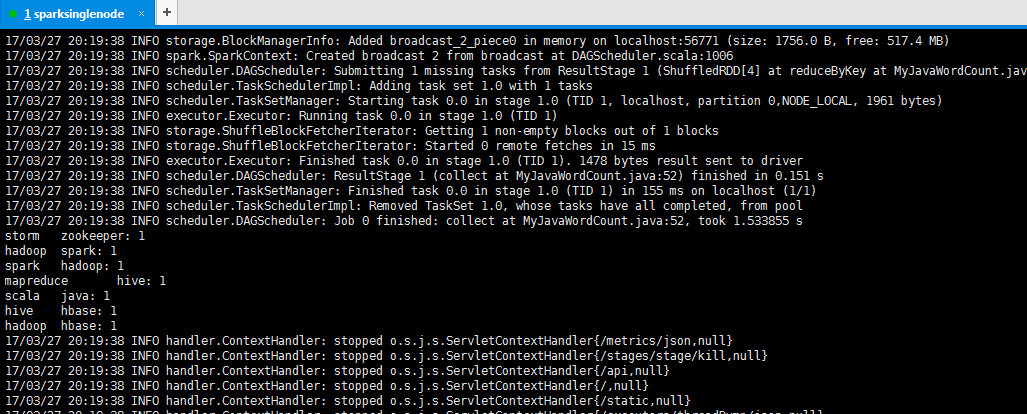

b) 提交Java版本的Wordcount

[spark@sparksinglenode spark-1.6.1-bin-hadoop2.6]$ bin/spark-submit --class zhouls.bigdata.MyJavaWordCount /home/spark/testspark/mySpark-1.0-SNAPSHOT.jar hdfs://sparksinglenode:9000/testspark/inputData/wordcount/wc.txt hdfs://sparksinglenode:9000/testspark/outData/MyJavaWordCount

storm zookeeper: 1

hadoop spark: 1

spark hadoop: 1

mapreduce hive: 1

scala java: 1

hive hbase: 1

hadoop hbase: 1

注意:若想要在本地(即windows里或linux里能运行的话。则只需在程序代码里。注明是local就好,这个很简单。不多赘述,再打包。再运行就可以了。

bin/spark-submit --class com.zhouls.test.MyJavaWordCount /home/spark/testspark/mySpark-1.0.SNAPSHOT.jar /home/spark/testspark/inputData/wordcount/wc.txt /home/spark/testspark/outData/MyJavaWordCount

成功!

关于对pom.xml的进一步深入,见

对于maven创建spark项目的pom.xml配置文件(图文详解)

推荐博客

Scala IDEA for Eclipse里用maven来创建scala和java项目代码环境(图文详解)

用maven来创建scala和java项目代码环境(图文详解)(Intellij IDEA(Ultimate版本)、Intellij IDEA(Community版本)和Scala IDEA for Eclipse皆适用)(博主推荐)

同时,大家可以关注我的个人博客:

http://www.cnblogs.com/zlslch/ 和 http://www.cnblogs.com/lchzls/ http://www.cnblogs.com/sunnyDream/

详情请见:http://www.cnblogs.com/zlslch/p/7473861.html

人生苦短,我愿分享。本公众号将秉持活到老学到老学习无休止的交流分享开源精神,汇聚于互联网和个人学习工作的精华干货知识,一切来于互联网,反馈回互联网。

目前研究领域:大数据、机器学习、深度学习、人工智能、数据挖掘、数据分析。 语言涉及:Java、Scala、Python、Shell、Linux等 。同时还涉及平常所使用的手机、电脑和互联网上的使用技巧、问题和实用软件。 只要你一直关注和呆在群里,每天必须有收获

对应本平台的讨论和答疑QQ群:大数据和人工智能躺过的坑(总群)(161156071)

打开百度App,扫码,精彩文章每天更新!欢迎关注我的百家号: 九月哥快讯

Spark编程环境搭建(基于Intellij IDEA的Ultimate版本)(包含Java和Scala版的WordCount)(博主强烈推荐)的更多相关文章

- IntelliJ IDEA(Ultimate版本)的下载、安装和WordCount的初步使用(本地模式和集群模式)

不多说,直接上干货! IntelliJ IDEA号称当前Java开发效率最高的IDE工具.IntelliJ IDEA有两个版本:社区版(Community)和旗舰版(Ultimate).社区版时免费的 ...

- Ubuntu14.04下Ambari安装搭建部署大数据集群(图文分五大步详解)(博主强烈推荐)

不多说,直接上干货! 写在前面的话 (1) 最近一段时间,因担任我团队实验室的大数据环境集群真实物理机器工作,至此,本人秉持负责.认真和细心的态度,先分别在虚拟机上模拟搭建ambari(基于CentO ...

- Ubuntu14.04下Cloudera安装搭建部署大数据集群(图文分五大步详解)(博主强烈推荐)(在线或离线)

第一步: Cloudera Manager安装之Cloudera Manager安装前准备(Ubuntu14.04)(一) 第二步: Cloudera Manager安装之时间服务器和时间客户端(Ub ...

- Spark编程环境搭建及WordCount实例

基于Intellij IDEA搭建Spark开发环境搭建 基于Intellij IDEA搭建Spark开发环境搭——参考文档 ● 参考文档http://spark.apache.org/docs/la ...

- CentOS6.5下Ambari安装搭建部署大数据集群(图文分五大步详解)(博主强烈推荐)

第一步: Ambari安装之Ambari安装前准备(CentOS6.5)(一) 第二步: Ambari安装之部署本地库(镜像服务器)(二) 第三步: Ambari安装之安装并配置Ambari-serv ...

- CentOS6.5下Cloudera安装搭建部署大数据集群(图文分五大步详解)(博主强烈推荐)

不多说,直接上干货! 第一步: Cloudera Manager安装之Cloudera Manager安装前准备(CentOS6.5)(一) 第二步: Cloudera Manager安装之时间服务 ...

- 用maven来创建scala和java项目代码环境(图文详解)(Intellij IDEA(Ultimate版本)、Intellij IDEA(Community版本)和Scala IDEA for Eclipse皆适用)(博主推荐)

不多说,直接上干货! 为什么要写这篇博客? 首先,对于spark项目,强烈建议搭建,用Intellij IDEA(Ultimate版本),如果你还有另所爱好尝试Scala IDEA for Eclip ...

- 使用 IntelliJ IDEA 导入 Spark 最新源码及编译 Spark 源代码(博主强烈推荐)

前言 其实啊,无论你是初学者还是具备了有一定spark编程经验,都需要对spark源码足够重视起来. 本人,肺腑之己见,想要成为大数据的大牛和顶尖专家,多结合源码和操练编程. 准备工作 1.sca ...

- IntelliJ IDEA(Community版本)的下载、安装和WordCount的初步使用(本地模式和集群模式)

不多说,直接上干货! 对于初学者来说,建议你先玩玩这个免费的社区版,但是,一段时间,还是去玩专业版吧,这个很简单哈,学聪明点,去搞到途径激活!可以看我的博客. 包括: IntelliJ IDEA(Co ...

随机推荐

- 用Socket开发的一枚小型实时通信App

Socket 英文原意是插座. 在网络世界里, 当一台主机温柔而体贴的同时提供多个服务时, 每个服务被绑定在一个端口上, 而每个端口就好像一个小插座. 用户们连接对应的插座去获取相应的服务. 在Nod ...

- Hdu3363 Ice-sugar Gourd 2017-01-16 11:39 43人阅读 评论(0) 收藏

Ice-sugar Gourd Time Limit: 5000/2000 MS (Java/Others) Memory Limit: 65536/65536 K (Java/Others) ...

- 手动设置3G的wifi迷你无线路由

1.插入中兴的3G无线网卡,终端上显示如下内容: ~ >: usb 1-1.3: new full speed USB device number 11 using s3c2410-ohci u ...

- queued frame 造成图形性能卡顿

曾经遇到过卡顿是类似的原因:当时对显卡底层知识理解不懂,看到引擎底层有一个MaxFramexxx的接口,实现是使用注册表修改显卡底层的注册信息,当时还是一个掉接口习惯的客户端码农的思维,没理解底层含义 ...

- Android-项目所有文件报红色j,状态栏无法Run 'app'

项目所有文件报红色j,不可用状态 状态栏如下: 无法 Run 'app' 无法 Debug 'app' ........... 以下操作按钮灰色的,无法点击: 解决方案: 只需要:Sync Proje ...

- Sending Email In .NET Core 2.0

Consider the following written in .NET Core 2.0. SmtpClient client = ) { UseDefaultCredentials = tru ...

- Dalsa线扫相机SDK开发-小试牛刀(1)

拿到了dalsa相机,可以用Sapera软件配置相机,进行图像采集.但是自己开发的话就得撸起袖子写代码了,查了两篇不错的博文,作为指导. Sapera帮助文档 - <好好先生>专栏 - 博 ...

- EFCore 2.0引用标量函数

参考文档:https://www.cnblogs.com/CreateMyself/p/8485697.html 1.添加nuget包:EntityFramework.Functions,在上下文类M ...

- 简单版nginx lua 完成流量上报于中间件

本文链接:https://www.cnblogs.com/zhenghongxin/p/9131226.html 公司某些业务下,需要将请求的流量上报于中间件(kafka,rabbitMq等),让st ...

- Python 第三方包上传至 PyPI 服务器

PyPI 服务器主要功能是?PyPI 服务器怎么搭建? PyPI 服务器可以用来管理自己开发的 Python 第三包. Pypi服务器搭建 Python 第三方包在本地打包 # 本地目录执行以下命令应 ...