DenseNet笔记

一、DenseNet的优点

- 减轻梯度消失问题

- 加强特征的传递

- 充分利用特征

- 减少了参数量

二、网络结构公式

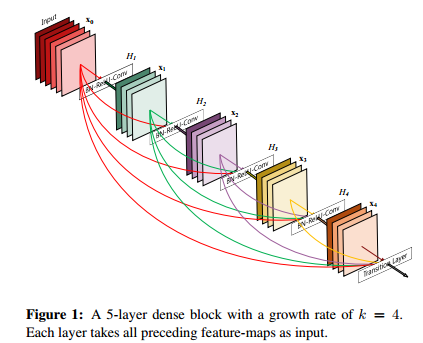

对于每一个DenseBlock中的每一个层,

[x0,x1,…,xl-1]表示将0到l-1层的输出feature map做concatenation。concatenation是做通道的合并,就像Inception那样。而前面resnet是做值的相加,通道数是不变的。Hl包括BN,ReLU和3*3的卷积。

而在ResNet中的每一个残差块,

三、Growth Rate

指的是DenseBlock中每一个非线性变换Hl(BN,ReLU和3*3的卷积)的输出,这个输出与输入Concate.一个DenseBlock的输出=输入+Hl数×growth_rate。在要给DenseBlock中,Feature Map的size保持不变。

四、Bottleneck

这个组件位于DenseBlock中,当一个DenseBlock包含的非线性变换Hl较多时(如nHl=48),此时的grow rate为k=32,那么第48层的输入变成input+47×32,这是一个很大的数,如果不用bottleneck进行降维,那么计算量很大。

因此,使用4×k个1x1卷积进行降维。使得3×3线性变换的输入通道变成4×k。同时,bottleneck起到特征融合的效果。

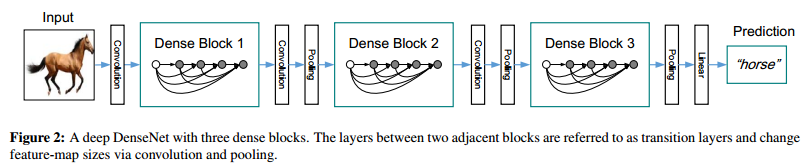

五、Transition

这个组件位于DenseBlock之间,使用1×1卷积进行降维,降维后的通道数为input_channels*reduction. 参数reduction默认为0.5,后接池化层进行下采样,减小Feature Map 分辨率。

六、网络结构

七、代码实现(Pytorch)

import torch

import torch.nn as nn

import torch.nn.functional as F

import math class Bottleneck(nn.Module):

def __init__(self,nChannels,growthRate):

super(Bottleneck,self).__init__()

interChannels = 4*growthRate

self.bn1 = nn.BatchNorm2d(nChannels)

self.conv1 = nn.Conv2d(nChannels,interChannels,kernel_size=1,

stride=1,bias=False)

self.bn2 = nn.BatchNorm2d(interChannels)

self.conv2 = nn.Conv2d(interChannels,growthRate,kernel_size=3,

stride=1,padding=1,bias=False) def forward(self, *input):

#先进行BN(pytorch的BN已经包含了Scale),然后进行relu,conv1起到bottleneck的作用

out = self.conv1(F.relu(self.bn1(input)))

out = self.conv2(F.relu(self.bn2(out)))

out = torch.cat(input,out)

return out class SingleLayer(nn.Module):

def __init__(self,nChannels,growthRate):

super(SingleLayer,self).__init__()

self.bn1 = nn.BatchNorm2d(nChannels)

self.conv1 = nn.Conv2d(nChannels,growthRate,kernel_size=3,

padding=1,bias=False) def forward(self, *input):

out = self.conv1(F.relu(self.bn1(input)))

out = torch.cat(input,out)

return out class Transition(nn.Module):

def __int__(self,nChannels,nOutChannels):

super(Transition,self).__init__() self.bn1 = nn.BatchNorm2d(nChannels)

self.conv1 = nn.Conv2d(nChannels,nOutChannels,kernel_size=1,bias=False) def forward(self, *input):

out = self.conv1(F.relu(self.bn1(input)))

out = F.avg_pool2d(out,2)

return out class DenseNet(nn.Module):

def __init__(self,growthRate,depth,reduction,nClasses,bottleneck):

super(DenseNet,self).__init__()

#DenseBlock中非线性变换模块的个数

nNoneLinears = (depth-4)//3

if bottleneck:

nNoneLinears //=2 nChannels = 2*growthRate

self.conv1 = nn.Conv2d(3,nChannels,kernel_size=3,padding=1,bias=False)

self.denseblock1 = self._make_dense(nChannels,growthRate,nNoneLinears,bottleneck)

nChannels += nNoneLinears*growthRate

nOutChannels = int(math.floor(nChannels*reduction)) #向下取整

self.transition1 = Transition(nChannels,nOutChannels) nChannels = nOutChannels

self.denseblock2 = self._make_dense(nChannels,growthRate,nNoneLinears,bottleneck)

nChannels += nNoneLinears*growthRate

nOutChannels = int(math.floor(nChannels*reduction))

self.transition2 = Transition(nChannels, nOutChannels) nChannels = nOutChannels

self.denseblock3 = self._make_dense(nChannels, growthRate, nNoneLinears, bottleneck)

nChannels += nNoneLinears * growthRate self.bn1 = nn.BatchNorm2d(nChannels)

self.fc = nn.Linear(nChannels,nClasses) #参数初始化

for m in self.modules():

if isinstance(m,nn.Conv2d):

n = m.kernel_size[0]*m.kernel_size[1]*m.out_channels

m.weight.data.normal_(0,math.sqrt(2./n))

elif isinstance(m,nn.BatchNorm2d):

m.weight.data.fill_(1)

m.bias.data.zero_()

elif isinstance(m,nn.Linear):

m.bias.data.zero_() def _make_dense(self,nChannels,growthRate,nDenseBlocks,bottleneck):

layers = []

for i in range(int(nDenseBlocks)):

if bottleneck:

layers.append(Bottleneck(nChannels,growthRate))

else:

layers.append(SingleLayer(nChannels,growthRate))

nChannels+=growthRate

return nn.Sequential(*layers) def forward(self, *input):

out = self.conv1(input)

out = self.transition1(self.denseblock1(out))

out = self.transition2(self.denseblock2(out))

out = self.denseblock3(out)

out = torch.squeeze(F.avg_pool2d(F.relu(self.bn1(out)),8))

out = F.log_softmax(self.fc(out))

return out

DenseNet笔记的更多相关文章

- 论文笔记——DenseNet

<Densely Connected Convolutional Networks>阅读笔记 代码地址:https://github.com/liuzhuang13/DenseNet 首先 ...

- 论文笔记:CNN经典结构2(WideResNet,FractalNet,DenseNet,ResNeXt,DPN,SENet)

前言 在论文笔记:CNN经典结构1中主要讲了2012-2015年的一些经典CNN结构.本文主要讲解2016-2017年的一些经典CNN结构. CIFAR和SVHN上,DenseNet-BC优于ResN ...

- DenseNet 论文阅读笔记

Densely Connected Convolutional Networks 原文链接 摘要 研究表明,如果卷积网络在接近输入和接近输出地层之间包含较短地连接,那么,该网络可以显著地加深,变得更精 ...

- tensorflow学习笔记——DenseNet

完整代码及其数据,请移步小编的GitHub地址 传送门:请点击我 如果点击有误:https://github.com/LeBron-Jian/DeepLearningNote 这里结合网络的资料和De ...

- 论文笔记系列-Neural Network Search :A Survey

论文笔记系列-Neural Network Search :A Survey 论文 笔记 NAS automl survey review reinforcement learning Bayesia ...

- 论文笔记:CNN经典结构1(AlexNet,ZFNet,OverFeat,VGG,GoogleNet,ResNet)

前言 本文主要介绍2012-2015年的一些经典CNN结构,从AlexNet,ZFNet,OverFeat到VGG,GoogleNetv1-v4,ResNetv1-v2. 在论文笔记:CNN经典结构2 ...

- 转载:DenseNet算法详解

原文连接:http://blog.csdn.net/u014380165/article/details/75142664 参考连接:http://blog.csdn.net/u012938704/a ...

- Dual Path Networks(DPN)——一种结合了ResNet和DenseNet优势的新型卷积网络结构。深度残差网络通过残差旁支通路再利用特征,但残差通道不善于探索新特征。密集连接网络通过密集连接通路探索新特征,但有高冗余度。

如何评价Dual Path Networks(DPN)? 论文链接:https://arxiv.org/pdf/1707.01629v1.pdf在ImagNet-1k数据集上,浅DPN超过了最好的Re ...

- DenseNet算法详解——思路就是highway,DneseNet在训练时十分消耗内存

论文笔记:Densely Connected Convolutional Networks(DenseNet模型详解) 2017年09月28日 11:58:49 阅读数:1814 [ 转载自http: ...

随机推荐

- VMware 三种网络模式的区别

VMware 三种网络模式的区别 VMware 三种网络模式的区别 我们首先说一下VMware的几个虚拟设备 VMnet0:用于虚拟桥接网络下的虚拟交换机 VMnet1:用于虚拟Host-Only网络 ...

- Educational Codeforces Round 48

题目地址 Edu48 A.Death Note 翻译 你有一个无穷页的本子,每一页可以写\(m\)个名字, 你在第\(i\)天要写\(a_i\)个名字,如果这一页恰好写满了,你就会翻页, 问每天的翻页 ...

- 《Linux内核设计与实现》第7章读书笔记

第七章 链接 一. 链接的概念 链接是将各种代码和数据部分收集起来并组合成为一个单一文件的过程.可以执行于编译.加载和运行时,由叫做链接器(可实现分离编译)的程序自动执行. 二.静态链接 为了创建静态 ...

- Andoid自动判断输入是电话,网址或者Email的方法--Linkify

Andoid自动判断输入是电话,网址或者Email的方法----Linkify的应用!http://blog.csdn.net/android_tutor/article/details/500016 ...

- dingo 内部调用获取异常信息

$exception->getResponse(); $params = [ 'company_id' => $this->request->input('company_id ...

- Docker图形界面管理之DockerUI

DockerUI DockerrUI是一个基于Docker API提供图形化页面简单的容器管理系统,支持容器管理.镜像管理. 1.1 下载镜像 docker pull abh1nav/dockerui ...

- 用Anaconda安装本地python包

Anaconda确实带来了很多方便,但是之前也过多的依赖了conda自带的一键下载python包的功能.这不,这几天突然要用FastFM这个包,无奈conda里没有,于是只能从github下载下来,实 ...

- GO_10:GO语言基础之error

Go错误处理 Go 语言通过内置的错误接口提供了非常简单的错误处理机制. error类型是一个接口类型,这是它的定义: type error interface { Error() string } ...

- Hadoop基础-HDFS分布式文件系统的存储

Hadoop基础-HDFS分布式文件系统的存储 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 一.HDFS数据块 1>.磁盘中的数据块 每个磁盘都有默认的数据块大小,这个磁盘 ...

- MySQL数据库语法-多表查询练习一

MySQL数据库语法-多表查询练习一 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 本篇博客主要介绍的多表查询的外键约束,以及如何使用外链接和内连接查询数据信息. 一.数据表和测试 ...