kubernetes常见日志采集问题和解决方案分析

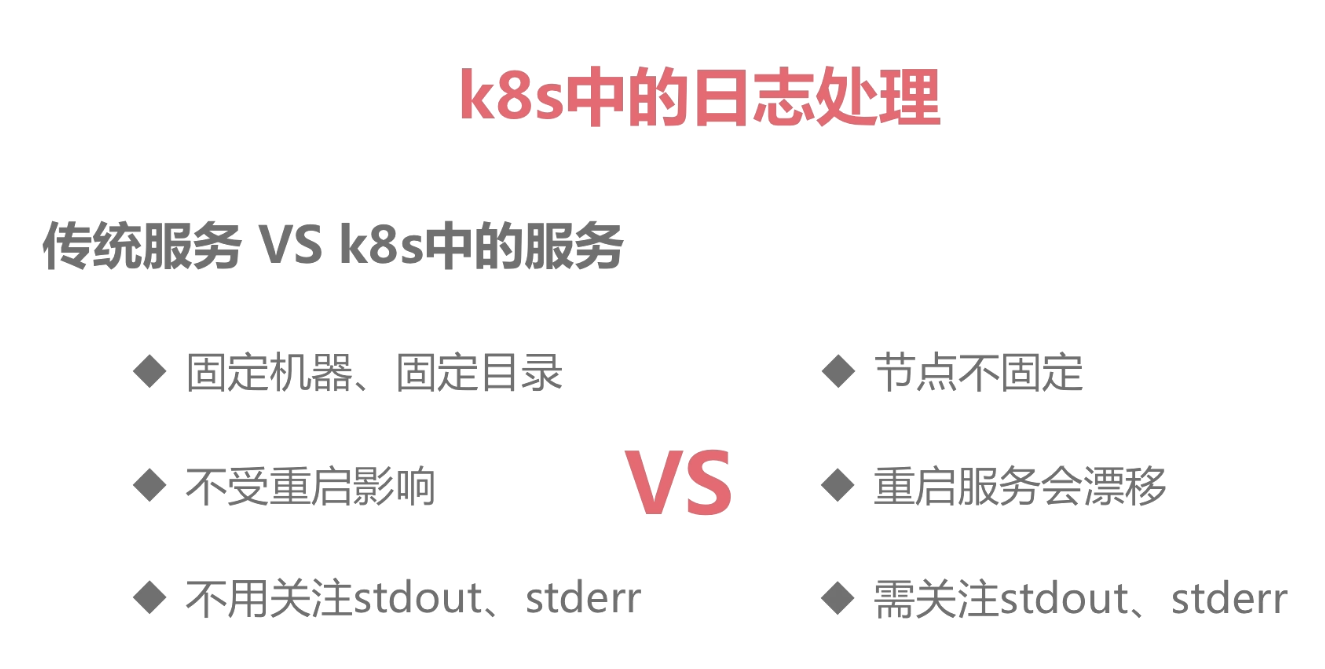

传统日志与kubernetes日志对比

- 传统服务

- 目录固定

- 重启不会丢失

- 不用关注标准与错误日志输出

- 容器服务

- 节点不固定

- 重启服务会漂移

- 需要关注标准与错误日志输出

- 日志文件重启会丢失

- 日志目录不固定

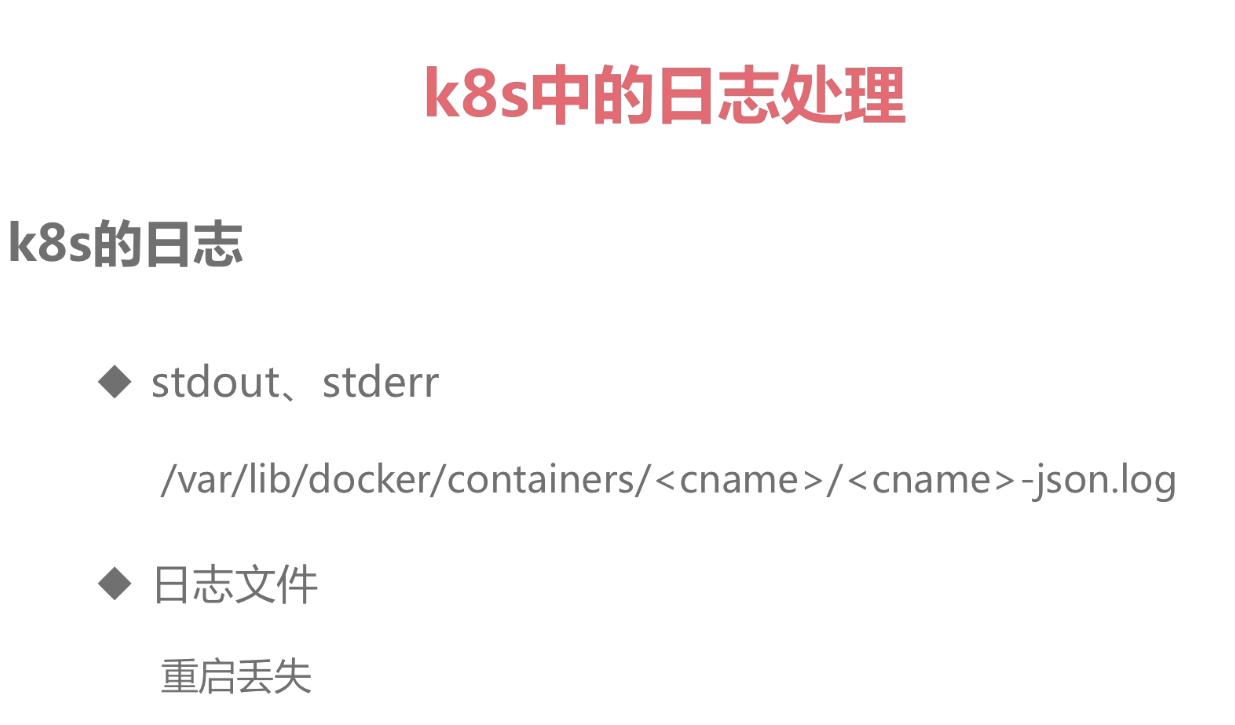

k8s中的日志处理

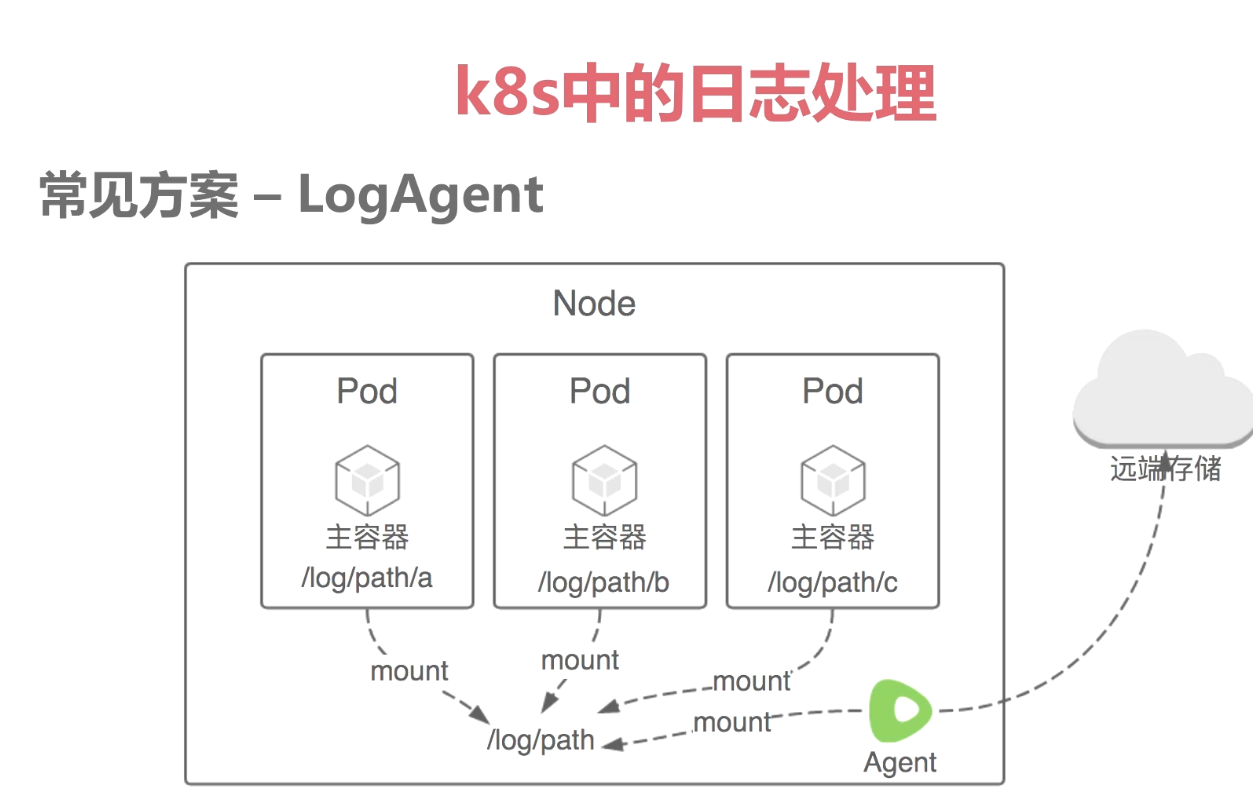

常见日志采集方案:

1.远程日志 将容器中日志直接写入远程kafka、es等,再由logstash等处理。劣势就是需要改造服务由写入本地的就要进行修改 传输到远端存储。

2.sidecar模式,在每个pod中运行一个filebeat,logstash等pod共享一个valume,由采集工具将日志内容采集发送。缺点每个pod都需要额外增加一个日志采集工具,对pod有侵入。

3.logagent模式,在node中运行一个filebeat,logstash等,通过将pod日志目录固定事先约定好,直接采集对应目录内容传输至远端。优点节约资源,对pod无侵入。缺点:文件后缀名尽量统一否则维护较为困难。目录预先定义好无法判断来源于哪个pod,只能区分node。

实践:

采用logagent模式

日志采集工具使用阿里开源logpilot(优点与docker主进程进行交互能够通过docker动态识别各个pod日志目录,底层采用filebeat)

常见日志采集工具 logpilot filebeat logstash Fluentd Logtail Flume(filebeat与flentd在容器环境中应用最多)缺点:都是采集监测静态目录。

搭建es:

---

apiVersion: v1

kind: Service

metadata:

name: elasticsearch-api

namespace: kube-system

labels:

name: elasticsearch

spec:

selector:

app: es

ports:

- name: transport

port: 9200

protocol: TCP

---

apiVersion: v1

kind: Service

metadata:

name: elasticsearch-discovery

namespace: kube-system

labels:

name: elasticsearch

spec:

selector:

app: es

ports:

- name: transport

port: 9300

protocol: TCP

---

apiVersion: apps/v1beta1

kind: StatefulSet

metadata:

name: elasticsearch

namespace: kube-system

labels:

kubernetes.io/cluster-service: "true"

spec:

replicas: 3

serviceName: "elasticsearch-service"

selector:

matchLabels:

app: es

template:

metadata:

labels:

app: es

spec:

tolerations:

- effect: NoSchedule

key: node-role.kubernetes.io/master

serviceAccountName: dashboard-admin

initContainers:

- name: init-sysctl

image: busybox:1.27

command:

- sysctl

- -w

- vm.max_map_count=262144

securityContext:

privileged: true

containers:

- name: elasticsearch

image: registry.cn-hangzhou.aliyuncs.com/imooc/elasticsearch:5.5.1

ports:

- containerPort: 9200

protocol: TCP

- containerPort: 9300

protocol: TCP

securityContext:

capabilities:

add:

- IPC_LOCK

- SYS_RESOURCE

resources:

limits:

memory: 4000Mi

requests:

cpu: 100m

memory: 2000Mi

env:

- name: "http.host"

value: "0.0.0.0"

- name: "network.host"

value: "_eth0_"

- name: "cluster.name"

value: "docker-cluster"

- name: "bootstrap.memory_lock"

value: "false"

- name: "discovery.zen.ping.unicast.hosts"

value: "elasticsearch-discovery"

- name: "discovery.zen.ping.unicast.hosts.resolve_timeout"

value: "10s"

- name: "discovery.zen.ping_timeout"

value: "6s"

- name: "discovery.zen.minimum_master_nodes"

value: "2"

- name: "discovery.zen.fd.ping_interval"

value: "2s"

- name: "discovery.zen.no_master_block"

value: "write"

- name: "gateway.expected_nodes"

value: "2"

- name: "gateway.expected_master_nodes"

value: "1"

- name: "transport.tcp.connect_timeout"

value: "60s"

- name: "ES_JAVA_OPTS"

value: "-Xms2g -Xmx2g"

livenessProbe:

tcpSocket:

port: transport

initialDelaySeconds: 20

periodSeconds: 10

volumeMounts:

- name: es-data

mountPath: /data

terminationGracePeriodSeconds: 30

volumes:

- name: es-data

hostPath:

path: /es-data

es.yaml

搭建logpilot:

---

apiVersion: extensions/v1beta1

kind: DaemonSet

metadata:

name: log-pilot

namespace: kube-system

labels:

k8s-app: log-pilot

kubernetes.io/cluster-service: "true"

spec:

template:

metadata:

labels:

k8s-app: log-es

kubernetes.io/cluster-service: "true"

version: v1.22

spec:

tolerations:

- key: node-role.kubernetes.io/master

effect: NoSchedule

serviceAccountName: dashboard-admin

containers:

- name: log-pilot

image: registry.cn-hangzhou.aliyuncs.com/imooc/log-pilot:0.9-filebeat

resources:

limits:

memory: 200Mi

requests:

cpu: 100m

memory: 200Mi

env:

- name: "FILEBEAT_OUTPUT"

value: "elasticsearch"

- name: "ELASTICSEARCH_HOST"

value: "elasticsearch-api"

- name: "ELASTICSEARCH_PORT"

value: "9200"

- name: "ELASTICSEARCH_USER"

value: "elastic"

- name: "ELASTICSEARCH_PASSWORD"

value: "changeme"

volumeMounts:

- name: sock

mountPath: /var/run/docker.sock

- name: root

mountPath: /host

readOnly: true

- name: varlib

mountPath: /var/lib/filebeat

- name: varlog

mountPath: /var/log/filebeat

securityContext:

capabilities:

add:

- SYS_ADMIN

terminationGracePeriodSeconds: 30

volumes:

- name: sock

hostPath:

path: /var/run/docker.sock

- name: root

hostPath:

path: /

- name: varlib

hostPath:

path: /var/lib/filebeat

type: DirectoryOrCreate

- name: varlog

hostPath:

path: /var/log/filebeat

type: DirectoryOrCreate

logpilot.yaml

搭建kibana:

---

apiVersion: v1

kind: Service

metadata:

name: kibana

namespace: kube-system

labels:

component: kibana

spec:

selector:

component: kibana

ports:

- name: http

port: 80

targetPort: http

---

#ingress

apiVersion: extensions/v1beta1

kind: Ingress

metadata:

name: kibana

namespace: kube-system

spec:

rules:

- host: kibana.mooc.com

http:

paths:

- path: /

backend:

serviceName: kibana

servicePort: 80

---

apiVersion: apps/v1beta1

kind: Deployment

metadata:

name: kibana

namespace: kube-system

labels:

component: kibana

spec:

replicas: 1

selector:

matchLabels:

component: kibana

template:

metadata:

labels:

component: kibana

spec:

containers:

- name: kibana

image: registry.cn-hangzhou.aliyuncs.com/imooc/kibana:5.5.1

env:

- name: CLUSTER_NAME

value: docker-cluster

- name: ELASTICSEARCH_URL

value: http://elasticsearch-api:9200/

resources:

limits:

cpu: 1000m

requests:

cpu: 100m

ports:

- containerPort: 5601

name: http

kibana.yaml

kubernetes常见日志采集问题和解决方案分析的更多相关文章

- 自建Kubernetes logtail日志采集客户端安装方式

自建Kubernetes安装方式 前提条件 Kubernetes集群版本1.8及以上. 已经安装Helm命令,版本2.6.4及以上. 安装步骤 在日志服务控制台创建一个Project,Project名 ...

- Kubernetes Ingress 日志分析与监控的最佳实践

摘要: Ingress主要提供HTTP层(7层)路由功能,是目前K8s中HTTP/HTTPS服务的主流暴露方式.为简化广大用户对于Ingress日志分析与监控的门槛,阿里云容器服务和日志服务将Ingr ...

- Kubernetes Ingress日志分析入门

本文主要介绍如何基于日志服务构建Kubernetes Ingress日志分析平台,并提供一些简单的动手实验方便大家快速了解日志服务相关功能. 部署Ingress日志方案 登录容器服务管理控制台. 将上 ...

- SpringCloud微服务实战——搭建企业级开发框架(三十八):搭建ELK日志采集与分析系统

一套好的日志分析系统可以详细记录系统的运行情况,方便我们定位分析系统性能瓶颈.查找定位系统问题.上一篇说明了日志的多种业务场景以及日志记录的实现方式,那么日志记录下来,相关人员就需要对日志数据进行 ...

- 使用日志服务进行Kubernetes日志采集

阿里云容器服务Kubernetes集群集成了日志服务(SLS),您可在创建集群时启用日志服务,快速采集Kubernetes 集群的容器日志,包括容器的标准输出以及容器内的文本文件. 新建 Kubern ...

- Kubernetes日志采集

Kubernetes日志打印方式 标准输出 docker标准输出日志stdout和stderr,使用docker logs或者kubectl logs查看最新的日志(tail). 如果想看到更多的日志 ...

- 日志采集技术分析 Inode Inotify

日志采集技术分析[阿里] - 新手学习导向 - 中国红客联盟 - Powered by HUC http://www.cnhonkerarmy.com/thread-236973-1-1.html

- 「视频小课堂」ELK和Kafka是怎么就玩在一起成了日志采集解决方案文字版

视频地址:ELK和Kafka是怎么就玩在一起成了日志采集解决方案 视频文字版 今天呢我就带来了一期视频,主要就是讲ELK和Kafka之间的通讯关系通过对一张通讯图,和一些操作命令,让我们能更深入的去理 ...

- Kubernetes 常用日志收集方案

Kubernetes 常用日志收集方案 学习了 Kubernetes 集群中监控系统的搭建,除了对集群的监控报警之外,还有一项运维工作是非常重要的,那就是日志的收集. 介绍 应用程序和系统日志可以帮助 ...

随机推荐

- 浏览器+css基础+选择器+权重+匹配规则

浏览器的组成: shell+内核 shell:用户能看得到的界面就叫shell 内核:渲染rendering引擎和js引擎 现在主流拥有自己开发内核的浏览器:opera现在属于360和昆仑万维 CSS ...

- Centos 7 设置 SFTP

近期要给服务器设置一个SFTP用户,可以上传删除修改的SFTP,但是禁止该用户SSH登录.这里记录下来 先升级 来源: https://blog.csdn.net/fenglailea/article ...

- 鸿蒙内核源码分析(汇编传参篇) | 如何传递复杂的参数 | 百篇博客分析OpenHarmony源码 | v23.02

百篇博客系列篇.本篇为: v23.xx 鸿蒙内核源码分析(汇编传参篇) | 如何传递复杂的参数 | 51.c.h .o 硬件架构相关篇为: v22.xx 鸿蒙内核源码分析(汇编基础篇) | CPU在哪 ...

- P6222-「P6156 简单题」加强版【莫比乌斯反演】

正题 题目链接:https://www.luogu.com.cn/problem/P6222 题目大意 给出\(k\),\(T\)组询问给出\(n\)求 \[\sum_{i=1}^n\sum_{j=1 ...

- JavaFx全局快捷键实现(Kotlin)

原文地址: JavaFx全局快捷键实现(Kotlin) | Stars-One的杂货小窝 最近整款工具需要用到全局快捷键,搜集了下网上的资料,发现有个JIntellitype库可以用来实现全局快捷键, ...

- 在昨天夜黑风高的晚上,我偷了隔壁老王的Python入门课件,由浅入深堪称完美!

隔壁老王是一个资深码农,就业教育事业的秃顶之才昨天我下楼打酱油,看他迎面走来,满目春光我好奇的问道:老王,有什么好事,隔壁小花叫你上门了吗?老王:秘密!!我心想:哎呦~不错啊半晚之时,连猫狗都睡着了, ...

- 极简SpringBoot指南-Chapter03-基于SpringBoot的Web服务

仓库地址 w4ngzhen/springboot-simple-guide: This is a project that guides SpringBoot users to get started ...

- 痞子衡嵌入式:i.MXRT全系列下FlexSPI外设AHB Master ID定义与AHB RX Buffer指定的异同

大家好,我是痞子衡,是正经搞技术的痞子.今天痞子衡给大家介绍的是i.MXRT全系列下FlexSPI外设AHB Master ID定义与AHB RX Buffer指定的异同. 因为 i.MXRT 全系列 ...

- c++ fstream feekg讨论

#include <iostream> #include <fstream> using namespace std; int main() { std::ifstream f ...

- js 判断两个对象是否相等

最近碰到的一个面试题,不算高频,记录一下 判断两个对象是否相等,大致分为三步 首先判断两个比较对象是不是 Object 如果都是对象 再比较 对象的长度是否相等 如果两个对象的长度相等 再比较对象属性 ...