MapReduce原理深入理解(一)

1.MapReduce概念

1)MapReduce是一种分布式计算模型,由Google提出,主要用于搜索领域,解决海量数据的计算问题.

2)MapReduce是分布式运行的,由两个阶段组成:Map和Reduce,Map阶段是一个独立的程序,有很多个节点同时运行,每个节点处理一部分数据。Reduce阶段是一个独立的程序,有很多个节点同时运行,每个节点处理一部分数据【在这先把reduce理解为一个单独的聚合程序即可】。

3)MapReduce框架都有默认实现,用户只需要覆盖map()和reduce()两个函数,即可实现分布式计算,非常简单。

4)两个函数的形参和返回值都是<key、value>,使用的时候一定要注意构造<k,v>。

2.MapReduce核心思想

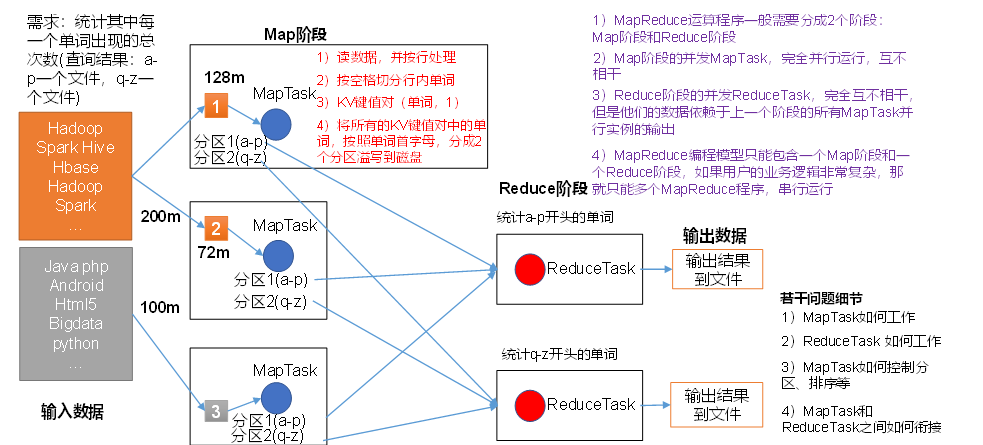

(1)分布式的运算程序往往需要分成至少2个阶段。

(2)第一个阶段的MapTask并发实例,完全并行运行,互不相干。

(3)第二个阶段的ReduceTask并发实例互不相干,但是他们的数据依赖于上一个阶段的所有MapTask并发实例的输出。

(4)MapReduce编程模型只能包含一个Map阶段和一个Reduce阶段,如果用户的业务逻辑非常复杂,那就只能多个MapReduce程序,串行运行。

总结:分析WordCount数据流走向深入理解MapReduce核心思想。

3. MapReduce 中的shuffle

4.Mapreduce代码

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.Mapper;

import org.apache.hadoop.mapreduce.Reducer;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat; import java.io.IOException; public class WordCount {

//分割任务

// 第一对kv,是决定数据输入的格式

// 第二队kv 是决定数据输出的格式

public static class MyMapper extends Mapper<LongWritable, Text, Text, LongWritable> {

/*map阶段数据是一行一行过来的

每一行数据都需要执行代码*/

@Override

protected void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

LongWritable longWritable = new LongWritable(1);

String s = value.toString();

context.write(new Text(s), longWritable);

}

}

//接收Map端数据

public static class MyReducer extends Reducer<Text, LongWritable, Text, LongWritable> {

/* reduce 聚合程序 每一个k都会调用一次

* 默认是一个节点

* key:每一个单词

* values:map端 当前k所对应的所有的v

*/

@Override

protected void reduce(Text key, Iterable<LongWritable> values, Context context) throws IOException, InterruptedException {

//设置统计的初始值为0

long sum = 0l;

for (LongWritable value : values) {

sum += value.get();

}

context.write(key, new LongWritable(sum));

}

} /**

* 是当前mapreduce程序入口

* 用来构建mapreduce程序

*/

public static void main(String[] args) throws IOException, ClassNotFoundException, InterruptedException {

//创建一个job任务

Job job=Job.getInstance();

//指定job名称

job.setJobName("第一个mr程序");

//构建mr

//指定当前main所在类名(识别具体的类)

job.setJarByClass(WordCount.class);

//指定map端类

// 指定map输出的kv类型

job.setMapperClass(MyMapper.class);

job.setMapOutputKeyClass(Text.class);

job.setMapOutputValueClass(LongWritable.class);

//指定reduce端类

//指定reduce端输出的kv类型

job.setReducerClass(MyReducer.class);

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(LongWritable.class); // 指定输入路径

Path in = new Path("/word");

FileInputFormat.addInputPath(job,in);

//输出路径指定

Path out = new Path("/output");

FileSystem fs = FileSystem.get(new Configuration());

//如果文件存在

if(fs.exists(out)){

fs.delete(out,true);

}

//存在

FileOutputFormat.setOutputPath(job,out); //启动

job.waitForCompletion(true);

System.out.println("MapReduce正在执行");

}

}

MapReduce原理深入理解(一)的更多相关文章

- MapReduce原理深入理解(二)

1.Mapreduce操作不需要reduce阶段 1 import org.apache.hadoop.conf.Configuration; 2 import org.apache.hadoop.f ...

- 大数据运算模型 MapReduce 原理

大数据运算模型 MapReduce 原理 2016-01-24 杜亦舒 MapReduce 是一个大数据集合的并行运算模型,由google提出,现在流行的hadoop中也使用了MapReduce作为计 ...

- MapReduce原理及其主要实现平台分析

原文:http://www.infotech.ac.cn/article/2012/1003-3513-28-2-60.html MapReduce原理及其主要实现平台分析 亢丽芸, 王效岳, 白如江 ...

- MapReduce 原理与 Python 实践

MapReduce 原理与 Python 实践 1. MapReduce 原理 以下是个人在MongoDB和Redis实际应用中总结的Map-Reduce的理解 Hadoop 的 MapReduce ...

- hadoop自带例子SecondarySort源码分析MapReduce原理

这里分析MapReduce原理并没用WordCount,目前没用过hadoop也没接触过大数据,感觉,只是感觉,在项目中,如果真的用到了MapReduce那待排序的肯定会更加实用. 先贴上源码 pac ...

- 04 MapReduce原理介绍

大数据实战(上) # MapReduce原理介绍 大纲: * Mapreduce介绍 * MapReduce2运行原理 * shuffle及排序 定义 * Mapreduce 最早是由googl ...

- Atitit 泛型原理与理解attilax总结

Atitit 泛型原理与理解attilax总结 1. 泛型历史11.1.1. 由来11.2. 为什么需要泛型,类型安全21.3. 7.泛型的好处22. 泛型的机制编辑22.1.1. 机制32.1.2. ...

- Hapoop原理及MapReduce原理分析

Hapoop原理 Hadoop是一个开源的可运行于大规模集群上的分布式并行编程框架,其最核心的设计包括:MapReduce和HDFS.基于 Hadoop,你可以轻松地编写可处理海量数据的分布式并行程序 ...

- Hadoop学习记录(4)|MapReduce原理|API操作使用

MapReduce概念 MapReduce是一种分布式计算模型,由谷歌提出,主要用于搜索领域,解决海量数据计算问题. MR由两个阶段组成:Map和Reduce,用户只需要实现map()和reduce( ...

随机推荐

- 一次关于shiro反序列化漏洞的思考

0x01前言 之前在我反序列化的那篇文章中(https://www.cnblogs.com/lcxblogs/p/13539535.html),简单说了一下反序列化漏洞,也提了一嘴常见的几种Java框 ...

- xv6学习笔记(4) : 进程调度

xv6学习笔记(4) : 进程 xv6所有程序都是单进程.单线程程序.要明白这个概念才好继续往下看 1. XV6中进程相关的数据结构 在XV6中,与进程有关的数据结构如下 // Per-process ...

- 软件开发目录规范 ATM框架构建

软件开发的目录规范 建立文件夹 为了提高程序的可读性与可维护性,我们应该为软件设计良好的目录结构,这与规范的编码风格同等重要.软件的目录规范并无硬性标准,只要清晰可读即可 以ATM购物车项目为例: 首 ...

- 熟悉而陌生的新朋友——IAsyncDisposable

本文作者--句幽 在.NET Core 3.0的版本更新中,官方我们带来了一个新的接口 IAsyncDisposable. 小伙伴一看肯定就知道,它和.NET中原有的IDisposable接口肯定有着 ...

- javascript - 将字符串转换为模板字符串

参考: https://www.itranslater.com/qa/details/2325714161562551296 是否可以将模板字符串创建为常用字符串 let a="b:${b} ...

- MySQL临时表与内存表

在MySQL中有三种虚拟表:临时表.内存表.视图.下面简单介绍一下临时表和内存表的使用. 1.临时表 MySQL临时表在我们需要保存一些临时数据时是非常有用的.临时表在MySQL 3.23版本中添加. ...

- Spring Boot Mybatis注解:@Mapper和@MapperScan

使用@Mapper注解 添加了@Mapper注解之后这个接口在编译时会生成相应的实现类,让其他的类进行引用 @Mapper public interface EmpMapper { public Li ...

- C#多线程---Monitor实现线程同步

一.简介 Monitor.Enter和Monitor.Exit方法来实现线程同步,这个属于排他锁,即每次只有一个线程可以访问共享数据. C#中通过lock关键字来提供简化的语法,lock可以理解为Mo ...

- [SWMM]弗汝德数

弗汝德数(Froude number)是流体内惯性力与重力的比值.弗汝德数(Fr)是水力学中重要的无量纲数之一,它表示过水断面上单位重量液体具有的平均动能与平均势能的比值,它也表示水流惯性力与重力的比 ...

- jwt《token》

payload与claims只能存在一个这部分是jwt源码:依赖如下:官方文档的依赖 <dependency> <groupId>io.jsonwebtoken</gro ...