Python爬取网页信息

Python爬取网页信息的步骤

以爬取英文名字网站(https://nameberry.com/)中每个名字的评论内容,包括英文名,用户名,评论的时间和评论的内容为例。

1、确认网址

在浏览器中输入初始网址,逐层查找链接,直到找到需要获取的内容。

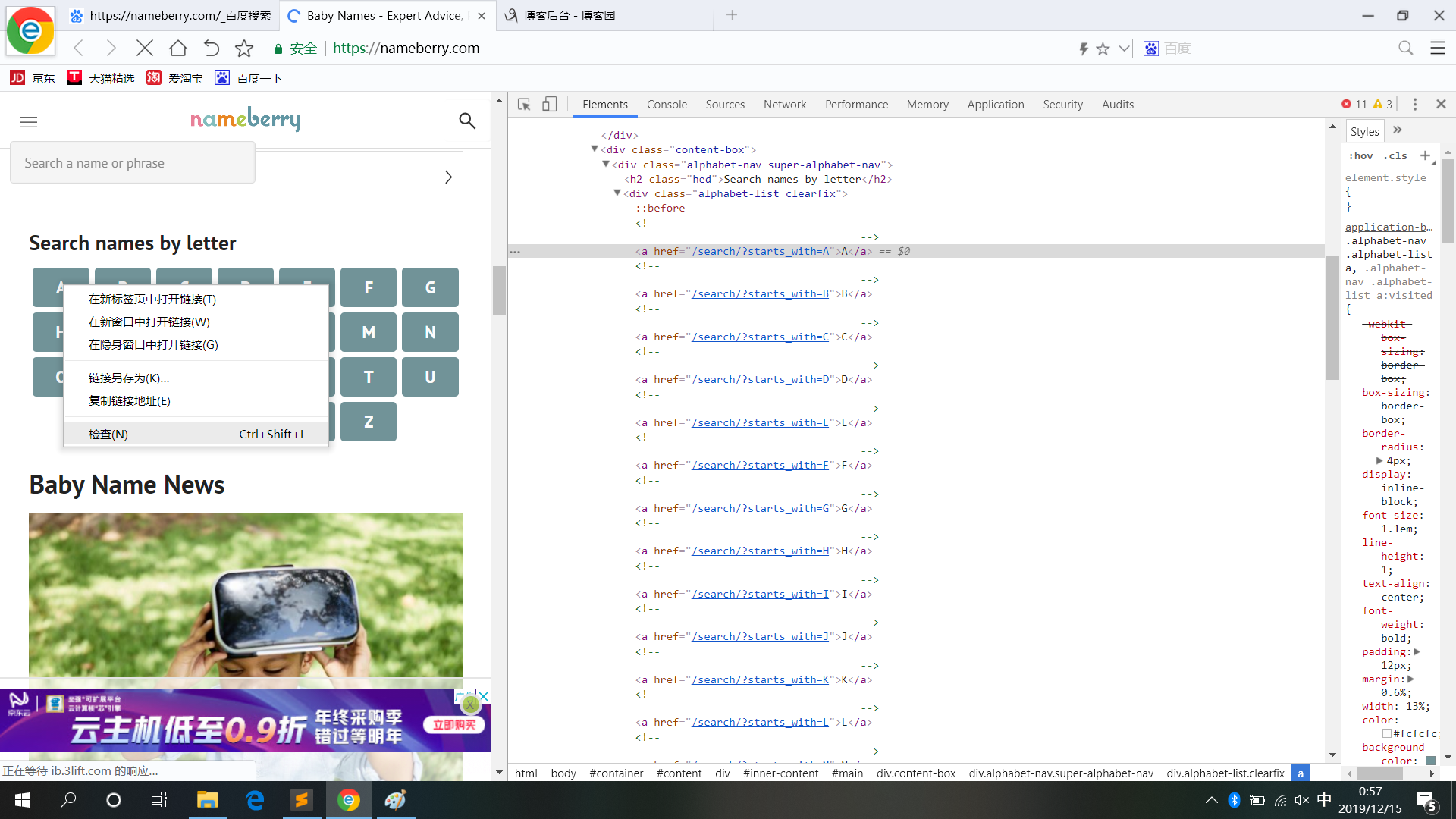

在打开的界面中,点击鼠标右键,在弹出的对话框中,选择“检查”,则在界面会显示该网页的源代码,在具体内容处点击查找,可以定位到需要查找的内容的源码。

注意:代码显示的方式与浏览器有关,有些浏览器不支持显示源代码功能(360浏览器,谷歌浏览器,火狐浏览器等是支持显示源代码功能)

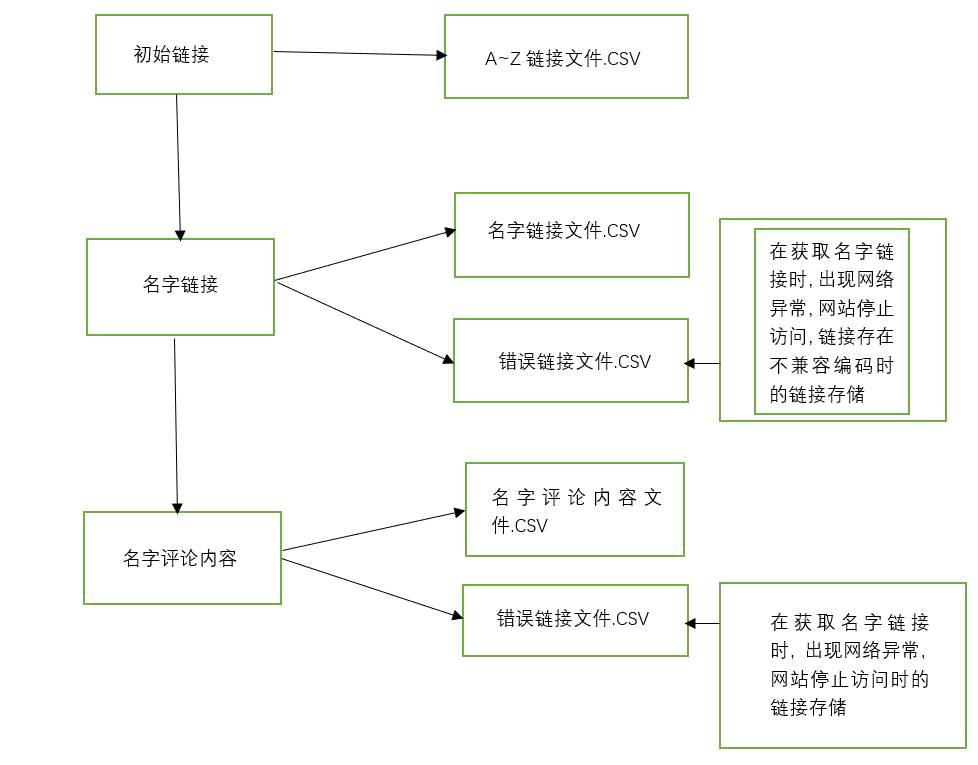

步骤图:

1)首页,获取A~Z的页面链接

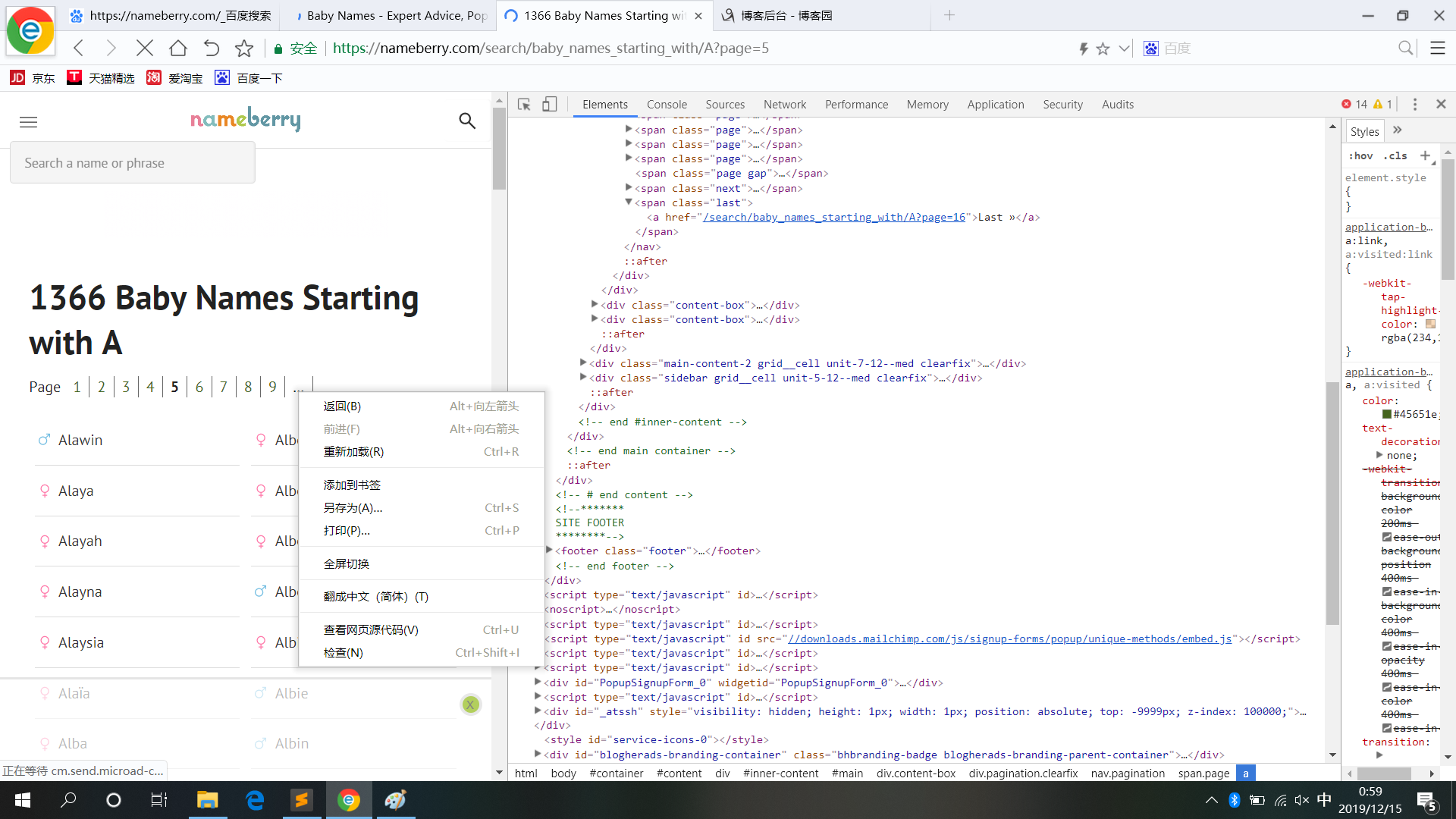

2)名字链接页,获取每个字母中的名字链接(存在翻页情况)

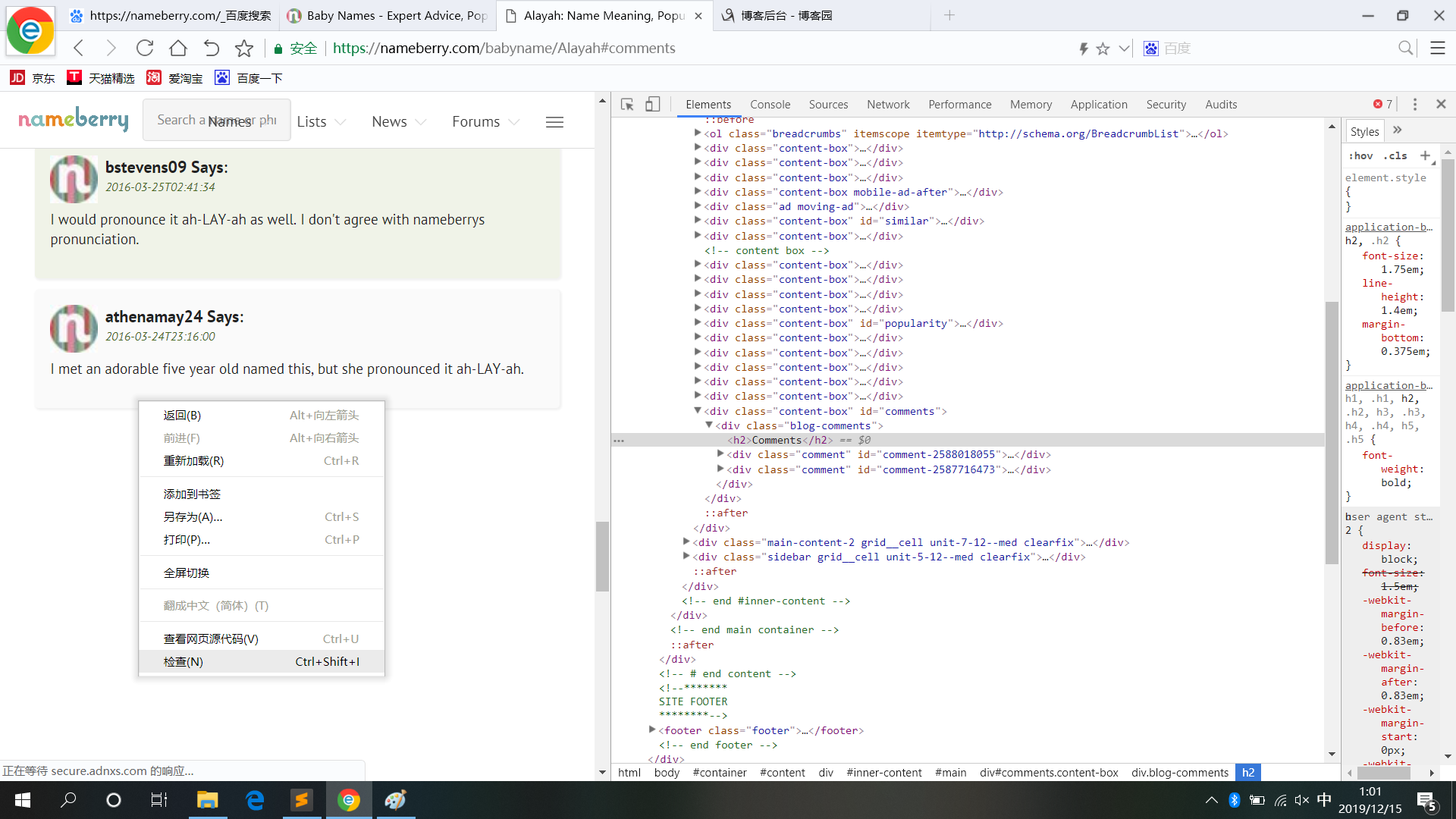

3)名字内容页,获取每个名字的评论信息

2、编写测试代码

1)获取A~Z链接,在爬取网页信息时,为了减少网页的响应时间,可以根据已知的信息,自动生成对应的链接,这里采取自动生成A~Z之间的连接,以pandas的二维数组形式存储

def get_url1():

urls=[]

# A,'B','C','D','E','F','G','H','I','J','K','L','M','N','O','P','Q','R','S','T','U','V','W','X','Y','Z'

a=['A','B','C','D','E','F','G','H','I','J','K','L','M','N','O','P','Q','R','S','T','U','V','W','X','Y','Z']

#自动生成A~Z的链接

for i in a:

urls.append("https://nameberry.com/search/baby_names_starting_with/%s" %i)

dp=pd.DataFrame(urls)

dp.to_csv("A~Z_Link1.csv",mode="a",encoding='utf_8_sig')

#循环用于在每个字母链接下,调用爬取名字链接的页面的函数,即函数嵌套

for j in urls:

get_pages_Html(j)

return urls

2)获取名字链接,根据网页源码分析出包含名字链接的标签,编写代码,名字链接用直接存储的方式存储,方便读取名字链接进行对名字的评论内容的获取

#获取页数

def get_pages_Html(url1):

req = requests.get(url1)

soup=BeautifulSoup(req.text)

#异常处理,为解决页面不存在多页的问题,使用re正则表达式获取页面数

try:

lastpage = soup.find(class_="last").find("a")['href']

str1='{}'.format(lastpage)

b=re.findall('\\d+', str1 )

for page in b:

num=page

except:

num=1

get_pages(num,url1)

return num def get_pages(n,url):

pages=[]

for k in range(1,int(n)+1):

pages.append("{}?page={}".format(url,k))

dp=pd.DataFrame(pages)

dp.to_csv("NUM_pages_1.csv",mode="a",encoding='utf_8_sig')

#函数调用

for l in pages:

parse_HTML2(l)

return pages # 名字的链接,根据网页源码的标签,确定名字链接的位置

def parse_HTML2(url2):

try:

req = requests.get(url2)

req.encoding = req.apparent_encoding

soup = BeautifulSoup(req.text)

except:

dp=pd.DataFrame(url2)

dp.to_csv("Error_pages_1.csv",mode="a",encoding='utf_8_sig')

name_data_l=[]

error=[]

li_list = soup.find_all('li',class_="Listing-name pt-15 pb-15 bdb-gray-light w-100pct flex border-highlight")

try:

for li in li_list:

nameList=li.find('a',class_='flex-1')['href']

name_data_l.append('https://nameberry.com/'+nameList)

time.sleep(1)

cun(name_data_l,'Name_List_1')

except:

dp=pd.DataFrame(name_data_l)

dp.to_csv("Error_Name_List_1.csv",mode="a",encoding='utf_8_sig')

# cun(url2,'Error_link_Q')

# dp=pd.DataFrame(name_data_l)

# dp.to_csv("Name_List.csv",mode="a",encoding='utf_8_sig')

# for i in name_data_l:

# parse_HTML3(i)

return name_data_l

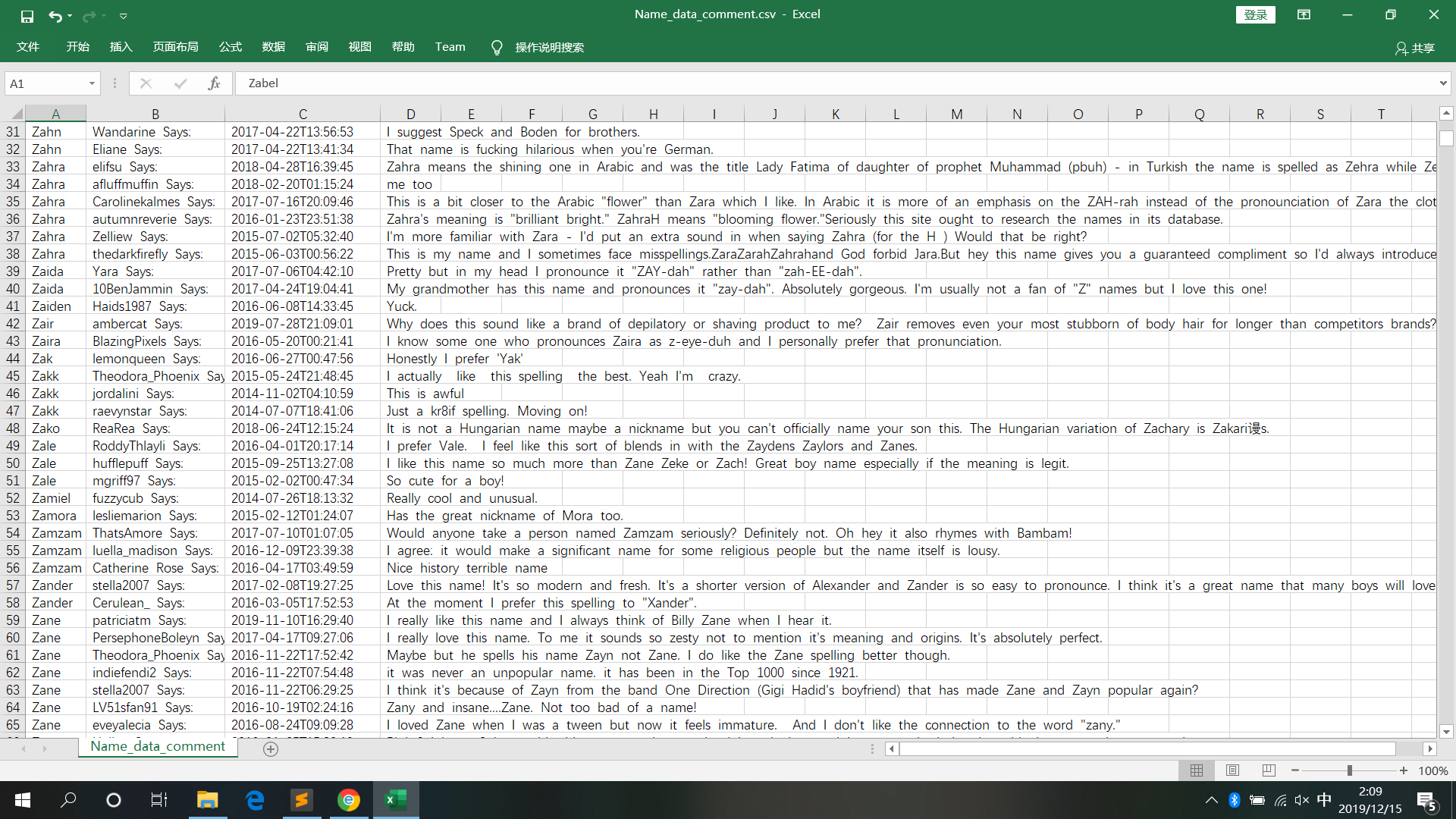

3)获取名字评论的内容,采用字典形式写入文件

# 名字里的内容

def parse_HTML3(url3):

count=0

req = requests.get(url3)

req.encoding = req.apparent_encoding

soup = BeautifulSoup(req.text)

error=[]

try:

Name=soup.find('h1',class_='first-header').find("a").get_text().replace(",","").replace("\n","")

except:

error.append(url3)

cun(error,"Error_Link_Comment")

li_list = soup.find_all('div',class_="comment")

for li in li_list:

Title=li.find("h4").get_text().replace(",","").replace("\n","")

Time=li.find("p",class_='meta').get_text().replace(",","").replace("\n","")

Comments=li.find("div",class_='comment-text').get_text().replace(",","").replace("\n","")

dic2={

"Name":Name,

"Title":Title,

"Time":Time,

"Comments":Comments

}

time.sleep(1)

count=count+1

save_to_csv(dic2,"Name_data_comment")

print(count)

return 1

3、测试代码

1)代码编写完成后,具体的函数调用逻辑,获取链接时,为直接的函数嵌套,获取内容时,为从文件中读取出名字链接,在获取名字的评论内容。避免因为逐层访问,造成访问网页超时,出现异常。

如图:

2)测试结果

4、小结

在爬取网页内容时,要先分析网页源码,再进行编码和调试,遵从爬虫协议(严重者会被封号),在爬取的数据量非常大时,可以设置顺序部分请求(一部分的进行爬取网页内容)。

总之,爬虫有风险,测试需谨慎!!!

Python爬取网页信息的更多相关文章

- [python] 常用正则表达式爬取网页信息及分析HTML标签总结【转】

[python] 常用正则表达式爬取网页信息及分析HTML标签总结 转http://blog.csdn.net/Eastmount/article/details/51082253 标签: pytho ...

- 常用正则表达式爬取网页信息及HTML分析总结

Python爬取网页信息时,经常使用的正则表达式及方法. 1.获取<tr></tr>标签之间内容 2.获取<a href..></a>超链接之间内容 3 ...

- python学习之——爬取网页信息

爬取网页信息 说明:正则表达式有待学习,之后完善此功能 #encoding=utf-8 import urllib import re import os #获取网络数据到指定文件 def getHt ...

- python爬取网页的通用代码框架

python爬取网页的通用代码框架: def getHTMLText(url):#参数code缺省值为‘utf-8’(编码方式) try: r=requests.get(url,timeout=30) ...

- Python爬取招聘信息,并且存储到MySQL数据库中

前面一篇文章主要讲述,如何通过Python爬取招聘信息,且爬取的日期为前一天的,同时将爬取的内容保存到数据库中:这篇文章主要讲述如何将python文件压缩成exe可执行文件,供后面的操作. 这系列文章 ...

- 如何使用python爬取网页动态数据

我们在使用python爬取网页数据的时候,会遇到页面的数据是通过js脚本动态加载的情况,这时候我们就得模拟接口请求信息,根据接口返回结果来获取我们想要的数据. 以某电影网站为例:我们要获取到电影名称以 ...

- python爬取网页文本、图片

从网页爬取文本信息: eg:从http://computer.swu.edu.cn/s/computer/kxyj2xsky/中爬取讲座信息(讲座时间和讲座名称) 注:如果要爬取的内容是多页的话,网址 ...

- python爬取酒店信息练习

爬取酒店信息,首先知道要用到那些库.本次使用request库区获取网页,使用bs4来解析网页,使用selenium来进行模拟浏览. 本次要爬取的美团网的蚌埠酒店信息及其评价.爬取的网址为“http:/ ...

- python 嵌套爬取网页信息

当需要的信息要经过两个链接才能打开的时候,就需要用到嵌套爬取. 比如要爬取起点中文网排行榜的小说简介,找到榜单网址:https://www.qidian.com/all?orderId=&st ...

随机推荐

- 【LeetCode】最接近的三数之和【排序,固定k1,二分寻找k2和k3】

给定一个包括 n 个整数的数组 nums 和 一个目标值 target.找出 nums 中的三个整数,使得它们的和与 target 最接近.返回这三个数的和.假定每组输入只存在唯一答案. 例如,给定数 ...

- Java/C++ 学习资源推荐

列举一下我所知道的一些学习资源,希望能对大家有所帮助 Java学习资源资源: 1.尚学堂 Java300集 链接:https://study.163.com/course/introduction.h ...

- Jackson 动态Bean

为了解决json字符串有很多属性, 但是不必每个属性都映射到pojo的属性. @JsonProperty : 标记一个方法是一个属性的getter或setter方法, 也即把java属性和json域关 ...

- Linux中buff/cache内存占用过高解决办法

在Linux系统中,我们经常用free命令来查看系统内存的使用状态.在一个centos7的系统上,free命令的显示内容大概是这样一个状态: 这个命令几乎是每一个使用过Linux的人必会的命令,但越是 ...

- isset和empty,isset和unset,__isset和__unset

1.isset() 用来检测变量是否存在,如果变量存在,且值不等于零,返回ture empty() 用来检测是否为空,如果变量值值为"".0."0".NULL. ...

- day38——线程queue、事件event、协程

day38 线程queue 多线程抢占资源 只能让其串行--用到互斥锁 线程queue 队列--先进先出(FIFO) import queue q = queue.Queue(3) q.put(1) ...

- AS3中 is,as,typeof的区别

AS3中 is,as,typeof的区别 . var my_num:Number=9;trace(typeof my_num);var my_object:Array=["语文", ...

- IIS配置文件的XML格式不正确 applicationHost.config崩溃

错误提示如图: 检查C:\Windows\System32\inetsrv\config目录下的applicationHost.config文件,备份一份. 可使用IIS提供的AppCmd.exe的r ...

- Java调用WebService方法总结(6)--XFire调用WebService

XFire是codeHaus组织提供的一个WebService开源框架,目前已被Apache的CXF所取代,已很少有人用了,这里简单记录下其调用WebService使用方法.官网现已不提供下载,可以到 ...

- iOS 播放系统自带铃声

播放声音代码例子 https://github.com/baitongtong/git-.git 给一个国外网址,苹果系统铃声以及自定义铃声免登陆免费下载:http://www.zedge.net/r ...