各种卷积类型Convolution

从最开始的卷积层,发展至今,卷积已不再是当初的卷积,而是一个研究方向。在反卷积这篇博客中,介绍了一些常见的卷积的关系,本篇博客就是要梳理这些有趣的卷积结构。

阅读本篇博客之前,建议将这篇博客结合在一起阅读,想必会有更深的理解。另外,不管是什么类型的卷积,我们都把它理解成一种运算操作。

- Group convolution

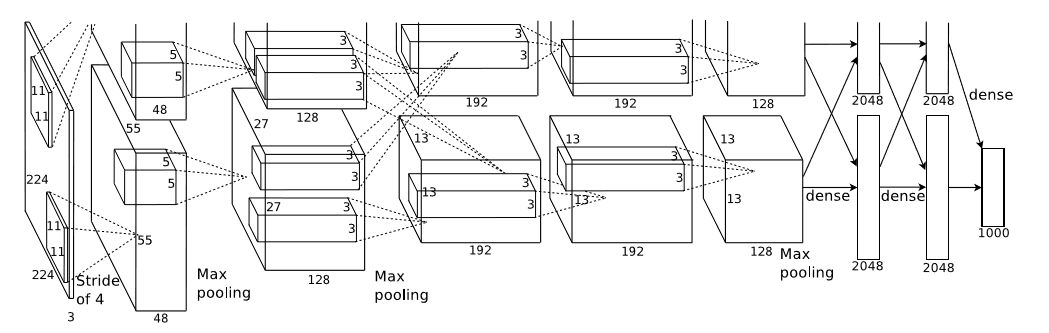

Group convolution是最早应用在2012年Alexnet的双GPU架构模型中,相当于把channel这一维度均分到两个GPU,进行分组卷积。如图所示:

这篇论文是:ImageNet Classification with Deep Convolutional Neural Networks。由图可见,上下两个并行的网络结构只有在部分层中才有信息交互,而且网络结构一模一样,这就是Group convolution最早的应用,但是在caffe中经常使用的单机多GPU并行训练和上述问题存在本质区别,因为Group convolution是指将channel维度细分成多个group,然后再分组进行Convolution,而多GPU的训练只是一个数据并行分组的方式,其中minibatch和batch之间的关系就是batch=minibatch*GPU_num,这并不存在对channel的分组。

总之,Group convolution是一种卷积操作,想要切分channel,然后分组卷积,运算上没有什么特别的地方。

2.Pointwise convolution

点积,就是卷积核大小是1*1的,那为啥起名点积呢?就是因为这和向量中的点积运算很类似,举个例子,一张3通道的feature map,卷积核大小是1*1*3,那它的运算其实就是:Σ卷积核*单通道feature map。

总之,Pointwise convolution是一种卷积操作,而且是一种特殊的卷积运算,代表着卷积核的大小是1*1。

3.Separable convolution

可分离卷积,这种思路其实就是起了个高深的名字,也很常见。也是想在channel维度上改变经典的卷积运算,咋办呢?经典的卷积核都是k*k*channel大小的,其中channel是上一层的输出即本层的输入,这不太好,我们想任意指定一个channel,作为卷积核的大小,这样并不影响输入输出的特征图的长宽尺寸,仅仅改变了channel这一维度。这就变得很有意思了,同Group convolution不一样的是,可分离卷积可增加channel维度,而并没有依赖GPU。

举个例子,对于经典的卷积运算,如果说所需的参数量为256*3*3*256=589824。而对于可分离卷积,假设我们指定的卷积核是3*3*4,那首先是256*3*3*4=9216,接下来我们得到了4*256=1024个通道数,但是呢?这并没有完成,因为还需要下一个过程将channel重新压缩回256,接着有1024*1*1*256=262144,整个过程就是9216+262144=271360,看看,589824是271360的两倍多。虽然,这在很多框架上也许未能比较出效果的显著差异,那是多方面的原因。

值得一提的是,上面举的例子可以认为是Separable convolution 和Pointwise convolution结合在一起,事实上就是配套使用的。

最早的Separable convolution来源于论文:Simplifying ConvNets for Fast Learning,作者用的是k*1和1*k的卷积核,起名为可分离卷积,而本处的可分离卷积来源于另一篇论文:Xception: Deep Learning with Depthwise Separable Convolutions。

总之,Separable convolution是一种卷积操作,而且是一种特殊的卷积运算,代表着卷积核的channel维度可以自己任意选取。

4.Depthwise convolution

深度卷积,这名字又开始很高深了,其实它的意思就是拓展Separable convolution而来,我们可以让卷积核的channel维度等于1啊,这样就是深度卷积,意为在每一个channel上做卷积。值得注意的是,往往Separable convolution和Depthwise convolution是统称为Depthwise convolution。假设卷积核的shape是[filter_height, filter_width, in_channels, channel_multiplier],区别仅在于channel_multiplier,由于参考同一篇论文,此处将其统一。

这样说来,前面的例子中其实就是Depthwise separable convolution = Depthwise convolution + Pointwise convolution,这就是深度可分离卷积的真正内涵。这也就是以下论文的工作:Xception: Deep Learning with Depthwise Separable Convolutions

总之,Depthwise convolution是一种卷积操作,和Separable convolution一样,表示对channel维度进行卷积的一种方式。

5.Dilated convolution

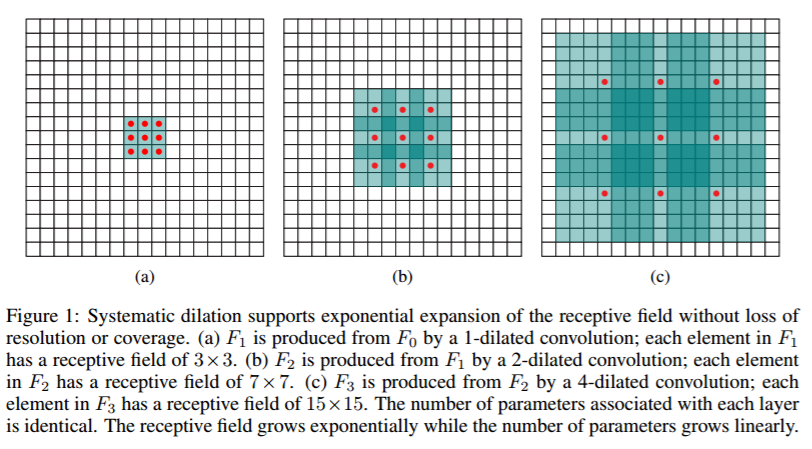

空洞卷积是解决pixel-wise输出模型的一种常用的卷积方式。一种普遍的认识是,pooling下采样操作导致的信息丢失是不可逆的,通常的分类识别模型,只需要预测每一类的概率,所以我们不需要考虑pooling会导致损失图像细节信息的问题,但是做像素级的预测时(譬如语义分割),就要考虑到这个问题了。那么空洞卷积可以用下图来说明:

也就是以下论文:Multi-scale context aggregation by dilated convolutions

总之,空洞卷积是卷积运算的一种方式,在于增大了感受野却不丢失语义信息。

各种卷积类型Convolution的更多相关文章

- 从图(Graph)到图卷积(Graph Convolution):漫谈图神经网络模型 (二)

本文属于图神经网络的系列文章,文章目录如下: 从图(Graph)到图卷积(Graph Convolution):漫谈图神经网络模型 (一) 从图(Graph)到图卷积(Graph Convolutio ...

- 从图(Graph)到图卷积(Graph Convolution):漫谈图神经网络模型 (一)

本文属于图神经网络的系列文章,文章目录如下: 从图(Graph)到图卷积(Graph Convolution):漫谈图神经网络模型 (一) 从图(Graph)到图卷积(Graph Convolutio ...

- 卷积(convolution)与相关(correlation)(matlab 实现)

1. 卷积(convolution) 输出 y(n) 是作为在 x(k) 和 h(n−k)(反转和移位)重叠之下的样本和求出的. 考虑下面两个序列: x(n)=[3,11,7,0,−1,4,2],−3 ...

- 从图(Graph)到图卷积(Graph Convolution):漫谈图神经网络模型 (三)

本文属于图神经网络的系列文章,文章目录如下: 从图(Graph)到图卷积(Graph Convolution):漫谈图神经网络模型 (一) 从图(Graph)到图卷积(Graph Convolutio ...

- 转置卷积Transposed Convolution

转置卷积Transposed Convolution 我们为卷积神经网络引入的层,包括卷积层和池层,通常会减小输入的宽度和高度,或者保持不变.然而,语义分割和生成对抗网络等应用程序需要预测每个像素的值 ...

- 信号处理——卷积(convolution)的实现

作者:桂. 时间:2017-03-07 22:33:37 链接:http://www.cnblogs.com/xingshansi/p/6517301.html 前言 信号时域.频域对应关系,及其D ...

- [翻译] 扩张卷积 (Dilated Convolution)

英文原文: Dilated Convolution 简单来说,扩张卷积只是运用卷积到一个指定间隔的输入.按照这个定义,给定我们的输入是一个2维图片,扩张率 k=1 是通常的卷积,k=2 的意思是每个输 ...

- 空洞卷积(dilated Convolution) 与感受野(Receptive Field)

一.空洞卷积 空洞卷积是是为了解决基于FCN思想的语义分割中,输出图像的size要求和输入图像的size一致而需要upsample,但由于FCN中使用pooling操作来增大感受野同时降低分辨率,导致 ...

- tensorflow的卷积和池化层(二):记实践之cifar10

在tensorflow中的卷积和池化层(一)和各种卷积类型Convolution这两篇博客中,主要讲解了卷积神经网络的核心层,同时也结合当下流行的Caffe和tf框架做了介绍,本篇博客将接着tenso ...

随机推荐

- LevelDB原理解析

LevelDb有如下一些特点: 首先,LevelDb是一个持久化存储的KV系统,和Redis这种内存型的KV系统不同,LevelDb不会像Redis一样狂吃内存,而是将大部分数据存储到磁盘上. 其次, ...

- Scrum Meeting NO.1

Scrum Meeting No.1 1.会议内容 不出所料地,组员们都在忙着写编译.编译大作业的进度已经接近尾声,码农们已经磨刀霍霍向软工-- 在上一周,bugphobia和我们组决定共同使用一套后 ...

- 【读书笔记】Linux内核设计与实现(第一章&第二章)

http://pan.baidu.com/s/1hqYAZNQ OneNote做的笔记没法儿带着格式一起导进来.所以上传到百度云,麻烦老师下载一下了. 下次不再用OneNote.

- mysql 访问不是本地数据库,给用户刷新了权限没有作用

1.grant all privileges on *.* to 'yangxin'@'%' identified by 'yangxin123456' with grant option; flus ...

- 软件工程之四则运算--Github

由于现在配置问题,然后借用同学电脑将代码上传至Github,网址为:https://github.com/be821/RealFour 参考相关Github文档: 1. http://my.oschi ...

- OS X(10.10) python3.4 matplotlib的安装

最近在用python做一些数据处理相关的工作,当然少不了matplotlib这个模块.之前在windows下分分钟安装成功,结果到了mac下死活编译不过去. 最后还是在stackoverflow上找到 ...

- C语言入门:03.关键字、标识符、注释

一.学习语法之前的提醒 (1)C语言属于一门高级语言,其实,所有高级语言的基本语法组成部分都是一样的,只是表现形式不太一样 (2)就好像亚洲人和非洲人,大家都有人类的结构:2只 手.2只脚.1个头,只 ...

- 使用kubeadm 离线安装 单master k8s 1.13

Study From :https://www.kubernetes.org.cn/4948.html https://www.kubernetes.org.cn/4948.html 感谢原作者提供的 ...

- BeanFactory 简介以及它 和FactoryBean的区别(阿里面试)

BeanFacotry是spring中比较原始的Factory.如XMLBeanFactory就是一种典型的BeanFactory.原始的BeanFactory无法支持spring的许多插件,如AOP ...

- 登录窗口不是系统主窗口 但又需要最先显示 用delphi怎么编写代

主窗体FormShow事件(主窗体为Form1为例,Form2为登陆窗体) procedure TForm1.FormShow(Sender: TObject); begin if Form2.S ...