openstack(Pike 版)集群部署(三)--- Glance 部署

一、介绍

参照官网部署:https://docs.openstack.org/glance/queens/install/

继续上一博客进行部署:http://www.cnblogs.com/weijie0717/p/8556939.html

二、部署 Glance

1、配置数据库 (任意controller 节点操作)

# mysql -uroot -p

mysql> CREATE DATABASE glance;

mysql> GRANT ALL PRIVILEGES ON glance.* TO 'glance'@'localhost' IDENTIFIED BY 'GLANCE_DBPASS';

mysql> GRANT ALL PRIVILEGES ON glance.* TO 'glance'@'%' IDENTIFIED BY 'GLANCE_DBPASS';

2、配置glance 用户和 API 信息 (任意controller 节点操作)

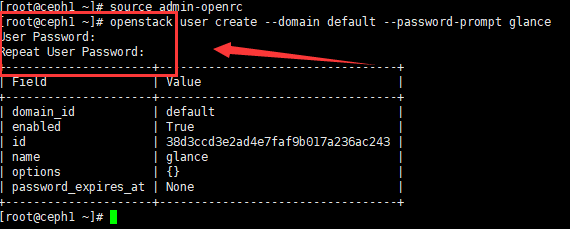

a、获取管理员认证权限

# source admin-openrc

b、创建用户

# openstack user create --domain default --password-prompt glance (新用户需要配置密码)

c、分配 Glance到 指定project 和 role

# openstack role add --project service --user glance admin

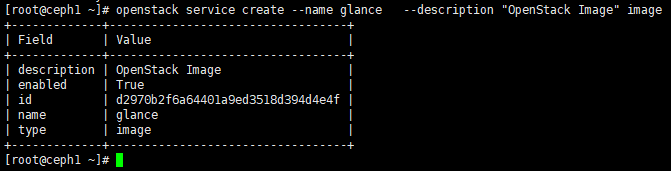

d、创建 openstack Glance 服务

# openstack service create --name glance --description "OpenStack Image" image

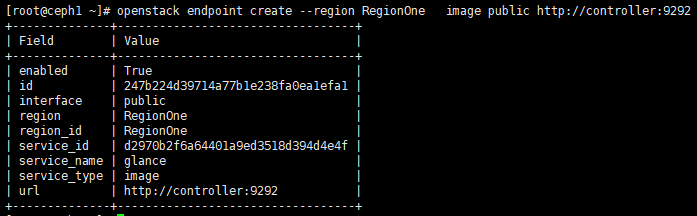

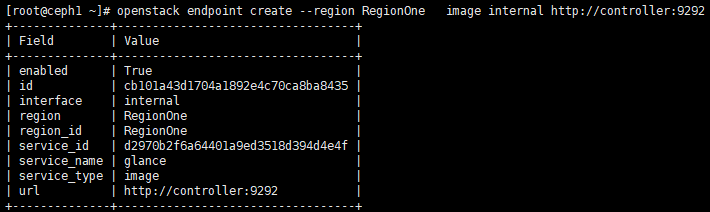

e、创建 GLance API (admin,public,internal)

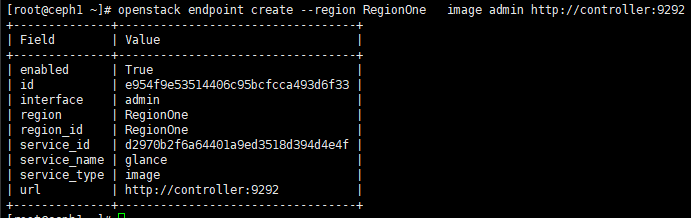

# openstack endpoint create --region RegionOne image public http://controller:9292 #(controller为 Glance-haproxy-vip)

# openstack endpoint create --region RegionOne image internal http://controller:9292 #(controller为 Glance-haproxy-vip)

# openstack endpoint create --region RegionOne image admin http://controller:9292 #(controller为 Glance-haproxy-vip)

3、 Glance 包安装 (所有controller-node)

# yum install -y openstack-glance

4、编辑配置文件 (所有controller-node)

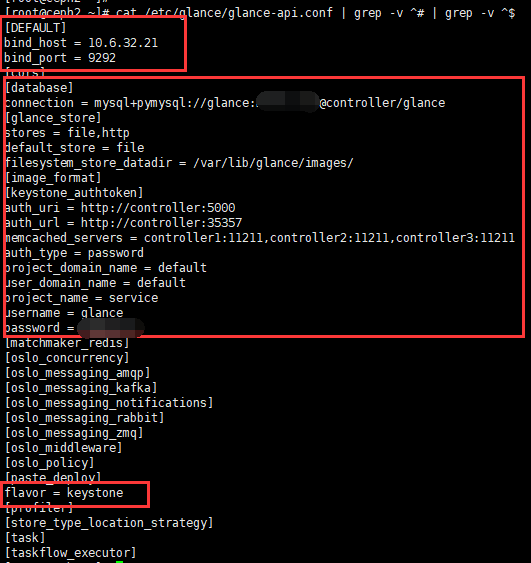

a、编辑 /etc/glance/glance-api.conf 文件 # 标红区域为需要特别关注的地方

# vim /etc/glance/glance-api.conf

[DEFAULT] # 集群中此配置文件唯一不一样的区域,为避免后期 HAproxy 端口冲突

bind_host = 网卡IP

bind_port = 9292 [database]

# ...

connection = mysql+pymysql://glance:GLANCE_PASS@controller/glance [keystone_authtoken]

# ...

auth_uri = http://controller:5000

auth_url = http://controller:35357

memcached_servers = controller1:11211,controller2:11211,controller3:11211

auth_type = password

project_domain_name = default

user_domain_name = default

project_name = service

username = glance

password = GLANCE_PASS [paste_deploy]

# ...

flavor = keystone [glance_store] # 以下为Glance 本地存储配置

# ...

stores = file,http

default_store = file

filesystem_store_datadir = /var/lib/glance/images/

如下图:

b、编辑 /etc/glance/glance-registry.conf 文件 # 标红区域为需要特别关注的地方

# vim /etc/glance/glance-registry.conf

[DEFAULT] # 整个集群文件中唯一不同的区域

# ...

bind_host = 网卡ip

bind_port = 9191 [database]

connection = mysql+pymysql://glance:GLANCE_PASS@controller/glance [keystone_authtoken]

# ...

auth_uri = http://controller:5000

auth_url = http://controller:35357

memcached_servers = controller1:11211,controller2:11211,controller3:11211

auth_type = password

project_domain_name = default

user_domain_name = default

project_name = service

username = glance

password = GLANCE_PASS [paste_deploy]

# ...

flavor = keystone

5、初始化 Glance 数据库 (任意controller 节点操作)

# su -s /bin/sh -c "glance-manage db_sync" glance

# (忽略此处输出所有信息)

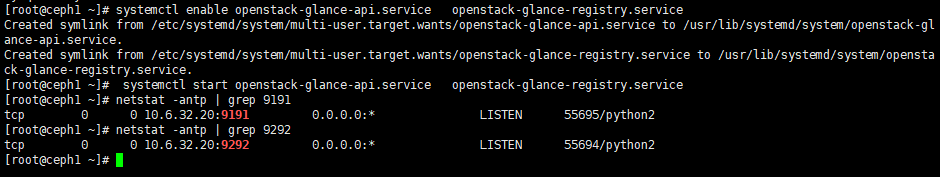

6、启动服务并设置开机自启动 (all-controller-node)

# systemctl enable openstack-glance-api.service openstack-glance-registry.service

# systemctl start openstack-glance-api.service openstack-glance-registry.service

# 查看端口,如下:服务启动正常

7、配置 Glance-Haproxy

博客:http://www.cnblogs.com/weijie0717/p/8530102.html

注:必须保证 单controller -node 认证 Glance 和 Keystone 时访问的是同一个节点,否则为认证失败。

三、测试 (任意 controller-node)

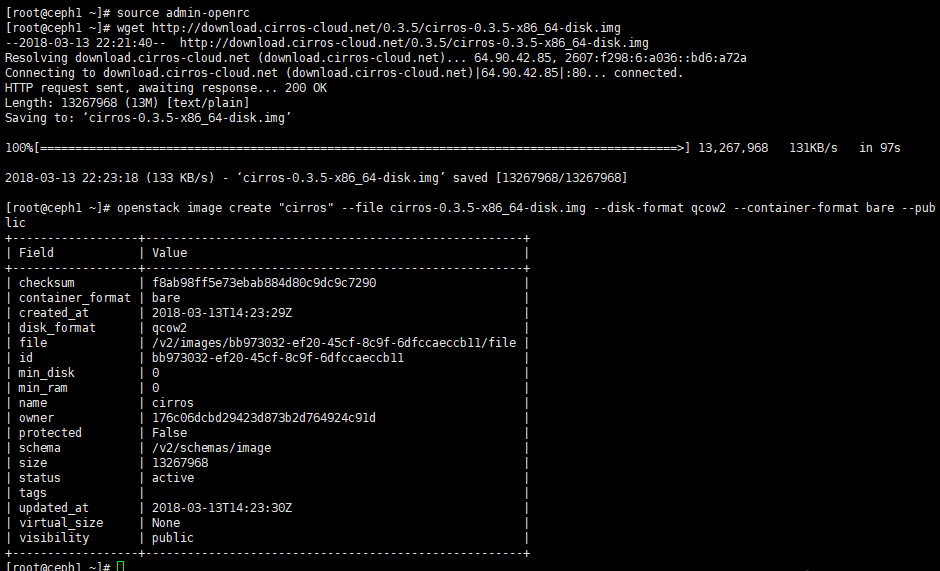

1、下载镜像

# cd /root

# wget http://download.cirros-cloud.net/0.3.5/cirros-0.3.5-x86_64-disk.img

2、上传镜像到Image server

# openstack image create "cirros" --file cirros-0.3.5-x86_64-disk.img --disk-format qcow2 --container-format bare --public

3、查看

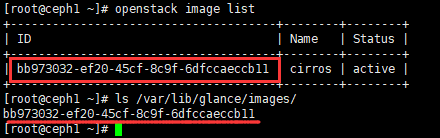

1、查看镜像上传情况

# openstack image list

上传成功

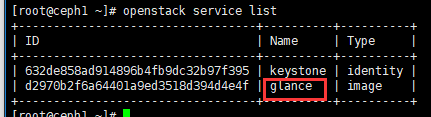

2、查看openstack集群 当前支持服务

# openstack service list

到此处,openstack集群 Glance-server 使用本地存储 部署成功。

续: openstack集群 Glance-server 使用Ceph 存储。

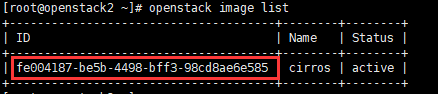

1、删除之前上传的本地镜像。(任意 controller-node)

a、查看镜像ID

# openstack image list

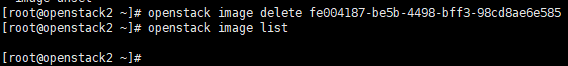

b、删除镜像

# openstack image delete image-ID

2、拷贝ceph集群配置文件到所有controller 节点 /etc/ceph/ceph.conf (ceph 集群 任意节点)

# scp /etc/ceph/ceph.conf root@controller1:/etc/ceph/ceph.conf

# scp /etc/ceph/ceph.conf root@controller2:/etc/ceph/ceph.conf

# scp /etc/ceph/ceph.conf root@controller3:/etc/ceph/ceph.conf

3、创建 Glance 所需要的ceph 存储池:images (任意ceph-mon 节点 )

# ceph osd pool create images 64 64

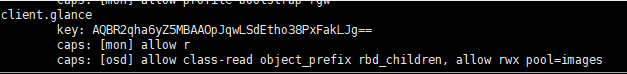

4、生成和导出证书到 controller节点 (任意ceph-mon 节点 )

a、生成key

# ceph auth get-or-create client.glance mon 'allow r' osd 'allow class-read object_prefix rbd_children, allow rwx pool=images'

b、查看

# ceph auth list

c、导出 key,并拷贝至所有controller 节点 /etc/ceph/文件中

# ceph auth get-or-create client.glance | tee /etc/ceph/ceph.client.glance.keyring

# scp /etc/ceph/ceph.client.glance.keyring root@controller-all:/etc/ceph/ceph.client.glance.keyring

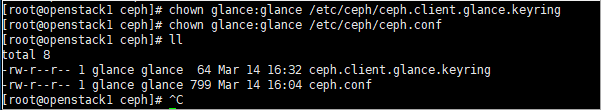

d、修改ceph.conf 和 key 文件 权限 (所有controller节点操作)

# chown glance:glance /etc/ceph/ceph.client.glance.keyring

# chown glance:glance /etc/ceph/ceph.conf

5、安装 rbd 驱动包 (all-controller-node)

# yum install python-rbd -y

6、修改 glance-api 配置文件 (all-controller-node)

a、备份配置,便于恢复

# cp /etc/glance/glance-api.conf /etc/glance/glance-api.conf.bak

b、修改配置文件

# vim /etc/glance/glance-api.conf

[DEFAULT]

show_image_direct_url = True #启动镜像的写时复制功能 [glance_store]

stores = rbd

default_store = rbd

#filesystem_store_datadir = /var/lib/glance/images/ #注释此行,本地存储配置行

rbd_store_chunk_size = 8

rbd_store_pool = images

rbd_store_user = glance

rbd_store_ceph_conf = /etc/ceph/ceph.conf

7、重启服务 (all-controller-node)

# systemctl restart openstack-glance-api.service openstack-glance-registry.service

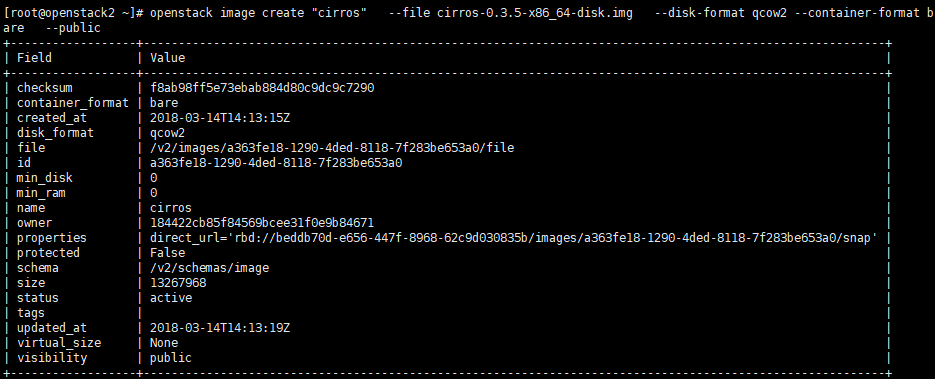

8、上传镜像进行测试。(任意 controller-node)

a、获取认证权限

# source admin-openrc

b、下载镜像

# wget http://download.cirros-cloud.net/0.3.5/cirros-0.3.5-x86_64-disk.img

c、上传镜像

# openstack image create "cirros" --file cirros-0.3.5-x86_64-disk.img --disk-format qcow2 --container-format bare --public

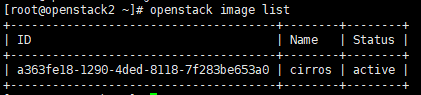

d、查看镜像上传情况

#openstack image list

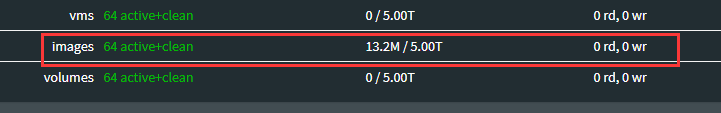

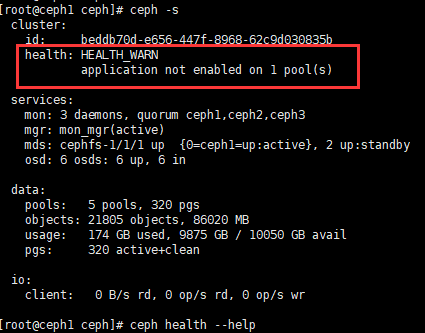

9、ceph 查看镜像上传情况和处理告警

a、镜像已上传至ceph,ceph会有告警

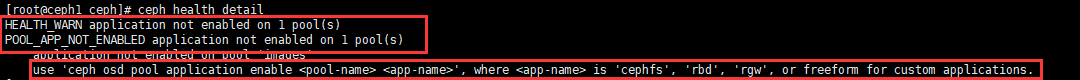

b、告警信息查看

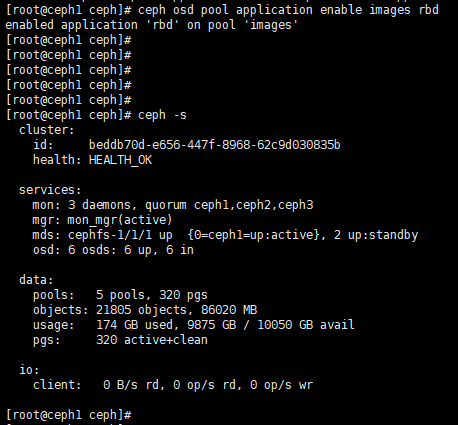

c、按照提示处理告警

# ceph osd pool application enable images rbd

Openstack Glance server 到此处部署完毕。

openstack(Pike 版)集群部署(三)--- Glance 部署的更多相关文章

- openstack高可用集群16-ceph介绍和部署

Ceph Ceph是一个可靠.自动重均衡.自动恢复的分布式存储系统,根据场景划分可以将Ceph分为三大块,分别是对象存储.块设备和文件系统服务.块设备存储是Ceph的强项. Ceph的主要优点是分布式 ...

- openstack pike 集群高可用 安装 部署 目录汇总

# openstack pike 集群高可用 安装部署#安装环境 centos 7 史上最详细的openstack pike版 部署文档欢迎经验分享,欢迎笔记分享欢迎留言,或加QQ群663105353 ...

- openstack高可用集群21-生产环境高可用openstack集群部署记录

第一篇 集群概述 keepalived + haproxy +Rabbitmq集群+MariaDB Galera高可用集群 部署openstack时使用单个控制节点是非常危险的,这样就意味着单个节 ...

- CentOS7.2非HA分布式部署Openstack Pike版 (实验)

部署环境 一.组网拓扑 二.设备配置 笔记本:联想L440处理器:i3-4000M 2.40GHz内存:12G虚拟机软件:VMware® Workstation 12 Pro(12.5.2 build ...

- VLAN 模式下的 OpenStack 管理 vSphere 集群方案

本文不合适转载,只用于自我学习. 关于为什么要用OpenStack 管理 vSphere 集群,原因可以有很多,特别是一些传统企业,VMware 的使用还是很普遍的,用 OpenStack 纳管至少会 ...

- Kubernetes容器集群管理环境 - 完整部署(上篇)

Kubernetes(通常称为"K8S")是Google开源的容器集群管理系统.其设计目标是在主机集群之间提供一个能够自动化部署.可拓展.应用容器可运营的平台.Kubernetes ...

- Kubeadm 1.9 HA 高可用集群本地离线镜像部署【已验证】

k8s介绍 k8s 发展速度很快,目前很多大的公司容器集群都基于该项目,如京东,腾讯,滴滴,瓜子二手车,易宝支付,北森等等. kubernetes1.9版本发布2017年12月15日,每三个月一个迭代 ...

- [K8s 1.9实践]Kubeadm 1.9 HA 高可用 集群 本地离线镜像部署

k8s介绍 k8s 发展速度很快,目前很多大的公司容器集群都基于该项目,如京东,腾讯,滴滴,瓜子二手车,北森等等. kubernetes1.9版本发布2017年12月15日,每是那三个月一个迭代, W ...

- 实现CI/CDk8s高可用集群搭建总结以及部署API到k8s

实现CI/CD(Centos7.2)系列二:k8s高可用集群搭建总结以及部署API到k8s 前言:本系列博客又更新了,是博主研究很长时间,亲自动手实践过后的心得,k8s集群是购买了5台阿里云服务器部署 ...

- openstack高可用集群17-openstack集成Ceph准备

Openstack集成Ceph准备 Openstack环境中,数据存储可分为临时性存储与永久性存储. 临时性存储:主要由本地文件系统提供,并主要用于nova虚拟机的本地系统与临时数据盘,以及存储gla ...

随机推荐

- 01.VMware虚拟机上网络连接(network type)的三种模式--bridged、host-only、NAT

VMWare提供了三种工作模式,它们是bridged(桥接模式).NAT(网络地址转换模式)和host-only(主机模式).要想在网络管理和维护中合理应用它们,你就应该先了解一下这三种工作模式. 1 ...

- js人形时钟

https://blog.csdn.net/rsylqc/article/details/44808063 分享自:http://chabudai.org/blog/?p=59 在这个网站看到一个很有 ...

- mui longtap 事件无效

1.mui 的部分事件默认是关闭的 需要在init中单独配置事件开关 mui.init({ gestureConfig: { longtap: true, //默认为false } })

- shell编程:基本语法

要掌握一门语言,就要先掌握它的语法.如同C语言一般,shell也有自己的语法. 变量 按照惯例,Shell变量通常由字母加下划线开头,由任意长度的字母.数字.下划线组成.有两种类型的Shell变量: ...

- Rafy源码解读 笔记(一) DbMigration

主要功能,提供数据库的升级回滚和变迁操作. 整个模块的都是通过DbMigrationContext这个类来体现的,回滚或升级由若干个子操作完成,每个子操作被封装成一个类MigrationOperati ...

- Python正则表达式与re模块介绍

Python中通过re模块实现了正则表达式的功能.re模块提供了一些根据正则表达式进行查找.替换.分隔字符串的函数.本文主要介绍正则表达式先关内容以及re模块中常用的函数和函数常用场景. 正则表达式基 ...

- LeetCode OJ 144. Binary Tree Preorder Traversal

Given a binary tree, return the preorder traversal of its nodes' values. For example:Given binary tr ...

- vue中嵌套页面(iframe)

vue中嵌套iframe,将要嵌套的文件放在static下面.(要将打包文件整体放在statici里,我的文件名是canvas) src可以使用相对路径,也可使用服务器根路径http:localhos ...

- sqlalchemy sql express language

metadata = MetaData() teacher = Table("teachers", metadata, Column("tid", Intege ...

- 18. socket io

类似dataservice 我们socket io 和后端交互 我们也可以做成专门的service 我们先引入 为什么不是cdn呢? 因为client就是从我们的server端拿到的socket.io ...