深度学习—BN的理解(二)

神经网络各个操作层的顺序:

1、sigmoid,tanh函数:conv -> bn -> sigmoid -> pooling

2、RELU激活函数:conv -> bn -> relu -> pooling

一般情况下,先激活函数,后pooling。但对于RELU激活函数,二者交换位置无区别。

论文原文里面是“weights -> batchnorm -> activation ->maxpooling-> weights -> batchnorm -> activation -> dropout”。原文认为这样可以利用到激活函数的不同区间(sigmoid的两个饱和区、中间的线性区等)实现不同的非线性效果,在特定的情况下也可能学习到一个恒等变换的batchnorm,一般用这个即可。

为了activation能更有效地使用输入信息,所以一般放在激活函数之前。

tensorflow中关于BN(Batch Normalization)的函数主要有两个,分别是:

- tf.nn.moments

- tf.nn.batch_normalization

- tf.layers.batch_normalization

- tf.contrib.layers.batch_norm

应用中一般使用 tf.layers.batch_normalization 进行归一化操作。因为集成度较高,不需要自己计算相关的均值和方差。

1、tf.nn.moments计算的是哪一部分均值方差?

举例:

tf.nn.moments(x, axes, name=None, keep_dims=False);其中x是输入,axes表示在哪一维计算,输出为计算的均值和方差。

img = tf.Variable(tf.random_normal([128, 32, 32, 64]))

axis = list(range(len(img.get_shape()) - 1))

mean, variance = tf.nn.moments(img, axis)

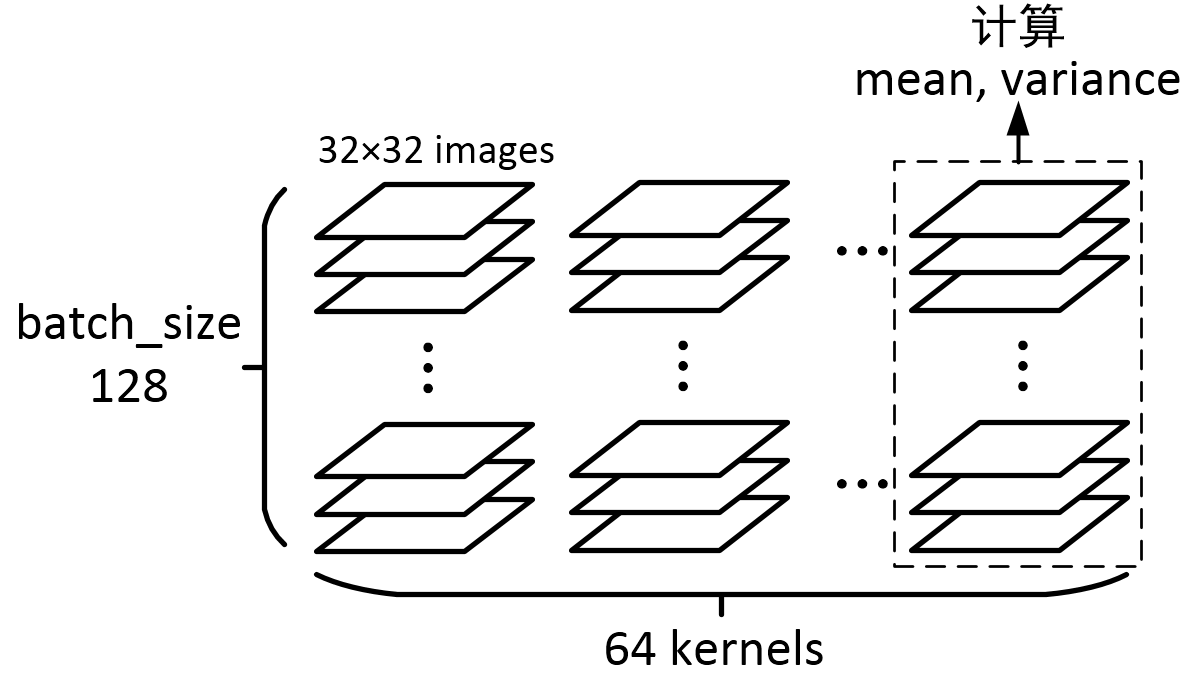

一个batch里的128个图,经过一个64 kernels卷积层处理,得到了128×64个图,再针对每一个kernel所对应的128个图,求它们所有像素的mean和variance,因为总共有64个kernels,输出的结果就是一个一维长度64的数组啦!最后输出是(64,)的数组向量。

2、 tf.layers.batch_normalization

在TensorFlow中,如果我们要使用batch normalization层,可以使用的API有tf.layers.batch_normalization和tf.contrib.layers.batch_norm,如果我们直接使用这两个API构建我们的网络,往往会出现训练的时候网络的表现非常好,而当测试的时候我们将其中的参数is_training设置为False时,网络的表现非常的差。这往往是因为我们训练的时候忽视了一个细节。

(1)方法1:

在tf.contrib.layers.batch_norm的帮助文档中我们看到有以下的文字

Note: when training, the moving_mean and moving_variance need to be updated. By default the update ops are placed in tf.GraphKeys.UPDATE_OPS, so they need to be added as a dependency to the train_op.

也就是说,我们需要在代码运行的过程中手动对moving_mean和moving_variance进行手动更新,代码如下:

update_ops = tf.get_collection(tf.GraphKeys.UPDATE_OPS)

with tf.control_dependencies(update_ops):

train_op = optimizer.minimize(loss)

这一步非常的重要,很多人在训练的时候往往会忽略这一步,导致训练/测试时结果相差巨大。

(2)还有一个方法:需要将is_training改成True。

要注意的地方是,在做测试的时候,如果将is_training改为 False,就会出现测试accuracy很低的现象,需要将is_training改成True。虽然这样能得到高的accuracy,但是明显不合理!!

3、tf.nn.batch_normalization

自己写,用tf.nn.batch_normalization

tensorflow实现:

def batchNorm_layer(inputs, is_training, decay = 1e-5, epsilon = 1e-3):

scale = tf.Variable(tf.ones(inputs.get_shape()[1:].as_list()))

beta = tf.Variable(tf.zeros(inputs.get_shape()[1:].as_list()))

pop_mean = tf.Variable(tf.zeros(inputs.get_shape()[1:].as_list()), trainable=False)

pop_var = tf.Variable(tf.ones(inputs.get_shape()[1:].as_list()), trainable=False) if is_training:

batch_mean, batch_var = tf.nn.moments(inputs, [0])

train_mean = tf.assign(pop_mean, pop_mean * decay + batch_mean * (1 - decay))

train_var = tf.assign(pop_var, pop_var * decay + batch_var * (1 - decay))

with tf.control_dependencies([train_mean, train_var]):

return tf.nn.batch_normalization(inputs, batch_mean, batch_var, beta, scale, epsilon)

else:

return tf.nn.batch_normalization(inputs, pop_mean, pop_var, beta, scale, epsilon)

参考:https://www.jianshu.com/p/0312e04e4e83

深度学习—BN的理解(二)的更多相关文章

- 深度学习—BN的理解(一)

0.问题 机器学习领域有个很重要的假设:IID独立同分布假设,就是假设训练数据和测试数据是满足相同分布的,这是通过训练数据获得的模型能够在测试集获得好的效果的一个基本保障.那BatchNorm的作用是 ...

- 转载-【深度学习】深入理解Batch Normalization批标准化

全文转载于郭耀华-[深度学习]深入理解Batch Normalization批标准化: 文章链接Batch Normalization: Accelerating Deep Network T ...

- 深度学习课程笔记(二)Classification: Probility Generative Model

深度学习课程笔记(二)Classification: Probility Generative Model 2017.10.05 相关材料来自:http://speech.ee.ntu.edu.tw ...

- 【深度学习】深入理解Batch Normalization批标准化

这几天面试经常被问到BN层的原理,虽然回答上来了,但还是感觉答得不是很好,今天仔细研究了一下Batch Normalization的原理,以下为参考网上几篇文章总结得出. Batch Normaliz ...

- 深度学习入门实战(二)-用TensorFlow训练线性回归

欢迎大家关注腾讯云技术社区-博客园官方主页,我们将持续在博客园为大家推荐技术精品文章哦~ 作者 :董超 上一篇文章我们介绍了 MxNet 的安装,但 MxNet 有个缺点,那就是文档不太全,用起来可能 ...

- 【深度学习】深入理解优化器Optimizer算法(BGD、SGD、MBGD、Momentum、NAG、Adagrad、Adadelta、RMSprop、Adam)

在机器学习.深度学习中使用的优化算法除了常见的梯度下降,还有 Adadelta,Adagrad,RMSProp 等几种优化器,都是什么呢,又该怎么选择呢? 在 Sebastian Ruder 的这篇论 ...

- 【深度学习笔记】(二)基于MNIST数据集的神经网络实验

一.介绍 MNIST(Mixed National Institute of Standards and Technology database)是网上著名的公开数据库之一,是一个入门级的计算机视觉数 ...

- 【深度学习】深入理解ReLU(Rectifie Linear Units)激活函数

论文参考:Deep Sparse Rectifier Neural Networks (很有趣的一篇paper) Part 0:传统激活函数.脑神经元激活频率研究.稀疏激活性 0.1 一般激活函数有 ...

- 深度学习基础(十二)—— ReLU vs PReLU

从算法的命名上来说,PReLU 是对 ReLU 的进一步限制,事实上 PReLU(Parametric Rectified Linear Unit),也即 PReLU 是增加了参数修正的 ReLU. ...

随机推荐

- Rocchio算法

一.引子 查询扩展(Query Expansion)是信息检索领域的一个重要话题. 一方面.用户本身可能会出错,他会输入一些错别字,比方把"冯小刚",错写成"冯晓刚&qu ...

- udp广播和多播

使用UDP协议进行信息的传输之前不需要建立链接, 客户端向服务器发送信息时,客户端只需要给出服务器的ip地址和端口号,可以发送信息.至于服务器端是否存在,是否能够收到该报文,客户端根本不用管. 广播( ...

- 配置LANMP环境(9)-- 安装Git与vsftp

一.安装Git 检查是否已经安装 git --version 安装 yum -y install git 二.安装vsftp 检查是否已经安装 yum list installed vsftpd 安装 ...

- 【Mac系统 + Mysql】之安装Mysql数据库

安装Mysql步骤: 一.下载 参考文章<mac 安装MySQL> 到Mysql官网下载.dmg格式的文件 先放弃了,看下面的简易安装. 二.使用homebrew安装MySQL(推荐) 如 ...

- erlang实现一个进程池 pool

erlang的实现一个简单的进程池. erlang进程是非常轻量级的,这个进程池的主要目的是用一种通用的方式去管理和限制系统中运行的资源占用.当运行的工作者进程数量达到上限,进程池还可以把任务放到队列 ...

- Warning: (3719, “‘utf8’ is currently an alias for the character set UTF8MB3, which will be replaced by UTF8MB4 in a future release. Please consider using UTF8MB4 in order to be unambiguous.”)

[1]本地版本 Mysql 8.0.12 创建表SQL: DROP TABLE IF EXISTS students; CREATE TABLE `students` ( `sId` ) UNSIGN ...

- mysql 考勤表异常 【待修改】

有考勤刷卡记录表,表名为attendance ,有如下字段: 姓名 卡号 刷卡时间 刷卡类型 name id time type 张三 59775623 2010-04-01 07:23:37 ...

- 【JavaEE】Springmvc搭建方法及example

现在介绍SSH的文章很多,但是适合自己需求的却经常找不到,这些东西呢,会了之后总会感觉别人的程序哪里哪里别扭,会之前呢就感觉很混乱,而且SSH的官方文档,至少在我看来是“会者勉强能看.不会者一片迷茫” ...

- 如何创建AnjularJS项目

第一步:命名空间 var applyAppModule=angular.module('apply-app' ,[]); 第二步:控制器 ng-controller="ApplyCon ...

- Effective Java 读书笔记(一):使用静态工厂方法代替构造器

这是Effective Java第2章提出的第一条建议: 考虑用静态工厂方法代替构造器 此处的静态工厂方法并不是设计模式,主要指static修饰的静态方法,关于static的说明可以参考之前的博文&l ...