window7系统下安装scrapy爬虫框架

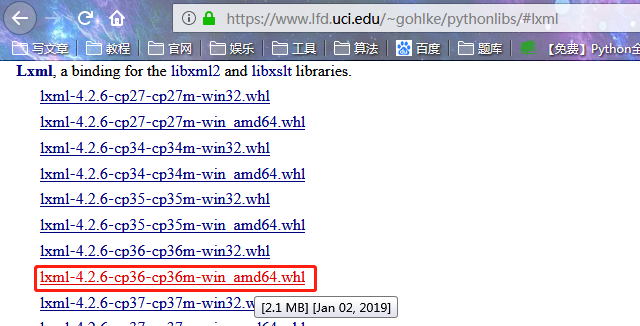

本文是在python3.6环境下安装的下面软件,如果大家和我的python版本不一致,请在页面选择符合自己版本的软件下载.

1.wheel

pip install wheel

2.lxml

下载lxml文件:https://www.lfd.uci.edu/~gohlke/pythonlibs/#lxml

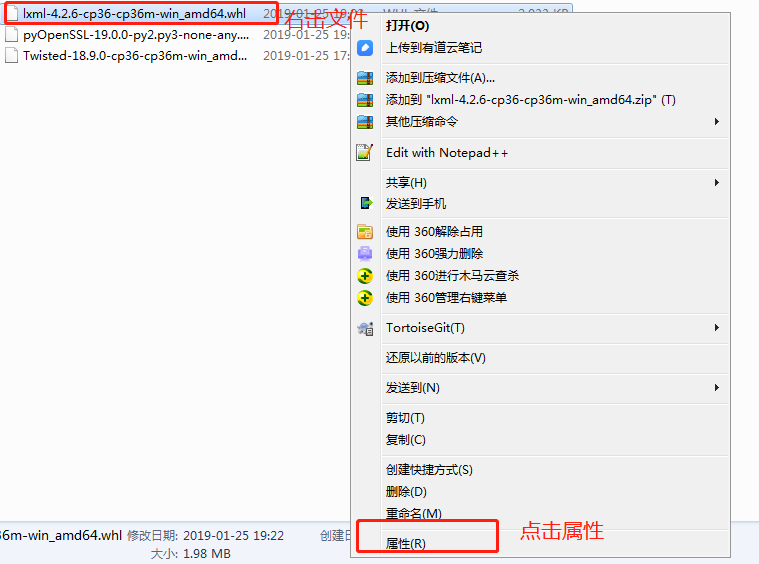

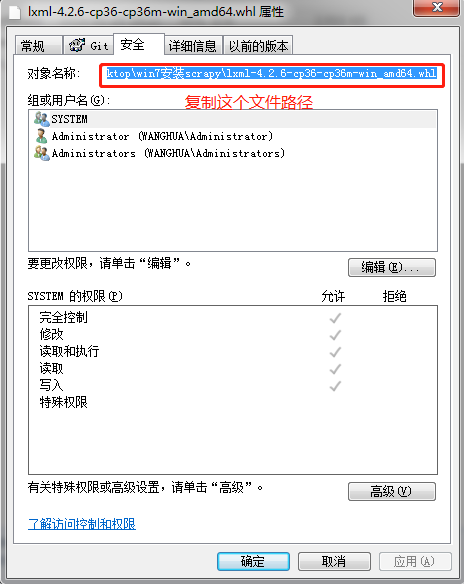

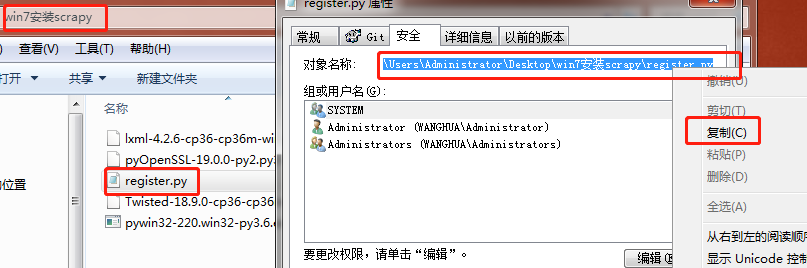

下载完成,鼠标右击文件-属性-安全-复制文件路径

pip install C:\Users\Administrator\Desktop\lxml-4.2.6-cp36-cp36m-win_amd64.whl

打开cmd命令行

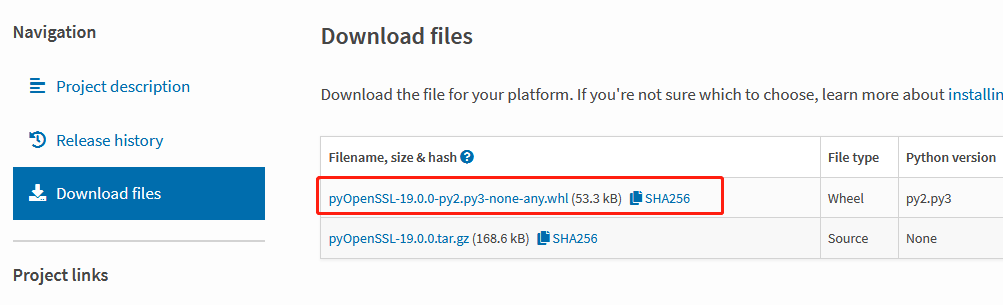

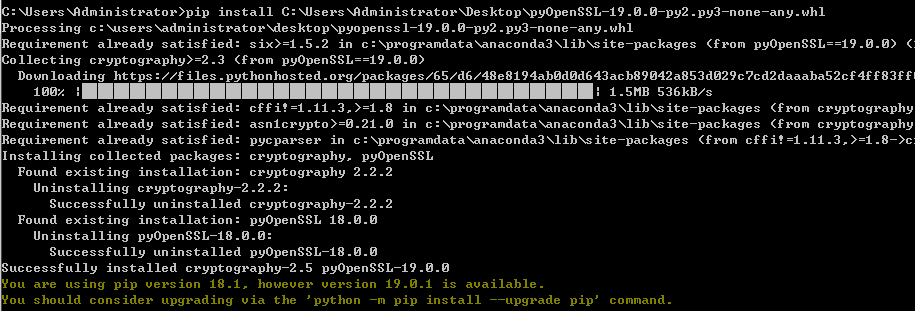

3.PyOpenssl

下载文件pyOpenSSL

https://pypi.org/project/pyOpenSSL/#files

安装

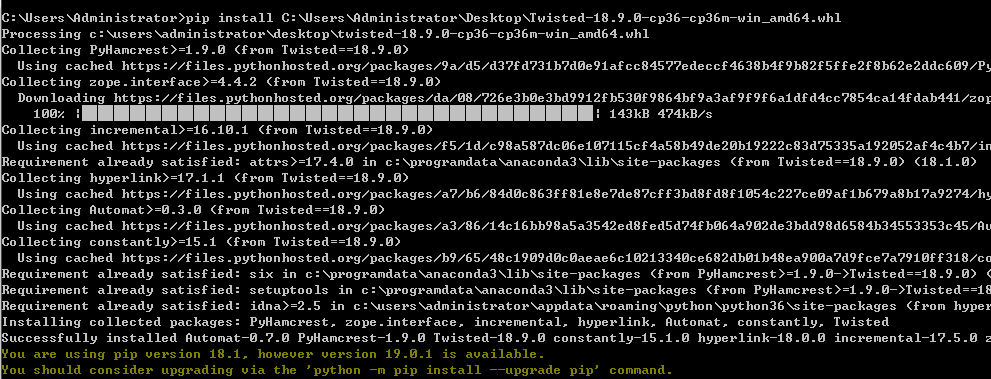

4.Twisted

下载文件

https://www.lfd.uci.edu/~gohlke/pythonlibs/#twisted

安装

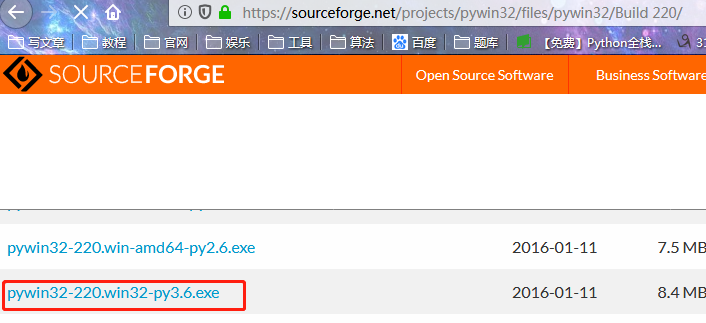

5.Pywin32

下载文件pywin32

https://sourceforge.net/projects/pywin32/files/pywin32/Build%20220/

安装

6.Scrapy

pip install scrapy

7.番外篇

7.1如果遇到下面的问题

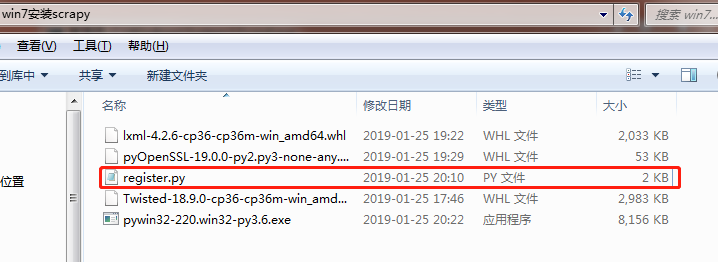

7.2请编写一个文件register.py,内容如下:

from __future__ import print_function

import sys

try:

from winreg import *

except ImportError:

from _winreg import *

# tweak as necessary

version = sys.version[:3]

installpath = sys.prefix

regpath = "SOFTWARE\\Python\\Pythoncore\\{0}\\".format(version)

installkey = "InstallPath"

pythonkey = "PythonPath"

pythonpath = "{0};{1}\\Lib\\;{2}\\DLLs\\".format(

installpath, installpath, installpath)

def RegisterPy():

try:

reg = OpenKey(HKEY_CURRENT_USER, regpath)

except EnvironmentError as e:

try:

reg = CreateKey(HKEY_CURRENT_USER, regpath)

SetValue(reg, installkey, REG_SZ, installpath)

SetValue(reg, pythonkey, REG_SZ, pythonpath)

CloseKey(reg)

except:

print("*** Unable to register!")

return

print("--- Python", version, "is now registered!")

return

if (QueryValue(reg, installkey) == installpath and

QueryValue(reg, pythonkey) == pythonpath):

CloseKey(reg)

print("=== Python", version, "is already registered!")

return

CloseKey(reg)

print("*** Unable to register!")

print("*** You probably have another Python installation!")

if __name__ == "__main__":

RegisterPy()

7.3 复制python文件路径

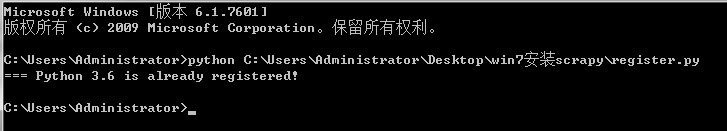

7.4 cmd窗口执行python文件

7.5 重新执行pywin32-220.win32-py3.6.exe

8.相关文件百度网盘下载地址:

链接:https://pan.baidu.com/s/1RmtuVywW_mXs76_usU0sjA

提取码:uakt

window7系统下安装scrapy爬虫框架的更多相关文章

- win7中python3.4下安装scrapy爬虫框架(亲测可用)

貌似最新的scrapy已经支持python3,但是错误挺多的,以下为在win7中的安装步骤: 1.首先需要安装Scrapy的依赖包,包括parsel, w3lib, cryptography, pyO ...

- 安装scrapy 爬虫框架

安装scrapy 爬虫框架 个人根据学习需要,在Windows搭建scrapy爬虫框架,搭建过程种遇到个别问题,共享出来作为记录. 1.安装python 2.7 1.1下载 下载地址 1.2配置环境变 ...

- python3.7.1安装Scrapy爬虫框架

python3.7.1安装Scrapy爬虫框架 环境:win7(64位), Python3.7.1(64位) 一.安装pyhthon 详见Python环境搭建:http://www.runoob.co ...

- Window7环境下安装Scrapy 方法

Window7环境下安装Scrapy Scrapy在CPython(默认Python实现)和PyPy(从PyPy 5.9开始)下运行Python 2.7和Python 3.4或更高版本. 如果您使用的 ...

- Python3环境安装Scrapy爬虫框架过程及常见错误

收录待用,修改转载已取得腾讯云授权 Scrapy安装介绍 Scrapy的安装有多种方式,它支持Python2.7版本及以上或Python3.3版本及以上.下面说明Python3环境下的安装过程. Sc ...

- Ubuntu 12.04 安装Scrapy爬虫框架

转自:http://www.cnblogs.com/HelloPython/ 亲测有效 根据Scrapy安装指南(http://doc.scrapy.org/en/latest/intro/insta ...

- Window7系统下安装jdk

根据电脑的操作系统下载相对于的jdk版本(32位或64位),我安装的是:java_jdk1.7 [计算机]——[属性]——[高级系统设置]——高级——[环境变量] 系统变量——>新建JAVA_H ...

- python应用:爬虫框架Scrapy系统学习第二篇——windows下安装scrapy

windows下安装scrapy 依次执行下列操作: pip install wheel pip install lxml pip install PyOpenssl 安装Microsoft visu ...

- Python之Scrapy爬虫框架安装及简单使用

题记:早已听闻python爬虫框架的大名.近些天学习了下其中的Scrapy爬虫框架,将自己理解的跟大家分享.有表述不当之处,望大神们斧正. 一.初窥Scrapy Scrapy是一个为了爬取网站数据,提 ...

随机推荐

- Centos下Subversion 服务器安装配置

1.安装 # yum install subversion 2. svn配置 建立svn版本库目录可建多个:2.1 新建文件夹: # mkdir -p /opt/svndata/repos 2.2 建 ...

- SpringCloud系列十五:使用Hystrix实现容错

1. 回顾 上文讲解了容错的重要性,以及容错需要实现的功能. 本文来讲解使用Hystrix实现容错. 2. Hystrix简介 Hystrix是Netflix开源的一个延迟和容错库,用于隔离访问远程系 ...

- Java中有几种类型的流?以及常见的实现类都有哪些?

Java中有几种类型的流?以及常见的实现类都有哪些? 首先应该从两个角度来看: 从输入输出方面来讲: Java中有输入流和输出流 从流的编码方式上来讲: Java中有字节流和字符流 ...

- 使用httpClient发送get\post请求

maven依赖 <dependency> <groupId>org.apache.httpcomponents</groupId> <artifactId&g ...

- cnetos 6.7彻底解决vmware NAT网络问题

cnetos 6.7彻底解决vmware NAT网络问题 vmnet8在nat时使用 vmnet1 在桥接时使用 *解决Windows不能ping通linux的问题 vmnet8相当于一个网卡,虚 ...

- 利用ascx输出knockoutjs的模板

项目里面的UI模板在一个页面中有2K多行了.需要增加新的UI样式.问题来了.加上js代码,几乎是变成了不可维护的状态.增加和修改都需要用ctrl+f的方式找到对应的模板,然后进行处理.很容易出错.突然 ...

- windows下安装JDK和Tomcat

一.安装JDK 1.安装 JDK当前最高版本为1.7. 下载并运行JDK 1.7安装程序jdk-7u25-windows-i586.exe,直接安装到C盘(也可以在其它盘,但文件名一定要是英文名),其 ...

- python 爬虫1 Urllib库的基本使用

1.简单使用 import urllib2 response = urllib2.urlopen("http://www.baidu.com") print response.re ...

- wpf数据绑定更新通知

类似于这样子的;大致的意思是:一个代码变量,通过改变变量的值,绑定这个变量的这个圆颜色也在变化 就是一种心跳效果 在网上数据触发的感觉不多,废了不少时间,这里做个总结 1:通知 class Notif ...

- C++11写算法之选择排序

选择排序,顾名思义,指从数组后面将最小的值找出来,然后与最前面(指当前位置)值进行交换. 时间复杂度:O(n^2) 空间复杂度:O(1) 此处应用了C++11的auto , lambda , stat ...