django+celery+redis实现运行定时任务

0、目的

1、安装

2、django代码(whthas_home为project,portal为app)

1 from __future__ import absolute_import

2

3 from .celery import app as celery_app

修改代码,whthas_home/setting.py

1 # Celery settings

2 import djcelery

3 djcelery.setup_loader()

4

5 BROKER_URL = 'redis://127.0.0.1:6379/0'

6 CELERY_RESULT_BACKEND = 'redis://127.0.0.1:6379/0'##加密方式CELERY_RESULT_BACKEND = 'redis://:密码@127.0.0.1:6379/0'

7 CELERY_ACCEPT_CONTENT = ['json']

8 CELERY_TASK_SERIALIZER = 'json'

9 CELERY_RESULT_SERIALIZER = 'json'

10 CELERYBEAT_SCHEDULER = 'djcelery.schedulers.DatabaseScheduler'

11 CELERY_TIMEZONE = 'Asia/Shanghai'

12

13 # Application definition

14

15 INSTALLED_APPS = [

16 'django.contrib.auth',

17 'django.contrib.contenttypes',

18 'django.contrib.sessions',

19 'django.contrib.messages',

20 'django.contrib.staticfiles',

21 'suit',

22 'django.contrib.admin',

23 'DjangoUeditor',

24 'portal',

25 'djcelery',

26 ]

增加文件, whthas_home/celery.py

1 from __future__ import absolute_import

2

3 import os

4 from celery import Celery

5 from django.conf import settings

6

7 os.environ.setdefault('DJANGO_SETTINGS_MODULE', 'whthas_home.settings')

8

9 app = Celery('portal')

10

11 app.config_from_object('django.conf:settings')

12 app.autodiscover_tasks(lambda: settings.INSTALLED_APPS)

13

14

15 @app.task(bind=True)

16 def debug_task(self):

17 print('Request: {0!r}'.format(self.request))

1 from celery import task

2 from time import sleep

3

4

5 @task()

6 def Task_A(message):

7 Task_A.update_state(state='PROGRESS', meta={'progress': 0})

8 sleep(10)

9 Task_A.update_state(state='PROGRESS', meta={'progress': 30})

10 sleep(10)

11 return message

12

13

14 def get_task_status(task_id):

15 task = Task_A.AsyncResult(task_id)

16

17 status = task.state

18 progress = 0

19

20 if status == u'SUCCESS':

21 progress = 100

22 elif status == u'FAILURE':

23 progress = 0

24 elif status == 'PROGRESS':

25 progress = task.info['progress']

26

27 return {'status': status, 'progress': progress}

3、测试

>>> from portal.tasks import *

>>> t = TaskA.delay("heel2")

>>> get_task_status(t.id)

{'status': u'PROGRESS', 'progress': 0}

>>> get_task_status(t.id)

{'status': u'PROGRESS', 'progress': 0}

>>> get_task_status(t.id)

{'status': u'PROGRESS', 'progress': 30}

>>> get_task_status(t.id)

{'status': u'PROGRESS', 'progress': 30}

>>> get_task_status(t.id)

{'status': u'SUCCESS', 'progress': 100}

>>>

同时broker侧能看到:

[2017-04-21 16:38:47,023: INFO/MainProcess] Received task: portal.tasks.Task_A[da948495-c64b-4ff9-882b-876721cd5017]

[2017-04-21 16:39:07,035: INFO/MainProcess] Task portal.tasks.Task_A[da948495-c64b-4ff9-882b-876721cd5017] succeeded in 20.0099999905s: heel

表示代码能正常运行。

127.0.0.1:6379> get "celery-task-meta-da948495-c64b-4ff9-882b-876721cd5017"

"{\"status\": \"SUCCESS\", \"traceback\": null, \"result\": \"heel\", \"children\": []}"

相关redis命令:keys *

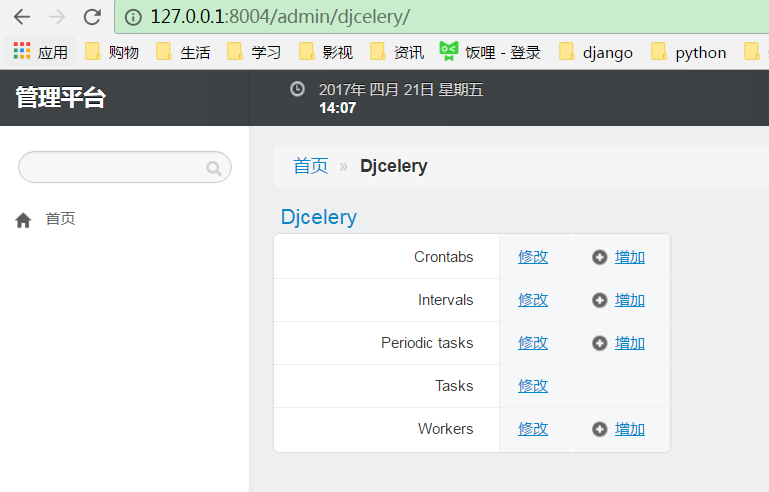

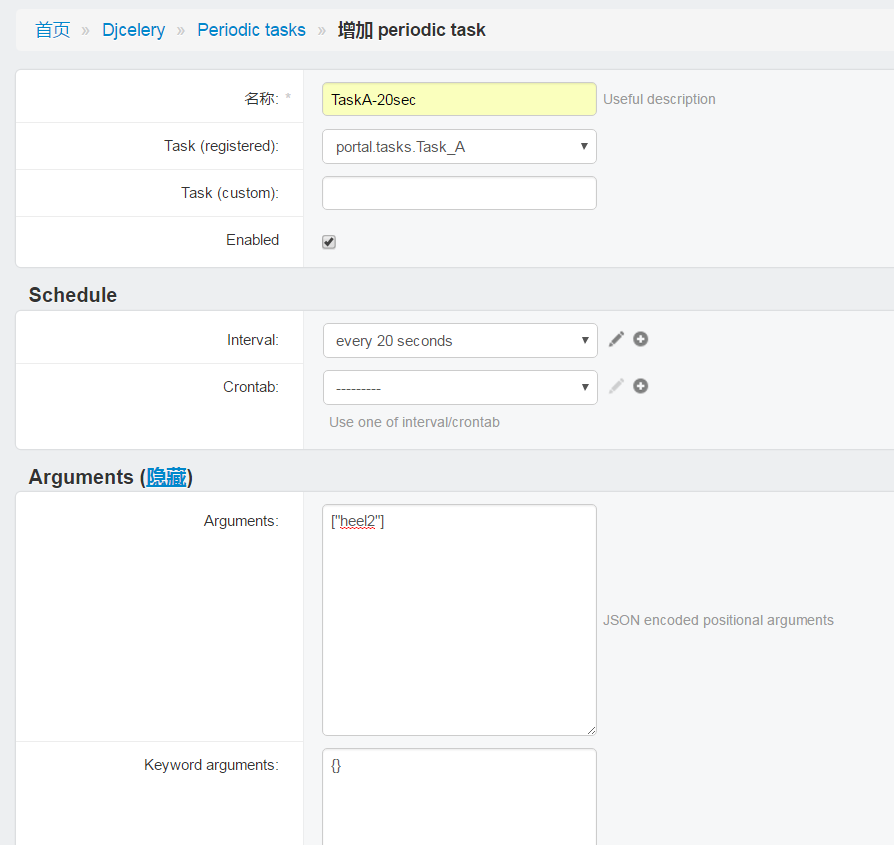

4、django后台定义任务

5、执行任务

启动broker:python manage.py celeryd -l info

[2017-04-21 16:56:33,216: INFO/MainProcess] Received task: portal.tasks.Task_A[d8a26977-8413-4bf0-b518-b53052af4cee]

[2017-04-21 16:56:53,211: INFO/MainProcess] Received task: portal.tasks.Task_A[00f1cab7-eb56-4cc3-9979-a8a68aaaf2de]

[2017-04-21 16:56:53,220: INFO/MainProcess] Task portal.tasks.Task_A[d8a26977-8413-4bf0-b518-b53052af4cee] succeeded in 20.003000021s: heel2

[2017-04-21 16:57:13,211: INFO/MainProcess] Received task: portal.tasks.Task_A[aa652612-8525-4110-94ea-9010085ec20b]

[2017-04-21 16:57:13,223: INFO/MainProcess] Task portal.tasks.Task_A[00f1cab7-eb56-4cc3-9979-a8a68aaaf2de] succeeded in 20.0080001354s: heel2

[2017-04-21 16:57:33,213: INFO/MainProcess] Received task: portal.tasks.Task_A[9876890e-6a71-4501-bdae-775492ebae88]

[2017-04-21 16:57:33,219: INFO/MainProcess] Task portal.tasks.Task_A[aa652612-8525-4110-94ea-9010085ec20b] succeeded in 20.0050001144s: heel2

[2017-04-21 16:57:53,211: INFO/MainProcess] Received task: portal.tasks.Task_A[c12fcffc-3910-4a22-93b3-0df740910728]

[2017-04-21 16:57:53,221: INFO/MainProcess] Task portal.tasks.Task_A[9876890e-6a71-4501-bdae-775492ebae88] succeeded in 20.0069999695s: heel2

[2017-04-21 16:58:13,211: INFO/MainProcess] Received task: portal.tasks.Task_A[ccfad575-c0b4-48f5-9385-85ff5dac76fc]

[2017-04-21 16:58:13,217: INFO/MainProcess] Task portal.tasks.Task_A[c12fcffc-3910-4a22-93b3-0df740910728] succeeded in 20.003000021s: heel2

[2017-04-21 16:58:33,211: INFO/MainProcess] Received task: portal.tasks.Task_A[0d6f77a6-a29c-4ead-9428-e3e758c754e1]

[2017-04-21 16:58:33,221: INFO/MainProcess] Task portal.tasks.Task_A[ccfad575-c0b4-48f5-9385-85ff5dac76fc] succeeded in 20.007999897s: heel2

[2017-04-21 16:58:53,211: INFO/MainProcess] Received task: portal.tasks.Task_A[34b2b3a0-771c-4a28-94a1-92e25763fae1]

[2017-04-21 16:58:53,217: INFO/MainProcess] Task portal.tasks.Task_A[0d6f77a6-a29c-4ead-9428-e3e758c754e1] succeeded in 20.0039999485s: heel2

[2017-04-21 16:59:13,211: INFO/MainProcess] Received task: portal.tasks.Task_A[d4be920f-376a-46a2-9edd-095234d29ef2]

[2017-04-21 16:59:13,217: INFO/MainProcess] Task portal.tasks.Task_A[34b2b3a0-771c-4a28-94a1-92e25763fae1] succeeded in 20.0039999485s: heel2

django+celery+redis实现运行定时任务的更多相关文章

- django celery redis 定时任务

0.目的 在开发项目中,经常有一些操作时间比较长(生产环境中超过了nginx的timeout时间),或者是间隔一段时间就要执行的任务. 在这种情况下,使用celery就是一个很好的选择. cele ...

- Django + Celery 实现动态配置定时任务

哈喽,今天给大家分享一篇Django+Celery实现动态配置定时任务,因为最近也是无意间看到一位大佬关于这块的文章,然后自己觉得不错,也想学习写一下,然后最终实现功能是在前端页面统一管理计划任务,大 ...

- django+celery+redis环境搭建

初次尝试搭建django+celery+redis环境,记录下来,慢慢学习~ 1.安装apache 下载httpd-2.0.63.tar.gz,解压tar zxvf httpd-2.0.63.tar. ...

- 06: django+celery+redis

目录: 1.1 Celery介绍 1.2 celery 组件 1.3 安装相关包 与 管理命令 1.4 celery与Django执行异步任务 1.5 在django中使用计划任务功能 1.1 Cel ...

- 项目部署Django+celery+redis

celery介绍 1.celery应用举例 1.Celery 是一个 基于python开发的分布式异步消息任务队列,通过它可以轻松的实现任务的异步处理, 如果你的业务场景中需要用到异步任务,就可以 ...

- python用Django+Celery+Redis 监视程序(一)

C盘创建一个目录就叫DjangoDemo,然后开始在该目录下操作. 1.新建Django工程与应用 运行pip install django 安装django 这里我们建一个名为demo的项目和hom ...

- Django+Celery+redis kombu.exceptions.EncodeError:Object of type is not JSON serializable报错

在本文中例子中遇到问题的各种开发版本如下: Python3.6.8 Django==2.2 celery==4.4.0 kombu==4.6.7 redis==3.3.0 大概的报错如下截图: 是在开 ...

- Django + celery +redis使用

1.安装包 pip install celery pip install django-celery pip install pymysql 2.创建一个django项目 - proj/ - proj ...

- django+celery+redis应用

一.celery介绍 1.应用场景 a. Celery 是一个 基于python开发的分布式异步消息任务队列,通过它可以轻松的实现任务的异步处理,如果你的业务场景中需要用到异步任务,就可以考虑使用ce ...

随机推荐

- python 写 excel 模块 : xlwt

主要来自:[ python中使用xlrd.xlwt操作excel表格详解 ] 为了方便阅读, 我将原文两个模块拆分为两篇博文: [ python 读 excel 模块: xlrd ] [ python ...

- HDU 2105 The Center of Gravity (数学)

题目链接 Problem Description Everyone know the story that how Newton discovered the Universal Gravitatio ...

- thinkphp 随机获取一条数据

$data=$AD->field("ID,Answer,State")->limit(1)->order('rand()')->select();

- linux驱动学习(二) Makefile高级【转】

转自:http://blog.csdn.net/ghostyu/article/details/6866863 版权声明:本文为博主原创文章,未经博主允许不得转载. 在我前一篇写的[ linux驱动学 ...

- HDU1907(尼姆博弈)

John Time Limit: 5000/1000 MS (Java/Others) Memory Limit: 65535/32768 K (Java/Others)Total Submis ...

- JAVA 开发工具 市场状况

转载:http://blog.csdn.net/hj7jay/article/details/52250755 2016 JAVA 流行的开发工具 最流行的工具并不一定是“最好的”,对于开发来说,什么 ...

- SVN代码提交

SVN代码提交(转载) 原文链接:http://www.softown.cn/post/100.html 1.SVN代码提交 1) 原则 先更新再提交: SVN是为了多人协同开发而产生的,如果你在提交 ...

- tcpdump学习(2):基本使用

安装好tcpdump之后,运行tcpdump: 1. tcpdump -D 获取网络适配器列表,以下是在Ubuntu上获取到的结果: root@holmesian-laptop:~# tcpdump ...

- hdu 2236(二分图最小点覆盖+二分)

无题II Time Limit: 2000/2000 MS (Java/Others) Memory Limit: 32768/32768 K (Java/Others)Total Submis ...

- 在lua中正确使用uuid的方法:

-- 参考:http://ju.outofmemory.cn/entry/97724local function guid() local template ="xxxxxxx ...