一文讲清楚FusionInsight MRS CDL如何使用

摘要:CDL是一种简单、高效的数据实时集成服务,能够从各种OLTP数据库中抓取Data Change事件,然后推送至Kafka中,最后由Sink Connector消费Topic中的数据并导入到大数据生态软件应用中,从而实现数据的实时入湖。

本文分享自华为云社区《华为FusionInsight MRS CDL使用指南》,作者:晋红轻。

说明

CDL是一种简单、高效的数据实时集成服务,能够从各种OLTP数据库中抓取Data Change事件,然后推送至Kafka中,最后由Sink Connector消费Topic中的数据并导入到大数据生态软件应用中,从而实现数据的实时入湖。

CDL服务包含了两个重要的角色:CDLConnector和CDLService。CDLConnector是具体执行数据抓取任务的实例,CDLService是负责管理和创建任务的实例。

本此实践介绍以mysql作为数据源进行数据抓取

前提条件

- MRS集群已安装CDL服务。

- MySQL数据库需要开启mysql的bin log功能(默认情况下是开启的)。

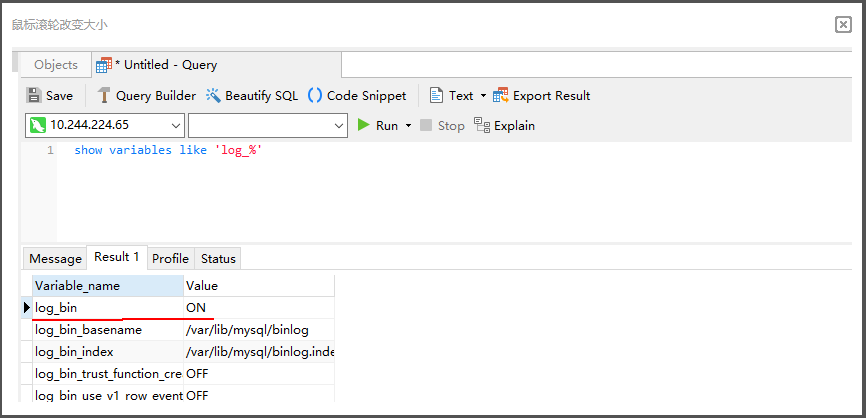

查看MySQL是否开启bin log:

使用工具或者命令行连接MySQL数据库(本示例使用navicat工具连接),执行show variables like 'log_%'命令查看。

例如在navicat工具选择"File > New Query"新建查询,输入如下SQL命令,单击"Run"在结果中"log_bin"显示为"ON"则表示开启成功。

show variables like 'log_%'

工具准备

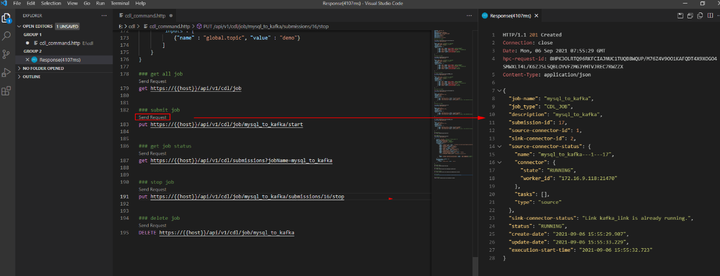

现在cdl只能使用rest api的方式进行命令提交,所以需要提前安装工具进行调试。本文使用VSCode工具。

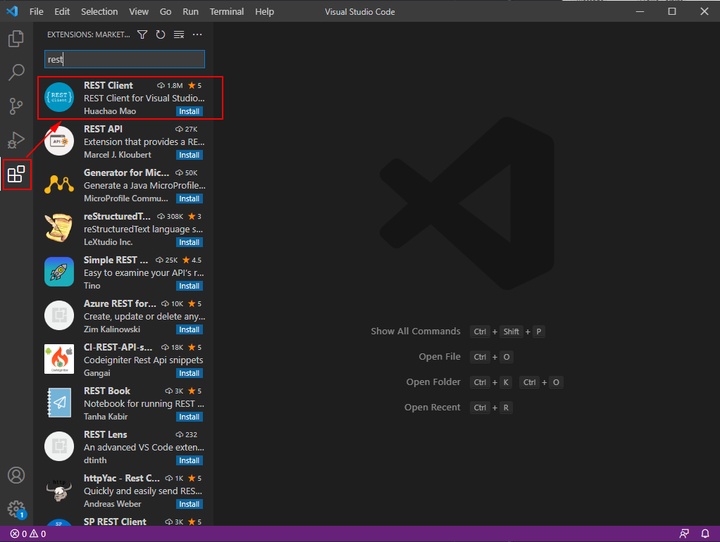

完成之后安装rest client插件:

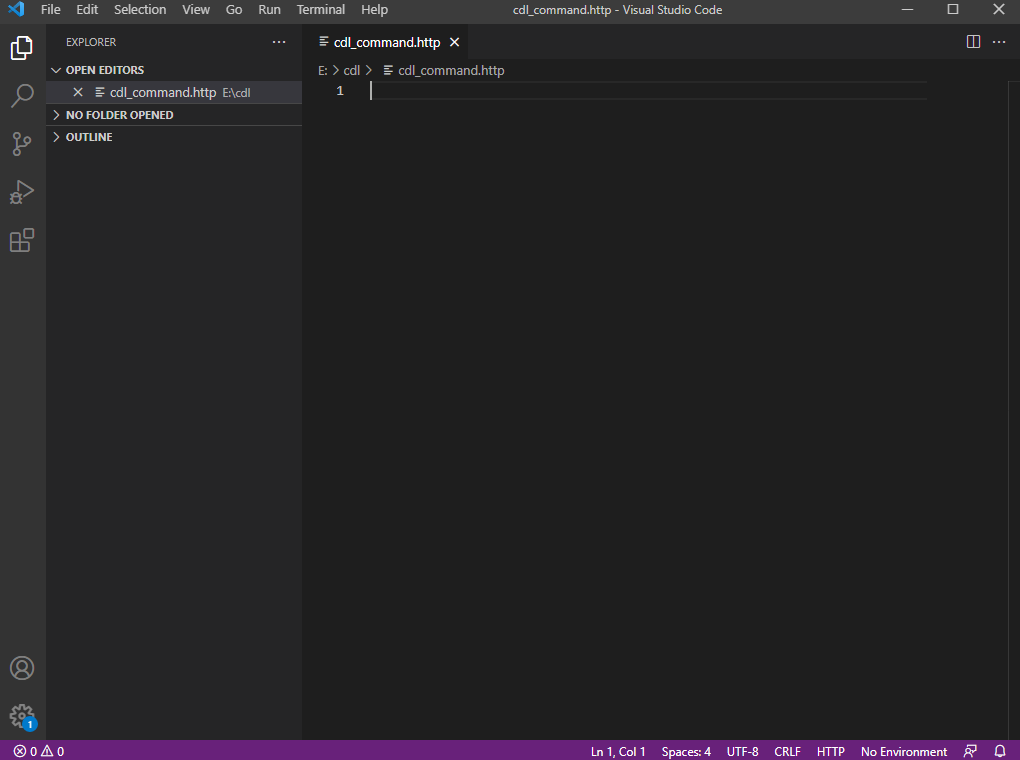

完成之后创建一个cdl.http的文件进行编辑:

创建CDL任务

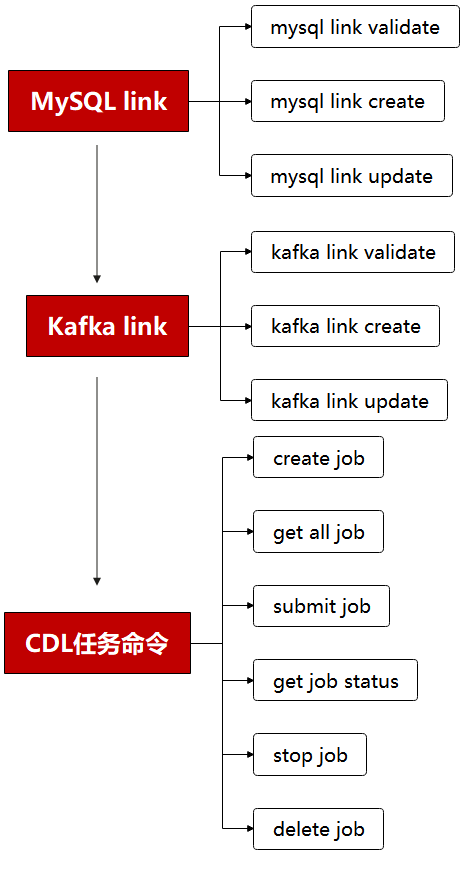

CDL任务创建的流程图如下所示:

说明:需要先创建一个MySQL link, 在创建一个Kafka link, 然后再创建一个CDL同步任务并启动。

MySQL link部分rest请求代码

@hostname = 172.16.9.113

@port = 21495

@host = {{hostname}}:{{port}}

@bootstrap = "172.16.9.113:21007"

@bootstrap_normal = "172.16.9.113:21005"

@mysql_host = "172.16.2.118"

@mysql_port = "3306"

@mysql_database = "hudi"

@mysql_user = "root"

@mysql_password = "Huawei@123" ### get links

get https://{{host}}/api/v1/cdl/link ### mysql link validate post https://{{host}}/api/v1/cdl/link?validate=true

content-type: application/json {

"name": "MySQL_link", //link名,全局唯一,不能重复

"description":"MySQL connection", //link描述

"link-type":"mysql", //link的类型

"enabled":"true",

"link-config-values": {

"inputs": [

{ "name": "host", "value": {{mysql_host}} }, //数据库安装节点的ip

{ "name": "port", "value": {{mysql_port}} },//数据库监听的端口

{ "name": "database.name", "value": {{mysql_database}} }, //连接的数据库名

{ "name": "user", "value": {{mysql_user}} }, //用户

{ "name": "password","value": {{mysql_password}} } ,//密码

{ "name":"schema", "value": {{mysql_database}}}//同数据库名

]

}

} ### mysql link create post https://{{host}}/api/v1/cdl/link

content-type: application/json {

"name": "MySQL_link", //link名,全局唯一,不能重复

"description":"MySQL connection", //link描述

"link-type":"mysql", //link的类型

"enabled":"true",

"link-config-values": {

"inputs": [

{ "name": "host", "value": {{mysql_host}} }, //数据库安装节点的ip

{ "name": "port", "value": {{mysql_port}} },//数据库监听的端口

{ "name": "database.name", "value": {{mysql_database}} }, //连接的数据库名

{ "name": "user", "value": {{mysql_user}} }, //用户

{ "name": "password","value": {{mysql_password}} } ,//密码

{ "name":"schema", "value": {{mysql_database}}}//同数据库名

]

}

} ### mysql link update put https://{{host}}/api/v1/cdl/link/MySQL_link

content-type: application/json {

"name": "MySQL_link", //link名,全局唯一,不能重复

"description":"MySQL connection", //link描述

"link-type":"mysql", //link的类型

"enabled":"true",

"link-config-values": {

"inputs": [

{ "name": "host", "value": {{mysql_host}} }, //数据库安装节点的ip

{ "name": "port", "value": {{mysql_port}} },//数据库监听的端口

{ "name": "database.name", "value": {{mysql_database}} }, //连接的数据库名

{ "name": "user", "value": {{mysql_user}} }, //用户

{ "name": "password","value": {{mysql_password}} } ,//密码

{ "name":"schema", "value": {{mysql_database}}}//同数据库名

]

}

}

Kafka link部分rest请求代码

### get links

get https://{{host}}/api/v1/cdl/link ### kafka link validate post https://{{host}}/api/v1/cdl/link?validate=true

content-type: application/json {

"name": "kafka_link",

"description":"test kafka link",

"link-type":"kafka",

"enabled":"true",

"link-config-values": {

"inputs": [

{ "name": "bootstrap.servers", "value": "172.16.9.113:21007" },

{ "name": "sasl.kerberos.service.name", "value": "kafka" },

{ "name": "security.protocol","value": "SASL_PLAINTEXT" }//安全模式为SASL_PLAINTEXT,普通模式为PLAINTEXT

]

}

} ### kafka link create post https://{{host}}/api/v1/cdl/link

content-type: application/json {

"name": "kafka_link",

"description":"test kafka link",

"link-type":"kafka",

"enabled":"true",

"link-config-values": {

"inputs": [

{ "name": "bootstrap.servers", "value": "172.16.9.113:21007" },

{ "name": "sasl.kerberos.service.name", "value": "kafka" },

{ "name": "security.protocol","value": "SASL_PLAINTEXT" }//安全模式为SASL_PLAINTEXT,普通模式为PLAINTEXT

]

}

} ### kafka link update put https://{{host}}/api/v1/cdl/link/kafka_link

content-type: application/json {

"name": "kafka_link",

"description":"test kafka link",

"link-type":"kafka",

"enabled":"true",

"link-config-values": {

"inputs": [

{ "name": "bootstrap.servers", "value": "172.16.9.113:21007" },

{ "name": "sasl.kerberos.service.name", "value": "kafka" },

{ "name": "security.protocol","value": "SASL_PLAINTEXT" }//安全模式为SASL_PLAINTEXT,普通模式为PLAINTEXT

]

}

}

CDL任务命令部分rest请求代码

@hostname = 172.16.9.113

@port = 21495

@host = {{hostname}}:{{port}}

@bootstrap = "172.16.9.113:21007"

@bootstrap_normal = "172.16.9.113:21005"

@mysql_host = "172.16.2.118"

@mysql_port = "3306"

@mysql_database = "hudi"

@mysql_user = "root"

@mysql_password = "Huawei@123" ### create job

post https://{{host}}/api/v1/cdl/job

content-type: application/json {

"job_type": "CDL_JOB", //job类型,目前只支持CDL_JOB这一种

"name": "mysql_to_kafka", //job名称

"description":"mysql_to_kafka", //job描述

"from-link-name": "MySQL_link", //数据源Link

"to-link-name": "kafka_link", //目标源Link

"from-config-values": {

"inputs": [

{"name" : "connector.class", "value" : "com.huawei.cdc.connect.mysql.MysqlSourceConnector"},

{"name" : "schema", "value" : "hudi"},

{"name" : "db.name.alias", "value" : "hudi"},

{"name" : "whitelist", "value" : "hudisource"},

{"name" : "tables", "value" : "hudisource"},

{"name" : "tasks.max", "value" : "10"},

{"name" : "mode", "value" : "insert,update,delete"},

{"name" : "parse.dml.data", "value" : "true"},

{"name" : "schema.auto.creation", "value" : "false"},

{"name" : "errors.tolerance", "value" : "all"},

{"name" : "multiple.topic.partitions.enable", "value" : "false"},

{"name" : "topic.table.mapping", "value" : "[

{\"topicName\":\"huditableout\", \"tableName\":\"hudisource\"}

]"

},

{"name" : "producer.override.security.protocol", "value" : "SASL_PLAINTEXT"},//安全模式为SASL_PLAINTEXT,普通模式为PLAINTEXT

{"name" : "consumer.override.security.protocol", "value" : "SASL_PLAINTEXT"}//安全模式为SASL_PLAINTEXT,普通模式为PLAINTEXT

]

},

"to-config-values": {"inputs": []},

"job-config-values": {

"inputs": [

{"name" : "global.topic", "value" : "demo"}

]

}

} ### get all job

get https://{{host}}/api/v1/cdl/job

### submit job

put https://{{host}}/api/v1/cdl/job/mysql_to_kafka/start

### get job status

get https://{{host}}/api/v1/cdl/submissions?jobName=mysql_to_kafka

### stop job

put https://{{host}}/api/v1/cdl/job/mysql_to_kafka/submissions/13/stop

### delete job

DELETE https://{{host}}/api/v1/cdl/job/mysql_to_kafka

场景验证

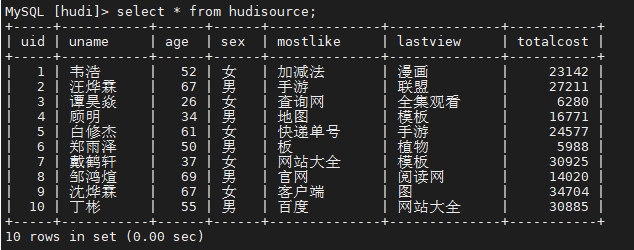

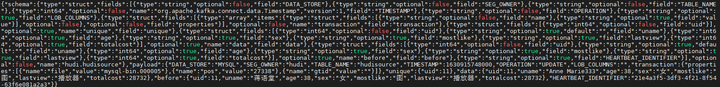

生产库MySQL原始数据如下:

提交CDL任务之后

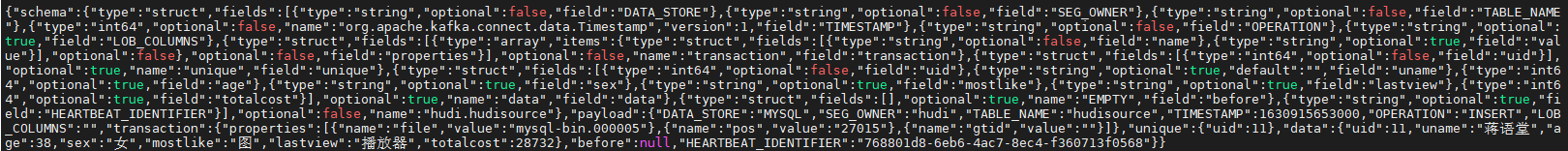

增加操作: insert into hudi.hudisource values (11,“蒋语堂”,38,“女”,“图”,“播放器”,28732);

对应kafka消息体:

更改操作: UPDATE hudi.hudisource SET uname=‘Anne Marie333’ WHERE uid=11;

对应kafka消息体:

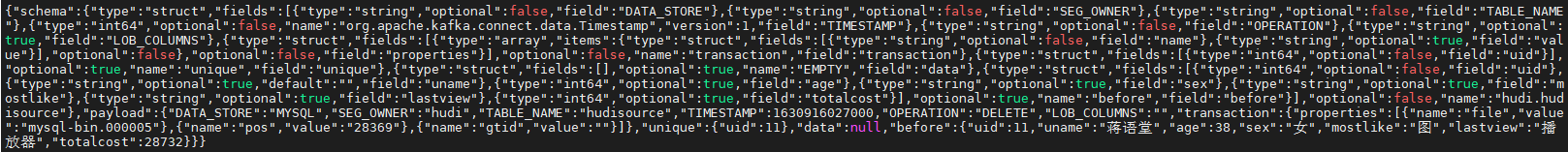

删除操作:delete from hudi.hudisource where uid=11;

对应kafka消息体:

一文讲清楚FusionInsight MRS CDL如何使用的更多相关文章

- 一文了解华为FusionInsight MRS HBase的集群隔离方案RSGroup

摘要: RSGroup是集群隔离方案. 本文分享自华为云社区<华为FusionInsight MRS HBase的集群隔离--RSGroup>,作者: MissAverage. 一.HBa ...

- FusionInsight MRS:你的大数据“管家”

摘要:4月24日-26日,HDC.Cloud2021在深圳大学城成功举办,华为云FusionInsight MRS云原生数据湖带来最懂行的大数据解决方案,为政企客户提供湖仓一体.云原生的大数据解决方案 ...

- HDFS 细粒度锁优化,FusionInsight MRS有妙招

摘要:华为云FusionInsight MRS通过FGL对HDFS NameNode锁机制进行优化,有效提升了NameNode的读写吞吐量,从而能够支持更多数据,更多业务请求访问,从而更好的支撑政企客 ...

- 华为云FusionInsight MRS:助力企业构建“一企一湖,一城一湖”

摘要:华为云FusionInsight MRS新一代的数据湖,让大数据越用越快.越用越易.越用越稳.越用越省!让数据价值近在眼前! 10月30日,以"携手共赢·数创未来"为主题的第 ...

- 解密华为云FusionInsight MRS新特性:一架构三湖

摘要:华为云安全网关产品总监郭冕在"华为云TechWave云原生2.0专题日"上发表<华为云FusionInsight MRS,一个架构实现三种数据湖>的主题演讲,分享 ...

- Superior Scheduler:带你了解FusionInsight MRS的超级调度器

摘要:Superior Scheduler是一个专门为Hadoop YARN分布式资源管理系统设计的调度引擎,是针对企业客户融合资源池,多租户的业务诉求而设计的高性能企业级调度器. 本文分享自华为云社 ...

- 工业数据分析为什么要用FusionInsight MRS IoTDB?

摘要:MRS IoTDB,它是华为FusionInsight MRS大数据套件中的时序数据库产品,在深度参与Apache IoTDB社区开源版的基础上推出的高性能企业级时序数据库产品. 本文分享自华为 ...

- 一文讲清楚MySQL事务隔离级别和实现原理,开发人员必备知识点

经常提到数据库的事务,那你知道数据库还有事务隔离的说法吗,事务隔离还有隔离级别,那什么是事务隔离,隔离级别又是什么呢?本文就帮大家梳理一下. MySQL 事务 本文所说的 MySQL 事务都是指在 I ...

- 【技术干货】华为云FusionInsight MRS的自研超级调度器Superior Scheduler

Superior Scheduler是一个专门为Hadoop YARN分布式资源管理系统设计的调度引擎,是针对企业客户融合资源池,多租户的业务诉求而设计的高性能企业级调度器. Superior Sch ...

- 一文讲清楚 JVM Safe Point

大家好,我是树哥. 关于 Safe Point 是 JVM 中很关键的一个概念,但我估计有不少同学不是很懂.于是今天跟大家来深入聊聊 Safe Point,希望通过这篇文章能解答这样几个问题: 什么是 ...

随机推荐

- Java服务总在半夜挂,背后的真相竟然是...

写在前面 最近有用户反馈测试环境Java服务总在凌晨00:00左右挂掉,用户反馈Java服务没有定时任务,也没有流量突增的情况,Jvm配置也合理,莫名其妙就挂了 问题排查 问题复现 为了复现该问题,写 ...

- LooklessControl

Lookless controls vs User Controls. Lookless controls usage patterns(LooklessControl与UserControl的比较. ...

- 一款.NET开源的小巧、智能、免费的Windows内存清理工具 - WinMemoryCleaner

前言 我们在使用Windows系统的时候经常会遇到一些程序不会释放已分配的内存,从而导致电脑变得缓慢.今天给大家推荐一款.NET开源的小巧.智能.免费的Windows内存清理工具:WinMemoryC ...

- Android 输入系统介绍

目录 一.目的 二.环境 三.相关概念 3.1 输入设备 3.2 UEVENT机制 3.3 JNI 3.4 EPOLL机制 3.5 INotify 四.详细设计 4.1 结构图 4.2 代码结构 4. ...

- Excel 条件定位

查找定位 可以将所有空单元的值填上 方法:先使用定位条件选择区域中空单元格,输入100,按组合键Ctrl+Enter 仅复制分类汇总结果 先将数据进行组合 数据 -> 组合 如果直接复制,会把所 ...

- 学会XPath,轻松抓取网页数据

一.定义 XPath(XML Path Language)是一种用于在 XML 文档中定位和选择节点的语言.XPath的选择功能非常强大,可以通过简单的路径选择语法,选取文档中的任意节点或节点集.学会 ...

- Java自定义ClassLoader实现插件类隔离加载

为什么需要类隔离加载 项目开发过程中,需要依赖不同版本的中间件依赖包,以适配不同的中间件服务端 如果这些中间件依赖包版本之间不能向下兼容,高版本依赖无法连接低版本的服务端,相反低版本依赖也无法连接高版 ...

- winform中也可以这样做数据展示✨

1.前言 在做winform开发的过程中,经常需要做数据展示的功能,之前一直使用的是gridcontrol控件,今天想通过一个示例,跟大家介绍一下如何在winform blazor hybrid中使用 ...

- Spring+SpringMVC+Mybatis+Vue+Axios+Thymeleaf整合案例

1.创建SSM-Parent父项目 修改配置文件 <?xml version="1.0" encoding="UTF-8"?> <projec ...

- 小市值选股策略代码分享(附python源码)

小市值选股策略的核心在于通过综合分析公司的基本面.行业定位.财务健康状况以及市场趋势, 来寻找那些被市场低估但具备显著成长潜力的股票,同时也要重视风险管理和投资组合的多样化. 今天来给大家分享下小市值 ...